3.10(选修)直观理解反向传播(Backpropagation intuition)

这个视频主要是推导反向传播。

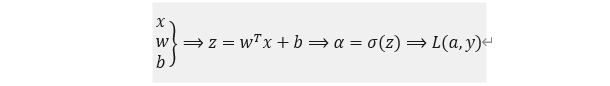

下图是逻辑回归的推导:

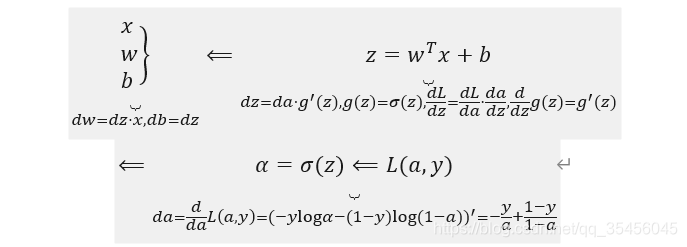

回想一下逻辑回归的公式(参考公式3.2、公式3.5、公式3.6、公式3.15) 公式3.38:

所以回想当时我们讨论逻辑回归的时候,我们有这个正向传播步骤,其中我们计算z,然后a,然后损失函数L。

公式3.39:

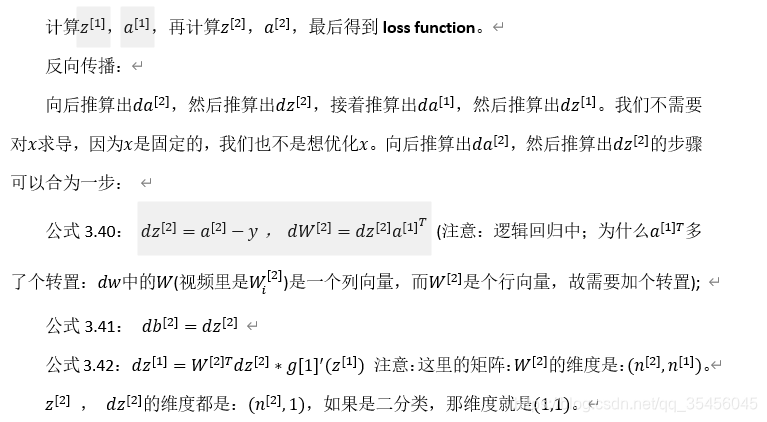

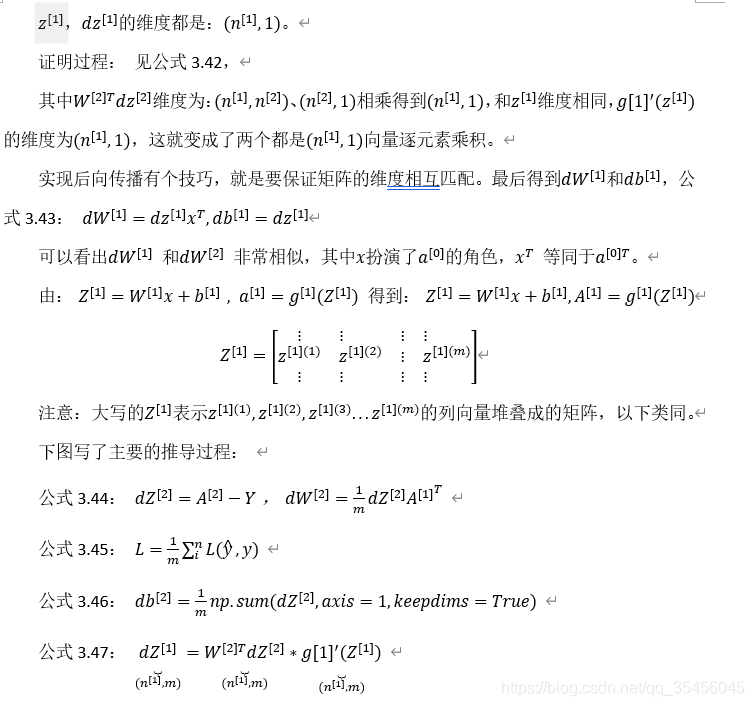

神经网络的计算中,与逻辑回归十分类似,但中间会有多层的计算。下图是一个双层神经网络,有一个输入层,一个隐藏层和一个输出层。

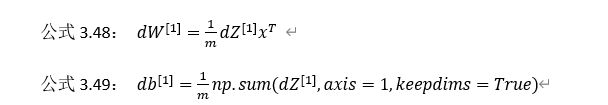

前向传播:

吴恩达老师认为反向传播的推导是机器学习领域最难的数学推导之一,矩阵的导数要用链式法则来求,如果这章内容掌握不了也没大的关系,只要有这种直觉就可以了。还有一点,就是初始化你的神经网络的权重,不要都是0,而是随机初始化,下一章将详细介绍原因。