首先说说为什么需要参数估计:在我们的实际问题里面,往往是知道总体服从什么样的分布,但是这个分布有一些参数是不知道的,那么我们就必须要先知道这些参数是多少,然后才能去进行后续的计算。那么本次

B

l

o

g

Blog

B l o g 将会介绍两种常用的估计方法。其中,极大似然估计在很多地方都会使用到,例如某些图像处理算法就是基于极大似然估计的。OK,闲话少说,我们开始吧!

首先,矩估计的数学基础是大数定理:

lim

n

→

∞

P

(

∣

1

n

∑

i

=

1

n

X

k

−

E

X

k

∣

)

≥

ε

)

=

0

\lim_{n\to ∞}P(|\frac{1}{n}\sum_{i=1}^nX^k - EX^k|) ≥ ε) = 0

n → ∞ lim P ( ∣ n 1 i = 1 ∑ n X k − E X k ∣ ) ≥ ε ) = 0

n

→

∞

n \to ∞

n → ∞

1

n

∑

i

=

1

n

X

k

\frac{1}{n}\sum_{i=1}^nX^k

n 1 ∑ i = 1 n X k

E

X

k

EX^k

E X k

那么,到底如何使用矩估计呢?我们通过一个例题来分析固定的步骤:

已知总体服从

X

∼

N

(

μ

,

σ

2

)

X \sim N(μ, σ^2)

X ∼ N ( μ , σ 2 )

μ

,

σ

2

μ, σ^2

μ , σ 2

【第一步】:把所有未知数设出来。我们设

θ

1

=

μ

,

θ

2

=

σ

2

θ_1 = μ, θ_2 = σ^2

θ 1 = μ , θ 2 = σ 2

E

X

EX

E X

E

X

2

EX^2

E X 2

E

X

=

θ

1

EX = θ_1

E X = θ 1

E

X

2

=

D

X

+

(

E

X

)

2

=

θ

2

+

θ

1

2

EX^2 = DX + (EX)^2 =θ_2 + θ_1^2

E X 2 = D X + ( E X ) 2 = θ 2 + θ 1 2

【第三步】:用

k

k

k

θ

1

,

θ

2

θ_1, θ_2

θ 1 , θ 2

θ

1

=

E

X

θ_1 = EX

θ 1 = E X

θ

2

=

E

X

2

−

(

E

X

)

2

θ_2 = EX^2 - (EX)^2

θ 2 = E X 2 − ( E X ) 2

【第四步】:根据我们一开始说的数学基础,可以使用

1

n

∑

i

=

1

n

X

k

\frac{1}{n}\sum_{i=1}^nX^k

n 1 ∑ i = 1 n X k

E

X

k

EX^k

E X k

θ

1

=

1

n

∑

i

=

1

n

X

i

θ_1 = \frac{1}{n}\sum_{i=1}^nX_i

θ 1 = n 1 ∑ i = 1 n X i

n

n

n

θ

1

θ_1

θ 1

θ

2

=

1

n

∑

i

=

1

n

X

i

2

−

X

ˉ

2

=

S

n

2

θ_2 = \frac{1}{n}\sum_{i=1}^nX_i^2 - \bar{X}^2 = S_n^2

θ 2 = n 1 ∑ i = 1 n X i 2 − X ˉ 2 = S n 2

θ

2

θ_2

θ 2

我们下面学习极大似然估计。首先我们看看方法:

L

L

L

L

L

L

L

(

x

1

,

x

2

,

⋯

,

x

n

,

θ

)

=

∏

i

=

1

n

p

(

x

i

,

θ

)

L(x_1, x_2, \cdots, x_n, θ) = \prod_{i=1}^n p(x_i, θ)

L ( x 1 , x 2 , ⋯ , x n , θ ) = i = 1 ∏ n p ( x i , θ )

L

L

L

L

(

x

1

,

x

2

,

⋯

,

x

n

,

θ

)

=

∏

i

=

1

n

f

(

x

i

,

θ

)

L(x_1, x_2, \cdots, x_n, θ) = \prod_{i=1}^n f(x_i, θ)

L ( x 1 , x 2 , ⋯ , x n , θ ) = i = 1 ∏ n f ( x i , θ )

【第二步】我们的目的是找到使得

L

L

L

θ

θ

θ

L

L

L 但是我们先需要对似然函数两边同时取对数

【第三步】对取完对数之后的式子求导,令倒数等于0,解出

θ

θ

θ

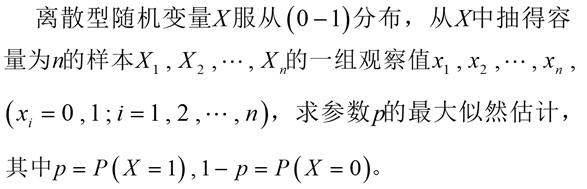

我们继续根据一个例子理解极大似然估计的步骤:

首先这是离散型的随机变量,所以似然函数是这

n

n

n

x

i

x_i

x i

x

i

x_i

x i

P

{

X

i

=

x

}

=

p

x

(

1

−

p

)

1

−

x

P\{X_i = x\} = p^x(1-p)^{1-x}

P { X i = x } = p x ( 1 − p ) 1 − x

x

=

0

x = 0

x = 0

P

{

X

=

0

}

=

1

−

p

P\{X = 0\} = 1-p

P { X = 0 } = 1 − p

x

=

1

x = 1

x = 1

P

{

X

=

1

}

=

p

P\{X = 1\} = p

P { X = 1 } = p

下面我们就开始构造似然函数

L

L

L

L

(

x

1

,

x

2

,

⋯

,

x

n

,

p

)

=

p

x

1

(

1

−

p

)

1

−

x

1

p

x

2

(

1

−

p

)

1

−

x

2

⋯

p

x

n

(

1

−

p

)

1

−

x

n

L(x_1, x_2, \cdots, x_n, p) = p^{x_1}(1-p)^{1-x_1}p^{x_2}(1-p)^{1-x_2}\cdots p^{x_n}(1-p)^{1-x_n}

L ( x 1 , x 2 , ⋯ , x n , p ) = p x 1 ( 1 − p ) 1 − x 1 p x 2 ( 1 − p ) 1 − x 2 ⋯ p x n ( 1 − p ) 1 − x n

L

(

x

1

,

x

2

,

⋯

,

x

n

,

p

)

=

p

∑

i

=

1

n

x

i

(

1

−

p

)

n

−

∑

i

=

1

n

x

i

L(x_1, x_2, \cdots, x_n, p) = p^{\sum_{i=1}^nx_i}(1-p)^{n - \sum_{i=1}^nx_i}

L ( x 1 , x 2 , ⋯ , x n , p ) = p ∑ i = 1 n x i ( 1 − p ) n − ∑ i = 1 n x i

l

n

(

L

(

x

1

,

x

2

,

⋯

,

x

n

,

p

)

)

=

∑

i

=

1

n

x

i

l

n

(

p

)

+

(

n

−

∑

i

=

1

n

x

i

)

l

n

(

1

−

p

)

ln(L(x_1, x_2, \cdots, x_n, p)) = \sum_{i=1}^nx_iln(p) + (n - \sum_{i=1}^nx_i)ln(1-p)

l n ( L ( x 1 , x 2 , ⋯ , x n , p ) ) = i = 1 ∑ n x i l n ( p ) + ( n − i = 1 ∑ n x i ) l n ( 1 − p )

p

p

p

d

l

n

(

L

(

x

1

,

x

2

,

⋯

,

x

n

,

p

)

)

d

p

=

1

p

∑

i

=

1

n

x

i

−

1

1

−

p

(

n

−

∑

i

=

1

n

x

i

)

\frac{dln(L(x_1, x_2, \cdots, x_n, p))}{dp} = \frac{1}{p}\sum_{i=1}^nx_i - \frac{1}{1-p}(n - \sum_{i=1}^nx_i)

d p d l n ( L ( x 1 , x 2 , ⋯ , x n , p ) ) = p 1 i = 1 ∑ n x i − 1 − p 1 ( n − i = 1 ∑ n x i )

1

p

∑

i

=

1

n

x

i

=

1

1

−

p

(

n

−

∑

i

=

1

n

x

i

)

\frac{1}{p}\sum_{i=1}^nx_i = \frac{1}{1-p}(n - \sum_{i=1}^nx_i)

p 1 i = 1 ∑ n x i = 1 − p 1 ( n − i = 1 ∑ n x i )

p

p

p

p

=

1

n

∑

i

=

1

n

x

i

=

X

ˉ

p = \frac{1}{n}\sum_{i=1}^nx_i = \bar{X}

p = n 1 i = 1 ∑ n x i = X ˉ

另外,如果遇到了像是正态分布这样有两个变量的,极大似然估计也是一样的,只不过是要分别对两个变量求偏导数罢了。然后联立解方程。

结束语:本文介绍了两种常见的参数估计算法,但是这两种算法估计出来的参数孰优孰劣呢?我们需要一个合理的评估,那么在下一篇

B

l

o

g

Blog

B l o g