什么是非人工智能 每个行业都需要的 3 种人为驱动的决策能力 布兰代斯·马歇尔

支持统计数据的研究报告预计高度依赖AI的未来。

• 2018年,麦肯锡全球研究院发布了一份《工作未来报告》,估计到2030年,全球将有4亿人被AI系统、工具和平台取代。

• 2023年3月,高盛发布了其《全球经济影响报告》,表明“生成AI可能取代现有工作的四分之一”。

• 本月早些时候,世界经济论坛发布了其《未来就业报告》,确认了高盛的预测,但公布了自动化对就业的具体影响数字。

就业前景估计相当令人警醒:8300万个工作岗位将消失,而只会创造6900万个工作岗位。这是一个1400万个工作岗位的差异。

失业或无法获得体面工作薪资的恐惧感很高。

作者讨论了令人不幸的AI炒作趋势——提示工程

通过几个月的激烈讨论“AI能为您做什么”,专栏评论和播客的我想问相反的问题:

AI不能做什么?

有些人会热情地说:“没有。这是技术进步中最具破坏性和变革性的进步。它改变了世界,改变了我们与数字空间的互动方式。”

人们害怕自己的职业、工作和维持理想生活方式的手段会被自动化淘汰。甚至有一份潜在工作清单(在技术、媒体、法律等领域),这些工作首先面临消失的风险,原因是AI。

而在每份报告中最令人恼火的部分是缺乏相反立场,比如提供关于使职业不受AI影响的建议。

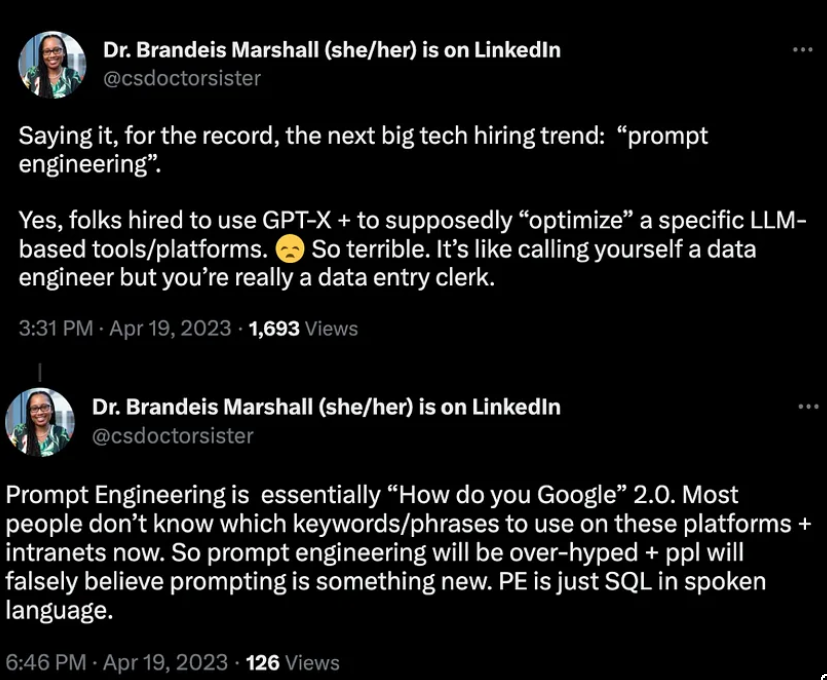

博士 Brandeis Marshall 在 Linkedin@csdoctorsister 上的两条推文从文章作者的角度讨论了提示工程的危险。

“我在此记录一下,下一个重大技术招聘趋势:“提示工程”。

是的,雇用人员使用GPT-X+ presumably“优化”特定的基于LLM的工具/平台。太糟糕了。这就像自称数据工程师,但实际上你只是数据录入员。” 2023年4月19日下午3:31 · 1693次浏览

“提示工程本质上是“你如何谷歌”2.0版本。现在大多数人不知道在这些平台和内部网站上使用哪些关键词/短语。所以提示工程会被过度宣传,人们会错误地认为提示是某种新事物。提示工程只是口语中的SQL。 ” 2023年4月19日下午6:46 · 126次浏览

Claude AI是如何解读这两条推文的意思:

-

Dr. Brandeis Marshall 记录了下一个主要的技术招聘趋势将是“提示工程”。这意味着聘请人员使用GPT-X+“优化”特定的基于语言模型的工具和平台。她认为这是非常糟糕的,就像自称数据工程师但实际上只是数据录入员。

-

提示工程本质上是搜索引擎的更新版本。现在大多数人不知道在这些平台和内部网站上使用哪些关键词和短语。所以,提示工程会被高估,人们会错误地认为提示工程是某种新的事物。但实际上,提示工程只是口语中的SQL,用于帮助用户获取信息。

总体来说,这两条推文在警告人工智能技术被过度依赖和高估,而忽视人类工程师和专家的作用。提示工程仅仅辅助人类,而不能取代人类。

作者关于提示工程的不幸AI炒作趋势的推文(来源1和来源2)

经过数月激烈的“人工智能能为你做什么”的面对面讨论、专栏文章和播客,我想问一个相反的问题:人工智能不能做什么?

有些人会热情地说:“没什么。这是技术上最具颠覆性和变革性的进步。它正在并将继续改变世界以及我们与数字空间的互动方式。

带有支持统计数据的研究报告预测了一个高度人工智能的未来。

2018年,麦肯锡全球研究所发布了一份未来工作报告,估计到400年,全球将有2030亿人被人工智能系统、工具和平台所取代。

2023 年 <> 月,高盛发布了其全球经济影响报告,建议“生成式人工智能可以替代多达四分之一的当前工作”。

本月早些时候,世界经济论坛发布了《未来就业报告》,该报告与高盛的预测一致,但分享了自动化对就业影响的具体数字。

就业前景估计相当发人深省:83万个工作岗位将蒸发,只有69万个工作岗位将被创造。这是一个14万个工作岗位的差异。

对工作替代和/或无法获得生活工资工作的恐惧非常高。人们害怕他们会从职业、工作和支持他们想要的生活方式的方式中被自动化。

甚至还有一份潜在工作清单(在科技、媒体、法律等领域),这些工作首先出现在砧板上,由于人工智能而消失。

这些报告中令人恼火的部分是,缺乏对立的立场,例如分享关于人工智能证明你的职业生涯的建议。

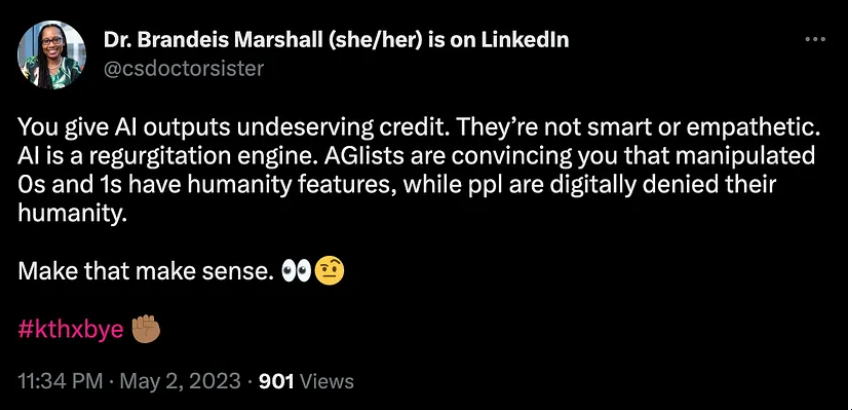

Brandeis Marshall 博士(她/她)在 LinkedIn@csdoctorsister 上

“你给Al过度积极的评价。Al并不智能或富有同情心。Al仅仅是一个重复引擎。AG列表(Algorithmic Governance lists)让你相信操纵的0和1具有人性特征,而人们在数字领域被否定人性。 ”

这种说法站得住脚吗? Claude AI 如何解读博士的观点:

这句话的意思是,Al(可能指的是一个人名或系统)给出了不恰当或不值得的赞同或信用。

换句话说,Al过于轻信或轻易地给出了赞同,而实际上那个人或事物并不值得如此积极的评价。这可能导致 Al 评价失误或判断错误。

例如:

-

Al太轻易地给新员工一个好评,而实际上新员工的表现不够理想。 -

Al过于相信某个理论或观点,而实际上它还不够成熟或可靠。 -

Al太快地信任某人,而实际上那人不那么值得信任。

所以,总体来说,这句话在暗示Al的某个决定、判断或评价是仓促的,结果给出了不适当的正面反馈。Al应该更加谨慎地鉴定事物的价值和可靠性,而不是轻易给出积极的评价。

与其关注人工智能在我们生活的各个方面的预期采用,不如考虑磨练人工智能无法实现的东西。

无法实现人工智能的是无法数字化或自动化的行动、任务和技能。这些例程要求人类不断参与循环,以做出关键和关键的决定。

因此,我确定了三类人类驱动的决策能力,每个部门和行业目前都需要,并且在可预见的未来将需要。

情境意识。现在上下文不是铁板一块。人类考虑的背景类型可能不止以下一种:文化、经济、情感、历史、位置、政治、情境和社会。

通常有一条贯穿线来交叉这些不同的背景。经济视角不能与社会和/或政治视角分开。

将这些上下文隔离为独立且相同分布的元素并不是现实生活 - 无论有多少知名的AI研究人员试图通过精心设计的实验和已发表的结果构建一个具有代表性的数学方程。

像这样的图像在网上分享,需要人们的历史、位置和政治意识知道它们是为了引起公众的某种反应而制造和制造的。

冲突解决。人工智能无法处理摩擦。事实上,它选择了一方——最不讨人喜欢的一面。

2016 年,人工智能聊天机器人 Tay 在被关闭前不到 1 天就发布了种族主义、厌恶女性和其他主义的推文。

快进到 2023 年 <> 月,注入 ChatGPT 的 Snapchat 人工智能聊天机器人向一名成年人传播了不适当的建议,称他们是未成年人。

人工智能不知道什么时候该闭嘴或不回答。AI被编程为提供响应。该答复的质量、适当性和有效性仍然值得怀疑。

处理难题是人工智能系统、工具和平台的一个明显薄弱领域。人工智能有可能为人类提供选择,但它不能真正帮助我们做出明智的选择。

批判性思维。我们人类评估和评估环境的能力是我们显着特征之一。批判性思维技能结合了解决问题、好奇心、创造力、推理和策略。

人工智能不能很好地完成这些批判性思维元素之一。例如,计算机编程,又名编码,确实解决了数学问题。

但是,一旦数学方程式中的任何元素成为人们的代理,那么通过编码方法解决问题的方法就会中断,因为至少有一个人口群体因此被排斥和压迫。

在另一个例子中,人工智能艺术试图声称人工智能是创造性的。但是,有一些棘手的版权侵权纠纷引起了人们对从在线存储库中废弃的内容的合法(和道德)使用的担忧。

人工智能之所以达到这个水泥天花板,是因为推理和判断是通过平衡生活经验、专业知识和技能做出的。

人工智能没有生活经验,由训练/测试数据集和可编程技能决定的专业知识有限。其余的则由人们在锻炼批判性思维技能时承担。

人工智能无法提供情境感知、解决冲突或批判性思考。如果你进入一个需要融合这三种功能的职业或技能,那么你将有一条谋生之路。

最有可能的是,你的工作职责会转变,而不是消失,这样你就会诊断多种环境的影响,管理紧张局势和批判性思考。

例如,对于编码人员(无论是否拥有计算机科学学位)来说,我们将更需要解释和解释生成AI实际上在做什么。

如果不意识到您编写的代码行的潜在社会影响,您将无法成为一名软件开发人员。从本质上讲,我们所有人都能够理解我们主要学科中基于数字和沟通技能的优势和劣势的细微差别,这一点非常重要。

AI无法实现的是不能数字化或自动化的行为、任务和技能。

这些例行工作需要人类不断参与,以作出关键和关键决定。所以,我已经确定了每个行业目前需要和未来可预见的未来都需要的三类人为决策能力。

本文由 mdnice 多平台发布