https://github.com/ShannonAI/dice_loss_for_NLP

通过定义Dice Loss,替代cross entropy(CE)处理数据不平衡问题。

问题

在样本不平衡的情况中,主要有以下两种难以克服的难点

the training-test discrepancy: 如果不能很好的平衡样本标签,那么模型学习过程通常会朝着有更多标签的类别收敛。

the overwhelming effect of easy-negative examples: 如果容易判别的负样本太多,那么模型很难学习到真正区分正样本与负样本的边界,很难捕捉到特征。

方法

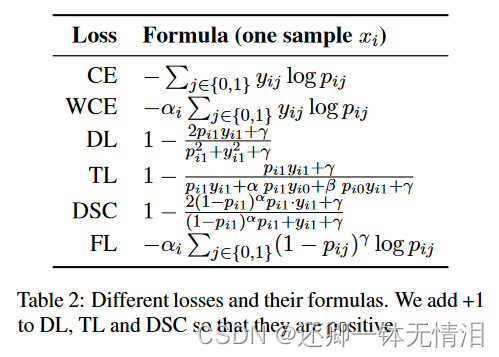

交叉熵

权重交叉熵

损失函数

实验

Part-of-Speech Tagging

Named Entity Recognition

Machine Reading Comprehension

Paraphrase Identification

不均衡数据集

实验结果

实验结果太多了,请大家参照原文吧

https://arxiv.org/abs/1911.02855

https://arxiv.org/pdf/1911.02855.pdf

Reference