法语简介:

ABSTRAIT

Le succès des méthodes de réseau de neurones pour le calcul des intégrations de mots a conduit à des méthodes activées pour générer des enchaînements sémantiques de textes plus longs, tels que des phrases et des paragraphes. Étonnamment, Wieting et al (ICLR’16) ont montré que ces méthodes compliquées sont plus performantes, en particulier dans les contextes hors domaine (apprentissage par transfert), par des méthodes plus simples impliquant une rééducation légère des mots incorporés et une régression linéaire de base. La méthode de Wieting et al. nécessite un recyclage avec un ensemble de données étiqueté substantiel tel que la base de données Paraphrase (Ganitkevitch et al., 2013).

Le document actuel va plus loin, montrant que l’inclusion de phrases non divulguées ci-dessous est une base de référence formidable: Utilisez des mots incorporés à l’aide d’une des méthodes les plus répandues sur des corpus non étiquetés comme Wikipedia. vecteurs de mots, puis modifiez-les un peu en utilisant PCA / SVD. Cette pondération améliore les performances d’environ 10% à 30% dans les tâches de similarité textuelle, et surpasse les méthodes supervisées sophistiquées, notamment les RNN et les LSTM. Cela améliore même les intégrations de Wieting et al. Cette méthode simple devrait être utilisée comme base de référence à l’avenir, en particulier lorsque les données de formation étiquetées sont rares ou inexistantes.

Le papier donne également une explication théorique du succès de la méthode non surveillée ci-dessus utilisant un modèle générateur de variables latentes pour les phrases, qui est une simple extension du modèle dans Arora et al. (TACL’16) avec de nouveaux termes de «lissage» qui permettent de faire apparaître des mots hors contexte, ainsi que des probabilités élevées pour des mots comme et, pas dans tous les contextes.

- INTRODUCTION

Les Word embeddings calculées à l’aide de diverses méthodes sont les composantes de base du traitement du langage naturel (NLP) et de la recherche d’informations (IR). Ils capturent les similitudes entre les mots (par exemple, (Bengio et al., 2003; Collobert et Weston, 2008; Mikolov et al., 2013a; Pennington et al., 2014)). Des travaux récents ont tenté de calculer des incorporations qui capturent la sémantique des séquences de mots (phrases, phrases et paragraphes), avec des méthodes allant de la simple composition additionnelle des vecteurs à des architectures sophistiquées telles que les réseaux neuronaux Iyyer et al., 2015; Le & Mikolov, 2014; Kiros et coll., 2015; Socher et coll., 2011; Blunsom et coll., 2014; Tai et coll., 2015; Wang et coll., 2016)). Récemment, (Wieting et al., 2016) ont appris les enchaînements de phrases paraphrastiques à usage général en commençant par des mots standard et en les modifiant en se basant sur le jeu de données Paraphrase (PPDB). modèle de moyenne. Cette méthode simple permet d’obtenir de meilleures performances sur les tâches de similarité textuelle qu’une grande variété de méthodes et constitue une bonne initialisation pour les tâches de classification textuelle. Cependant, la supervision à partir du jeu de données paraphrase semble cruciale, car ils signalent que la moyenne simple des termes initiaux ne fonctionne pas très bien.

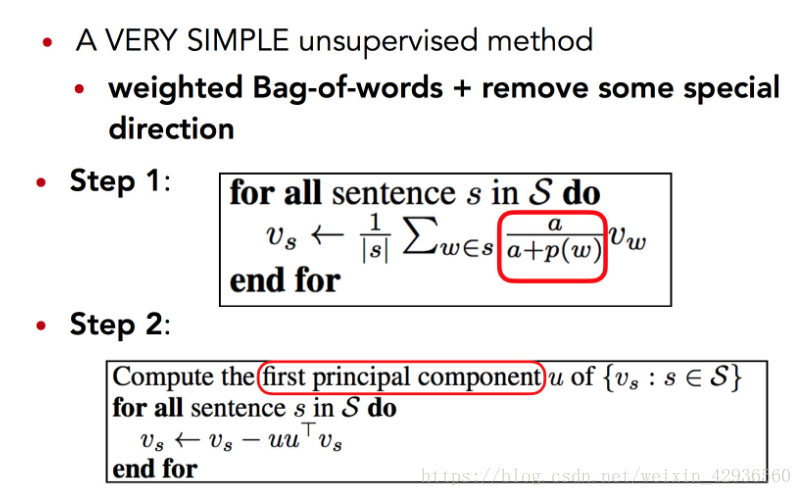

Nous donnons ici une nouvelle méthode d’incorporation de phrases qui est d’une simplicité embarrassante: calculez simplement la moyenne pondérée des vecteurs de mots dans la phrase, puis supprimez les projections des vecteurs moyens sur leur première composante principale («suppression de composants communs»). Ici, le poids d’un mot w est a / (a + p (w)) avec un paramètre et p (w) la fréquence de mot (estimée); nous appelons

1

Publié en tant que document de conférence à l’ICLR 2017

cette fréquence inverse lisse (SIF). Cette méthode permet d’obtenir des performances significativement supérieures à la moyenne non pondérée sur diverses tâches de similarité textuelle, et sur la plupart de ces tâches, même sur certaines méthodes sophistiquées testées (Wieting et al., 2016), y compris certains modèles RNN et LSTM. Le procédé est bien adapté aux paramètres d’adaptation de domaine, c’est-à-dire que des vecteurs de mots formés sur divers types de corpus sont utilisés pour calculer les enchaînements de phrases dans différents bancs de test. Il est également assez robuste au schéma de pondération: utiliser les fréquences de mots estimées à partir de différents corpus ne nuit pas aux performances; une large gamme de paramètres peut atteindre des résultats proches des meilleurs, et une gamme encore plus large peut permettre une amélioration significative par rapport à la moyenne non pondérée.

Bien sûr, cette repondération SIF rappelle fortement la repondération de TF-IDF à partir de la recherche d’informations (Sparck Jones, 1972; Robertson, 2004) si l’on considère une «phrase» comme un «document» et suppose raisonnablement que la phrase ne contiennent généralement des mots répétés. De telles repondérations (ou des idées apparentées telles que la suppression de mots fréquents du vocabulaire) sont une bonne règle de base mais n’ont pas de justification théorique dans un contexte d’intégration de mots.

L’article actuel fournit une justification théorique pour la repondération en utilisant un modèle génératif pour les phrases, qui est une modification simple du modèle Random Walk on Discourses pour générer du texte (Arora et al., 2016). Dans cet article, il a été noté que le modèle implique théoriquement l’incorporation d’une phrase, à savoir la moyenne simple des encastrements de tous les mots.

Nous modifions ce modèle théorique, motivé par l’observation empirique que la plupart des méthodes d’intégration de mots, car elles cherchent à capturer des probabilités de coïncidence des mots en utilisant un produit interne vectoriel, finissent par donner de grands vecteurs à des mots fréquents. , simplement pour tenir compte de l’observation empirique selon laquelle les mots sont parfois hors contexte dans les documents. Ces anomalies font que la moyenne des vecteurs de mots ont des composantes énormes dans des directions sémantiquement sans signification. Notre modification du modèle génératif de (Arora et al., 2016) permet de «lisser» les termes, puis un calcul de la probabilité maximale conduit à notre repondération SIF.

Fait intéressant, ce SIF théoriquement dérivé fait mieux (de quelques points de pourcentage) que le TF-

IDF dans notre cadre. La méthode améliore également les enchaînements de phrases de Wieting et al.

dans le tableau 1. Enfin, nous avons découvert que - contrairement à la croyance répandue - Word2Vec (CBOW)

n’utilise pas la moyenne simple des vecteurs de mots dans le modèle, comme suggéré de manière trompeuse par les

expression Pr [w | w1, w2, …, w5] ∝ exp (vw · (1 vwi)). Une fouille dans l’implémentation montre 5i

elle utilise implicitement une moyenne pondérée de vecteurs de mots - principale, différente de TF-IDF - et cette pondération se révèle tout à fait similaire à la nôtre. (Voir la section 3.1.)

中文介绍:

第一步,对每个词向量乘以相应的权值,这个权值与该词语频率相关,求和后得到暂定的句向量。

第二步,计算语料库所有句向量构成的矩阵的第一主成分u,让每个句向量减去它在u上的投影(类似PCA)。

效果:

在句子相似度任务上超过平均水平,甚至超过部分复杂的模型。在句子分类上效果也很明显,甚至是最好成绩。