0. 简述

运动信息对于视频中动作的识别有着重要的作用。其中最常用的一种运动信息,是光流。之前的方法计算光流是offline的,比较耗时,本文提出了一种新的简洁的运动表示,叫做Optical Flow guided Feature (OFF)。OFF通过直接计算feature map上pixel-wise的时空梯度,使得CNN可以直接从帧计算到temporal information。

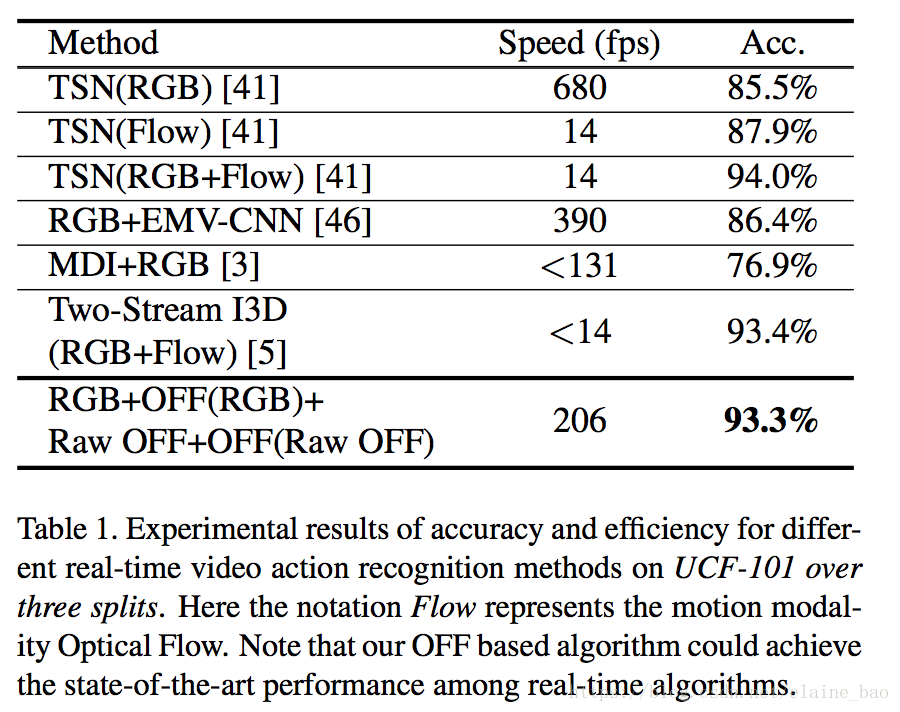

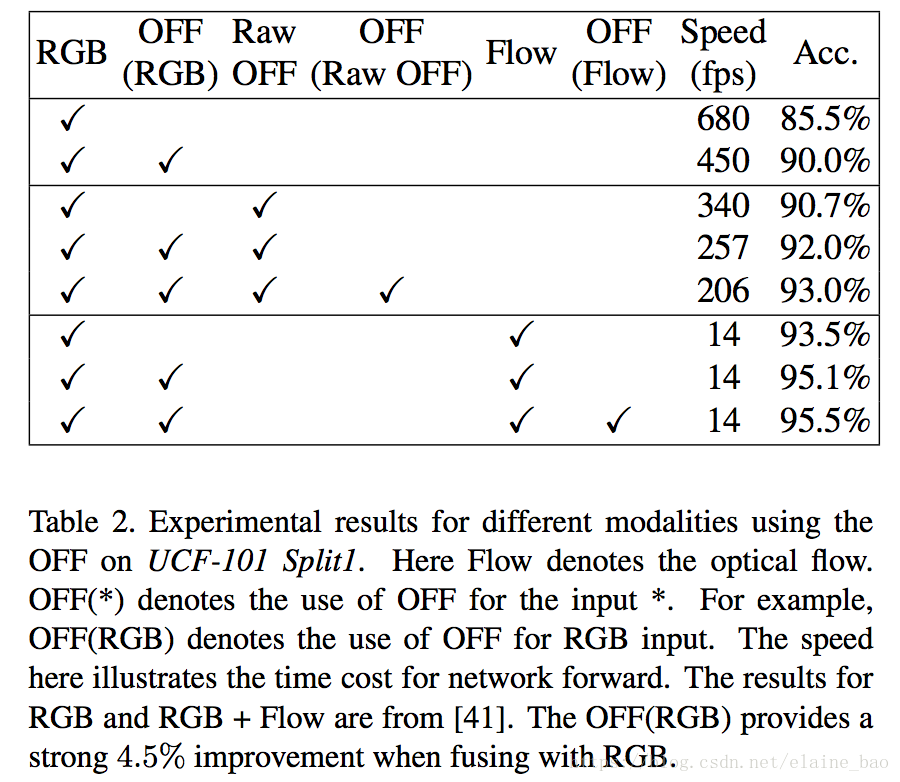

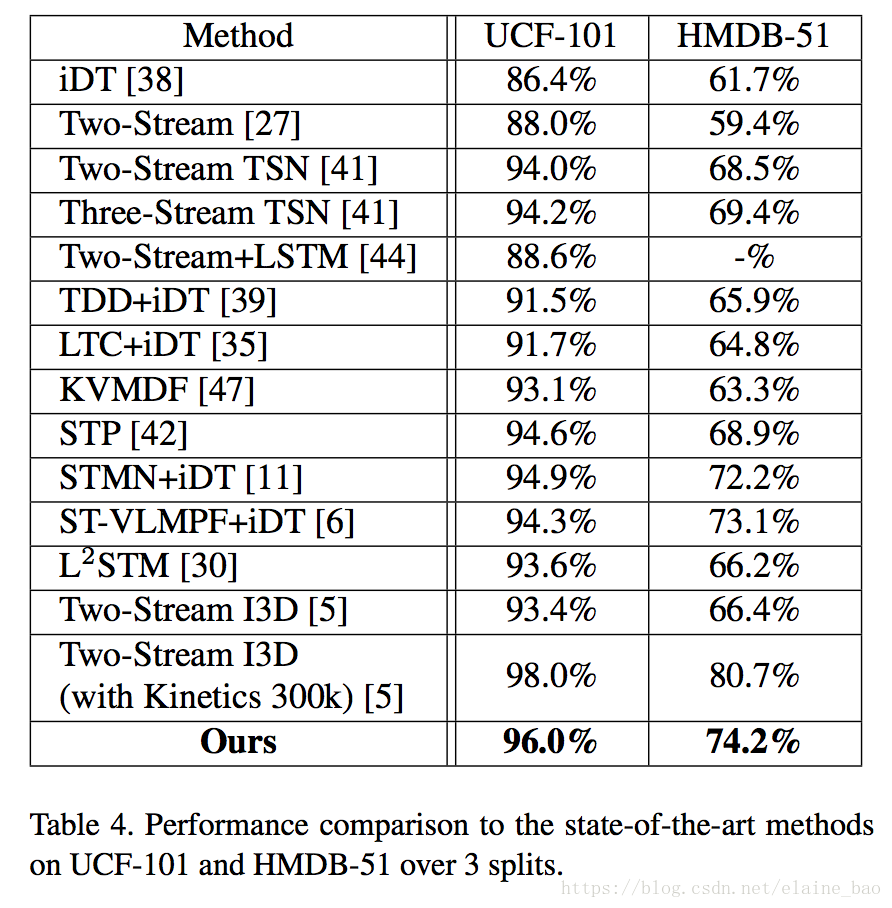

实验显示,在UCF101上仅以RGB输入到OFF网络得到的acc达到93.3%,和two stream(RGB+optial flow)的acc相当,并且快15倍。实验也显示OFF还可以和其他motion modalities如传统光流等配合使用,如将OFF插入到two-stream网络中能达到96.0%的acc。

本文的贡献主要在两个方面:

1. OFF是一个快速鲁邦的motion representation。当输入只有RGB时,OFF能够达到200fps,且性能和state-of-the-art的光流算法相当。

2. OFF可以end-to-end地训练,也就是说在一个网络里面可以同时学到spatial和temporal的特征表达了,不用再像two-stream那么分两个分支来进行了。

1. Optical Flow Guided Feature的来历

OFF是从光流的定义得到的。光流的基本假设有3个:

(1)相邻帧之间的亮度恒定

(2)相邻视频帧的取帧时间连续,即,相邻帧之间物体的运动比较“微小”;

(3)保持空间一致性,即,同一子图像的像素点具有相同的运动

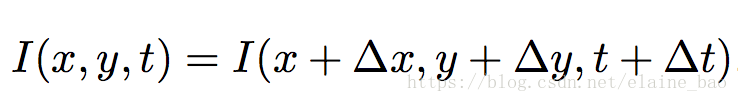

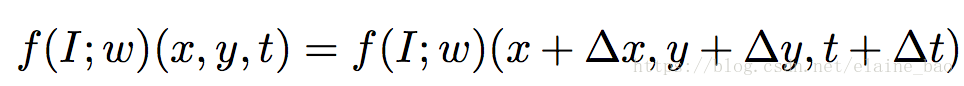

根据光流的微小运动和亮度恒定的假设,我们可以得到:

其中I(x,y,t)表示的是t时刻的一帧图像I上位置(x,y)的像素值。

将上述假设推广到特征层,即:

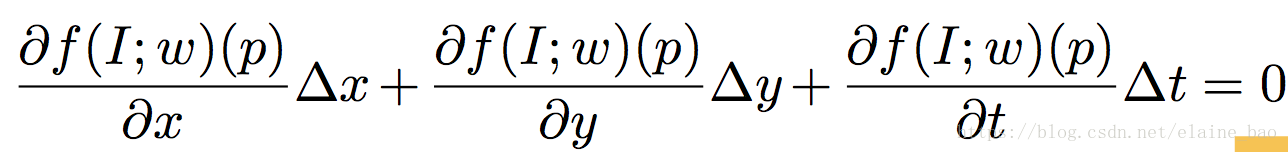

其中f(I;w)表示的是一帧图像I的特征提取function,w为参数。function可以是任何可微函数,在本文中我们使用的是CNN。根据光流的定义,上式中令p=(x,y,t),得到:

等式左右两边同时除以

,得到:

这里的(

,

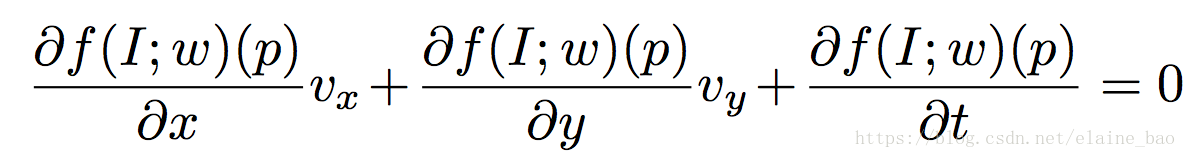

)相当于在feature点p上的二维速度矢量。其中前两项的偏微分相当于

在x方向和y方向的spatial gradients,第三项的偏微分则是t方向上的temporal gradients。

特殊情况下,当 f(I;w)(p) = I(p)时,f(I;w)(p)就表示t时刻的一帧图像I上位置(x,y)的像素值,这个时候(

,

)就是常见的光流了。那么在一般情况下,我们将(

,

)称为特征光流(feature flow)。

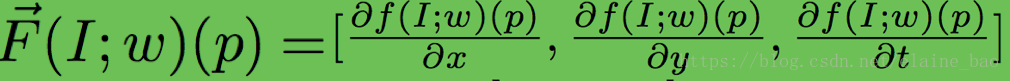

从上式中我们看到

是和feature flow [

,

, 1]成正交关系的,即

变化时feature flow也发生变化,因此我们称

为Optical Flow guided Feature (OFF)。当满足f(I;w)(p) = I(p)时,我们称

为Raw OFF。OFF

将空间时间的信息编码成和特征光流(

,

)正交且互补的向量。

3. 将OFF用于CNN

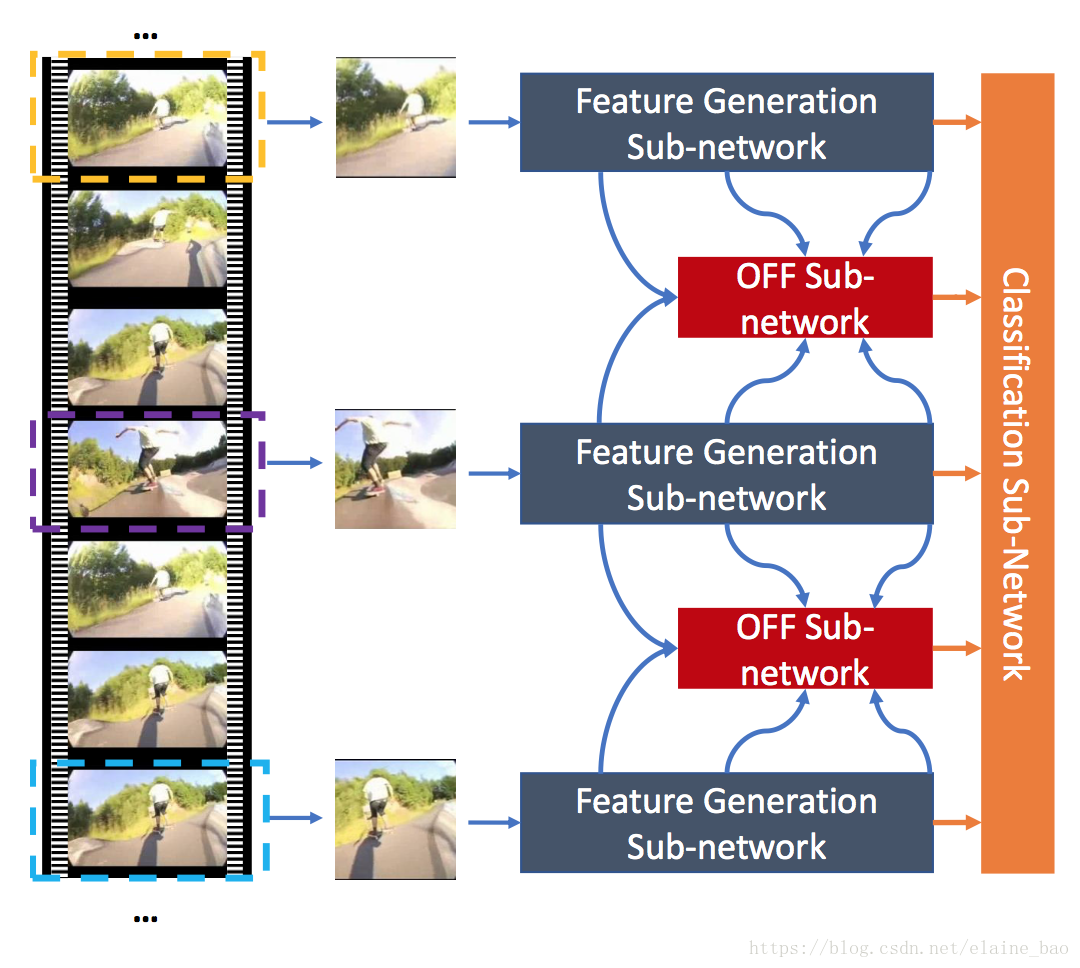

整个网络包含3个子网络:feature generation sub-network, OFF sub-network 和classification sub-network。

(1)feature generation sub-network: 用的是BN-Inception来提取feature map。

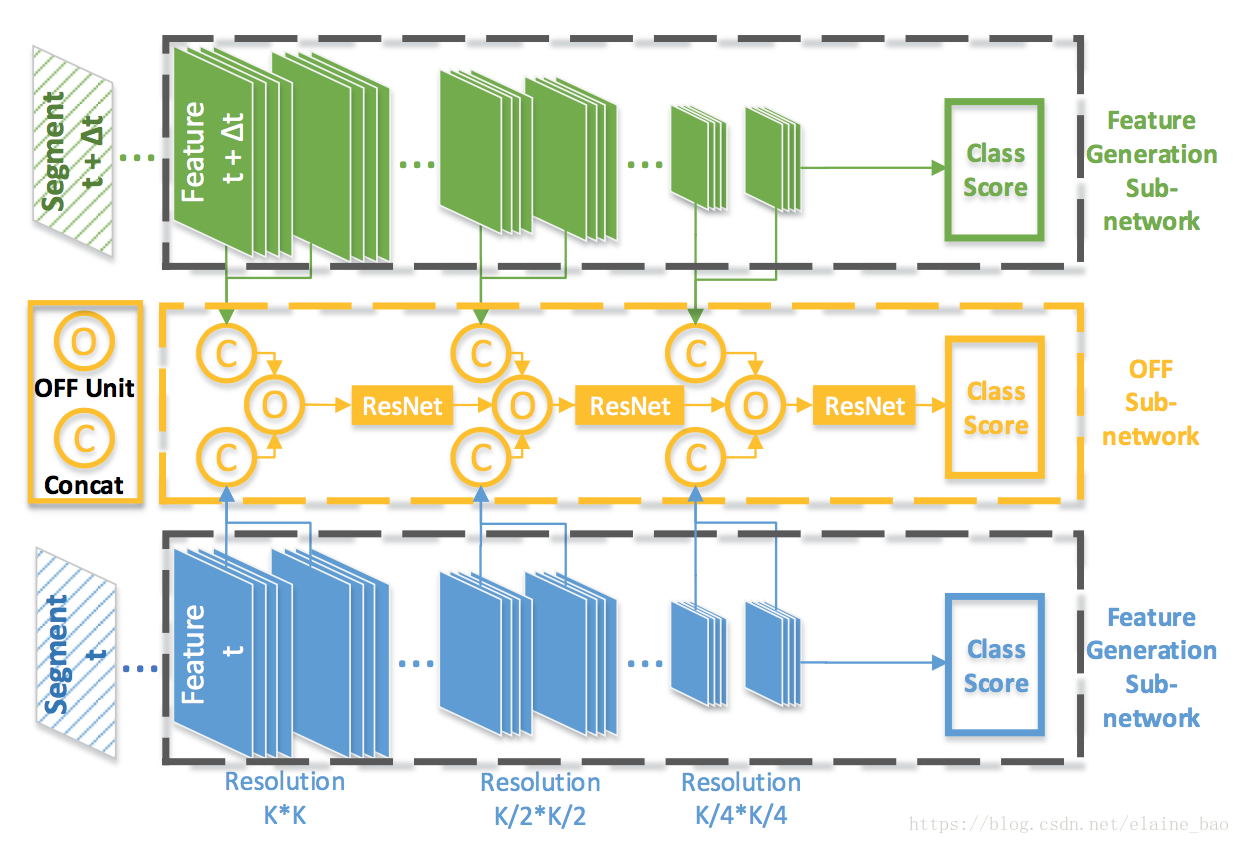

(2)OFF sub-network。包括几个OFF units用于提取OFF特征,不同的OFF units使用不同深度层级的features,如下图所示。不同的OFF units之间包含几个residual blocks用于refine特征。

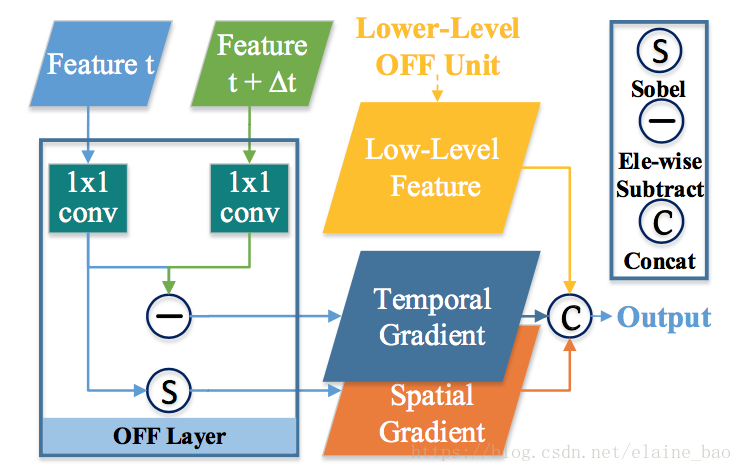

OFF unit的结果如下图所示,每个OFF unit包含一个OFF层用于提取OFF,每个OFF层首先通过1*1 conv层(128D)来对两个输入的feature进行dimension reduction,然后通过(1)element-wise的相减得到temporal gradient;(2)sobel计算得到spatial gradient;(3)low-level OFF结果的concat三个部分一起得到OFF的输出。

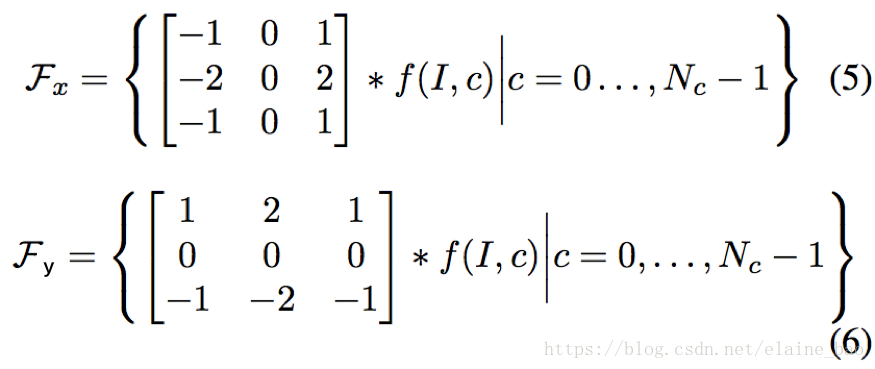

其中用于得到spatial gradient的sobel算子定义如下。什么?为什么sobel算子能得到spatial gradient?因为它是边缘检测算子呀。

(3)Classification sub-network。所有模块输出的score做平均。

整个网络的训练采用3阶段的训练策略。在第1阶段,我们使用已有的方法,如TSN来训练feature generation sub-network。在第2阶段,我们训练OFF sub-network和classification sub-network,同时frozen feature generation sub-network的参数。OFF sub-network和classification sub-network的参数是 learn from scratch。第3阶段,整个网络进行end-to-end的finetune直到最终收敛。

4. 实验