可以自己学习的激活函数(Maxout)

在深度学习中激活函数有sigma, tanh, relu,还有以后会将到的selu,但是有没有一个激活函数不是人为设定的,是机器学出来的呢?对抗网络(GAN)之父Goodfellow,给我们一个肯定的答案。Learnable activation function [Ian J. Goodfellow, ICML’13]

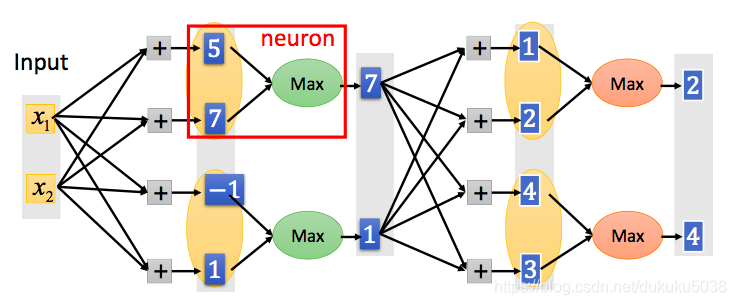

我们以两个输入的input举例,当然,input的维度可以更多。

每一层的结果,就是两两求最大值。

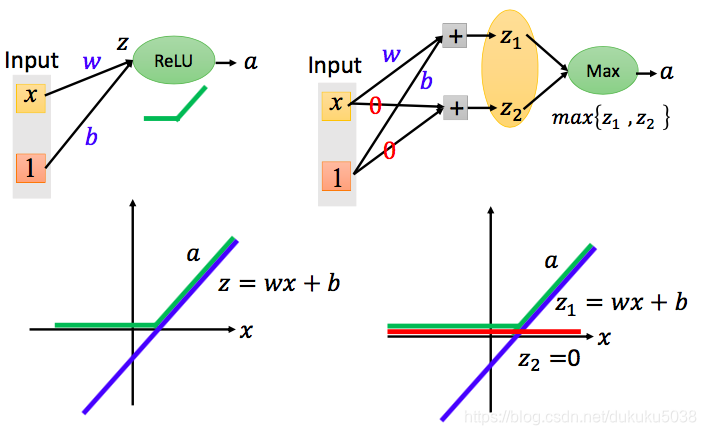

Relu是一种特殊的maxout

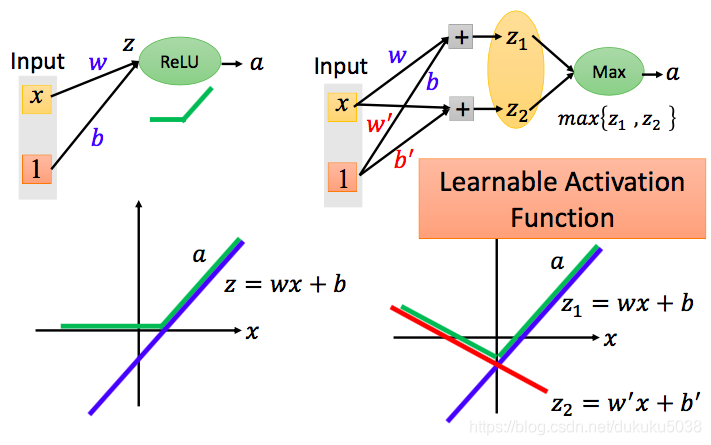

可学习的激活函数 learnable activation function

除了Relu之外 more than Relu

Maxout的性质

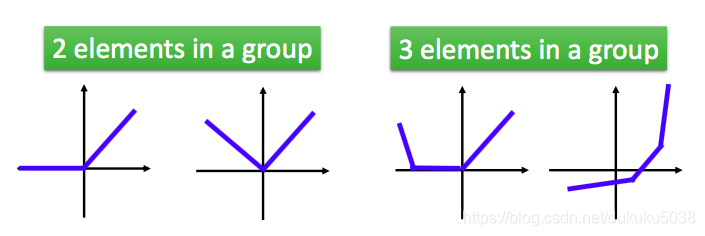

- 任何在maxout network的都会被piecewise的线性凹函数表示

- 有多少线段,取决于多少个元素为一组

maxout的训练: