基本神经网络的实现

1. 神经元的抽象模型

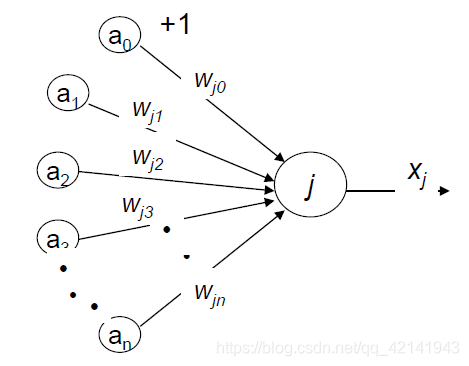

- Each input i transmits a real value ai

- Each connection is assigned with the weight wij

- The sum of the products of the inputs with the corresponding weights

- Threshold (equal to 0 in this case)

- Outcome Xi is produced by comparing the weighted sum with the threshold.

2. The McCulloch-Pitts Neuron (M-P)

2.1 基本概念

- A binary discrete-time element;

- With excitatory and inhibitory inputs and an excitation threshold;

- The network of such elements was the first model to tie the study of neural networks to the idea of computation in its modern sense.

2.2 模型与算法

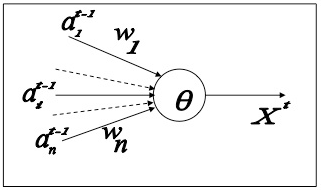

- Input values

ait from the i-thpresynaptic neuron at any instant t maybe equal either to 0 or 1 only - Weight

+1 forexcitatory type connectionand

-1 forinhibitorytype connection - Excitation Threshold

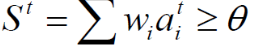

There is an excitation threshold θ associated with the neuron

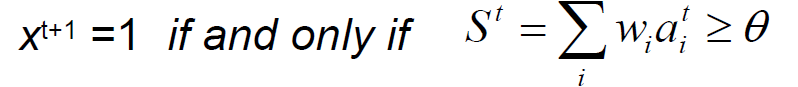

兴奋阈值代表大于自己有输出 - Output xt+1

- Instant state of the neuron

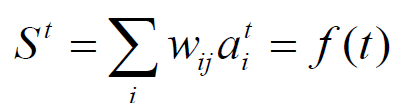

Call the instant total input St (t 时刻的加权和)

和之一神经元之前的状态无关 - Output

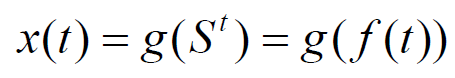

The neuron output xt+1 is function of its state St, therefore the output also can be written as function of discrete time.

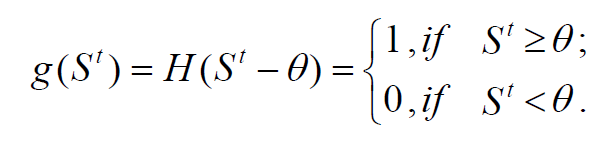

where g is the threshold activation function 阈值激活函数

与 相同

相同

同时在这里 H is the Heaviside (unit step) 海维赛德 函数或者单位阶跃函数 function:

所以在这里激活函数为阶跃函数 可以从输出性质看出

2.3 M-P Neural 实现的功能

- storing information

- producing logical and arithmetical operations

相对与人脑的

- to store knowledge

- to apply the knowledge stored to solve problems

实现存储信息的起始是Instant State 即加权和 但是对于神经网络来说其实是权重

实现逻辑以及算数操作的其实是激活函数 也是其引入非线性

2.4 M-P 所面临的学习问题

Some easily changeable free parameters are needed

In a network of MP-neurons, binary weights of

connections and thresholds are fixed. The only

change can be the change of pattern of connections,

which is technically expensive.

3. ANN Learning Algorithm (初步)

3.1 Defination

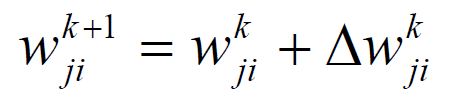

- How to adjust the weights of connections to get desirable output.

- Much work in artificial neural networks focuses on the learning rules that define: How to change the weights of connections between neurons to better adapt a network to serve some overall function.-曲线拟合

3.2 Hebb’s Rule

-

巴甫洛夫的条件反射实验

每次给狗喂食前都先响铃,时间一长,狗就会将铃声和食物联系起来。以后如果响铃但是不给食物,狗也会流口水。 -

赫布假说:

受该实验的启发,Hebb的理论认为在同一时间被激发的神经元间的联系会被强化。比如,铃声响时一个神经元被激发,在同一时间食物的出现会激发附近的另一个神经元,那么这两个神经元间的联系就会强化,从而记住这两个事物之间存在着联系。相反,如果两个神经元总是不能同步激发,那么它们间的联系将会越来越弱。

我们可以假定,反射活动的持续与重复会导致神经元稳定性的持久性提升……当神经元A的轴突与神经元B很近并参与了对B的重复持续的兴奋时,这两个神经元或其中一个便会发生某些生长过程或代谢变化,致使A作为能使B兴奋的细胞之一,它的效能增强了。

但是,这个解释并不完整,赫布强调说,神经元"A"必须对神经元"B"的激发“作出了一定贡献”,因此,神经元"A"的激发必须在神经元"B"之先,而不能同时激发。赫布理论中的这一部分研究,后来被称作STDP,表明 突触可塑性需要一定的时间延迟 。赫布理论可以用于解释“联合学习”(associative learning) ,在这种学习中,由对神经元的重复刺激,使得神经元之间的突触强度增加。这样的学习方法被称为赫布型学习(Hebbian learning)。赫布理论也成为了非监督学习的生物学基础。

可总结为 同时激发的神经元间的联系会不断加强, 而总是不能同时激发的神经元间的联系会不断变弱 -

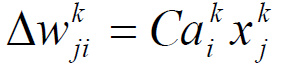

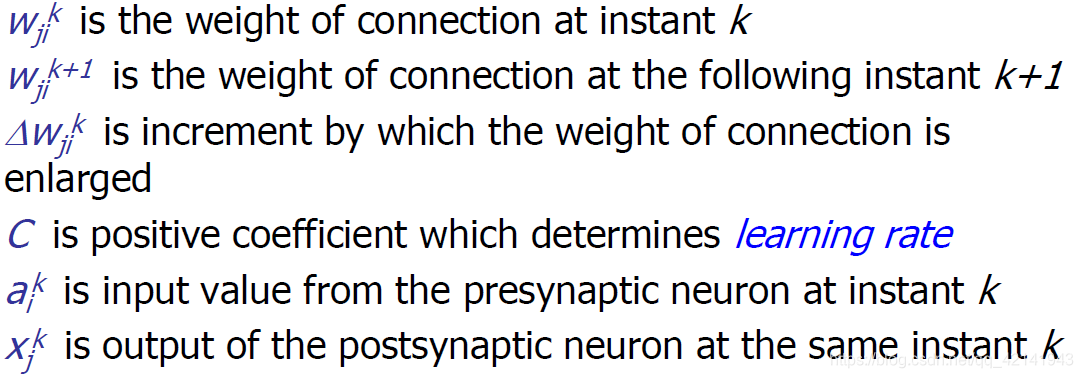

Simplest Formalization of Hebb’s Rule

其中 Wij 表示神经元j到神经元i的连接权,yi与yj表示两个神经元的输出,C是表示学习速率的常数

- 如果yi与yj同时被激活,即yi与yj同时为正,那么wij将增大。

对应了同时被激励的情况两个神经元间的连接加强 - 如果yi被激活,而yj处于抑制状态,即yi为正yj为负,那么wij将变小。

对应了不同时被激励的情况两个神经元间的联系减弱