声明:语音合成论文优选系列主要分享论文,分享论文不做直接翻译,所写的内容主要是我对论文内容的概括和个人看法。如有转载,请标注来源。

欢迎关注微信公众号:低调奋进

LightSpeech: Lightweight and Fast Text to Speech with Neural Architecture Search

本文章是中国科学技术大学和微软在2021.02.08更新的文章,本文章是使用AutoML中的NAS来搜索最佳的网络结构,这是我看到的第一篇使用NAS来优化语音合成模型,具体的文章链接https://arxiv.org/pdf/2102.04040.pdf

1 研究背景

虽然现在的语音合成的合成音频质量很高,但性能的问题是限制模型落地的关键,尤其是自回归模型。为了提高速度,很多研究提出非自回归模型,例如fastspeech2系统。一个较好的模型需要研究人员通过经验来设置超参,并通过大量实验来选择较好的版本。模型的超参包括控制参数更新的超参和控制网络架构的超参,而控制网络的超参往往凭借研究人员的经验来设置,根本无法获得最优的模型。AutoML的neural architecture search根据设定的搜索空间来寻找最优的网络结构,本文就是我看到第一篇使用该方法来寻找较优的模型。本文主要在fastspeech上进行优化,实验结果显示模型被压缩15倍,推理速度提高6.5倍,而且MOS反而提高一些。(当然NAS的缺点大家都知道,需要“钞能力”,google以前的方法动不动几千块GPU,动不动一个月的训练时间,我们也只能望卡兴叹。我对AutoML不是太熟,近两年算法应该提升很多,有时间多阅读这方面的文章。)

2 详细设计

本文先分析了系统fastspeech2的每个模块的时间开销情况,由table 1可知,大部分的时间主要在DEcoder部分。

本文设计了NAS的搜索空间如下

3 实验结果

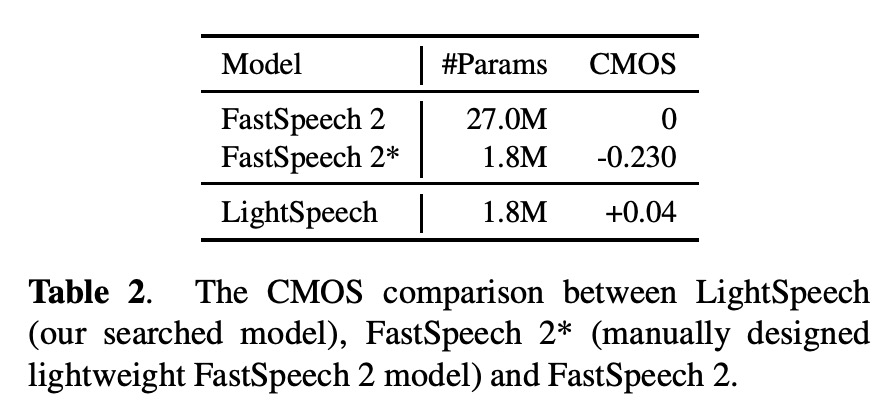

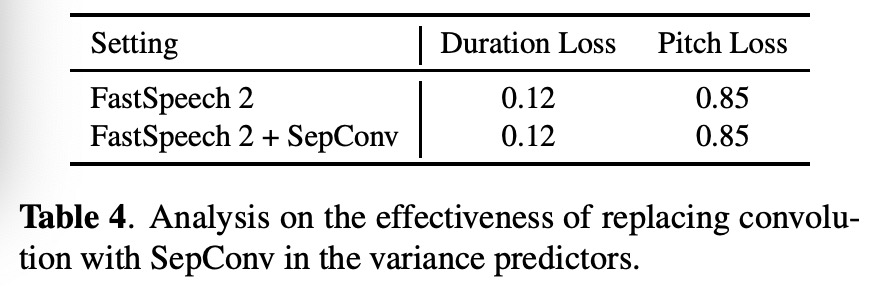

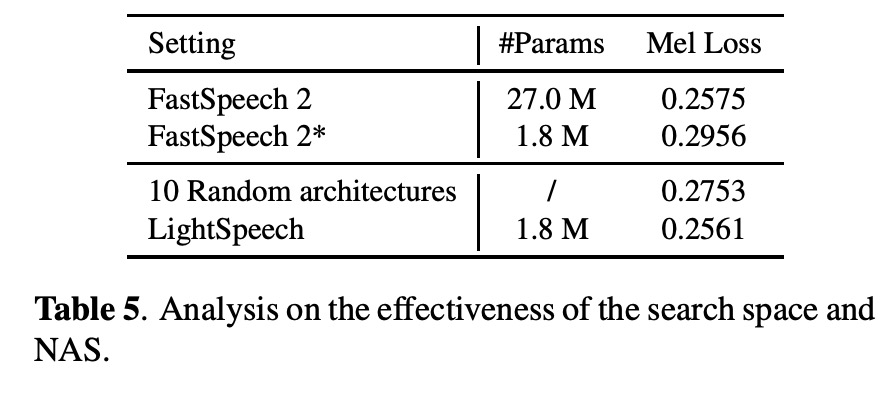

tabel 2显示在FastSpeech2上进行,FastSpeech2*是作者手动调参的模型,LightSpeech是NAS搜索的模型,结果显示模型参数减少了15倍,而且FastSpeech2*的MOS降低,但LightSpeech的MOS却微微增加了。table3也展示了LightSpeech的模型压缩15倍但推理速度提高6.5倍。table4和table5是本文其它实验,在此不做介绍。

4 总结

本文是第一篇使用AutoML方法来寻找较优的模型。本文主要在fastspeech上进行优化,实验结果显示模型被压缩15倍,推理速度提高6.5倍,而且MOS反而提高一些。