- 论文题目:Point Transformer V2: Grouped Vector Attention and Partition-based Pooling

- 发布期刊:NeurIPS

- 通讯地址:香港大学 & 英特尔实验室 & 马克斯普朗克研究所

- 代码地址:https://github.com/Gofinge/PointTransformerV2

介绍

介绍了一个改进版的3D点云理解模型,称为Point Transformer V2(PTv2)。论文分析了原始PTv1的局限性,并展示了PTv2在多个基准测试中的精度和效率均优于PTv1。此外,论文还通过详细的消融实验评估了PTv2中各个模块的影响,并评估了模型的复杂度和延迟,展示了这些改进带来的显著优势。

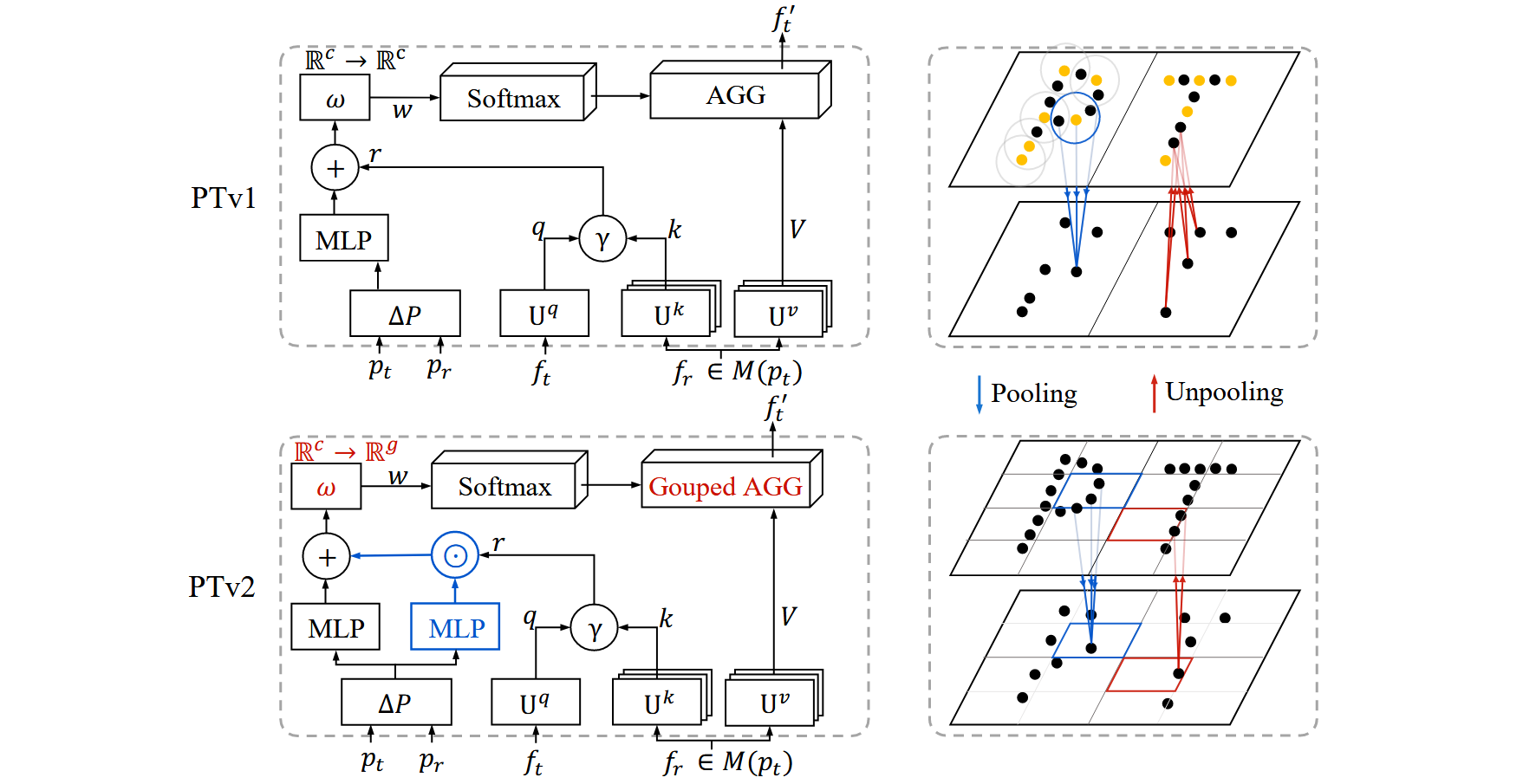

- 分组向量注意力(Grouped Vector Attention, GVA):PTv2引入了一种新的分组向量注意力机制,与原始的Point Transformer V1(PTv1)中的向量注意力相比,增强了模型的效率和可扩展性。通过将注意力向量分组,减少了参数数量,避免了过拟合,同时保留了多头注意力和向量注意力的优点。

- 改进的位置信息编码:论文强调了3D点云中空间关系的重要性,并引入了改进的位置信息编码乘子,以更好地利用3D空间中的几何信息。

- 基于分区的池化方法:PTv2提出了一种更高效的池化策略,将点云划分为不重叠的分区(网格),相比传统的池化方法(如最远点采样,FPS),实现了更好的空间对齐并减少了计算复杂度。

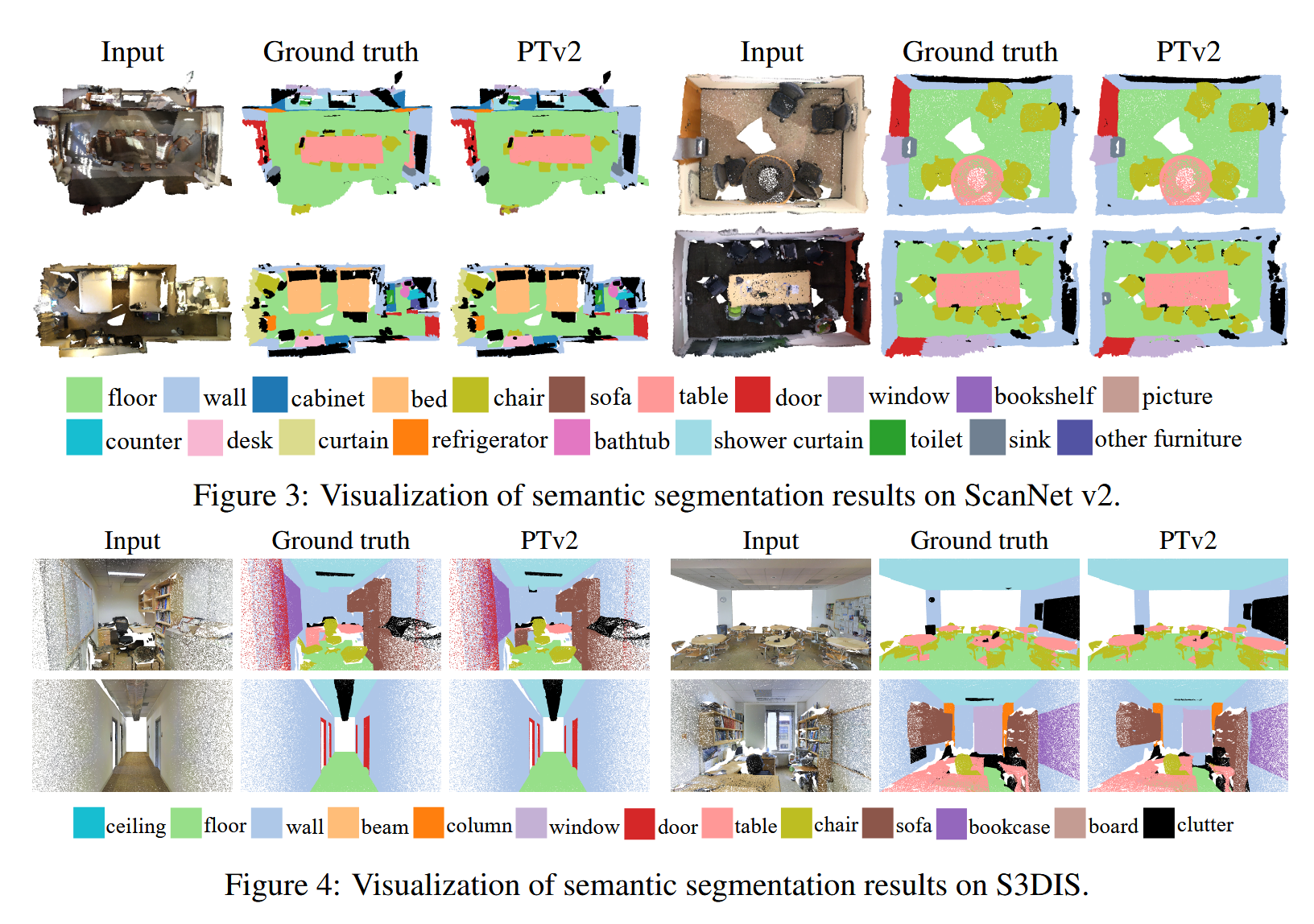

- 广泛的实验验证:该模型在各种3D点云任务(如分割和分类)上进行了评估,并在ScanNet v2、S3DIS和ModelNet40等数据集上取得了最先进的性能表现。

核心思想

Point Transformer V2的核心思想是通过分组向量注意力、改进的位置信息编码和基于分区的池化等新设计,解决了V1模型在深度和复杂度增加时的效率瓶颈,增强了模型在3D点云处理任务中的表现。其核心思想体现在以下几个方面:

-

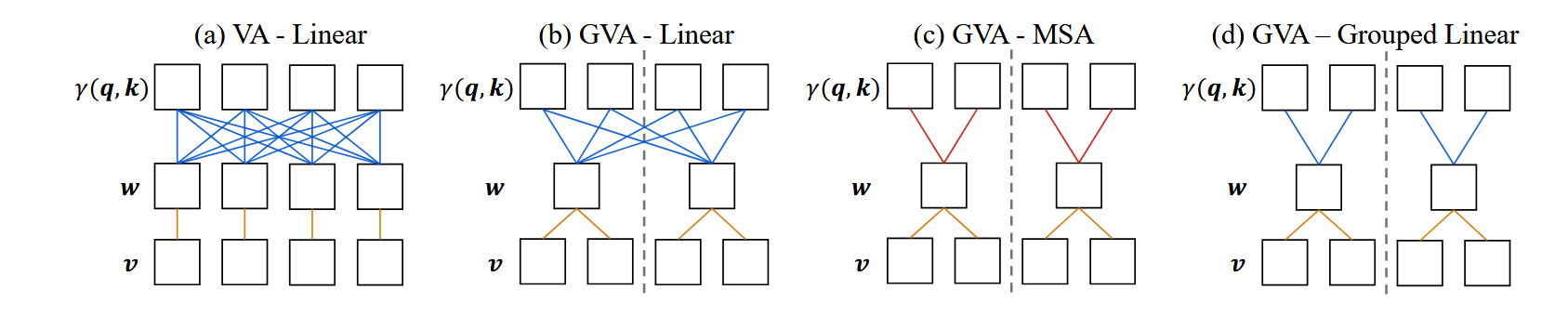

分组向量注意力(Grouped Vector Attention, GVA):这是该模型的核心创新之一。与Point Transformer V1中使用的向量注意力不同,GVA将通道分组,每组共享相同的注意力权重。这种分组机制减少了模型参数数量,提高了参数利用效率,避免了过拟合问题,同时保持了多头注意力(Multi-head Attention)和向量注意力的优点。通过分组,GVA能够在保持模型能力的同时提升计算效率,特别是在模型变得更深或通道数增多的情况下。

-

改进的位置信息编码:3D点云中的点是非规则分布的,位置信息对理解点云几何结构至关重要。PTv2引入了一个新的位置编码乘子(Position Encoding Multiplier),强化了点之间的几何关系表示。相比之前简单的加性编码,乘子机制能够更好地捕捉点之间的空间关系。

-

基于分区的池化(Partition-based Pooling):传统的点云池化方法(如最远点采样FPS)存在空间分布不一致和计算开销大的问题。PTv2引入了一种基于分区的池化方法,通过将点云划分为不重叠的网格分区,从而在每个分区内进行聚合。这种方法不仅提高了计算效率,还增强了空间对齐能力,确保在点云处理时能够更好地保持几何一致性。

核心代码实现讲解

Point Transformer V2 结合了新的注意力机制、位置信息编码以及池化方法来解决3D点云理解中的挑战。以下是对其核心思想和相应代码的详细解释:

分组向量注意力机制(Grouped Vector Attention)

核心思想:

- 在处理3D点云时,注意力机制需要对每个点与其邻域点的关系进行建模。Point Transformer V2 引入了分组向量注意力机制(Grouped Vector Attention, GVA),通过将通道分组,每个组共享相同的注意力权重,从而减少计算复杂度,避免模型因参数过多而导致的过拟合。

- 这种机制结合了多头注意力的优点(对不同组特征的独立关注)和向量注意力的优点(在每个通道上进行更细致的特征加权)。

对应代码:

class GroupedVectorAttention(nn.Module):

...

def forward(self, feat, coord, reference_index):

query, key, value = self.linear_q(feat), self.linear_k(feat), self.linear_v(feat)

key = pointops.grouping(reference_index, key, coord, with_xyz=True)

value = pointops.grouping(reference_index, value, coord, with_xyz=False)

...

weight = self.weight_encoding(relation_qk)

weight = self.attn_drop(self.softmax(weight))

...

feat = torch.einsum("n s g i, n s g -> n g i", value, weight)

feat = einops.rearrange(feat, "n g i -> n (g i)")

return feat

代码讲解:

- 通过

linear_q、linear_k和linear_v,将输入的特征转换为查询query、键key和值value。 - 使用

pointops.grouping操作,从参考点(reference_index)处获取邻居点的键和值。 - 权重编码(

weight_encoding)对query和key的差值进行处理,生成加权的向量。注意力机制通过softmax对每组特征进行加权。 - 最终,使用

einsum操作将加权的特征按组相加,并通过rearrange将结果重整为标准的特征维度。

改进的位置信息编码(Position Encoding Multiplier)

核心思想:

- 点云数据的位置信息在建模几何关系中至关重要。与2D图像不同,3D点云中点的位置是不规则分布的。因此,Point Transformer V2 引入了位置信息乘子(Position Encoding Multiplier),以加强空间关系的建模能力。

- 位置信息乘子不仅将相对位置作为加性偏差,还可以作为乘性因子,增强位置对特征的影响。

对应代码:

if self.pe_multiplier:

pem = self.linear_p_multiplier(pos)

relation_qk = relation_qk * pem

if self.pe_bias:

peb = self.linear_p_bias(pos)

relation_qk = relation_qk + peb

value = value + peb

代码讲解:

linear_p_multiplier和linear_p_bias分别对位置编码进行乘法和加法操作。- 通过乘性位置信息(

pe_multiplier)直接影响query和key的关系,增强模型对复杂几何关系的感知能力。 - 加性位置信息(

pe_bias)通过加权偏差调整位置编码,并对值(value)进行类似处理,从而影响最终的注意力结果。

基于分区的池化方法(Partition-based Pooling)

核心思想:

- 在处理3D点云时,传统的池化方法如最远点采样(FPS)可能会导致不均匀的空间分布,增加计算开销。为了解决这一问题,Point Transformer V2 引入了基于分区的池化(Grid Pooling),通过将点云划分为不重叠的网格,并在网格内进行特征聚合。

- 这种方式保证了池化操作的空间对齐性,并且能够高效地处理大规模点云数据。

对应代码:

class GridPool(nn.Module):

def forward(self, points, start=None):

coord, feat, offset = points

cluster = voxel_grid(pos=coord - start[batch], size=self.grid_size, batch=batch, start=0)

...

coord = segment_csr(coord[sorted_cluster_indices], idx_ptr, reduce="mean")

feat = segment_csr(feat[sorted_cluster_indices], idx_ptr, reduce="max")

return [coord, feat, offset], cluster

代码讲解:

- 使用

voxel_grid函数将点云划分为固定大小的网格区域,并在这些区域内对点的坐标和特征进行聚合。 - 坐标通过

segment_csr函数按平均值进行聚合,特征则通过最大值池化进行聚合。这种方法保证了点云空间划分的一致性,同时保留了有效的特征信息。

编码器和解码器模块(Encoder and Decoder)

核心思想:

- **编码器(Encoder)**通过逐层下采样和注意力机制提取深层次的特征信息。

- **解码器(Decoder)**通过逐层上采样(结合跳跃连接)来恢复细节特征。这种U-Net风格的结构保证了信息的有效传递,并能够恢复点云的细节信息。

对应代码:

class Encoder(nn.Module):

def forward(self, points):

points, cluster = self.down(points)

return self.blocks(points), cluster

class Decoder(nn.Module):

def forward(self, points, skip_points, cluster):

points = self.up(points, skip_points, cluster)

return self.blocks(points)

代码讲解:

Encoder模块使用GridPool进行下采样,并通过多个Block提取特征。Decoder模块通过UnpoolWithSkip实现上采样,并与编码器的跳跃连接保持一致,以恢复更多细节特征。

模型的整体结构(PointTransformerV2)

核心思想:

- Point Transformer V2 模型遵循典型的编码器-解码器架构。输入的点云数据经过多个编码和解码层处理,最终生成分割或分类的输出结果。

- 该结构能够在多个任务中表现出色,尤其是3D点云的分割和分类任务。

对应代码:

class PointTransformerV2(nn.Module):

def forward(self, data_dict):

coord = data_dict["coord"]

feat = data_dict["feat"]

offset = data_dict["offset"].int()

points = [coord, feat, offset]

points = self.patch_embed(points)

...

for i in reversed(range(self.num_stages)):

skip_points, cluster = skips.pop(-1)

points = self.dec_stages[i](points, skip_points, cluster)

...

return seg_logits

代码讲解:

- 输入数据包括坐标、特征和偏移量,经过

patch_embed进行初始特征提取后,依次通过各层编码器提取深层次的特征信息。 - 在解码过程中,通过跳跃连接恢复各阶段的特征,最终输出分割结果(

seg_logits)。

如何改进PointNet++

通过结合Point Transformer V2的以下改进:

- 分组向量注意力机制增强局部特征提取。

- 改进的位置信息编码提高几何关系建模能力。

- 基于分区的池化提高采样效率和空间对齐。

引入分组向量注意力机制(Grouped Vector Attention, GVA)

改进思路:

PointNet++依赖于MLP层对局部区域进行特征学习,虽然其性能在很多任务中表现出色,但它在建模点之间的细粒度关系方面有限。通过引入Point Transformer V2中的分组向量注意力机制,可以让模型在每个局部区域中对每个点及其邻域的特征进行更细致的注意力计算,增强模型对局部几何结构的感知能力。

具体操作:

在PointNet++的局部特征提取阶段,将MLP层替换为分组向量注意力机制。每个局部区域的点云经过查询、键和值计算,并根据相对几何位置对邻域特征进行加权组合。这可以提高特征提取的灵活性和细节捕捉能力。

效果预期:

- 能够增强模型在处理复杂点云结构时的表现,尤其在具有丰富局部细节的3D场景中,如分割和细粒度分类任务。

改进的位置信息编码(Position Encoding Multiplier)

改进思路:

PointNet++没有显式地考虑点之间的几何关系,它主要依赖于点的相对位置(通过最远点采样和k近邻操作)。可以借鉴Point Transformer V2中的位置信息乘子(Position Encoding Multiplier),将点之间的相对位置信息更有效地融入特征学习过程中。

具体操作:

在PointNet++的特征学习层(如局部聚合操作中),引入位置信息乘子。除了原有的特征学习机制外,为每个点的特征计算添加一个基于几何相对位置的乘子。这可以更有效地捕捉点之间的空间结构信息。

效果预期:

- 改进几何结构建模能力,尤其是在处理稀疏、非规则分布的点云时,如大规模室内场景的分割任务。

基于分区的池化(Partition-based Pooling)

改进思路:

PointNet++依赖于最远点采样(FPS)和k近邻(kNN)来构建局部区域,这在某些情况下可能效率不高且空间分布不均匀。可以借鉴Point Transformer V2中的基于分区的池化方法,将点云划分为固定大小的网格区域,并在网格内执行特征聚合。

具体操作:

在PointNet++的特征采样阶段,替换最远点采样为基于网格的池化方法。通过将点云划分为固定的网格,并在网格内进行平均或最大池化来聚合点特征。这将使得特征的空间分布更加均匀,计算效率更高。

效果预期:

- 提升池化操作的效率,并确保在处理大规模点云时的空间对齐和特征一致性。