随着人工智能技术的飞速发展,生成式预训练Transformer(GPT)作为自然语言处理(NLP)领域的明星模型,正引领着AI应用的新潮流。

近日,AI大神何恺明带队的MIT、Meta FAIR团队,提出了异构预训练Transformer(HPT)模型,引起了广泛关注。所谓异构预训练Transformer(HPT)模型,即预训练一个大型、可共享的神经网络主干,就能学习与任务和机器人形态无关的共享表示。简单讲,只需在策略模型的核心位置嵌入一个灵活可扩展的Transformer,便无需从零开始繁琐的训练过程。

另外,在2023年备受瞩目的计算机视觉与模式识别大会(CVPR)上,一种名为“集成预训练金字塔结构的Transformer模型”的深度学习新模型横空出世,同样引发了业界的热烈反响。

各类预训练Transformer模型作为NLP领域的重要里程碑,正迅速成为学术研究与论文发表的热门话题。

为了方便大家能够更好的掌握这个创新思路,我为大家整理了最新的预训练Transformer模型研究论文!

需要的同学添加工中号【沃的顶会】 回复 trans创新 即可全部领取

异构预训练Transformer:

Scaling Proprioceptive-Visual Learning with Heterogeneous Pre-trained Transformers

文章解析

本文研究了通过异构预训练在不同机器人实体和任务上学习策略表示的问题。提出了Heterogeneous Pre-trained Transformers (HPT),通过预训练一个大型共享的策略神经网络主干,学习任务和实体无关的共享表示。

HPT将不同实体的具体本体感觉和视觉输入对齐到一个短的令牌序列,然后处理这些令牌以控制不同任务的机器人。通过利用大规模多实体真实世界机器人数据集、仿真、部署的机器人和人类视频数据集,研究了跨异构数据的预训练策略。实验结果表明,HPT在多个模拟器基准和实际场景中,比基线方法提升了超过20%的性能。

创新点

1.任务和实体无关的共享表示:通过预训练一个大型共享的策略神经网络主干,学习任务和实体无关的共享表示。

2.异构数据对齐:将不同实体的具体本体感觉和视觉输入对齐到一个共享的潜空间,使不同实体的数据能够联合训练。

3.模块化架构:通过模块化的设计,使得新的实体只需要少量数据和训练即可“翻译”其特定设置到共享“语言”。

需要的同学添加工中号【沃的顶会】 回复 trans创新 即可全部领取

集成预训练Transformer

Fast-iTPN: Integrally Pre-Trained Transformer Pyramid Network with Token Migration

文章解析

本文提出了一种集成预训练的变压器金字塔网络(iTPN),旨在联合优化网络骨干和颈部,以最小化表示模型和下游任务之间的迁移差距。

iTPN的核心设计包括:1)基于视觉变压器(ViT)的第一个预训练特征金字塔;2)使用掩码特征建模(MFM)对特征金字塔进行多阶段监督。

为了减少计算内存开销并加速推理,iTPN升级为Fast-iTPN,引入了两个灵活的设计:1)令牌迁移:从骨干中丢弃冗余令牌并在特征金字塔中补充这些令牌,无需自注意力操作;2)令牌聚集:引入聚集令牌以减少全局自注意力带来的计算成本。

实验结果表明,Fast-iTPN在ImageNet-1K上的top-1准确率分别达到88.75%和89.5%,在COCO目标检测任务上的box AP分别为58.4%和58.8%,在ADE20K语义分割任务上的mIoU分别为57.5%和58.7%。Fast-iTPN可以加速推理过程高达70%,且性能损失微乎其微,展示了其作为下游视觉任务强大骨干的潜力。

创新点

1.集成预训练的特征金字塔:首次在视觉变压器(ViT)上实现预训练的特征金字塔,解决了大多数预训练任务只影响骨干而不训练颈部的问题。

2.多阶段监督:使用掩码特征建模(MFM)对特征金字塔进行多阶段监督,提高了重建和识别的准确性。

3.灵活的设计:通过令牌迁移和令牌聚集,减少了计算成本,加速了推理过程。

需要的同学添加工中号【沃的顶会】 回复 trans创新 即可全部领取

无缝集成Transformer

UniFormer: Unified Transformer for Efficient Spatiotemporal Representation Learning

文章解析

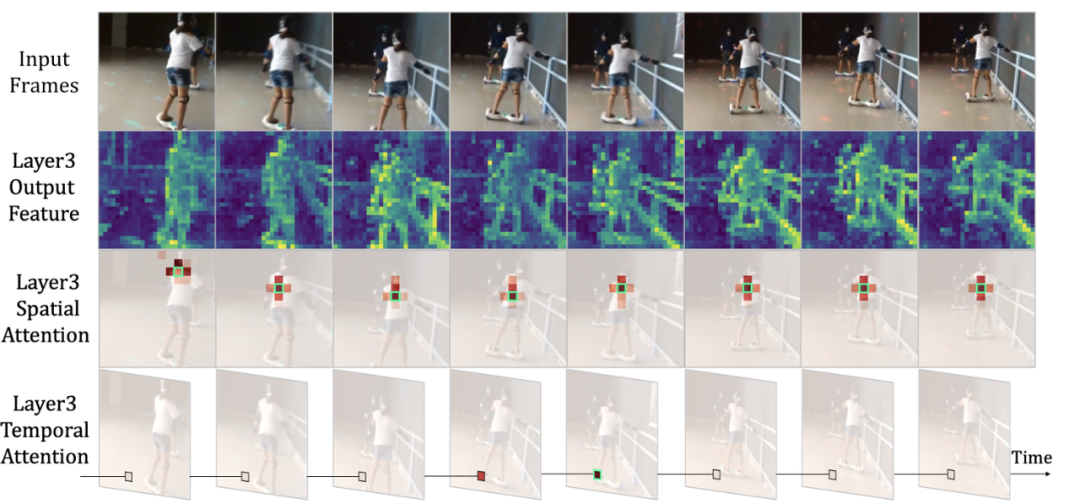

本文提出了一种新的统一变换器(UniFormer),旨在无缝集成3D卷积和时空自注意力的优点,以高效地学习视频中的丰富和多尺度时空语义。

3D卷积可以有效地聚合局部上下文以减少局部冗余,但受制于有限的感受野,难以捕捉全局依赖。相比之下,视觉变换器通过自注意力机制可以有效捕捉长程依赖,但在浅层中减少局部冗余时存在盲目的相似性比较问题。

UniFormer通过在浅层学习局部令牌亲和力,在深层学习全局令牌亲和力,实现了计算和准确性的平衡。

实验结果表明,UniFormer在Kinetics-400和Kinetics-600数据集上分别达到了82.9%和84.8%的top-1准确率,同时计算量仅为其他最先进方法的1/10。在Something-Something V1和V2数据集上,UniFormer分别达到了60.9%和71.2%的top-1准确率,刷新了这些数据集的最先进记录。

创新点

1.无缝集成3D卷积和时空自注意力:通过在浅层学习局部令牌亲和力,在深层学习全局令牌亲和力,有效解决时空冗余和依赖问题。

2.高效的计算性能:在保持高准确率的同时,计算量仅为其他最先进方法的1/10。

3.广泛的实验验证:在多个流行视频基准数据集上进行了广泛实验,验证了UniFormer的有效性和优越性。

需要的同学添加工中号【沃的顶会】 回复 trans创新 即可全部领取