In den letzten Tagen hat die Nachricht, dass OpenAI live übertragen wird, alle darüber spekuliert, ob GPT-5 bald veröffentlicht werden soll. Sam Altman musste die Gerüchte auf der X-Plattform widerlegen Noch nicht veröffentlicht. KI-Suchmaschine Auch dieses Mal nicht. Der Herausgeber war schon immer sehr neugierig: Warum schenken alle GPT-5 so viel Aufmerksamkeit? Ist das große Update von GPT-4 nicht immer noch in der Lage, den Bedürfnissen der breiten Masse gerecht zu werden? Bis ich diesen Artikel gelesen habe, wusste ich nicht, dass die Versionsunterschiede von GPT viel größer sind als die von Apple-Telefonen. Allein der Fortschritt von GPT-5 in der Videoverarbeitung lässt die Leute sich darauf freuen, ganz zu schweigen davon Verbesserung der allgemeinen künstlichen Intelligenz (AGI), es kann einige Fortschritte geben, nachdem ich es gelesen habe, freue ich mich auf GPT-5 ...

Zu lange zum Anschauen der Version:

- ChatGPT-Modelle wie GPT-3.5 und GPT-4 basieren auf der Transformer-Architektur und sind darauf abgestimmt, bestimmte Aufgaben wie Dialoge und Textvervollständigung gut zu erfüllen.

- GPT-4 stellt einen bedeutenden Fortschritt in den Fähigkeiten zur Verarbeitung natürlicher Sprache dar, mit multimodalen Fähigkeiten, verbesserten Argumentationsfähigkeiten und der Fähigkeit, längere Kontexte als frühere Generationen zu verarbeiten;

- GPT-4 Turbo ist eine optimierte Version von GPT-4, die speziell für Chat-basierte Anwendungen entwickelt wurde und eine höhere Kosteneffizienz und Effizienz bietet.

- GPT-5 wird voraussichtlich spannende Fortschritte in der Videoverarbeitung und der allgemeinen künstlichen Intelligenz (AGI) bringen;

- Während sich diese Modelle weiterentwickeln, werden Faktoren wie Verfügbarkeit und Kosten ihre breite Akzeptanz in allen Branchen bestimmen.

Verstehen Sie die Grundlagen des ChatGPT-Modells: Architektur und Training

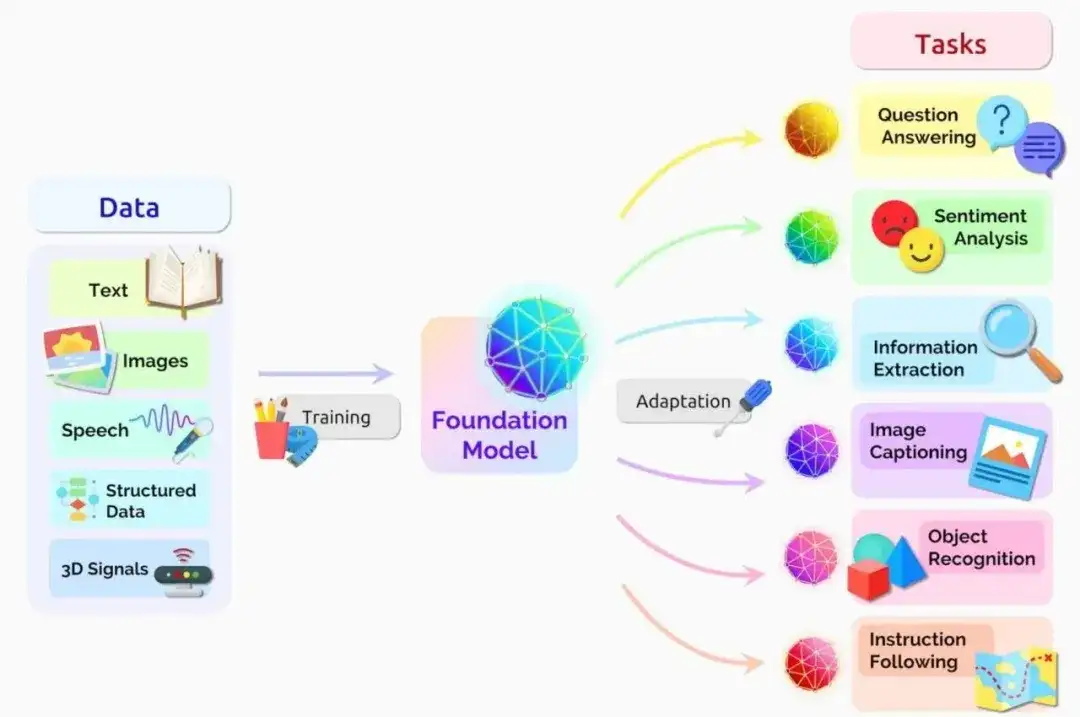

**Um die Fähigkeiten der verschiedenen ChatGPT-Modelle und ihre Unterschiede zu verstehen, ist es wichtig, zunächst die zugrunde liegende Architektur zu verstehen, die sie antreibt. Der Kern dieser Modelle basiert auf der GPT-Architektur (Generative Pre-trained Transformer), die den Bereich der Verarbeitung natürlicher Sprache revolutioniert hat. **Die GPT-Architektur ist vom Transformer-Modell abgeleitet, das in der bahnbrechenden Arbeit „Attention Is All You Need“ von Vaswani et al. eingeführt wurde. Das Transformer-Modell verzichtet auf traditionelle rekurrente neuronale Netze (RNNs) und übernimmt stattdessen einen Selbstaufmerksamkeitsmechanismus, der es dem Modell ermöglicht, die Bedeutung verschiedener Teile der Eingabesequenz bei der Ausgabegenerierung abzuwägen. Adresse des Papiers „Aufmerksamkeit ist alles, was Sie brauchen“: https://arxiv.org/abs/1706.03762 Detaillierte Einführung in rekurrente neuronale Netze (RNNs):

https://www.techopedia.com/definition/32834/recurrent-neural-network-rnn

Transformer-Modell, Quelle: NVIDIA

Der Selbstaufmerksamkeitsmechanismus ermöglicht es dem Modell, weitreichende Abhängigkeiten und Kontextinformationen effektiver zu erfassen als RNNs, die Schwierigkeiten haben, mit verschwindenden Gradienten und Speicherbeschränkungen umzugehen. Durch die Fokussierung auf relevante Teile der Eingabesequenz können Transformer-Modelle kohärentere, kontextbezogenere Ausgaben generieren.

**Ein weiterer wichtiger Aspekt der GPT-Architektur ist der Vortrainingsprozess. **GPT-Modelle werden zunächst auf große Mengen unbeschrifteter Textdaten wie Bücher, Artikel und Websites trainiert. Während dieser unbeaufsichtigten Vortrainingsphase lernt das Modell, das nächste Wort in der Sequenz basierend auf den vorherigen Wörtern vorherzusagen. Dadurch kann das Modell ein umfassendes Verständnis der Sprachstruktur, Syntax und Semantik entwickeln.

Das vorab trainierte GPT-Modell wurde jedoch nicht für bestimmte Aufgaben wie Dialoge oder Textvervollständigung optimiert. Um das Modell an diese Zwecke anzupassen, wird ein Feinabstimmungsprozess eingesetzt. Bei der Feinabstimmung wird ein vorab trainiertes Modell mithilfe eines kleinen, für die Zielaufgabe spezifischen Datensatzes neu trainiert, beispielsweise den Konversationsdaten von ChatGPT.

Bei der Feinabstimmung werden die Parameter des Modells angepasst, um den Fehler im Datensatz für die spezifische Aufgabe zu minimieren. Dieser Prozess ermöglicht es dem Modell, Nuancen und Muster zu lernen, die für die Zielaufgabe einzigartig sind, was zu einer verbesserten Leistung und menschenähnlicheren Interaktionen führt.

„Die Kombination aus Transformer-Architektur, Selbstaufmerksamkeitsmechanismus, Vortraining und Feinabstimmungsprozessen ermöglicht es dem GPT-Modell, hochwertige, kontextsensitive Textausgaben zu generieren.“

Diese architektonischen Entscheidungen bilden die Grundlage der ChatGPT-Modelle und ermöglichen es ihnen, natürliche Gespräche zu führen, Fragen zu beantworten und bei einer Vielzahl sprachbezogener Aufgaben zu helfen.

Wenn wir in den folgenden Kapiteln spezifische ChatGPT-Modelle diskutieren, denken Sie bitte daran, dass sie alle diese gemeinsame Architektur haben und die Unterschiede sich hauptsächlich in Faktoren wie Modellgröße, Trainingsdaten und Feinabstimmungsstrategien widerspiegeln.

GPT-3.5: Die Basis von ChatGPT

GPT-3.5, 2020 von OpenAI veröffentlicht, ist das zugrunde liegende Sprachmodell, das auf dem ursprünglichen ChatGPT aufbaut. Als Mitglied der GPT-Modellfamilie zeigt GPT-3.5 erhebliche Fortschritte bei der Verarbeitung und Erzeugung natürlicher Sprache.

Hauptmerkmale von GPT-3.5

- Verbessertes Sprachverständnis: Im Vergleich zu seinen Vorgängern zeigt GPT-3.5 ein tieferes Verständnis von Kontext, Nuancen und Semantik;

- Erhöhte Modellgröße: Mit 175 Milliarden Parametern ist GPT-3.5 eines der größten derzeit verfügbaren Sprachmodelle, das in der Lage ist, komplexere Muster zu erfassen und kohärenteren Text zu erzeugen;

- Verbesserungen bei der Textgenerierung: GPT-3.5 kann menschenähnlichen Text in mehreren Bereichen generieren, vom kreativen Schreiben bis zur technischen Dokumentation.

Die Abhängigkeit von ChatGPT von GPT-3.5

Das Grundmodell von ChatGPT basiert auf der GPT-3.5-Architektur. Durch die Feinabstimmung von GPT-3.5 mit Multi-Domain-Konversationsdaten hat ChatGPT die Möglichkeit entwickelt, natürliche, kontextbewusste Konversationen mit Benutzern zu führen.

Der Erfolg von ChatGPT lässt sich auf die Stärken des zugrunde liegenden GPT-3.5-Modells zurückführen, darunter Kontextverständnis, umfassende Wissensbasis und Anpassungsfähigkeit. GPT-3.5 ermöglicht es ChatGPT, während der gesamten Konversation Kohärenz und Relevanz aufrechtzuerhalten, indem es den Kontext der Konversation versteht. Umfangreiche Vorschulungen zu GPT-3.5 ermöglichen es ChatGPT, auf eine riesige Wissensdatenbank zu verweisen, die eine Vielzahl von Themen und Bereichen abdeckt.

Darüber hinaus trägt die Architektur von GPT-3.5 dazu bei, dass ChatGPT sich an verschiedene Konversationsstile und Benutzerpräferenzen anpassen kann.

Einschränkungen und Mängel von GPT-3.5

Trotz seiner Leistungsfähigkeit ist GPT-3.5 nicht ohne Einschränkungen. Zu den Hauptnachteilen zählen:

- Mangelnde Argumentationsfähigkeiten: Obwohl GPT-3.5 in der Lage ist, kohärenten und kontextbezogenen Text zu generieren, schneidet es bei Aufgaben, die logisches Denken oder Problemlösung erfordern, nicht gut ab;

- Verzerrung und Inkonsistenz: GPT-3.5 kann in seinen Trainingsdaten Verzerrungen aufweisen und manchmal inkonsistente oder widersprüchliche Antworten hervorrufen;

- Eingeschränktes Kontextfenster: GPT-3.5 hat eine maximale Eingabegröße von 2.048 Token (~1.500 Wörter), was seine Fähigkeit, längere Inhalte zu verarbeiten oder den Kontext in längeren Konversationen aufrechtzuerhalten, möglicherweise einschränkt.

Das Verständnis der Stärken und Grenzen von GPT-3.5 ist entscheidend, um realistische Erwartungen bei der Interaktion mit ChatGPT und anderen generativen KI-Anwendungen, die auf diesem Modell basieren, zu setzen. Obwohl GPT-3.5 den Bereich der Konversations-KI erheblich voranbringt, gibt es in Bereichen wie Argumentation, Voreingenommenheitsminderung und Kontextverarbeitung noch Raum für Verbesserungen.

GPT-4: Ein riesiger Fortschritt in der Verarbeitung natürlicher Sprache

GPT-4 markiert einen wichtigen Fortschritt bei der Verarbeitung natürlicher Sprache. GPT-4, das 2023 von OpenAI veröffentlicht wurde, führt neue Funktionen und Verbesserungen ein, indem es die Vorteile der vorherigen Generation übernimmt.

Hauptmerkmale von GPT-4

- Multimodale Fähigkeiten: Eine der bedeutendsten Verbesserungen von GPT-4 ist seine Fähigkeit, Inhalte über mehrere Modalitäten hinweg zu verarbeiten und zu generieren. Zusätzlich zur Textverarbeitung kann GPT-4 Bilder analysieren und beschreiben und so die Tür zu einer Vielzahl neuer Anwendungen und Nutzungsszenarien öffnen;

- Erweitertes Kontextfenster: Im Vergleich zu GPT-3.5 verfügt GPT-4 über ein deutlich größeres Kontextfenster. GPT-4 kann bis zu 25.000 Token (ca. 17.000 Wörter) verarbeiten, längere Inhalte verarbeiten und die kontextbezogene Kohärenz bei langen Gesprächen oder Dokumenten aufrechterhalten;

- Verbesserte Denkfähigkeiten: GPT-4 verfügt über verbesserte Denkfähigkeiten, sodass es bei Aufgaben, die logisches Denken, Problemlösung und Analyse erfordern, eine bessere Leistung erbringt. Dieser Fortschritt eröffnet neue Möglichkeiten für die Anwendung von GPT-4 in der wissenschaftlichen Forschung, Datenanalyse und Entscheidungsunterstützung und anderen Bereichen.

Die Auswirkungen von GPT-4 auf ChatGPT

Die Einführung von GPT-4 hatte erhebliche Auswirkungen auf ChatGPT und den gesamten Bereich der Konversations-KI.

Durch die Nutzung der Funktionen von GPT-4 kann ChatGPT komplexere und kontextsensitivere Gespräche führen und Benutzern genauere und relevantere Antworten liefern.

Darüber hinaus erleichtern die multimodalen Fähigkeiten von GPT-4 die Entwicklung neuer Anwendungen, die Sprachverständnis und visuelle Wahrnehmung kombinieren. Dies eröffnet weitere spannende Möglichkeiten bei der Bildunterschrift, der visuellen Beantwortung von Fragen und der multimodalen Inhaltserstellung.

Auseinandersetzung mit Einschränkungen und ethischen Überlegungen

Obwohl GPT-4 große Fortschritte bringt, ist es wichtig zu erkennen, dass es kein Allheilmittel für alle Einschränkungen und Herausforderungen von Sprachmodellen ist. Forscher und Entwickler kämpfen weiterhin mit Problemen wie Voreingenommenheit, Inkonsistenz und potenziellem Missbrauch. OpenAI unterstrich sein Engagement für eine verantwortungsvolle KI-Entwicklung durch die folgenden Schritte:

- Verbesserter Schutz vor schädlichen oder irreführenden Inhalten

- Arbeiten Sie mit Forschern und Ethikern zusammen, um potenzielle Risiken zu identifizieren und zu mindern

- Offenlegen Sie transparent die Fähigkeiten und Einschränkungen von GPT-4

Detaillierter Vergleich zwischen GPT-3.5 und GPT-4

|. GPT-3.5 |. Sprachverständnis |. Fähigkeit, logisch zu denken, Probleme zu lösen | ) |. Textgenerierung über mehrere Domänen hinweg |. Maximale Eingabe von 2.048 Token |. um mit längeren Inhalten umzugehen |. Mangelnde Denkfähigkeit |

GPT-4 Turbo: Optimiert für Chat-Anwendungen

GPT-4 Turbo ist eine Variante des GPT-4-Modells, die speziell auf die besonderen Anforderungen von Chat-Anwendungen zugeschnitten ist. Dieses Modell kombiniert die erweiterten Funktionen von GPT-4 und ist optimiert, um seine Leistung und Effizienz in Gesprächsumgebungen zu verbessern.

Hauptmerkmale von GPT-4 Turbo

- Maßgeschneidert für Chat: GPT-4 Turbo ist mit einer großen Menge an Gesprächsdaten fein abgestimmt, um natürlichere und kohärentere Antworten bei chatbasierten Interaktionen zu generieren;

- Verbesserte Effizienz: Durch die Optimierung der Architektur und des Trainingsprozesses bietet GPT-4 Turbo eine schnellere Reaktionszeit und geringere Rechenkosten als das Standard-GPT-4-Modell;

- Verbessertes Kontextmanagement: GPT-4 Turbo wurde entwickelt, um die Dynamik von Gesprächen effizienter zu bewältigen und den Kontext und die Kohärenz über mehrere Gesprächsrunden hinweg aufrechtzuerhalten.

Vorteile von GPT-4 Turbo in ChatGPT

Die Professionalität von GPT-4 Turbo bringt viele Vorteile für Chat-Anwendungen:

- Kosteneffizienz: Durch die Reduzierung des Rechenbedarfs ermöglicht GPT-4 Turbo Entwicklern, Chat-Anwendungen zu geringeren Kosten zu erstellen, zu betreiben und zu skalieren;

- Verbesserte Benutzererfahrung: Mit schnelleren Reaktionszeiten und kontextbezogenerer Ausgabe verbessert GPT-4 Turbo die gesamte Benutzererfahrung chatbasierter Interaktionen;

- Skalierbarkeit: Die Optimierungen von GPT-4 Turbo machen es ideal für die Abwicklung von Gesprächen mit hoher Parallelität und ermöglichen eine nahtlose Skalierung von Chat-Anwendungen.

Wie leistungsfähig wird GPT-5 sein?

OpenAI hat bestätigt, dass es aktiv an GPT-5 arbeitet, und obwohl spezifische Details zu GPT-5 noch begrenzt sind, deuten erste Anzeichen darauf hin, dass es erhebliche Verbesserungen und neue Funktionen mit sich bringen wird.

Mögliche funktionale Verbesserungen an GPT-5:

- Weitere Erweiterung des Kontextfensters, um das Verständnis und die Generierung längerer Inhalte zu unterstützen

- Erweiterte Multi-Turn-Dialogverarbeitungsfunktionen für natürlichere und flüssigere Dialoge

- Verbessern Sie die Denk- und Problemlösungsfähigkeiten und erweitern Sie die Fähigkeiten von Sprachmodellen

Darüber hinaus gibt es Gerüchte, dass GPT-5 Videoverarbeitungsfunktionen einführen und seine Multimedia-Verarbeitungsfunktionen von Text und Bildern auf Videos erweitern könnte. Dies könnte neue Grenzen in der Videoanalyse, -generierung und -interaktion eröffnen. Die rasante Entwicklung von Sprachmodellen wie ChatGPT hat die Diskussionen über die Möglichkeit, künstliche allgemeine Intelligenz (AGI) zu erreichen, neu entfacht – eine hypothetische Fähigkeit von KI-Systemen, jede wissensbasierte Aufgabe zu verstehen und zu lernen, die ein Mensch ausführen kann.

FAQ

F: Welches ChatGPT-Modell sollte ich verwenden?

A: Die Wahl des ChatGPT-Modells sollte auf Ihren spezifischen Bedürfnissen, Ihrem Budget und Ihren technischen Möglichkeiten basieren. GPT-3.5 eignet sich für allgemeine Szenarien, während GPT-4 erweiterte Funktionen und multimodale Unterstützung bietet. GPT-4 Turbo ist für Chat-Anwendungen optimiert und sorgt für ein ausgewogenes Verhältnis von Leistung und Effizienz.

F: Welches Modell verwendet ChatGPT-4?

A: ChatGPT-4 basiert auf dem GPT-4-Sprachmodell, dem fortschrittlichsten Modell der von OpenAI entwickelten GPT-Serie. Im Vergleich zu seinem Vorgänger GPT-3.5 weist GPT-4 erhebliche Verbesserungen bei multimodalen Fähigkeiten, verbessertem Denken und größeren Kontextfenstern auf.

F: Kommt GPT-5 bald?

A: Ja, OpenAI hat bestätigt, dass es GPT-5 als Nachfolger des GPT-4-Modells aktiv entwickelt. Obwohl spezifische Details begrenzt sind, wird erwartet, dass GPT-5 weitere Fortschritte beim Kontextverständnis, bei den Konversationsfähigkeiten und möglicherweise sogar bei der Videoverarbeitung bringen wird.

F: Welches GPT-Modell ist das beste?

A: Das hängt von Ihrem Anwendungsszenario und Ihren Bedürfnissen ab. Derzeit bietet GPT-4 die fortschrittlichsten Funktionen, während GPT-3.5 eine günstigere Wahl für allgemeine und Chat-Anwendungsszenarien ist.

Wenn ein Verstoß vorliegt, kontaktieren Sie uns bitte, um ihn zu löschen. Referenzlink: https://www.techopedia.com/chatgpt-models-guide

Folgen Sie uns

„Trusted AI Progress“ Der offizielle Account widmet sich der Verbreitung der neuesten vertrauenswürdigen künstlichen Intelligenztechnologie und der Kultivierung von Open-Source-Technologie und deckt groß angelegtes Graphenlernen, kausales Denken, Wissensgraphen, große Modelle und andere technische Bereiche ab Scannen Sie den QR-Code, um weitere KI-Informationen zu verfolgen und freizuschalten