Implémentation de Python [crawler de démarrage rapide d'une heure] analyse de texte + rotation de pages

Étudier à [Jianshu]: https://www.jianshu.com/p/9c266216957b

import requests

from bs4 import BeautifulSoup # 引入Beautiful Soup包

#----提前应该安装包:requests、bs4、lxml、

#【安装方法】:PyCharm中下方的Teminal中输入:pip install ****(星号为包名)

#----pip安装包显示网络差,等待时间长可将pip install ****

# 改为pip install -i https://pypi.tuna.tsinghua.edu.cn/simple ****

# headers就是告诉网站,我们是一个正常的浏览器在给它发送信息,请它给我们正确的信息。

headers = {'User-Agent': 'Mozilla/5.0 (Macintosh; Intel Mac OS X 10_12_3) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/56.0.2924.87 Safari/537.36'}

#设定网页不变的部分,每次只需要在这个上面加数字就行

base_url = 'https://www.qiushibaike.com/text/paga/'

#设置循环,让num分别等于1-5,爬取1-5页糗事百科段子

for num in range(1,5):

print('第{}页'.format(num))

# get中网址为需要爬取的网址,选择的是不需要登录的网址

r = requests.get( base_url + str(num), headers = headers)

#在r里面获取的很多内容中,我们所需要的是text数据,将其保存在content变量中并打印

content = r.text

#print(content)

#把刚刚保存在content中的text数据放入Beautiful Soup中

# 【lxml】因为content是一个字符串(string)数据,它并不是网页文件。

# 所以这里告诉Beautiful soup说你就把他当一个网页文件lxml来处理就行。

soup = BeautifulSoup(content, 'lxml')

#接下来就是施展Beautiful soup的魔法,把网页分成一块块的内容了。

#在网页界面按F12,

# 1将鼠标移到对应的代码标签(HTML tag)上,chrome就会把标签里面包含的网页内容高亮出来。

# 2或者对想要爬取的数据右键选[inspect/审查元素]找到对应的标签

#总之需要找到对应的标签和所属的最大上级标签。。

#发现网页内容每条笑话(糗事百科)上面都属于div class="article block untagged mb15 typs_hot"

# 或div class="article block untagged mb15 typs_long"

# 我们首先分解出所有class为article block untagged mb15 typs_hot标签(此标签比另一个文本多);

# 注意加'_'

divs = soup.find_all(class_="article block untagged mb15 typs_hot")

# print(divs)

# div是变量,依次表示divs中每一条刚刚筛选(class_=。。。)的信息。

# class_='thumb'是图片的标签如果发现此条信息有图片,则跳到下一条

# 由于内容是在标签中的span,所以需要将数据中的span取出

for div in divs:

if div.find_all(class_="thumb"):

continue

joke = div.span.get_text()

print(joke)

print('------------------------')

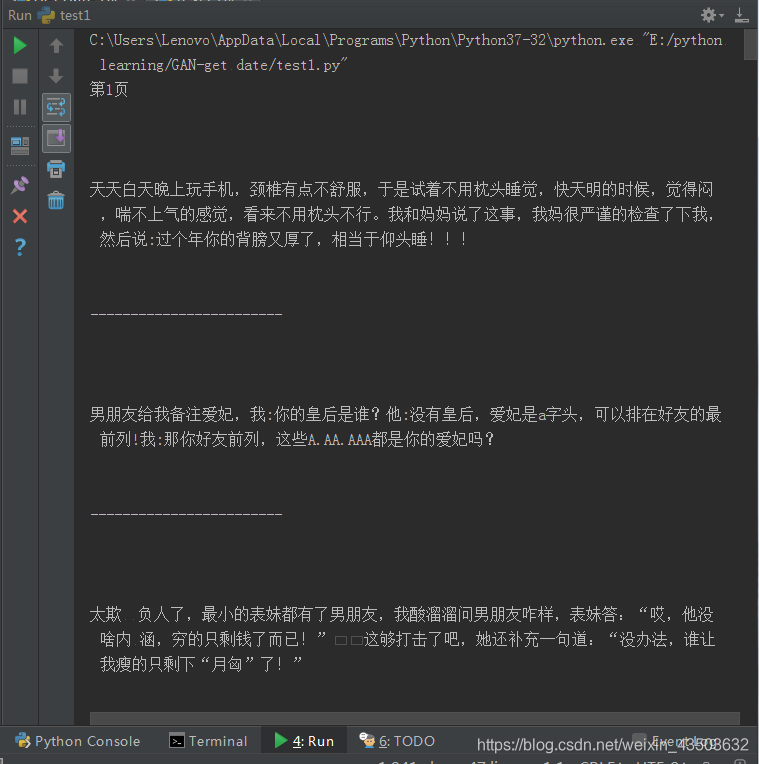

Le résultat final de l'exploration: la

première fois que j'ai appris l'exploration, il n'a pas été difficile de démarrer grâce aux conseils du grand frère, puis j'ai rencontré des problèmes et je les ai résolus un par un! Allez!