Source de l'article | Équipe de création intelligente ByteDance

Nous sommes ravis de partager avec vous notre dernier modèle de graphique vincentien, SDXL-Lightning, qui atteint une vitesse et une qualité sans précédent et est désormais disponible pour la communauté.

Modèle : https://huggingface.co/ByteDance/SDXL-Lightning

Article : https://arxiv.org/abs/2402.13929

Génération d'images ultra-rapide

L'IA générative attire l'attention du monde entier pour sa capacité à créer des images époustouflantes et même des vidéos basées sur des invites textuelles. Cependant, les modèles génératifs de pointe actuels reposent sur la diffusion, un processus itératif qui transforme progressivement le bruit en échantillons d’images. Ce processus nécessite d'énormes ressources informatiques et est lent. Lors du processus de génération d'échantillons d'images de haute qualité, le temps de traitement d'une seule image est d'environ 5 secondes, ce qui nécessite généralement plusieurs appels (20 à 40 fois) à un énorme réseau neuronal. . Cette vitesse limite les scénarios d’application qui nécessitent une génération rapide en temps réel. Comment accélérer la génération tout en améliorant la qualité est un domaine brûlant de la recherche actuelle et l'objectif principal de notre travail.

SDXL-Lightning franchit cette barrière grâce à une technologie innovante – Progressive Adversarial Distillation – pour atteindre des vitesses de génération sans précédent. Le modèle est capable de générer des images de très haute qualité et résolution en seulement 2 ou 4 étapes, réduisant ainsi le coût et le temps de calcul d'un facteur dix. Notre méthode peut même générer des images en une seule étape pour les applications sensibles au délai d'attente, même si une certaine qualité peut être légèrement sacrifiée.

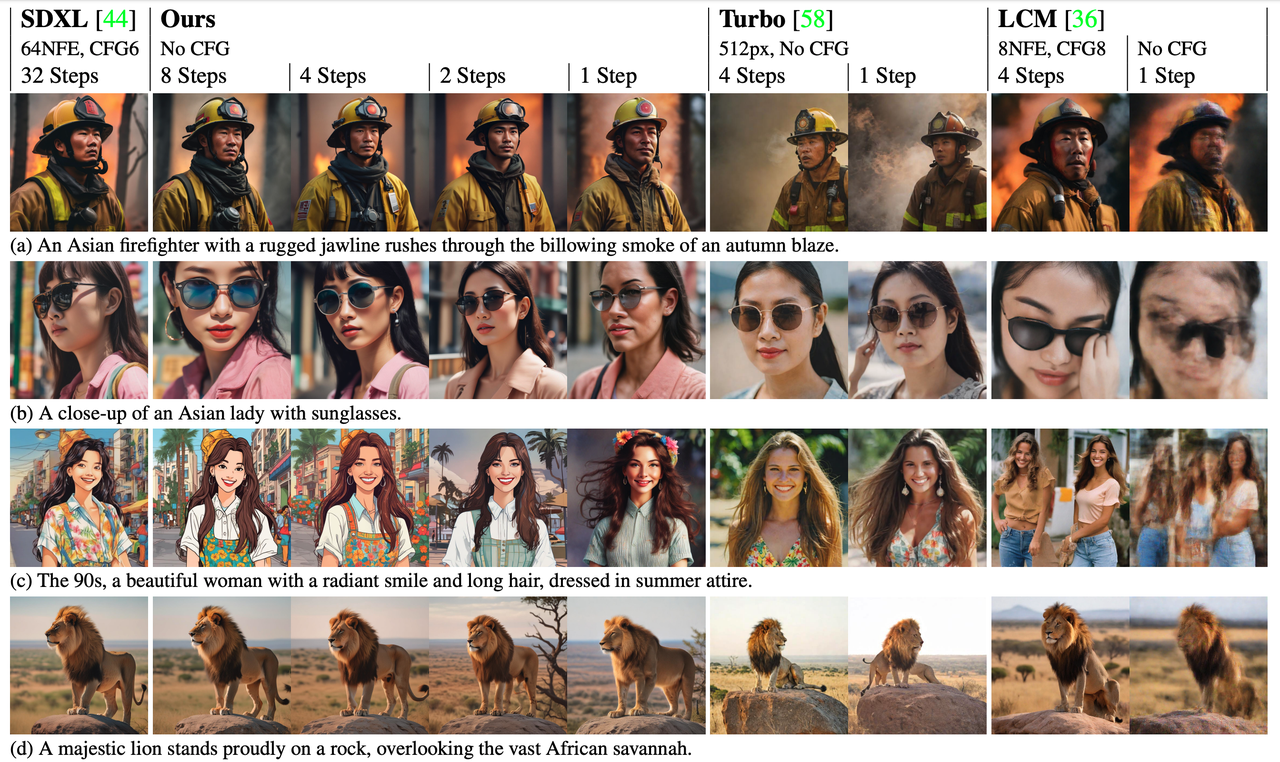

En plus de son avantage en termes de vitesse, SDXL-Lightning offre également des performances significatives en matière de qualité d'image et surpasse les technologies d'accélération précédentes lors des évaluations. Obtenez une résolution plus élevée et de meilleurs détails tout en conservant une bonne diversité et une bonne correspondance image-texte.

comparaison de vitesse

comparaison de vitesse

Modèle original (20 étapes), notre modèle (2 étapes)

Effet de modèle

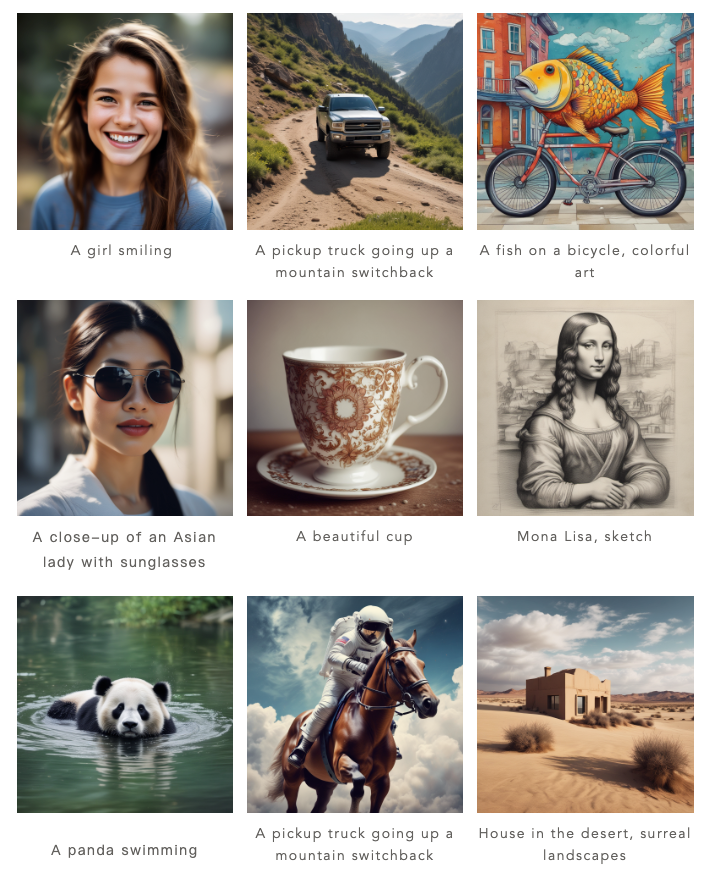

Notre modèle peut générer des images en 1 étape, 2 étapes, 4 étapes et 8 étapes. Plus il y a d’étapes d’inférence, meilleure est la qualité de l’image.

Voici les résultats de notre processus en 4 étapes :

Voici les résultats de notre construction en 2 étapes :

Par rapport aux méthodes précédentes (Turbo et LCM), notre méthode génère des images considérablement améliorées en termes de détails et plus fidèles au style et à la disposition du modèle génératif d'origine.

Redonner à la communauté, modèle ouvert

La vague de l’open source est devenue une force clé dans la promotion du développement rapide de l’intelligence artificielle, et ByteDance est fier de faire partie de cette vague. Notre modèle est basé sur SDXL, actuellement le modèle ouvert le plus populaire pour la génération d'images de texte, qui dispose déjà d'un écosystème florissant. Nous avons désormais décidé d'ouvrir SDXL-Lightning aux développeurs, chercheurs et créateurs du monde entier afin qu'ils puissent accéder à ce modèle et l'appliquer afin de promouvoir davantage l'innovation et la collaboration dans l'ensemble du secteur.

Lors de la conception de SDXL-Lightning, nous avons pris en compte la compatibilité avec la communauté des modèles ouverts. De nombreux artistes et développeurs de la communauté ont créé une variété de modèles de génération d'images stylisées, tels que les styles de dessins animés et d'anime. Afin de prendre en charge ces modèles, nous fournissons SDXL-Lightning en tant que plug-in d'accélération, qui peut être intégré de manière transparente dans ces différents styles de modèles SDXL afin d'accélérer la génération d'images pour différents modèles.

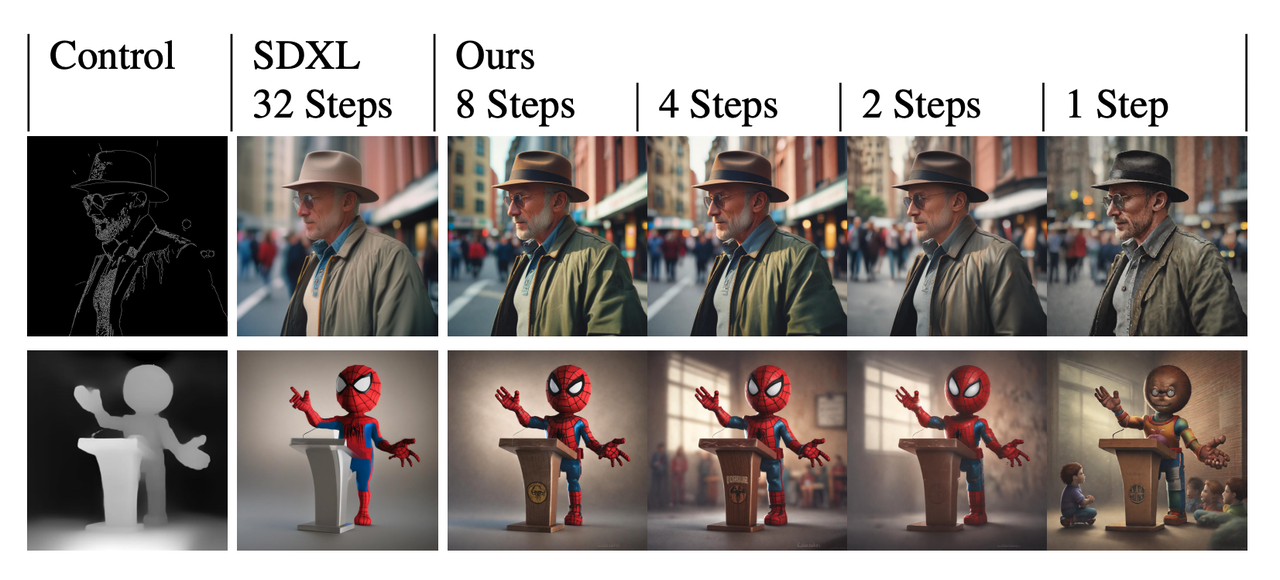

Notre modèle peut également être combiné avec le plug-in de contrôle actuellement très populaire ControlNet pour obtenir une génération d'images extrêmement rapide et contrôlable.

Notre modèle peut également être combiné avec le plug-in de contrôle actuellement très populaire ControlNet pour obtenir une génération d'images extrêmement rapide et contrôlable.

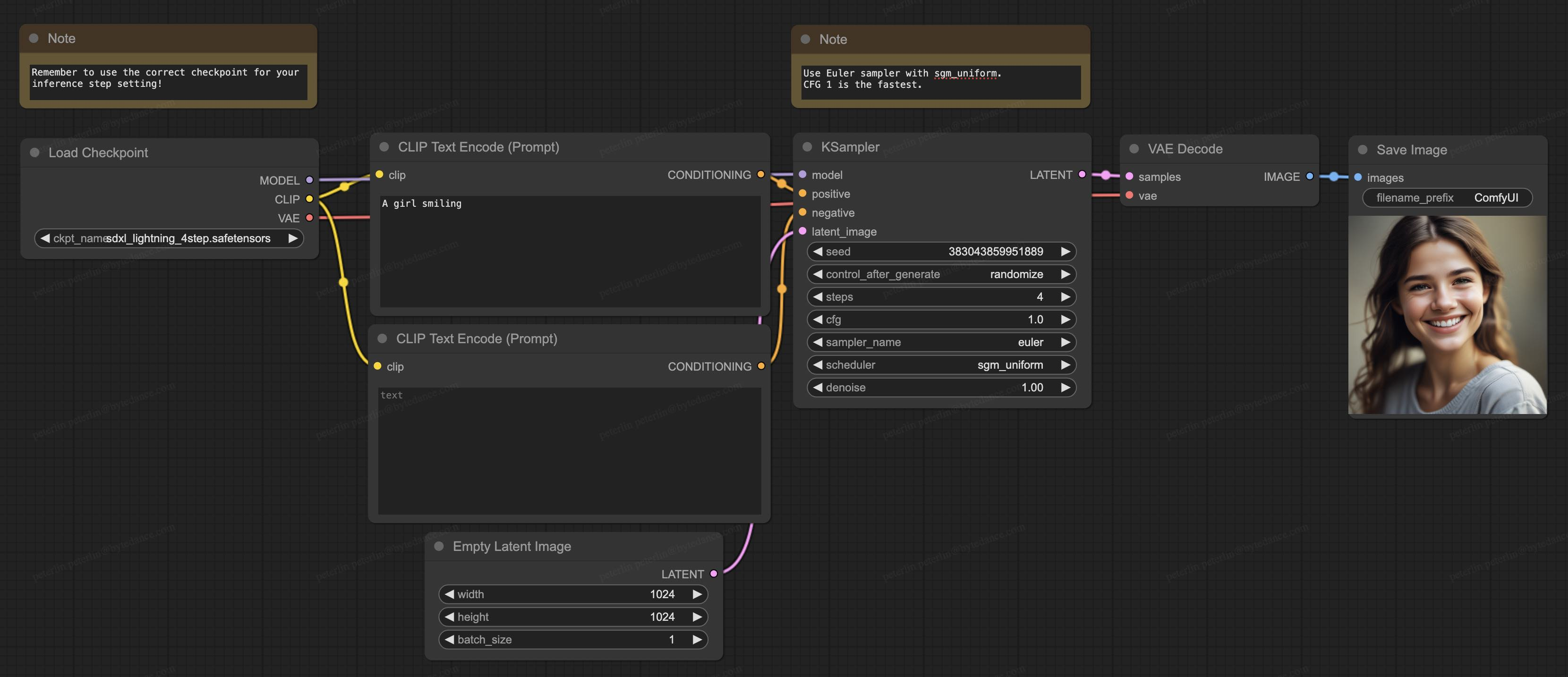

Notre modèle prend également en charge ComfyUI, actuellement le logiciel de génération le plus populaire dans la communauté open source, et le modèle peut être chargé directement pour être utilisé :

Notre modèle prend également en charge ComfyUI, actuellement le logiciel de génération le plus populaire dans la communauté open source, et le modèle peut être chargé directement pour être utilisé :

À propos des détails techniques

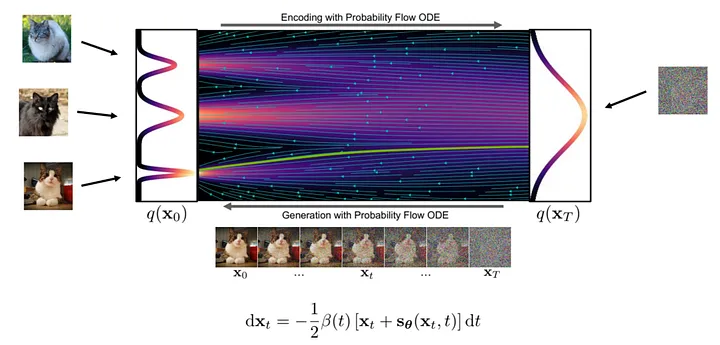

Théoriquement, la génération d’images est un processus de transformation étape par étape du bruit vers des images claires. Au cours de ce processus, le réseau neuronal apprend les gradients à différentes positions du flux de transformation.

Les étapes spécifiques pour générer une image sont les suivantes : Tout d’abord, nous échantillonnons de manière aléatoire un échantillon de bruit au point de départ du flux, puis utilisons un réseau neuronal pour calculer le gradient. En fonction du gradient à la position actuelle, nous apportons de petits ajustements à l'échantillon, puis répétons le processus. À chaque itération, les échantillons se rapprochent de la distribution finale de l’image jusqu’à obtenir une image claire.

Figure : Processus de génération ( image de : https://arxiv.org/abs/2011.13456 )

Figure : Processus de génération ( image de : https://arxiv.org/abs/2011.13456 )

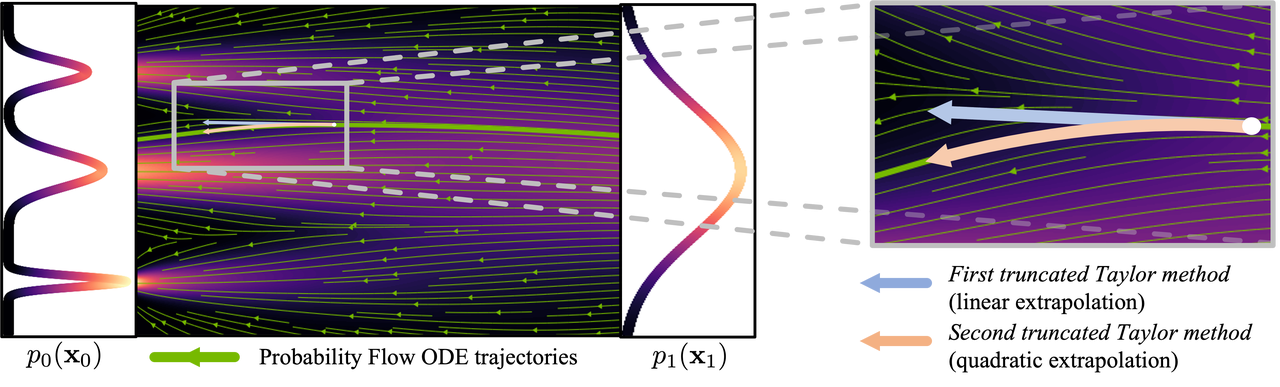

Étant donné que le flux de génération est complexe et non linéaire, le processus de génération ne doit franchir qu'une petite étape à la fois pour réduire l'accumulation d'erreurs de gradient. Des calculs fréquents du réseau neuronal sont donc nécessaires, c'est pourquoi la quantité de calcul est importante.

Figure : Processus de courbe ( image de : https://arxiv.org/abs/2210.05475 )

Figure : Processus de courbe ( image de : https://arxiv.org/abs/2210.05475 )

Afin de réduire le nombre d’étapes nécessaires à la génération d’images, de nombreuses recherches ont été consacrées à la recherche de solutions. Certaines études proposent des méthodes d'échantillonnage qui réduisent les erreurs, tandis que d'autres tentent de rendre plus linéaire le flux généré. Malgré les progrès de ces méthodes, elles nécessitent encore plus de 10 étapes d’inférence pour générer des images.

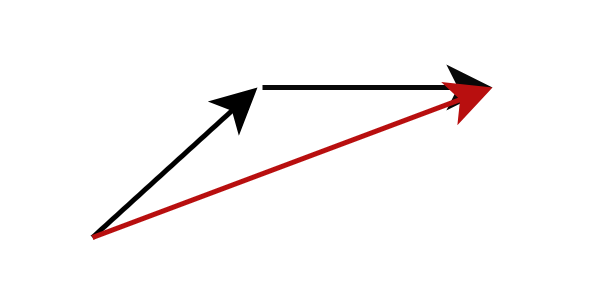

Une autre méthode est la distillation modèle, capable de générer des images de haute qualité en moins de 10 étapes d’inférence. Au lieu de calculer le gradient à la position d'écoulement actuelle, la distillation du modèle modifie la cible de la prédiction du modèle pour prédire directement la position d'écoulement la plus éloignée suivante. Plus précisément, nous formons un réseau d'étudiants à prédire directement le résultat du réseau d'enseignants après avoir effectué un raisonnement en plusieurs étapes. Une telle stratégie peut réduire considérablement le nombre d’étapes d’inférence requises. En appliquant ce processus à plusieurs reprises, nous pouvons réduire davantage le nombre d’étapes d’inférence. Cette approche a été appelée distillation progressive par des recherches antérieures.

Figure : Distillation progressive , le réseau d'étudiants prédit le résultat du réseau d'enseignants après plusieurs étapes

Figure : Distillation progressive , le réseau d'étudiants prédit le résultat du réseau d'enseignants après plusieurs étapes

En pratique, les réseaux d’étudiants ont souvent du mal à prédire avec précision les futures positions des flux. L'erreur s'amplifie à mesure que chaque étape s'accumule, ce qui fait que les images produites par le modèle commencent à devenir floues avec moins de 8 étapes d'inférence.

Pour résoudre ce problème, notre stratégie n'est pas de forcer le réseau d'étudiants à correspondre exactement aux prédictions du réseau d'enseignants, mais de rendre le réseau d'étudiants cohérent avec le réseau d'enseignants en termes de distribution de probabilité. En d’autres termes, le réseau étudiant est entraîné à prédire une localisation probable, et même si cette localisation n’est pas tout à fait exacte, nous ne la pénalisons pas. Cet objectif est atteint grâce à la formation contradictoire, qui introduit un réseau discriminant supplémentaire pour aider à réaliser une correspondance de distribution des résultats du réseau d'étudiants et d'enseignants.

Ceci est un bref aperçu de nos méthodes de recherche. Dans notre article technique ( https://arxiv.org/abs/2402.13929 ), nous fournissons une analyse théorique plus approfondie, une stratégie de formation et des détails de formulation spécifiques du modèle.

Au-delà de SDXL-Lightning

Bien que cette étude explore principalement comment utiliser la technologie SDXL-Lightning pour la génération d’images, le potentiel d’application de notre méthode de distillation contradictoire progressive proposée ne se limite pas aux images statiques. Cette technologie innovante peut également être utilisée pour générer rapidement et avec une haute qualité du contenu vidéo, audio et autre contenu multimodal. Nous vous invitons sincèrement à découvrir SDXL-Lightning sur la plateforme HuggingFace et attendons avec impatience vos précieux commentaires et retours.

Modèle : https://huggingface.co/ByteDance/SDXL-Lightning

Article : https://arxiv.org/abs/2402.13929

Un camarade de poulet "open source" deepin-IDE et a finalement réalisé l'amorçage ! Bon gars, Tencent a vraiment transformé Switch en une « machine d'apprentissage pensante » Examen des échecs de Tencent Cloud le 8 avril et explication de la situation Reconstruction du démarrage du bureau à distance RustDesk Client Web La base de données de terminal open source de WeChat basée sur SQLite WCDB a inauguré une mise à niveau majeure Liste d'avril TIOBE : PHP est tombé à un plus bas historique, Fabrice Bellard, le père de FFmpeg, a sorti l'outil de compression audio TSAC , Google a sorti un gros modèle de code, CodeGemma , est-ce que ça va vous tuer ? C'est tellement bon qu'il est open source - outil d'édition d'images et d'affiches open source