Note de l'éditeur : Actuellement, les grands modèles de langage sont devenus un sujet brûlant dans le domaine du traitement du langage naturel. Les LLM sont-ils vraiment « intelligents » ? Quelles inspirations nous ont-ils apportées ? En réponse à ces questions, Darveen Vijayan nous propose cet article qui suscite la réflexion.

L'auteur explique principalement deux points : Premièrement, les LLM doivent être considérés comme un calculateur de mots, qui fonctionne en prédisant le mot suivant, et ne doivent pas être classés comme « intelligents » à ce stade. Deuxièmement, malgré leurs limites actuelles, les LLM nous offrent l’occasion de réfléchir à la nature de l’intelligence humaine. Nous devons garder l'esprit ouvert, rechercher constamment de nouvelles connaissances et de nouvelles compréhensions des connaissances, et communiquer activement avec les autres pour repousser nos limites cognitives.

La question de savoir si les LLM sont intelligents ou non est probablement encore controversée. Mais une chose est sûre, ils ont apporté de l’innovation dans le domaine du traitement du langage naturel et ont fourni de nouvelles dimensions de réflexion sur la nature de l’intelligence humaine. Cet article mérite d’être lu attentivement et étudié par tous les utilisateurs d’outils de grands modèles et praticiens de l’IA.

Auteur | Darveen Vijayan

Compilé | Yue Yang

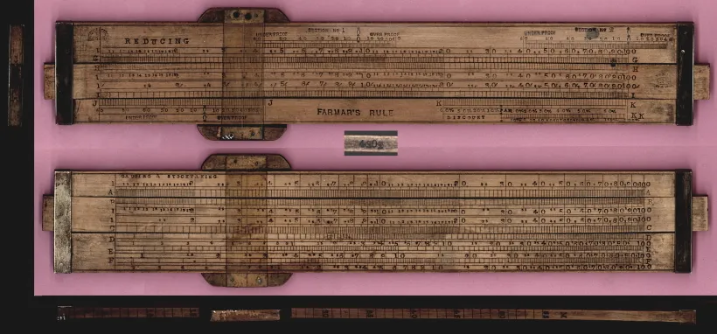

Au début du XVIIe siècle, un mathématicien et astronome nommé Edmund Gaunt a été confronté à un défi astronomique sans précédent : pour calculer les mouvements complexes des planètes et prédire les éclipses solaires, les astronomes devaient s'appuyer non seulement sur l'intuition, mais aussi sur la maîtrise des opérations logarithmiques complexes et des méthodes trigonométriques. équations. Ainsi, comme tout bon innovateur, Gunter a décidé d’inventer un appareil informatique analogique ! L'appareil qu'il a créé est finalement devenu connu sous le nom de règle à calcul[1].

La règle à calcul est un bloc de bois rectangulaire de 30 cm de long composé d'un cadre fixe et d'une partie coulissante. Le cadre fixe abrite une échelle logarithmique fixe, tandis que la partie coulissante abrite une échelle mobile. Pour utiliser une règle à calcul, vous devez comprendre les principes de base des logarithmes et savoir comment aligner les échelles pour la multiplication, la division et d'autres opérations mathématiques. Il faut faire glisser la partie mobile pour que les chiffres s'alignent, lire le résultat, et faire attention à la position de la virgule décimale. Oups, c'est vraiment trop compliqué !

règle à calcul

règle à calcul

Quelque 300 ans plus tard, en 1961, la Bell Punch Company a présenté la première calculatrice électronique de bureau, la « ANITA Mk VII ». Au cours des décennies suivantes, les calculatrices électroniques sont devenues de plus en plus complexes et dotées de plus en plus de fonctions. Les tâches qui nécessitaient auparavant des calculs manuels prennent moins de temps, ce qui permet aux employés de se concentrer sur un travail plus analytique et créatif. Par conséquent, les calculatrices électroniques modernes rendent non seulement le travail plus efficace, mais elles permettent également aux utilisateurs de mieux résoudre les problèmes.

La calculatrice a constitué un changement majeur dans la manière de faire les mathématiques, mais qu’en est-il du langage ?

Pensez à la façon dont vous structurez vos phrases. Tout d’abord, vous devez avoir une idée (que signifie cette phrase). Ensuite, vous devez maîtriser un tas de vocabulaire (avoir suffisamment de vocabulaire). Ensuite, vous devez être capable de mettre correctement ces mots dans des phrases (grammaire requise). Oups, c'est toujours aussi compliqué !

Il y a 50 000 ans déjà, lorsque l’Homo sapiens moderne a créé le langage pour la première fois, la façon dont nous générons les mots du langage est restée largement inchangée.

Sans doute, nous sommes toujours comme Gunter utilisant une règle à calcul lorsqu’il s’agit de construire des phrases !

Il est juste de dire que nous sommes toujours à l’ère de Gunther qui utilisait une règle à calcul pour générer des phrases !

Si vous y réfléchissez bien, utiliser un vocabulaire approprié et une grammaire correcte, c’est suivre les règles du langage.

C'est similaire aux mathématiques, les mathématiques regorgent de règles, ce qui me permet de comprendre 1+1=2 et comment fonctionne la calculatrice !

Nous avons besoin d'une calculatrice pour les mots !

Ce dont nous avons besoin c'est d'une calculatrice mais pour les mots !

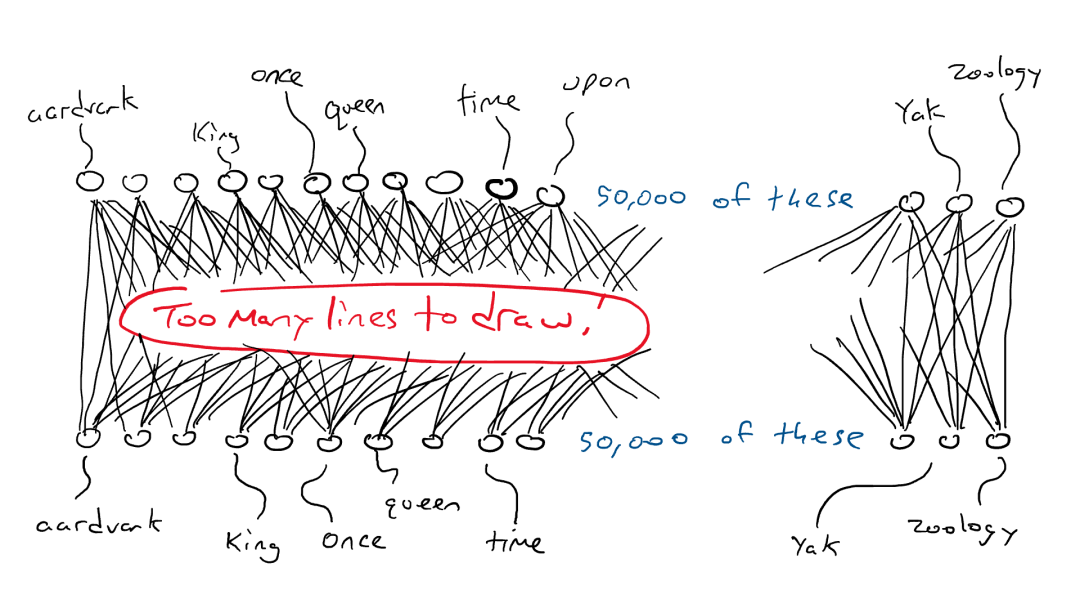

Oui, différentes langues doivent suivre des règles différentes, mais ce n'est qu'en obéissant aux règles du langage que la langue peut être comprise. Une différence évidente entre le langage et les mathématiques est que les mathématiques ont des réponses fixes et certaines, alors qu'il peut y avoir de nombreux mots raisonnables qui rentrent dans une phrase.

Essayez de remplir la phrase suivante : J'ai mangé un _________ (J'ai mangé un _________.) Imaginez les mots qui pourraient suivre. Il y a environ 1 million de mots dans la langue anglaise. De nombreux mots pourraient être utilisés ici, mais certainement pas tous.

Répondre « trou noir » équivaut à dire 2+2=5. De plus, répondre « pomme » est inexact. pourquoi ? À cause de restrictions grammaticales !

Au cours des derniers mois, les grands modèles linguistiques (LLM) [2] ont pris d'assaut le monde. Certains y voient une avancée majeure dans le domaine du traitement du langage naturel, tandis que d’autres y voient l’aube d’une nouvelle ère de l’intelligence artificielle (IA).

LLM s'est avéré très efficace pour générer du texte de type humain, ce qui place la barre plus haut pour les applications d'IA basées sur le langage. Grâce à sa vaste base de connaissances et à son excellente compréhension contextuelle, le LLM peut être appliqué dans divers domaines, de la traduction linguistique et de la génération de contenu aux assistants virtuels et chatbots pour le support client.

Sommes-nous aujourd’hui à un tournant similaire à celui des calculatrices électroniques dans les années 1960 ?

Avant de répondre à cette question, comprenons comment fonctionne le LLM ? LLM est basé sur un réseau neuronal Transformer et est utilisé pour calculer et prédire le prochain mot le mieux adapté dans une phrase. Pour créer un puissant réseau neuronal Transformer, il doit être formé sur une grande quantité de données textuelles. C'est pourquoi l'approche « prédire le prochain mot ou jeton » fonctionne si bien : parce qu'il existe de nombreuses données d'entraînement facilement disponibles. LLM prend une séquence entière de mots en entrée et prédit le mot suivant le plus probable. Pour apprendre le mot suivant le plus probable, ils se sont échauffés en dévorant toutes les données de Wikipédia, puis en dévorant des piles de livres et enfin en dévorant l'intégralité d'Internet.

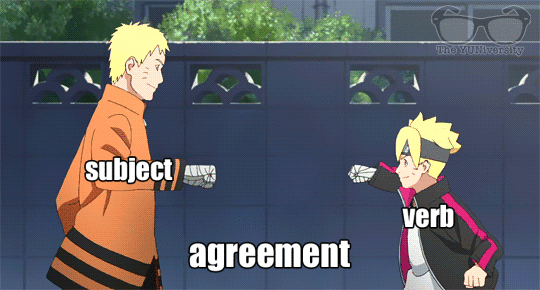

Nous avons établi précédemment que le langage contient des règles et des modèles. Le modèle apprendra implicitement ces règles à travers toutes ces phrases pour accomplir la tâche de prédiction du mot suivant.

réseau neuronal profond

Après un nom singulier, la probabilité qu'un verbe se termine par « s » augmente dans le mot suivant. De même, lors de la lecture des œuvres de Shakespeare, la probabilité d'apparition de mots tels que « fait » et « pourquoi » augmente.

Pendant la formation, le modèle apprend ces modèles de langage et devient finalement un expert en langage !

Mais est-ce suffisant ? Suffit-il simplement d’apprendre les règles d’une langue ?

Mais est-ce suffisant ? L’apprentissage des règles linguistiques est-il suffisant ?

La langue est complexe et un mot peut avoir plusieurs significations selon le contexte.

Par conséquent, une attention personnelle est requise. En termes simples, l’auto-attention est une technique que les apprenants en langues utilisent pour comprendre les relations entre les différents mots d’une phrase ou d’un article. Tout comme vous vous concentreriez sur différentes parties d'une histoire pour la comprendre, l'auto-attention permet au LLM de mettre davantage l'accent sur certains mots d'une phrase lors du traitement de l'information. De cette façon, le modèle peut mieux comprendre la signification globale et le contexte du texte, plutôt que de prédire aveuglément le mot suivant en se basant uniquement sur les règles linguistiques.

mécanisme d'auto-attention

Si je considère un grand modèle de langage comme un calculateur de mots qui prédit simplement le mot suivant, comment peut-il répondre à toutes mes questions ?

Si les LLM sont des calculateurs de mots, prédisant simplement le mot suivant, comment peuvent-ils répondre à toutes mes questions ?

Lorsque vous demandez à un grand modèle de langage de gérer une tâche qui nécessite de la réflexion et qu'il réussit, c'est probablement parce qu'il a vu la tâche que vous lui avez confiée dans des milliers d'exemples. Même si vous avez des exigences très particulières, telles que :

"Écrivez un poème sur un épaulard mangeant du poulet"

Écrivez-moi un poème sur une orque mangeant un poulet

Les grands modèles de langage peuvent également accomplir avec succès les tâches que vous leur avez assignées :

Au milieu des vagues, un spectacle inédit, Une orque chasse, rapide et vive, Dans le royaume de l'océan, la danse commence, Comme le sort d'un poulet, l'orque gagne.

Avec ses puissantes mâchoires, il frappe la proie, Les plumes flottent, à la dérive, À la manière de la nature, une histoire est racontée, Où la vie et la mort ne font plus qu'un.

~ ChatGPT

Pas mal, non ? Cela est dû à son mécanisme d’auto-attention, qui lui permet de fusionner et de faire correspondre efficacement les informations pertinentes pour construire une réponse raisonnable et cohérente.

Pendant la formation, les grands modèles linguistiques (LLM) apprennent à identifier des modèles, des associations et des relations entre les mots (et les expressions) dans les données. Après une formation approfondie et des réglages précis, LLM peut présenter de nouvelles fonctionnalités telles que la traduction linguistique, la génération de résumés, la réponse aux questions et même l'écriture créative. Bien que le modèle ne soit pas directement enseigné certaines tâches ou compétences, grâce à l'apprentissage et à la formation sur de grandes quantités de données, le modèle peut démontrer des capacités au-delà des attentes et fonctionner extrêmement bien.

Alors, les grands modèles de langage sont-ils intelligents ?

Les grands modèles de langage sont-ils intelligents ?

Les calculatrices électroniques existent depuis plus de soixante ans. Cet outil a fait un bond en avant dans la technologie, mais n'a jamais été considéré comme intelligent. pourquoi ?

Le test de Turing est un moyen simple de déterminer si une machine possède une intelligence humaine : si une machine peut converser avec les humains d'une manière qui les rend impossibles à distinguer, alors elle est considérée comme possédant une intelligence humaine.

Une calculatrice n’a jamais subi de test de Turing [3] car elle ne communique pas en utilisant le même langage que les humains, uniquement le langage mathématique. Cependant, les grands modèles de langage génèrent le langage humain. Tout son processus de formation tourne autour de l’imitation de la parole humaine. Il n’est donc pas surprenant qu’il puisse « s’adresser aux humains d’une manière qui les rend impossibles à distinguer ».

Par conséquent, utiliser le terme « intelligent » pour décrire de grands modèles de langage est un peu délicat, car il n’existe pas de consensus clair sur la véritable définition de l’intelligence. Une façon de savoir si quelque chose est intelligent est de savoir s’il peut faire quelque chose d’intéressant, d’utile et avec un certain niveau de complexité ou de créativité. Les grands modèles de langage correspondent certainement à cette définition. Cependant, je ne suis pas entièrement d'accord avec cette interprétation.

Je définis l'intelligence comme la capacité à repousser les limites de la connaissance.

Je définis l'intelligence comme la capacité d'élargir les frontières de la connaissance.

Au moment d’écrire ces lignes, les machines qui fonctionnent en prédisant le prochain jeton/mot ne peuvent toujours pas repousser les limites de la connaissance.

Cependant, il peut être déduit et rempli sur la base des données existantes. Il ne peut ni comprendre clairement la logique derrière les mots ni comprendre l’ensemble des connaissances existantes. Il ne peut pas générer d’idées innovantes ou de connaissances approfondies. Il ne peut fournir que des réponses relativement générales, mais ne peut pas générer d’idées révolutionnaires.

Face à l’incapacité des machines à générer une pensée innovante et des connaissances approfondies, quel impact ou quelles implications cela a-t-il sur nous, les humains ?

Alors, qu’est-ce que cela signifie pour nous, les humains ?

Nous devrions davantage considérer les grands modèles linguistiques (LLM) comme des calculateurs de mots. Notre processus de réflexion ne doit pas dépendre entièrement de grands modèles, mais doit être considéré comme une aide à notre réflexion et à notre expression plutôt que comme un substitut.

Dans le même temps, à mesure que le nombre de paramètres dans ces grands modèles augmente de façon exponentielle, nous pouvons nous sentir de plus en plus dépassés et perdus. Mon conseil à ce sujet est de toujours rester curieux des idées apparemment sans rapport. Parfois, nous rencontrons des idées apparemment sans rapport ou contradictoires, mais grâce à notre observation, notre perception, notre expérience, notre apprentissage et notre communication avec les autres, nous pouvons découvrir qu'il peut y avoir un lien entre ces idées, ou que ces idées pourraient être raisonnables. (Note du traducteur : Cette connexion peut provenir de notre observation, de notre compréhension et de notre interprétation des choses, ou de nouvelles idées dérivées de la corrélation de connaissances et de concepts dans différents domaines. Nous devons garder l'esprit ouvert, non seulement nous limiter aux intuitions superficielles, mais observer, percevoir , expérimenter, apprendre et communiquer avec les autres pour découvrir des significations et des connexions plus profondes) Nous ne devrions pas nous contenter de rester dans le domaine connu, mais devrions explorer activement de nouveaux domaines, en élargissant constamment nos limites cognitives. Nous devons également constamment rechercher de nouvelles connaissances ou de nouvelles compréhensions de connaissances déjà acquises et les combiner avec les connaissances existantes pour créer de nouvelles perspectives et idées.

Si vous êtes capable de penser et d'agir comme je le décris, alors toutes les formes de technologie, qu'il s'agisse d'une calculatrice ou d'un grand modèle de langage, deviendront un outil que vous pourrez exploiter plutôt qu'une menace existentielle dont vous devrez vous inquiéter.

FIN

Les références

[3] https://en.wikipedia.org/wiki/Turing_test

Cet article a été compilé par Baihai IDP avec l'autorisation de l'auteur original. Si vous devez réimprimer la traduction, veuillez nous contacter pour obtenir une autorisation.

Lien d'origine :

https://medium.com/the-modern-scientist/large-lingual-models-a-calculator-for-words-7ab4099d0cc9

RustDesk suspend ses services nationaux en raison d'une fraude généralisée Apple lance la puce M4 Taobao (taobao.com) redémarre le travail d'optimisation de la version Web Les lycéens créent leur propre langage de programmation open source comme cadeau de passage à l'âge adulte - Commentaires critiques des internautes : S'appuyer sur le défense Yunfeng a démissionné d'Alibaba et prévoit de produire à l'avenir La destination pour les programmeurs de jeux indépendants . Visual Studio Code 1.89 publie Java 17. C'est la version Java LTS la plus couramment utilisée. Windows 10 a une part de marché de 70. %, et Windows 11 continue de décliner | Google soutient Hongmeng pour prendre le relais ; l'open source Rabbit R1 prend en charge l'anxiété et les ambitions de Microsoft ;