Ces derniers jours, la nouvelle de la diffusion en direct d'OpenAI a aiguisé l'appétit de tout le monde. Tout le monde se demande si GPT-5 est sur le point de sortir. Sam Altman n'a pas dû réfuter les rumeurs sur la plate-forme X. encore publié. Moteur de recherche AI Pas cette fois non plus. L'éditeur a toujours été très curieux, pourquoi tout le monde accorde-t-il autant d'attention à GPT-5 ? La mise à jour majeure de GPT-4 n’est-elle pas encore capable de répondre aux besoins du grand public ? Jusqu'à ce que je lise cet article, je ne savais pas que les différences de version de GPT sont bien plus grandes que celles des téléphones Apple. Les progrès de GPT-5 dans le traitement vidéo à eux seuls suffisent à inciter les gens à l'attendre, sans parler du. amélioration de l'intelligence artificielle générale (AGI), il peut y avoir des progrès Après l'avoir lu, j'attends avec impatience GPT-5...

Trop long pour regarder la version :

- Les modèles ChatGPT, tels que GPT-3.5 et GPT-4, sont basés sur l'architecture Transformer et sont optimisés pour fonctionner correctement sur des tâches spécifiques, telles que le dialogue et la complétion de texte ;

- GPT-4 marque un bond en avant significatif dans les capacités de traitement du langage naturel, avec des capacités multimodales, des capacités de raisonnement améliorées et la capacité de traiter des contextes plus longs que les générations précédentes ;

- GPT-4 Turbo est une version optimisée de GPT-4, conçue spécifiquement pour les applications basées sur le chat, offrant une plus grande rentabilité et efficacité ;

- GPT-5 devrait faire des progrès passionnants dans le traitement vidéo et l’intelligence artificielle générale (AGI) ;

- À mesure que ces modèles continuent d’évoluer, des facteurs tels que la disponibilité et le coût détermineront leur adoption généralisée dans tous les secteurs.

Comprendre les bases du modèle ChatGPT : architecture et formation

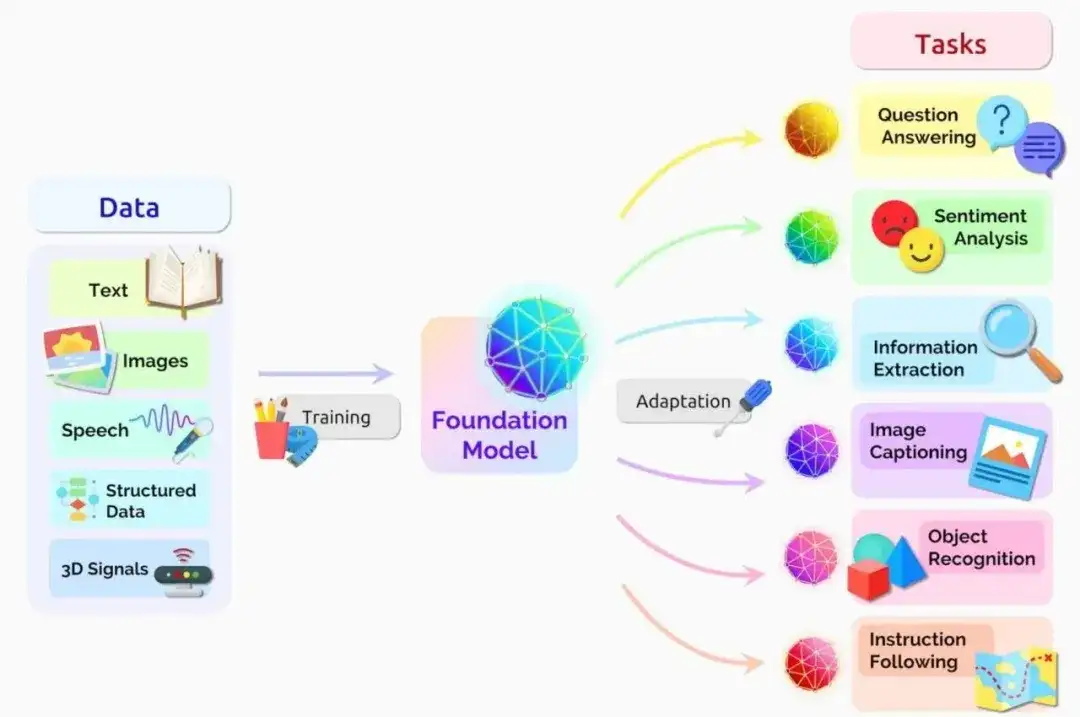

**Afin de comprendre les capacités des différents modèles ChatGPT et leurs différences, il est crucial de d'abord comprendre l'architecture sous-jacente qui les anime. Le cœur de ces modèles repose sur l’architecture GPT (Generative Pre-trained Transformer), qui a révolutionné le domaine du traitement du langage naturel. ** L'architecture GPT est dérivée du modèle Transformer présenté dans l'article phare « Attention Is All You Need » publié par Vaswani et al. Le modèle Transformer abandonne les réseaux neuronaux récurrents (RNN) traditionnels et adopte à la place un mécanisme d'auto-attention, permettant au modèle de peser l'importance des différentes parties de la séquence d'entrée lors de la génération de sortie. Adresse papier « L'attention est tout ce dont vous avez besoin » : https://arxiv.org/abs/1706.03762 Introduction détaillée des réseaux de neurones récurrents (RNN) :

https://www.techopedia.com/definition/32834/recurrent-neural-network-rnn

Modèle de transformateur, source : NVIDIA

Le mécanisme d'auto-attention permet au modèle de capturer les dépendances à longue portée et les informations contextuelles plus efficacement que les RNN, qui ont du mal à gérer les gradients en voie de disparition et les limitations de mémoire. En se concentrant sur les parties pertinentes de la séquence d'entrée, les modèles Transformer sont capables de générer une sortie plus cohérente et contextuellement appropriée.

**Un autre aspect clé de l'architecture GPT est le processus de pré-formation. **Les modèles GPT sont initialement formés sur de grandes quantités de données textuelles non étiquetées, telles que des livres, des articles et des sites Web. Au cours de cette phase de pré-entraînement non supervisée, le modèle apprend à prédire le mot suivant de la séquence en fonction des mots précédents. Cela permet au modèle de développer une riche compréhension de la structure, de la syntaxe et de la sémantique du langage.

Cependant, le modèle GPT pré-entraîné n'a pas été optimisé pour des tâches spécifiques telles que le dialogue ou la complétion de texte. Pour adapter le modèle à ces objectifs, un processus de réglage fin est utilisé. Le réglage fin implique de recycler un modèle pré-entraîné à l'aide d'un petit ensemble de données spécifique à la tâche cible, tel que les données de conversation de ChatGPT.

Lors du réglage fin, les paramètres du modèle sont ajustés pour minimiser l'erreur sur l'ensemble de données pour la tâche spécifique. Ce processus permet au modèle d'apprendre des nuances et des modèles propres à la tâche cible, ce qui entraîne des performances améliorées et des interactions plus humaines.

«La combinaison de l'architecture Transformer, du mécanisme d'auto-attention, des processus de pré-formation et de réglage fin permet au modèle GPT de générer une sortie texte de haute qualité et sensible au contexte.»

Ces choix architecturaux constituent la base des modèles ChatGPT, leur permettant de mener des conversations naturelles, de répondre aux questions et de contribuer à diverses tâches liées au langage.

Dans les chapitres suivants, lorsque nous discutons de modèles ChatGPT spécifiques, n'oubliez pas qu'ils partagent tous cette architecture commune et que les différences se reflètent principalement dans des facteurs tels que la taille du modèle, les données d'entraînement et les stratégies de réglage fin.

GPT-3.5 : La base de ChatGPT

GPT-3.5, publié par OpenAI en 2020, est le modèle de langage sous-jacent construit sur le ChatGPT original. En tant que membre de la famille de modèles GPT, GPT-3.5 démontre des progrès significatifs dans le traitement et la génération du langage naturel.

Principales fonctionnalités de GPT-3.5

- Compréhension améliorée du langage : par rapport à ses prédécesseurs, GPT-3.5 démontre une compréhension plus profonde du contexte, des nuances et de la sémantique ;

- Taille du modèle accrue : avec 175 milliards de paramètres, GPT-3.5 est l'un des plus grands modèles de langage actuellement disponibles, capable de capturer des modèles plus complexes et de générer un texte plus cohérent ;

- Améliorations de la génération de texte : GPT-3.5 peut générer du texte de type humain dans plusieurs domaines, de l'écriture créative à la documentation technique.

Dépendance de ChatGPT à GPT-3.5

Le modèle de base de ChatGPT est construit sur l'architecture GPT-3.5. En affinant GPT-3.5 avec des données de conversation multi-domaines, ChatGPT a développé la capacité de mener des conversations naturelles et contextuelles avec les utilisateurs.

Le succès de ChatGPT peut être attribué aux atouts de son modèle GPT-3.5 sous-jacent, notamment la compréhension contextuelle, une base de connaissances étendue et l'adaptabilité. GPT-3.5 permet à ChatGPT de maintenir la cohérence et la pertinence tout au long de la conversation en comprenant le contexte de la conversation. Une pré-formation approfondie sur GPT-3.5 permet à ChatGPT de référencer une vaste base de connaissances couvrant une variété de sujets et de domaines.

De plus, l'architecture de GPT-3.5 contribue à la capacité de ChatGPT à s'adapter aux différents styles de conversation et préférences des utilisateurs.

Limites et défauts de GPT-3.5

Malgré sa puissance, GPT-3.5 n’est pas sans limites. Les principaux inconvénients comprennent :

- Manque de capacités de raisonnement : bien que GPT-3.5 soit capable de générer un texte cohérent et contextuel, il ne fonctionne pas bien sur les tâches qui nécessitent un raisonnement logique ou une résolution de problèmes ;

- Biais et incohérence : GPT-3.5 peut présenter des biais dans ses données de formation et produire parfois des réponses incohérentes ou contradictoires ;

- Fenêtre contextuelle limitée : GPT-3.5 a une taille d'entrée maximale de 2 048 jetons (~ 1 500 mots), ce qui peut limiter sa capacité à gérer un contenu plus long ou à maintenir le contexte dans des conversations étendues.

Comprendre les forces et les limites de GPT-3.5 est essentiel pour définir des attentes réalistes lors de l'interaction avec ChatGPT et d'autres applications d'IA générative basées sur ce modèle. Bien que GPT-3.5 fasse considérablement progresser le domaine de l’IA conversationnelle, il reste encore des progrès à faire dans des domaines tels que le raisonnement, l’atténuation des biais et le traitement du contexte.

GPT-4 : un pas de géant dans le traitement du langage naturel

GPT-4 marque un progrès important dans les capacités de traitement du langage naturel. GPT-4, publié par OpenAI en 2023, introduit de nouvelles fonctionnalités et améliorations sur la base de l'héritage des avantages de la génération précédente.

Principales fonctionnalités de GPT-4

- Capacités multimodales : l'une des améliorations les plus importantes de GPT-4 est sa capacité à traiter et à générer du contenu selon plusieurs modalités. En plus de traiter du texte, GPT-4 peut analyser et décrire des images, ouvrant ainsi la porte à un large éventail de nouvelles applications et scénarios d'utilisation ;

- Fenêtre contextuelle augmentée : par rapport à GPT-3.5, GPT-4 a une fenêtre contextuelle beaucoup plus grande. Capable de traiter jusqu'à 25 000 jetons (environ 17 000 mots), GPT-4 peut gérer des contenus plus longs et maintenir une cohérence contextuelle lors de longues conversations ou documents ;

- Capacités de raisonnement améliorées : GPT-4 présente des capacités de raisonnement améliorées, lui permettant de mieux effectuer les tâches qui nécessitent une réflexion logique, une résolution de problèmes et une analyse. Ces progrès ouvrent de nouvelles possibilités pour l’application du GPT-4 dans la recherche scientifique, l’analyse des données et l’aide à la décision et dans d’autres domaines.

L'impact de GPT-4 sur ChatGPT

Le lancement de GPT-4 a eu un impact significatif sur ChatGPT et sur l’ensemble du domaine de l’IA conversationnelle.

En tirant parti des capacités de GPT-4, ChatGPT peut mener des conversations plus complexes et plus contextuelles, fournissant aux utilisateurs des réponses plus précises et pertinentes.

De plus, les capacités multimodales de GPT-4 facilitent le développement de nouvelles applications combinant compréhension du langage et perception visuelle. Cela ouvre des possibilités plus intéressantes en matière de sous-titrage d’images, de réponse visuelle aux questions et de création de contenu multimodal.

Aborder les limites et les considérations éthiques

Bien que GPT-4 apporte de grands progrès, il est important de réaliser qu’il ne constitue pas une panacée à toutes les limitations et défis des modèles linguistiques. Les chercheurs et les développeurs continuent de se débattre avec des problèmes tels que les préjugés, les incohérences et les abus potentiels. OpenAI a souligné son engagement en faveur du développement responsable de l’IA en prenant les mesures suivantes :

- Protection améliorée contre les contenus nuisibles ou trompeurs

- Travailler avec des chercheurs et des éthiciens pour identifier et atténuer les risques potentiels

- Divulguer de manière transparente les capacités et les limites de GPT-4

Comparaison détaillée entre GPT-3.5 et GPT-4

| Caractéristiques | GPT-4 | Compréhension approfondie du contexte, des nuances et de la sémantique | Capacité à penser logiquement, à résoudre des problèmes et à analyser | ) | Génération de texte | Peut générer du texte de type humain sur plusieurs domaines | Peut traiter et générer du contenu selon plusieurs modalités (texte, images) | Entrée maximale de 2 048 jetons | gérer un contenu plus long | Capacité de raisonnement | Manque de capacité de raisonnement |

GPT-4 Turbo : optimisé pour les applications de chat

GPT-4 Turbo est une variante du modèle GPT-4 conçue pour répondre aux besoins uniques des applications de chat. Ce modèle combine les fonctionnalités avancées de GPT-4 et est optimisé pour améliorer ses performances et son efficacité dans les environnements conversationnels.

Principales fonctionnalités de GPT-4 Turbo

- Adapté au chat : GPT-4 Turbo est optimisé avec une grande quantité de données de conversation pour générer des réponses plus naturelles et cohérentes dans les interactions basées sur le chat ;

- Efficacité améliorée : grâce à l'optimisation de l'architecture et du processus de formation, GPT-4 Turbo offre un temps de réponse plus rapide et un coût de calcul inférieur à celui du modèle GPT-4 standard ;

- Gestion améliorée du contexte : GPT-4 Turbo est conçu pour gérer plus efficacement la dynamique des conversations, en maintenant le contexte et la cohérence au cours de plusieurs cycles de conversations.

Avantages de GPT-4 Turbo dans ChatGPT

Le professionnalisme de GPT-4 Turbo apporte de nombreux avantages aux applications de chat :

- Rentabilité : en réduisant les exigences informatiques, GPT-4 Turbo permet aux développeurs de créer, d'exploiter et de faire évoluer des applications de chat à moindre coût ;

- Expérience utilisateur améliorée : avec des temps de réponse plus rapides et des résultats plus pertinents sur le plan contextuel, GPT-4 Turbo améliore l'expérience utilisateur globale des interactions basées sur le chat ;

- Évolutivité : les optimisations de GPT-4 Turbo le rendent idéal pour gérer les conversations à haute concurrence, permettant aux applications de chat d'évoluer de manière transparente.

Quelle sera la puissance de GPT-5 ?

OpenAI a confirmé qu'il travaille activement sur GPT-5, et bien que les détails spécifiques sur GPT-5 soient encore limités, les premières indications suggèrent qu'il apportera des améliorations significatives et de nouvelles fonctionnalités.

Améliorations fonctionnelles possibles de GPT-5 :

- Élargir davantage la fenêtre contextuelle pour prendre en charge la compréhension et la génération de contenu plus long

- Capacités avancées de traitement des dialogues multitours pour obtenir des dialogues plus naturels et plus fluides

- Améliorer les capacités de raisonnement et de résolution de problèmes et étendre les capacités des modèles de langage

En outre, des rumeurs courent selon lesquelles GPT-5 pourrait introduire des capacités de traitement vidéo, étendant ainsi ses capacités de traitement multimédia du texte et des images aux vidéos. Cela pourrait ouvrir de nouvelles frontières en matière d’analyse, de génération et d’interaction vidéo. Le développement rapide de modèles de langage comme ChatGPT a relancé les discussions sur la possibilité de parvenir à une intelligence générale artificielle (AGI), une capacité hypothétique des systèmes d'IA à comprendre et à apprendre toute tâche basée sur la connaissance qu'un humain peut accomplir.

FAQ

Q : Quel modèle ChatGPT dois-je utiliser ?

R : Votre choix de modèle ChatGPT doit être basé sur vos besoins spécifiques, votre budget et vos capacités techniques. GPT-3.5 convient aux scénarios généraux, tandis que GPT-4 offre des fonctionnalités plus avancées et une prise en charge multimodale. GPT-4 Turbo est optimisé pour les applications de chat, équilibrant performances et efficacité.

Q : Quel modèle ChatGPT-4 utilise-t-il ?

R : ChatGPT-4 est basé sur le modèle de langage GPT-4, qui est le modèle le plus avancé de la série GPT développée par OpenAI. Par rapport à son prédécesseur GPT-3.5, GPT-4 présente des améliorations significatives en termes de capacités multimodales, un raisonnement amélioré et des fenêtres contextuelles plus grandes.

Q : GPT-5 arrive-t-il bientôt ?

R : Oui, OpenAI a confirmé qu'il développe activement GPT-5 en tant que successeur du modèle GPT-4. Bien que les détails spécifiques soient limités, GPT-5 devrait apporter de nouveaux progrès dans la compréhension du contexte, les capacités conversationnelles et peut-être même les capacités de traitement vidéo.

Q : Quel modèle GPT est le meilleur ?

R : Cela dépend de votre scénario d’application et de vos besoins. Pour l'instant, GPT-4 offre les fonctionnalités les plus avancées, tandis que GPT-3.5 est un choix plus abordable pour les scénarios d'application généraux et de chat.

En cas d'infraction, veuillez nous contacter pour la supprimer. Lien de référence : https://www.techopedia.com/chatgpt-models-guide

Suivez-nous

"Trusted AI Progress" Le compte officiel est dédié à la diffusion des dernières technologies d'intelligence artificielle fiables et à la culture de la technologie open source, couvrant l'apprentissage des graphes à grande échelle, le raisonnement causal, les graphiques de connaissances, les grands modèles et d'autres domaines techniques. Bienvenue sur. scannez le code QR pour suivre et débloquer plus d'informations sur l'IA ~