Nota do editor: Atualmente, grandes modelos de linguagem se tornaram um tema importante no campo do processamento de linguagem natural. Os LLMs são realmente “inteligentes”? Que inspirações eles trouxeram para nós? Em resposta a essas perguntas, Darveen Vijayan nos traz este artigo instigante.

O autor explica principalmente dois pontos: primeiro, o LLM deve ser considerado uma calculadora de palavras, que funciona prevendo a próxima palavra, e não deve ser classificado como "inteligente" nesta fase. Em segundo lugar, apesar das suas actuais limitações, os LLMs proporcionam-nos uma oportunidade de reflectir sobre a natureza da inteligência humana. Devemos manter uma mente aberta, buscar constantemente novos conhecimentos e novas compreensões do conhecimento, e comunicar ativamente com os outros para expandir os nossos limites cognitivos.

Se os LLMs são inteligentes ou não, provavelmente ainda é controverso. Mas uma coisa é certa: trouxeram inovação ao campo do processamento da linguagem natural e proporcionaram novas dimensões de pensamento sobre a natureza da inteligência humana. Vale a pena ler este artigo com atenção e ser refletido por todos os usuários de ferramentas de grande modelo e profissionais de IA.

Autor |

Compilado |

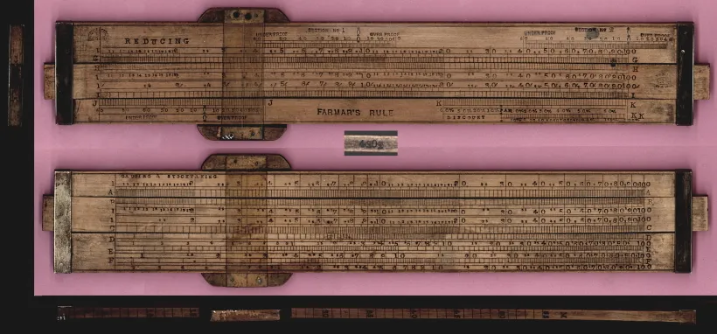

No início do século XVII, um matemático e astrônomo chamado Edmund Gaunt enfrentou um desafio astronômico sem precedentes - para calcular os movimentos complexos dos planetas e prever eclipses solares, os astrônomos precisavam confiar não apenas na intuição, mas também em dominar operações logarítmicas complexas e trigonométricas. equações. Então, como qualquer bom inovador, Gunter decidiu inventar um dispositivo de computação analógico! O dispositivo que ele criou acabou ficando conhecido como régua de cálculo[1].

A régua de cálculo é um bloco retangular de madeira com 30 cm de comprimento, composto por uma moldura fixa e uma parte deslizante. A moldura fixa abriga uma escala logarítmica fixa, enquanto a parte deslizante abriga uma escala móvel. Para usar uma régua de cálculo, você precisa compreender os princípios básicos dos logaritmos e como alinhar as escalas de multiplicação, divisão e outras operações matemáticas. É necessário deslizar a parte móvel para que os números se alinhem, ler o resultado e prestar atenção na posição da vírgula decimal. Ops, é realmente muito complicado!

régua de cálculo

régua de cálculo

Cerca de 300 anos depois, em 1961, a Bell Punch Company lançou a primeira calculadora eletrônica de mesa, a "ANITA Mk VII". Nas décadas seguintes, as calculadoras eletrônicas tornaram-se cada vez mais complexas e tinham cada vez mais funções. Os trabalhos que anteriormente exigiam cálculos manuais demoram menos tempo, permitindo que os funcionários se concentrem em trabalhos mais analíticos e criativos. Portanto, as calculadoras eletrônicas modernas não apenas tornam o trabalho mais eficiente, mas também permitem que as pessoas resolvam melhor os problemas.

A calculadora foi uma grande mudança na forma como a matemática era feita, mas e a linguagem?

Pense em como você estrutura suas frases. Primeiro, você precisa ter uma ideia (o que significa esta frase). Em seguida, você precisa dominar um monte de vocabulário (ter vocabulário suficiente). Então, você precisa ser capaz de colocar essas palavras em frases corretamente (gramática necessária). Ops, ainda é tão complicado!

Há 50 mil anos, quando o Homo sapiens moderno criou a linguagem, a forma como geramos palavras para a linguagem permaneceu praticamente inalterada.

Indiscutivelmente, ainda somos como Gunter, usando uma régua de cálculo quando se trata de construir frases!

É justo dizer que ainda estamos na era de Gunther, de usar uma régua de cálculo quando se trata de gerar frases!

Se você pensar bem, usar o vocabulário apropriado e a gramática correta é seguir as regras da linguagem.

É semelhante à matemática, a matemática é cheia de regras, então posso descobrir 1+1=2 e como funciona a calculadora!

Precisamos de uma calculadora para palavras!

O que precisamos é de uma calculadora, mas de palavras!

Sim, idiomas diferentes precisam seguir regras diferentes, mas somente obedecendo às regras do idioma o idioma pode ser compreendido. Uma diferença clara entre a linguagem e a matemática é que a matemática tem respostas fixas e certas, ao passo que pode haver muitas palavras razoáveis que cabem numa frase.

Tente preencher a seguinte frase: Comi _________ (comi _________.) Imagine as palavras que virão a seguir. Existem aproximadamente 1 milhão de palavras na língua inglesa. Muitas palavras poderiam ser usadas aqui, mas certamente não todas.

Responder “buraco negro” equivale a dizer 2+2=5. Além disso, responder “maçã” é impreciso. por que? Por causa de restrições gramaticais!

Nos últimos meses, os Large Language Models (LLMs) [2] conquistaram o mundo. Algumas pessoas consideram-no um grande avanço no campo do processamento de linguagem natural, enquanto outros consideram-no o início de uma nova era de inteligência artificial (IA).

O LLM provou ser muito bom na geração de texto semelhante ao humano, o que eleva o padrão para aplicações de IA baseadas em linguagem. Com sua vasta base de conhecimento e excelente compreensão contextual, o LLM pode ser aplicado em diversas áreas, desde tradução de idiomas e geração de conteúdo até assistentes virtuais e chatbots para suporte ao cliente.

Estaremos agora num ponto de viragem semelhante ao que estávamos com as calculadoras electrónicas na década de 1960?

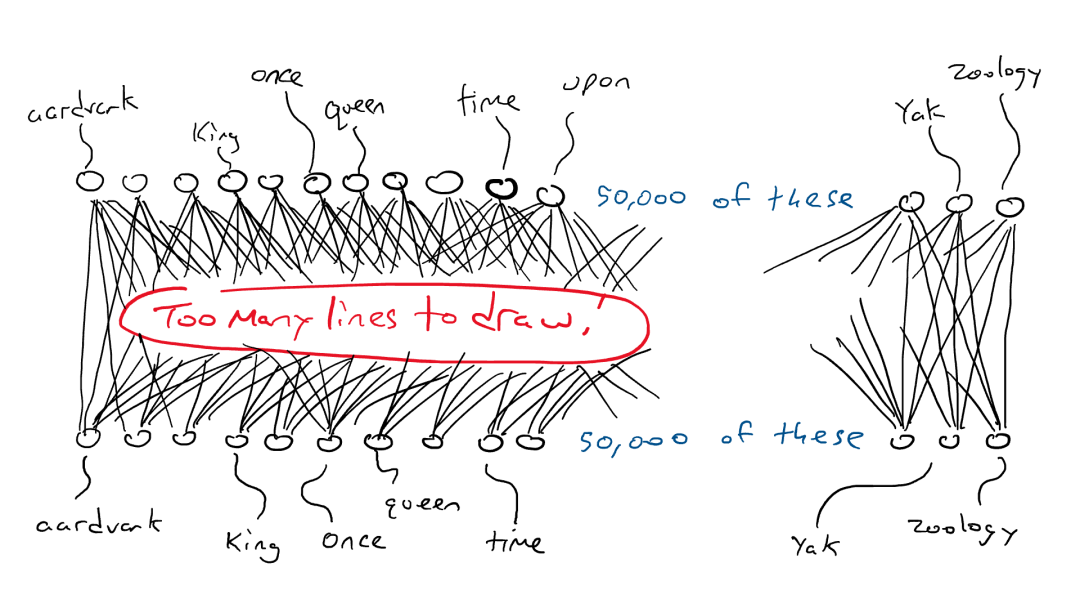

Antes de responder a esta pergunta, vamos entender como funciona o LLM? O LLM é baseado em uma rede neural Transformer e é usado para calcular e prever a próxima palavra mais adequada em uma frase. Para construir uma rede neural Transformer poderosa, ela precisa ser treinada em uma grande quantidade de dados de texto. É por isso que a abordagem “prever a próxima palavra ou token” funciona tão bem: porque há muitos dados de treinamento facilmente disponíveis. O LLM pega uma sequência inteira de palavras como entrada e prevê a próxima palavra mais provável. Para aprender a próxima palavra mais provável, eles se aqueceram devorando todos os dados da Wikipédia, depois devorando pilhas de livros e, finalmente, devorando toda a Internet.

Estabelecemos anteriormente que a linguagem contém regras e padrões. O modelo aprenderá implicitamente essas regras por meio de todas essas frases para completar a tarefa de prever a próxima palavra.

rede neural profunda

Depois de um substantivo no singular, a probabilidade de um verbo terminar em “s” aumenta na palavra seguinte. Da mesma forma, ao ler as obras de Shakespeare, a probabilidade de ocorrência de palavras como “doth” e “fore” aumenta.

Durante o treinamento, o modelo aprende esses padrões de linguagem e eventualmente se torna um especialista em idiomas!

Mas isso é suficiente? É suficiente simplesmente aprender as regras de uma língua?

Mas isso é suficiente? Aprender regras linguísticas é suficiente?

A linguagem é complexa e uma palavra pode ter vários significados dependendo do contexto.

Portanto, é necessária autoatenção. Simplificando, a autoatenção é uma técnica que os alunos usam para compreender as relações entre diferentes palavras em uma frase ou artigo. Assim como você focaria em diferentes partes de uma história para entendê-la, a autoatenção permite que o LLM coloque mais ênfase em certas palavras de uma frase ao processar informações. Dessa forma, o modelo pode compreender melhor o significado geral e o contexto do texto, em vez de prever cegamente a próxima palavra com base apenas nas regras do idioma.

mecanismo de autoatenção

Se eu pensar em um grande modelo de linguagem como uma calculadora de palavras que simplesmente prevê a próxima palavra, como ela poderá responder a todas as minhas perguntas?

Se os LLMs são calculadoras de palavras, apenas prevendo a próxima palavra, como podem responder a todas as minhas perguntas?

Quando você pede a um grande modelo de linguagem para lidar com uma tarefa que requer raciocínio, e ele é bem-sucedido, é provável que ele tenha visto a tarefa que você deu em milhares de exemplos. Mesmo se você tiver alguns requisitos exclusivos, como:

"Escreva um poema sobre uma baleia assassina comendo frango"

Escreva-me um poema sobre uma orca comendo uma galinha

Modelos de linguagem grandes também podem concluir com êxito as tarefas que você atribuiu:

Entre as ondas, uma visão invisível, Uma orca caça, rápida e perspicaz, No reino do oceano, a dança começa, Como o destino de uma galinha, a orca vence.

Com mandíbulas poderosas, ele atinge a presa, Penas flutuam, à deriva, No caminho da natureza, uma história é contada, Onde a vida e a morte se tornam uma só.

~ Bate-papoGPT

Nada mal, certo? Isso se deve ao seu mecanismo de autoatenção, que permite fundir e combinar com eficácia informações relevantes para construir uma resposta razoável e coerente.

Durante o treinamento, os grandes modelos de linguagem (LLMs) aprendem a identificar padrões, associações e relacionamentos entre palavras (e frases) nos dados. Após extenso treinamento e ajuste fino, o LLM pode exibir novos recursos, como tradução de idiomas, geração de resumos, resposta a perguntas e até redação criativa. Embora certas tarefas ou habilidades não sejam ensinadas diretamente ao modelo, ao aprender e treinar em grandes quantidades de dados, o modelo pode demonstrar capacidades além das expectativas e ter um desempenho extremamente bom

Então, os grandes modelos de linguagem são inteligentes?

Os grandes modelos de linguagem são inteligentes?

As calculadoras eletrônicas existem há mais de sessenta anos. Essa ferramenta fez avanços tecnológicos "saltos", mas nunca foi considerada inteligente. por que?

O Teste de Turing é uma maneira simples de determinar se uma máquina possui inteligência humana: se uma máquina pode conversar com os humanos de uma forma que os torne indistinguíveis, então é considerada como tendo inteligência humana.

Uma calculadora nunca passou por um teste de Turing [3] porque ela não se comunica usando a mesma linguagem que os humanos, apenas a linguagem matemática. No entanto, grandes modelos de linguagem geram linguagem humana. Todo o seu processo de treinamento gira em torno da imitação da fala humana. Portanto, não é surpreendente que possa “falar com os humanos de uma forma que os torna indistinguíveis”.

Portanto, usar o termo “inteligente” para descrever grandes modelos de linguagem é um pouco complicado, porque não há um consenso claro sobre a verdadeira definição de inteligência. Uma maneira de saber se algo é inteligente é se ele pode fazer algo interessante, útil e com certo nível de complexidade ou criatividade. Grandes modelos de linguagem certamente se enquadram nesta definição. No entanto, não concordo inteiramente com esta interpretação.

Defino inteligência como a capacidade de expandir as fronteiras do conhecimento.

Defino inteligência como a capacidade de expandir as fronteiras do conhecimento.

No momento em que este livro foi escrito, as máquinas que funcionam prevendo o próximo token/palavra ainda não conseguiam expandir os limites do conhecimento.

No entanto, pode ser inferido e preenchido com base nos dados existentes. Não consegue compreender claramente a lógica por trás das palavras nem compreender o corpo de conhecimento existente. Não pode gerar ideias inovadoras ou insights profundos. Só pode fornecer respostas relativamente gerais, mas não pode gerar ideias inovadoras.

Confrontados com a incapacidade das máquinas de gerar pensamentos inovadores e insights aprofundados, que impacto ou implicações isso tem sobre nós, humanos?

Então, o que isso significa para nós, humanos?

Deveríamos pensar nos grandes modelos de linguagem (LLMs) mais como calculadoras de palavras. O nosso processo de pensamento não deve ser completamente dependente de grandes modelos, mas deve ser visto como uma ajuda ao nosso pensamento e expressão, e não como um substituto.

Ao mesmo tempo, à medida que o número de parâmetros nestes grandes modelos cresce exponencialmente, podemos sentir-nos cada vez mais sobrecarregados e perdidos. Meu conselho sobre isso é sempre permanecer curioso sobre ideias aparentemente não relacionadas. Às vezes encontramos algumas ideias aparentemente não relacionadas ou contraditórias, mas através da nossa observação, percepção, experiência, aprendizagem e comunicação com outras pessoas, podemos descobrir que pode haver alguma ligação entre estas ideias, ou estas ideias podem ser razoáveis. (Nota do tradutor: Esta conexão pode vir de nossa observação, compreensão e interpretação das coisas, ou de novas ideias derivadas da correlação de conhecimentos e conceitos em diferentes campos. Devemos manter a mente aberta, não apenas limitar-se a intuições superficiais, mas observar, perceber , experimentar, aprender e comunicar-se com outras pessoas para descobrir significados e conexões mais profundos). Não devemos nos contentar em apenas permanecer no domínio conhecido, mas devemos explorar ativamente novos campos, expandindo constantemente nossos limites cognitivos. Devemos também procurar constantemente novos conhecimentos ou novas compreensões de conhecimentos já adquiridos e combiná-los com o conhecimento existente para criar novos insights e ideias.

Se você for capaz de pensar e agir da maneira que descrevo, então todas as formas de tecnologia, seja uma calculadora ou um grande modelo de linguagem, se tornarão uma ferramenta que você poderá aproveitar, em vez de uma ameaça existencial com a qual você precisa se preocupar.

FIM

Referências

[3] https://en.wikipedia.org/wiki/Turing_test

Este artigo foi compilado por Baihai IDP com a autorização do autor original. Caso necessite reimprimir a tradução, entre em contato conosco para autorização.

Links originais:

https://medium.com/the-modern-scientist/large-language-models-a-calculator-for-words-7ab4099d0cc9

RustDesk suspende serviços domésticos devido a fraude desenfreada Apple lança chip M4 Taobao (taobao.com) reinicia trabalho de otimização de versão web Alunos do ensino médio criam sua própria linguagem de programação de código aberto como um presente de maioridade - Comentários críticos dos internautas: Confiando no defesa Yunfeng renunciou ao Alibaba e planeja produzir no futuro O destino para programadores de jogos independentes Visual Studio Code 1.89 lança Java 17. É a versão Java LTS mais comumente usada, com uma participação de mercado de 70. %, e o Windows 11 continua a diminuir. Open Source Daily | Google apoia Hongmeng para assumir o controle do Rabbit R1;