введение

Документы Адрес: к себе внимание по сравнению с прошлым Чтение постижений через Attention нейронных сетей для

отсчета Боуэна:

https://www.imooc.com/article/29985

https://www.cnblogs.com/sandwichnlp/p/11811396.html#model-4 -aoa-ридер

Набор данных : CNN и Daily Mail, ТОС,

Чтение образца : <D, Q, A>

АОА Читатель принадлежности к двумерной модели сопоставления ( Нетерпеливый читатель является модель соответствия 2D, АоА считыватель аналогично CSA , считыватель), АОА Считыватель Внимание рассчитывается для комбинированного образом в строках и столбцах , следовательно , (АОА), в то время , используя вторичные методы проверки для модели АОА чтения , чтобы вычислить ответ необходимо проверить еще раз. Основные моменты этого документа является еще одним механизмом , чтобы сосредоточить внимание на существующих вложенными, т.е. чрезмерная концентрация внимания механизмов.

для конкретных моделей, 1 АоА

Встраивание Контекст : документы со встроенным слоем и вопросы , внедренные значение матрицы уровня прав общего доступа ,

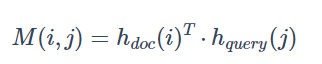

парное Matching Оценка : Скрытая точка документа и запроса умножения (поскольку совместное использование весовой матрицы, являются двунаправленными ГРУ, так те же размеры) , чтобы дать Pari -wise матрица соответствия ( попарно соответствие матрица )

Индивидуальное внимание :

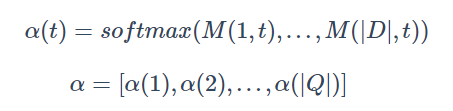

вниМание вычисляемых столбцы : подсчитана , что каждое слово документ для запроса внимания слова (важности), и , наконец , сформировать распределенное внимание на уровень документа (Т), также известный как запрос-к-документа Attetion , смотри ниже, чтобы получить альфа матрицу . В чем размерность α | D | * | Q |

Внимание направление нормализуется строка - модель ССХ (основные моменты) :

использование для фокусировки внимания на взвешенной суммы весов. Значение представление становится слово в данной статье, важность этих вопросов , его слова в

сторону линии были Софтмакс нормализованы, получить в документ-запроса на внимание .

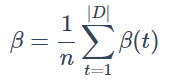

Для этого в среднем, получают внимание на уровне запросов :

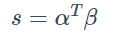

Наконец, каждый из которых внимание запросов к-документа и просто получить внимание запрос на уровне сделать дот дают оценку каждому слову в документе. (| D Q | * | Q 1 |)

Больше строк и столбцов, подытожил этот процесс похож на людей , читающих этот документ:

при взгляде на проблемы, важность вопроса слов не то же самое . Основной вклад в анализ этой проблемы в каждом слове, сначала найти наибольший вклад слова (колонки внимания + SoftMax), а затем повторно позиционирование и наибольший вклад в это слово наиболее соответствующие слова в документе (строка внимания + сумма) в качестве ответа на вопрос

Прогнозы Окончательное : слово ш может происходить несколько раз в текстовом пространстве V, его положение по- видимому, образует множество I I (W, D)