第十一章 实践方法论

2020-2-27 深度学习笔记11 - 实践方法论 1(性能度量-精度/召回率/PR曲线/覆盖率,默认的基准模型,决定是否收集更多数据)

选择超参数

大部分深度学习算法都有许多超参数来控制不同方面的算法表现。

- 有些超参数会影响算法运行的时间和存储成本。

- 有些超参数会影响学习到的模型质量,以及在新输入上推断正确结果的能力

有两种选择超参数的基本方法:手动选择和自动选择。

- 手动选择超参数需要了解超参数做了些什么,以及机器学习模型如何才能取得良好的泛化。

- 自动选择超参数算法大大减少了解这些想法的需要,但它们往往需要更高的计算成本。

1-手动调整超参数

手动设置超参数,我们必须了解超参数、训练误差、泛化误差和计算资源(内存和运行时间)之间的关系。

目标:调整模型的有效容量以匹配任务的复杂性。

容量:模型能够表示更复杂函数的能力。

对于某些超参数,数值太大时会发生过拟合。例如中间层隐藏单元的数量。学习率可能是最重要的超参数。调整学习率外的其他参数时,需要同时监测训练误差和测试误差,以判断模型是否过拟合或者欠拟合,然后适当调整容量。

大部分超参数可通过推理其是否增加或减少模型容量来设置。如隐藏单元数量增加,模型容量会增加,同时计算代价增加。权重衰减系数降低,容量增加,因为模型此时参数可以自由变大。

手动调整超参数的目标:提升测试集性能。只要训练误差低,随时可以收集更多训练数据来减少泛化误差。

2-自动超参数优化算法

流行的LR或者SVM,只有一到两个超参数需要调整,这还好说,NN(神经网络)动辄有较多的超参数。使用者如果没有几年的调参经验,那么手动调就是瞎折腾。能不能有自动算法,找到合适的超参数呢?

原则上,我们是有可能开发出封装学习算法的超参数优化算法,让使用者不用指定学习算法的超参数。但是,遗憾的是,超参数优化算法,本身又有自己的超参数,比如你需要为每个超参数指定被探索的值的范围,仍然需要人去指定。但是,这些次级超参数通常很容易选择,还是让问题变得好办点(超参数的大循环,包含学习算法的小循环)。

3-网格搜索

当有3个或者更少的超参数时,对于每个超参数,选择一个较小的有限值集去探索。这些超参数笛卡尔积得到一组组超参数,然后网格搜索:使用每组值训练模型,挑选验证集误差最小的一组值为最好的超参数。

通常,网格搜索大约在对数尺度上。如学习率的取值集合是{0.1,0.01,0.001,0.0001,0.00001}

。

通常,重复进行搜索效果会最好。例如,在集合{−1,0,1}找到的最佳值是1,说明低估了最优值所在范围,可继续在{1,2,3}中搜索。或者细粒度上继续搜索。

问题:计算代价随着超参数数量呈指数级增长。ps:这个有切身体会,当时CRF超参数中搜索5个参数,每个有5个左右的取值,共需要进行3000多次训练,一次需要50分钟,因为只有一台主机,跑完需要3个月!最后没办法硬把参数取值降下来,有的取3个值,这样确保3-4天跑一趟。后来想到搞个较小的验证集来测试超参数也可以,取了200张图片来做。

4-随机搜索

替代网格搜索的方法:随机搜索。编程简单,使用更方便,能更快地收敛到超参数的良好取值。

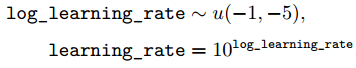

为每个超参数定一个边缘分布,例如伯努利分布,或者对数尺度上的均匀分布,例如对学习率的指数进行均匀采样:

和网格搜索不同,这时不需要离散化超参数的值,这允许在一个更大的集合上搜索,而不产生额外的计算代价。

当有几个超参数对性能度量没有显著影响时,随机搜索比网格指数级的高效。原因:没有浪费的实验,不像网格搜索有时会对一个超参数的两个不同值(给定其他超参数值不变)给出相同结果。

上图左边中,给定横轴超参数值,网格会对纵轴超参数的3个不同值给出相同结果,其实造成浪费。但是右边的随机搜索中,每次超参数通常具有不同值,每次都是独立的探索。(网格设定比较死,随机搜索中人为更少的干预)

5-基于模型的超参数优化

简化设定下,可以计算验证集上可导误差函数关于超参数的梯度。但是,大多数下梯度不可用。可能是因为高额的计算代价和存储成本,也可能是压根儿就不可导。

为了弥补梯度的缺失,可对验证集误差建模,然后通过优化该模型来提出新的超参数猜想。大部分基于模型的超参数搜索算法,均使用贝叶斯回归模型,来估计每个超参数的验证集误差期望和该期望的不确定性,但这涉及到探索。时而表现得像人类专家,时而爆炸了,不够成熟稳定。

大部分超参数优化算法比随机搜索更复杂,且缺点是在它们能够从实验提取任何信息前,需要运行完整的训练实验。手动搜索通常很早判断出超参数是否是病态的。