知识点一:爬虫的基本原理梳理

一、什么是爬虫?

请求网站并提取数据的自动化程序

二、爬虫的基本流程

1:向服务器发起请求

通过HTTP库向目标站点发起请求,即发送一个Request,请求可以包含额外的headers等信息,等待服务器的响应。

2:获取响应内容

如果服务器正常响应,会得到一个Response,Response的内容便是所要获取的页面内容,类型可能有HTML、JSON、二进制文件(如图片、视频等类型)。

3:解析内容

得到的内容可能是HTML,可以用正则表达式、网页解析库进行解析。可能是JSON,可以直接转成JOSN对象进行解析,可能是二进制数据,可以保存或者进一步处理

4:保存内容

保存形式多样,可以保存成文本,也可以保存至数据库,或者保存成特定格式的文件。

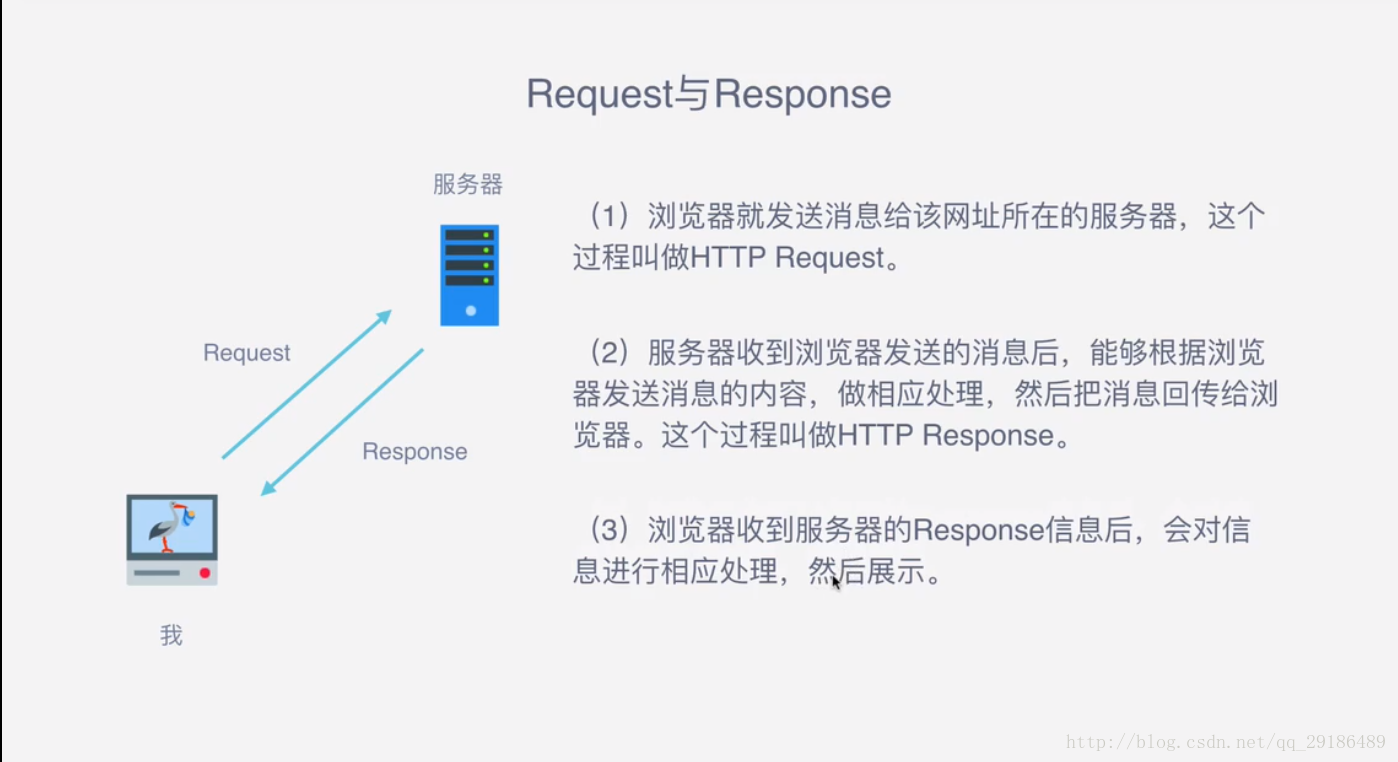

三、什么是Response和Request ?

四、Request中包含哪些内容?

1:请求方式

主要是GET、POST两种类型,另外还有HEAD、PUT、DELETE、OPTIONS等。

2:请求URL

URL全称是统一资源定位符,如一个网页文档、一张图片、一个视频等都可以用URL来唯一来确定

3:请求头

包含请求时的头部信息,如User-Agent、Host、Cookies等信息

4:请求体

请求时额外携带的数据,如表单提交时的表单数据

五、Response中包含哪些内容?

1:响应状态

有多种响应状态,如200代表成功,301代表跳转,404代表找不到页面,502代表服务器错误等

2:响应头

如内容类型、内容长度、服务器信息、设置cookies等等

3:响应体

最主要的部分,包含了请求资源的内容,如网页HTML、图片二进制数据等。

六、能抓到怎样的数据?

1:网页文本

如HTML文档、JSON格式文本等

2:图片文件

获取的是二进制文件,保存为图片格式

3:视频

同为二进制文件,保存为视频格式即可

4:其他

只要能够请求到的,都能够获取到

七、解析的方式

八、为什么我们抓到的有时候和浏览器看到的不一样?

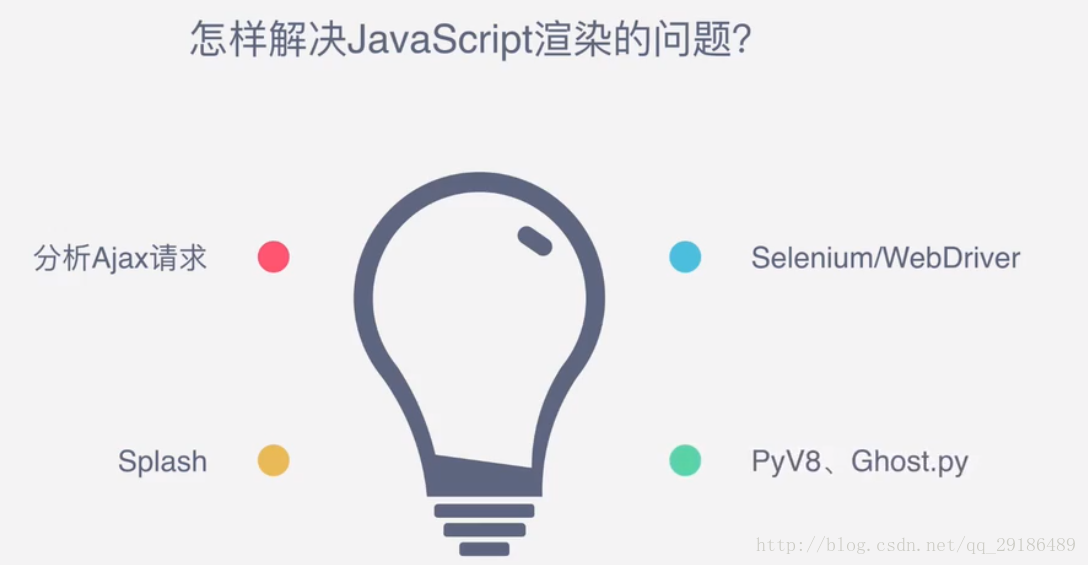

有时候,网页返回是JS动态加载的,直接用请求库访问获取到的是JS代码,不是渲染后的结果。

九、怎样保存数据?