回归算法是一种通过最小化预测值与实际结果值之间的差距,而得到输入特征之间的最佳组合方式的一类算法。对于连续值预测有线性回归等,而对于离散值/类别预测,我们也可以把逻辑回归等也视作回归算法的一种。线性回归主要用来解决连续值预测的问题,逻辑回归用来解决分类的问题,输出的属于某个类别的概率,工业界经常会用逻辑回归来做排序。在SVM、GBDT、AdaBoost算法中都有涉及逻辑回归,回归中的损失函数、梯度下降、过拟合等知识点也经常是面试考察的基础问题。因此很重要的两个内容,需要仔细体会~

1. 线性回归

1.1 线性回归问题,适用于有监督学习的预测。

一元线性回归分析:y=ax+b,只包括一个自变量和一个因变量,且二者的关系可用一条直线近似表示。

多元线性回归分析:hθ(x)=θ0+θ1x1+...+θnxn,包括两个或两个以上的自变量,并且因变量和自变量是线性关系。

1.2 损失函数

损失函数:通俗地说,损失函数用来衡量参数选择的准确性。损失函数定义为:

这个公式计算的是线性回归分析的值与实际值的距离的平均值。显然,损失函数得到的值越小,损失也就越小。

1.3 梯度下降

怎样最小化损失函数?损失函数的定义是一个凸函数,就可以使用凸优化的一些方法:

1) 梯度下降:逐步最小化损失函数的过程。如同下山的过程,找准下山方向(梯度),每次迈进一步,直至山底。如果有多个特征,对应多个参数θ,需要对每一个参数做一次迭代θj:=θj−α∂∂θjJ(θ0,θ1),做完以后再求J函数。

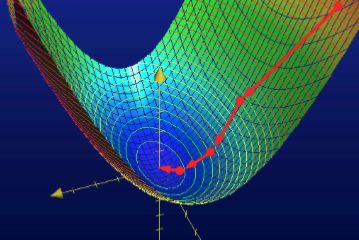

学习率:上段公式中的α就是学习率。它决定了下降的节奏快慢,就像一个人下山时候步伐的快慢。α过小会导致收敛很慢,α太大有可能会导致震荡。如何选择学习率呢,目前也有好多关于学习率自适应算法的研究。工程上,一般会调用一些开源包,包含有一些自适应方法。自己做的话会选择相对较小的α,比如0.01。下图展示了梯度下降的过程。

2) 牛顿法:速度快适用于小数据,大数据比较耗内存。

1.4 过拟合与正则化

回归与欠/过拟合:

1) 欠拟合:函数假设太简单导致无法覆盖足够的原始数据,可能造成数据预测的不准确。

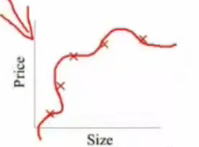

2) 拟合问题:比如我们有很多的特征,假设的函数曲线对原始数据拟合的非常好,从而丧失一般性,导致对新给的待预测样本,预测效果差。下图就是一个例子,一个复杂的曲线,把所有点都拟合进去了,但是泛化能力变差了,没有得到一个规律性的函数,不能有效的预测新样本。

过拟合解决方法:

1) 减少特征个数:手工选择保留特征、模型选择的算法选择特征。

2) 正则化:在原来的损失函数中加入θ的平方项,来防止波动太大。

即L2正则化。留下所有的特征,但是减少参数的大小。

2. 逻辑(斯特)回归

2.1 应用分析

与线性回归不同,逻辑回归主要用于解决分类问题,

2.2 Sigmoid函数

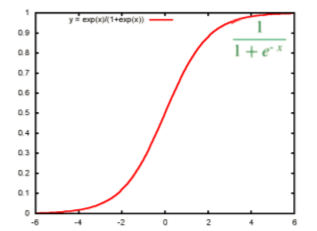

逻辑回归首先把样本映射到[0,1]之间的数值,这就归功于sigmoid函数,可以把任何连续的值映射到[0,1]之间,数越大越趋向于0,越小越趋近于1。Sigmoid函数公式如下:

函数的图像如下图,x=0的时候y对应中心点。

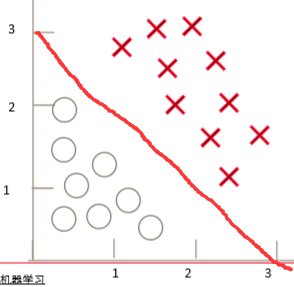

判定边界:对多元线性回归方程求Sigmoid函数hθ(x)=g(θ0+θ1x1+...+θnxn),找到一组θ,假设得到−3+x1+x2=0的直线,把样本分成两类。把(1,1)代入g函数,概率值<0.5,就判定为负样本。这条直线就是判定边界,如下图:

除了线性判定边界,还有较复杂的非线性判定边界。

2.3 逻辑回归的损失函数

线性回归的损失函数对逻辑回归不可用,因为逻辑回归的值是0或者1,求距离平均值会是一条不断弯曲的曲线,不是理想的凸函数。聪明的数学家找到了一个适合逻辑回归的损失定义方法:

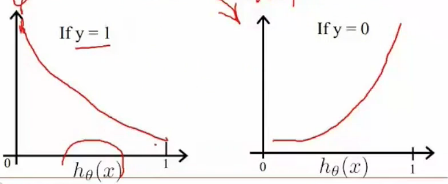

其中 hθ(x) 是一个概率值,y=1表示正样本,y=0表示负样本。当y是正样本时,如果给定的概率特别小(预测为负样本),损失就会很大;给定的概率很大(预测为正样本),损失就会接近0。损失值的函数如图:

带L2正则项的损失函数:

这个函数依然可以用梯度下降求解。

2.4 多分类问题

刚才讲述的都是二分类的问题,那如果是多分类的问题,又该怎么做呢?其实可以套用二分类的方法,根据特征,一层层细化类别。比如下图中有三种形状:

①:可以先用一个分类器区分“正方形”和“非正方形”,使用一个分类器对三角形与非三角形区分,再使用一个分类器对×进行区分,选择这三个分类器中 概率最高的那个。

②:可以先用一个分类器区分“正方形”和“非正方形”, 再用一个分类器对非正方形区分,得到“三角形”和“非三角形”,然后再用一个分类器区分叉。

3. 工程应用经验

逻辑斯特回归(LR)是个比较基础的算法,在它只会有很多算法SVM/GBDT/RandomForest。复杂的算法比较难以把握,工业界更偏向于用简单的算法。

3.1 LR优点与应用

LR的优点:

1) LR是以概率的形式输出结果,不只是0和1的判定;

2) LR的可解释强,可控性高;

3) 训练快,feature engineering之后效果赞;

4) 因为结果是概率,可以做ranking model;

5) 添加feature简单。

LR的应用场景很多哈:

1) CTR预估、推荐系统的learning to rank;

2) 一些电商搜索排序基线;

3) 一些电商的购物搭配推荐;

4) 新闻app排序基线。

1) 如果样本不均衡,样本充足的情况下可以做下采样——抽样,样本不足的情况下做上采样——对样本少的做重复;

2) 修改损失函数,给不同权重。比如负样本少,就可以给负样本大一点的权重;

3) 采样后的predict结果,用作判定请还原。