前言

运用request模块已经能爬取百分之90的网站了,那么scrapy框架是为了解决那百分之10的网站吗?

答案是否定的。scrapy的目的是为了让爬虫更加的高效,简介

使用

- 导入模块

pip install scrapy

- 创建项目(mySpider是项目名)

scrapy startproject mySpider

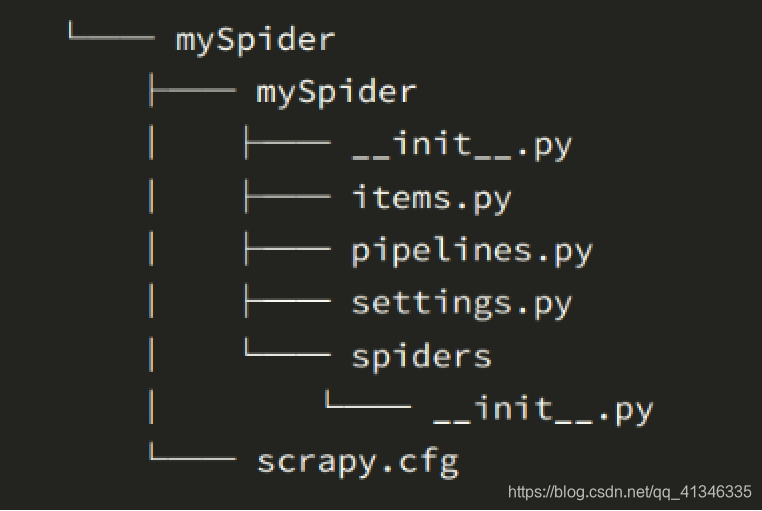

会出现下面的目录

下面来简单介绍一下各个主要文件的作用:

scrapy.cfg :项目的配置文件

mySpider/ :项目的Python模块,将会从这里引用代码

mySpider/items.py :项目的目标文件

mySpider/pipelines.py :项目的管道文件

mySpider/settings.py :项目的设置文件

mySpider/spiders/ :存储爬虫代码目录

- 爬数据

输入命令:

scrapy genspider itcast “itcast.cn”

itcast是爬虫的名字

- 运行

scrapy crawl itcast