4 熵和语言模型评价

4.1 熵

变长编码:给小概率信息赋以较长的编码,给大概率消息赋以较短的编码。

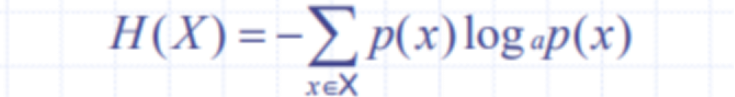

信息论中用熵描述随机变量平均信息量。

H(X)≥0,等号表明确定场(无随机性)的熵最小。

H(X)≤log|X|,等号表明等概场的熵最大。

联合熵:

条件熵:

链式规则:H(X,Y) = H(X) + H(Y|X)

信息量的大小随着消息长度的增加而增加,为了便于比较,一般使用熵率的概念,熵率一般也称为字符熵或词熵。

互信息:根据链式规则,有H(X,Y) = H(X) + H(Y|X) = H(Y) + H(X|Y)。

可以推导出:H(X) - H(X|Y) = H(Y) – H(Y|X)。

H(X)和 H(X|Y) 的差称为互信息,一般记作I(X;Y)。

I(X;Y) 描述了包含在X中的有关Y的信息量,或包含在Y中的有关X的信息量。

I(X;Y)≥0 等号成立当且仅当X和Y相互独立。

I(X;Y) = I(Y;X) 说明互信息是对称的。

在计算语言学中,更为常用的是两个具体事件之间的互信息,一般称之为点间互信息。

事件x, y之间的互信息定义为:I(x,y)=log(p(x,y)/p(x)p(y))

点间互信息度量两个具体事件之间的相关程度。

度

当I(x,y)>>0 时,x和y高度相关。当I(x,y)=0时,x和y高度相互独立。当I(x,y)<<0时,x和y呈互补分布。

此外,还有相对熵,交叉熵。

4.2 语言模型评价

一般而言,交叉熵越小,模型性能会越好。

语言模型的评价也可以计算困惑度。同交叉熵的度量结果没有区别。

噪音信道模型:

W是欲经信道传输的消息,在传输之前,首先进行编码使其适于信道传输,编码后的消息为X,由于信道噪声的存在,在信道末端,人们并不能精确接收到X,而是接收到有噪声在内的编码Y,信道概率p( y|x)描述了编码

x因噪声而变成y的概率,当接收方接到含有噪声的编码后,其任务就变为将Y解码,得到最为可能的消息 。作为通信系统而言,人们最为关心的是如何将消息编码,以便消息在有噪声存在的情况下有效可靠地发送到接收方。

在利用噪声信道处理语言问题时,人们并不关心编码问题,而更多关心的是在有噪声存在的情况下,如何解码将输出还原为信道输入。

噪音信道模型的应用:

1.机器翻译

2.利用信道模型,人们为翻译问题找出了一个整齐的数学描述。

3.词性标注,音字转换,字音转换。