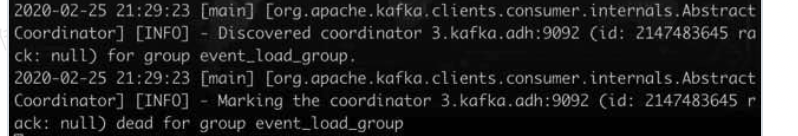

消费kafka数据 日志为info级别时 卡在下图 处不动

调整日志数据级别为debug 发现是连接kafka失败 kafka ip地址确认写的是正确的情况下 发现日志显示 error connection to node

(kafka集群名)。问题是 并没有在代码中写过 kafka节点名字 只写过ip 。

最后发现问题是

java(spark)消费kafka时 消费者 会根据提供的ip 去找到对应的kafka节点 并返回kafka节点名。然后 会根据节点名 去与kafka进行连接 此时 有一个问题是。如果我们的集群本地没有配置hosts (kafka 节点 与节点名的映射关系)会出现 连接不上的情况 与我们没配置 另一台 集群名的和ip对应关系 直接ssh集群名 的效果基本 相同

解决方式是 编辑/etc/hosts 文件 (可能需要sudo 权限) 设置映射名