语言环境

(1)python语言我采用最新的python3.7版本

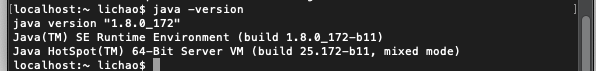

(2)java的环境由于要和后端的队友进行对接,所以商量下选择了 jdk 1.8

开发工具的选择

(1)有关python开发工具,选择pycharm

(2)有关java项目,使用IntelliJ IDEA

依赖管理

(1)java的依赖管理使用了maven,可以一键导入依赖,避免再去下载jar包

(2)python的依赖管理我选择Anaconda进行。

spark的搭建

由于可以需要使用spark进行推荐模型的构建以及计算任务,所以先行搭建需要的spark环境。

查询之下发现,搭建spark需要首先搭建hadoop,以及Scala语言,所以就一起进行了搭建与安装

(1)搭建hadoop

mac下有homebrew这个包管理工具,可以简单实现许多环境的安装搭建

- 首先下载hadoop

brew install hadoop

2.修改配置文件

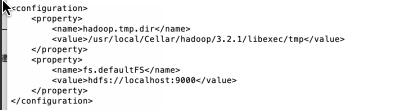

在/usr/local/Cellar/hadoop/3.2.1/libexec/etc/hadoop路径下 修改core-site.xml

hdfs-site.xml

mapred-site.xml

hadoop-env.sh添加java环境变量

修改环境变量

在 ~/.bash_profile 文件中写入

格式化HDFS

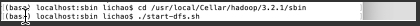

运行hadoop

查询hadoop启动情况

(2)scala安装

brew install scala

scala -version

(3)安装spark

安装完成,接下来开始后续的工作。