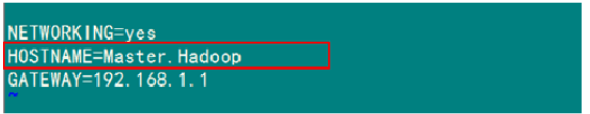

1)修改"/etc/sysconfig/network"文件其中"HOSTNAME"后面的值,改成我们规划的名称。

"/etc/sysconfig/network"的设定项目如下:

NETWORKING 是否利用网络

GATEWAY 默认网关

IPGATEWAYDEV 默认网关的接口名

HOSTNAME 主机名

DOMAIN 域名

2)配置hosts文件(必须)

“/etc/hosts"这个文件是用来配置主机将用的DNS服务器信息,是记载LAN内接续的各主机的对应[HostName和IP]用的。当用户在进行网络连接时,首先查找该文件,寻找对应主机名(或域名)对应的IP地址。

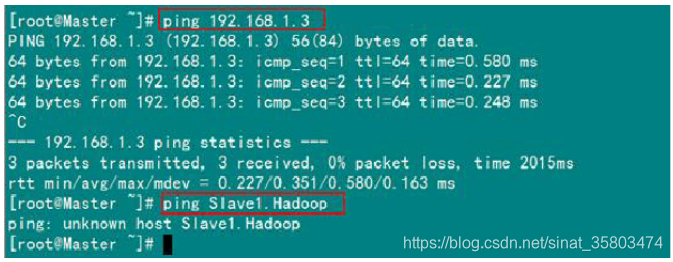

我们要测试两台机器之间知否连通,一般用"ping 机器的IP”,如果想用"ping 机器的主机名"发现找不见该名称的机器,

解决的办法就是修改"/etc/hosts"这个文件,通过把LAN内的各主机的IP地址和HostName的一一对应写入这个文件的时候,就可以解决问题

例如:机器为"Master.Hadoop:192.168.1.2"对机器为"Salve1.Hadoop:192.168.1.3"用命令"ping"记性连接测试。测试结果如下

从上图看到,直接对IP地址进行测试,可以ping的通。但是ping主机名,ping不通,

提示“unknown host”。

因为“Master.Hadoop”的“/etc/hosts”文件里没有192.168.1.3 Slave1.Hadoop"的内容,所以本机器无法对机器的主机名为“Slave1.Hadoop”解析;

在Hadoop集群配置中,需要在“/etc/hosts”文件中添加集群中所有机器的IP与主机名。

这样Master与所有的Slave机器之间不仅可以通过IP进行通信,还可以通过主机名进行通信。所以在所有机器上的“/etc/hosts”文件末尾中都要添加彼此之间的ip地址 主机名

192.168.1.2 Master.Hadoop

192.168.1.3 Slave1.Hadoop

192.168.1.4 Slave2.Hadoop

hadoop中所有机器的/etc/hosts 文件配置都要一样