整体概述

本项目采用两个舵机构成的二自由度的电动云台作为执行机构,控制摄像头在水平和垂直方向的运动。舵机带动摄像头进行二维平面的运动的同时,摄像头进行实时人脸检测,一旦检测到人脸,则进行人脸跟踪。

摄像头采用星瞳openMV H7,主控采用的是正点原子探索者F407开发板。

本文通过openMV和STM32两方面来讲解。

openMV部分

OpenMV摄像头是一款小巧,低功耗,低成本的电路板,它帮助你很轻松的完成机器视觉(machine vision)应用。其使用的是STM32F765VI ARM Cortex M7 处理器,所以其实我们编写openMV的代码从某种程度上来说其实还是往STM32里写代码,唯一不同的是,openMV这部分代码我们要用microPython来写。

在openMV上我们要做的很简单,如果摄像头识别到人脸,用矩形框将人脸框起来,通过串口把矩形框的中心坐标返回到开发板,开发读取坐标后控制舵机执行相应的运动。

所以首先,人脸追踪的基础是摄像头能够进行人脸检测。而openMV已经集成封装好了很多能够调用的库,其中正好就包含人脸检测相关的库和方法,只管调用就是了。(同时,openMV内置了n多个example,我们可以在example的基础上对代码进行修改。本例就是在face_detection的基础上修改实现的。)

模板例程这里就不赘述了,注释都写得很清楚,不了解的可以去看看官方的教程。这里主要讲一下人脸追踪的部分。

其中,我们要知道find_features方法返回一个关于这些特征的边界框矩形元组(x,y,w,h)的列表,若未发现任何特征,则返回一个空白列表。x,y是矩形框左上角的坐标值,w,h分别为矩形框的宽度和高度。那么很容易得到中心坐标(cx = x + w / 2, cy = y + h / 2)

接下来的任务就是将这两个数据通过串口传输到开发板。我们在串口上写了个简单的协议,规定发送数据的格式为:‘X’ + cx + ‘Y’ + cy + ‘OK’(后面讲STM32部分的时候会提到),于是我们这里向串口发送的数据为(‘X%dY%dOK\r\n’ % (cx,cy)),到了STM32部分我们会对接收到的数据进行分析然后把有效数据cx和cy从中提取出来。

具体代码如下:

import sensor, time, image

from pyb import UART

# Reset sensor

sensor.reset()

# Sensor settings

sensor.set_contrast(1)

sensor.set_gainceiling(16)

# HQVGA and GRAYSCALE are the best for face tracking.

sensor.set_framesize(sensor.HQVGA)

sensor.set_pixformat(sensor.GRAYSCALE)

# Load Haar Cascade

face_cascade = image.HaarCascade("frontalface", stages=25)

# OpenMV上P4,P5对应的串口3

uart = UART(3, 115200, timeout_char=1000)

# FPS clock

clock = time.clock()

while (True):

clock.tick()

# Capture snapshot

img = sensor.snapshot()

# Find objects.

objects = img.find_features(face_cascade, threshold=0.75, scale_factor=1.25)

#find_features函数返回一个关于要找的这些feature的边界框矩形元组(x,y,w,h)的列表。

#若未发现任何要找的feature,则返回一个空白列表,即objects是一个元组列表,包含(x,y,w,h)这个元组作为唯一一个元素

# Draw objects

for r in objects:

if(r):

img.draw_rectangle(r,color = (255,0,0))

cx = r[0]+r[2]/2 #计算得到人脸矩形框的中心x坐标

cy = r[1]+r[3]/2 #计算得到人脸矩形框的中心y坐标

print('x:%d, y:%d, w:%d, h:%d' % (r[0],r[1],r[2],r[3]) ) #打印矩形框的x,y,w,h

print('cx = %d, cy = %d' % (cx,cy))

uart.write('X%dY%dOK\r\n' % (cx,cy))

break

else:

#print('cannot find any face!')

uart.write('X-1Y-1OK\r\n')

STM32部分

舵机部分

扫描函数:用两层循环分别控制x方向和y方向的舵机运动,即可实现摄像头的二维运动。一旦识别到人脸,退出扫描函数,进入跟随函数,让摄像头跟随人脸运动,使人脸一直处于画面正中心。

跟随函数:如果识别到人脸,获取人脸在屏幕中的位置,当其距离屏幕正中心超过一定的阈值时,调节相应的舵机,使之向屏幕中心靠拢。如果未识别到人脸,则继续从当前位置开始执行扫描函数。

串口部分

上文提到,openMV捕获到人脸后,不断通过串口向STM32发送数据,所以我们串口函数的目的就是把接收到的数据中的cx和cy提取出来(其余数据丢弃不用),然后把cx和cy和舵机的运动函数联系起来,进而控制摄像头云台执行相应运动实现人脸追踪。

串口的配置过于简单,这里就略过不讲了,主要还是讲解一下如何解析从openMV接收到的格式为’X’ + cx + ‘Y’ + cy + 'OK’的数据并从中提取有效信息cx和xy。

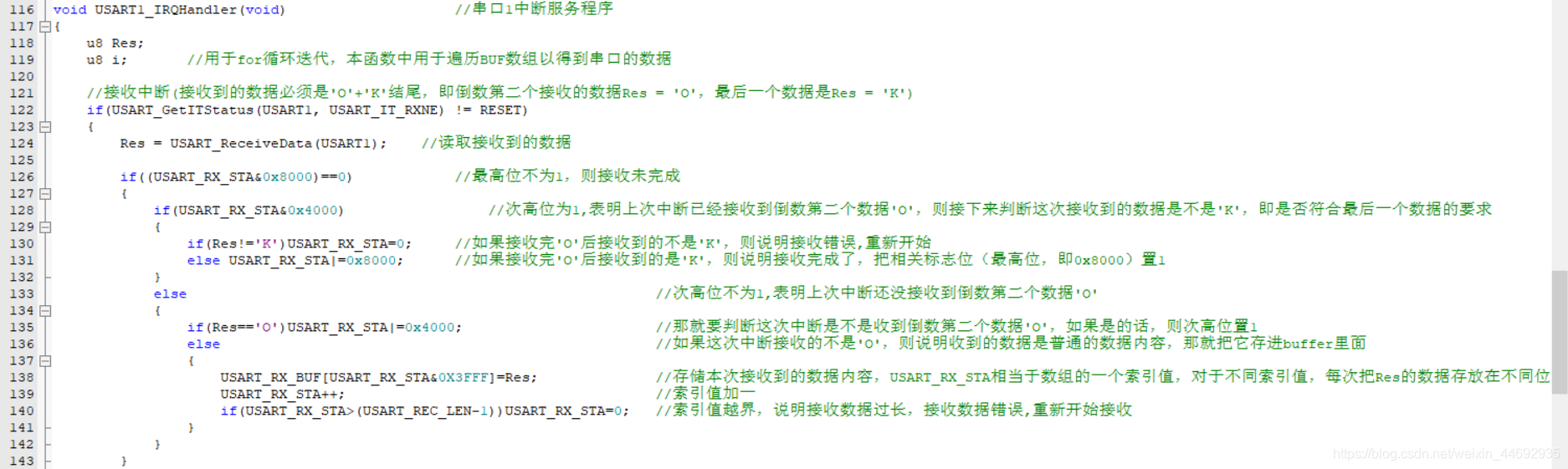

我们提取数据的代码将在正点原子的串口中断函数的基础上进行更改,可以先在我的上一篇博文了解到正点原子串口中断函数的思路:基于STM32F407的串口通信

通过正点原子的例子,我们知道如果我们的数据如果是以‘OK’结尾,会被串口认为有效数据接收,且‘OK’不会作为数据内容存入buffer数组中。

于是,‘X’ + cx + ‘Y’ + cy + 'OK’格式的数据(e.g. X17Y41OK)被STM32的串口有效接收后存放到buffer数组里的数据是X17Y41,那么我们只要通过遍历把XY之间的cx提取出来,把Y之后的cy提取出来,分别存放在两个数组里,就实现了cx和cy的提取。

(如果STM32部分的代码(如舵机控制)也干脆在openMV上写,那么提取数据用Python的正则表达式之类的应该很轻松能做到。不过当然,如果舵机控制部分在openMV上写,那也不会有串口通信和这些带格式的数据了,毕竟数据不需要通过串口从两个设备之间传输了。当然这是后话了,以后尝试只用openMV实现)

显然,我们是在数据接收完成后(即USART_RX_STA&0x8000==1)进行的进一步操作,于是我们在if((USART_RX_STA&0x8000)==0)后紧跟else if语句,条件为(USART_RX_STA&0x8000),表明接收完成,开始分析数据。

思路前面已经大致提到了,我们先建立两个buffer数组分别用于存放cx和cy的数据。然后按字节遍历整个接收数据,当识别到当前字节的数据为‘X’时,将之后出现的数据存放到cx数组中,当识别到当前字节的数据为‘Y’时,将之后出现的数据存放到cy数组中。最后,由于串口接收到的是char型数据,我们再通过atoi()函数将char型转化成int型的数据即可。

以上就是人脸追踪的大致思路了,写得有点复杂,其实代码还可以较大程度的优化,以后有时间再改了。

具体代码见:完整代码