四 HDFS环境搭建

1.jdk的安装(装java)

-

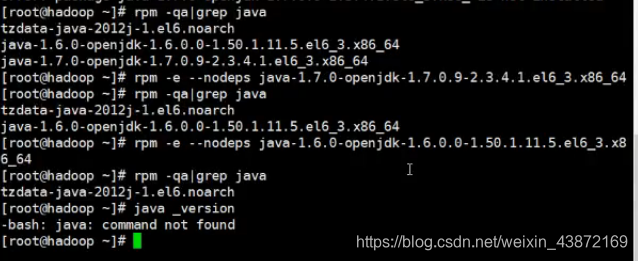

检查自带jdk,有就卸载

找jdk:rpm -qa|grep java

切换命令 :su -root

删除jdk:rpm -e --nodeps 名字

-

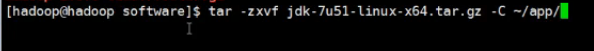

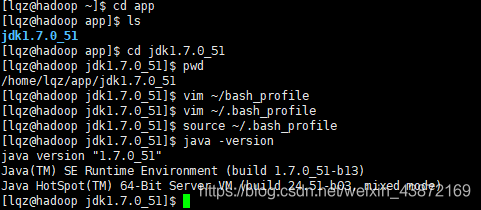

安装jdk

解压: tar -zxvf jdk名字 ~C 解压的位置

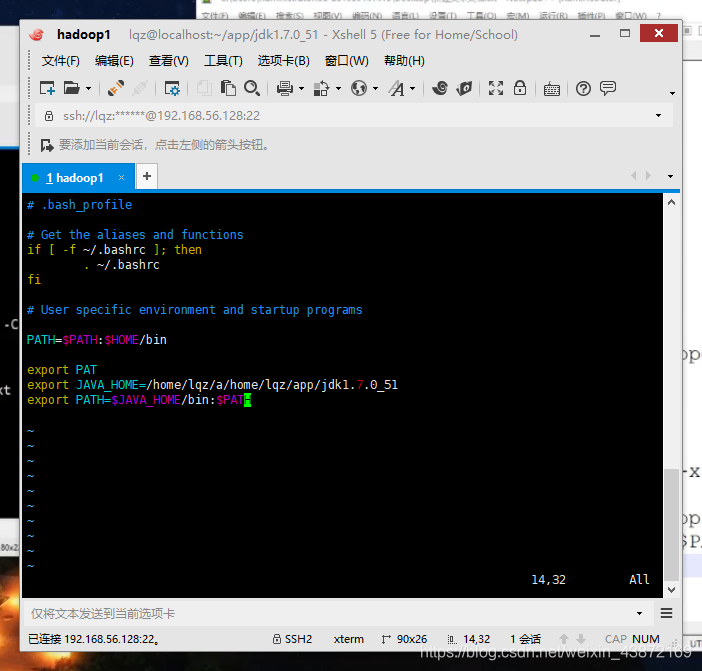

配置环境变量:vim ~/.bash_profile

配置完重启这个文件使配置文件生效:source ~/.bash_profile

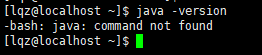

检验下:java -version

2 安装SSH(实现免密登录)

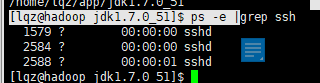

检测有没有ssh:ps -e | grep ssh

-

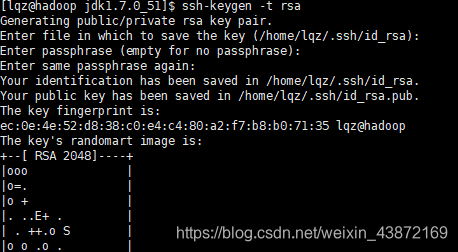

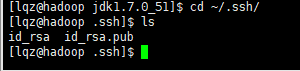

生成密钥:ssh-keygen -t rsa

(rsa是公钥)

pub是公钥 -

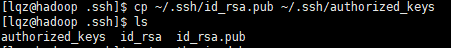

生成的密钥拷贝到特定的文件夹下

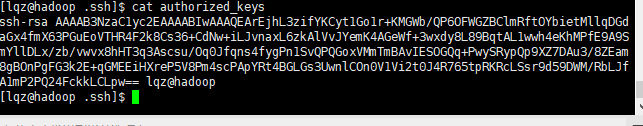

密钥如下:

-

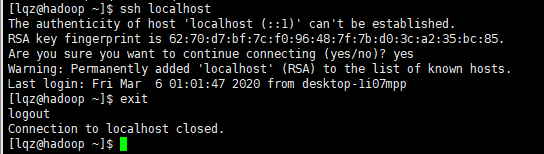

测试下连通性:ssh 主机名/ip地址

连接本地,然后exit退出

ifconfig可以查出ip地址,用ssh localhost和ssh ip地址一样

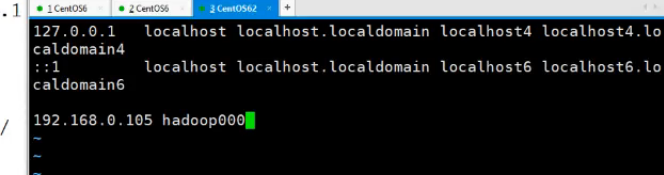

修改地址和主机名的映射:vim /etc/hosts

(用root用户)

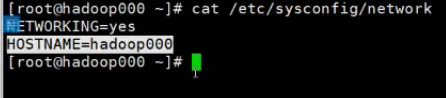

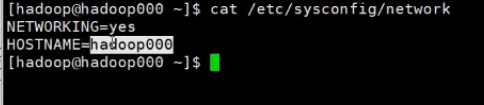

查看修改主机名:

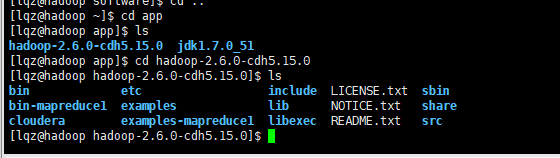

3.安装HDFS(hadoop)

-

解压 和上面一样tar -zxvf hadoop名字 ~C 解压的位置

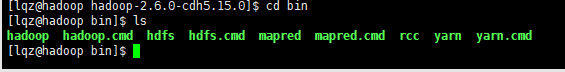

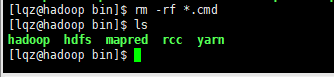

bin里面装的客户端命令集

cmd是windows系统用的

可以删掉cmd

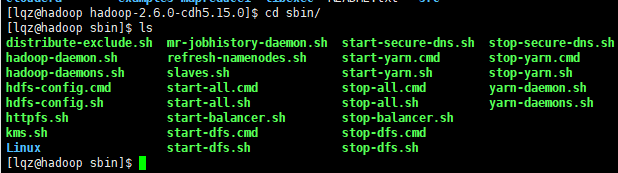

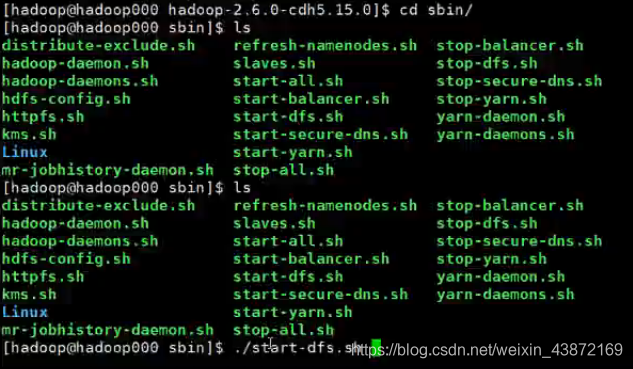

sbin是HDFS系统的命令

hadoop的配置文件

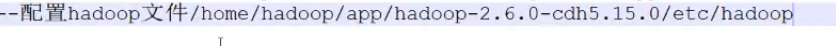

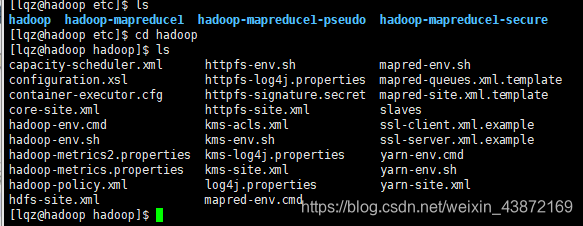

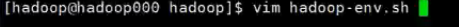

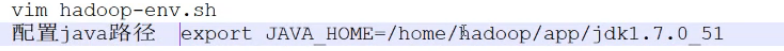

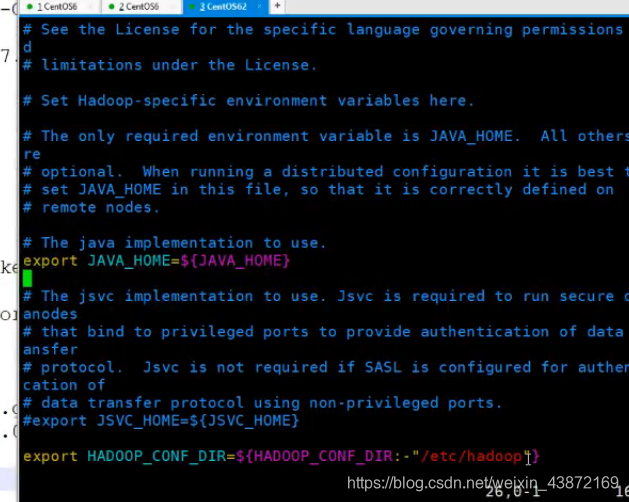

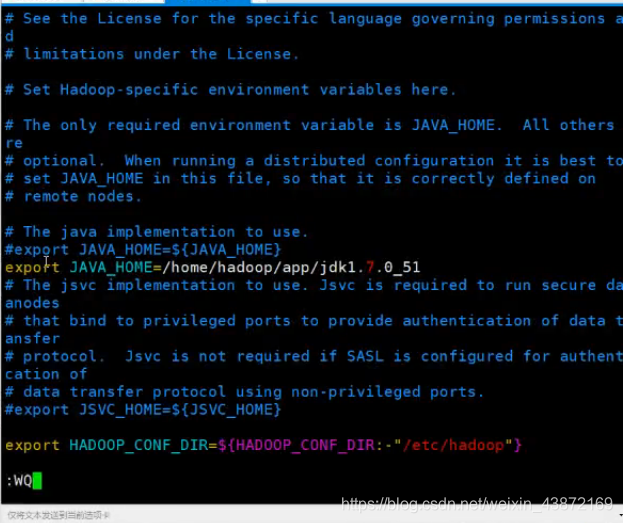

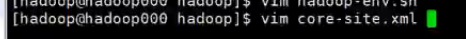

- 配置hadoop文件

三个文件

第一个

原来的文件如下

更改为:追加一个java文件变量

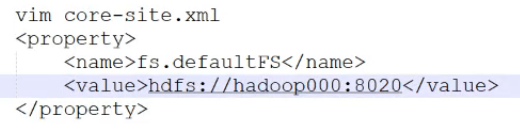

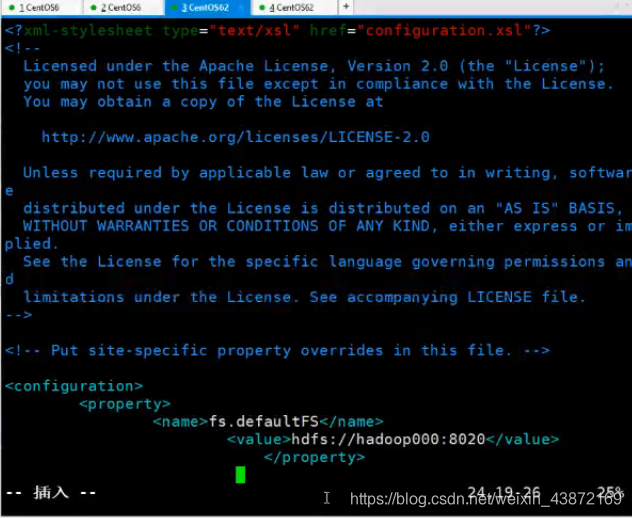

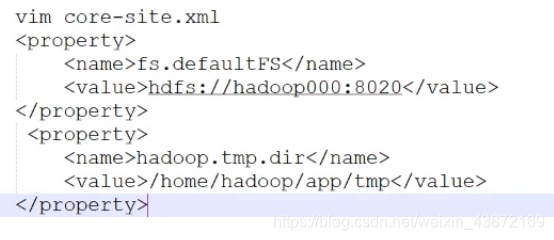

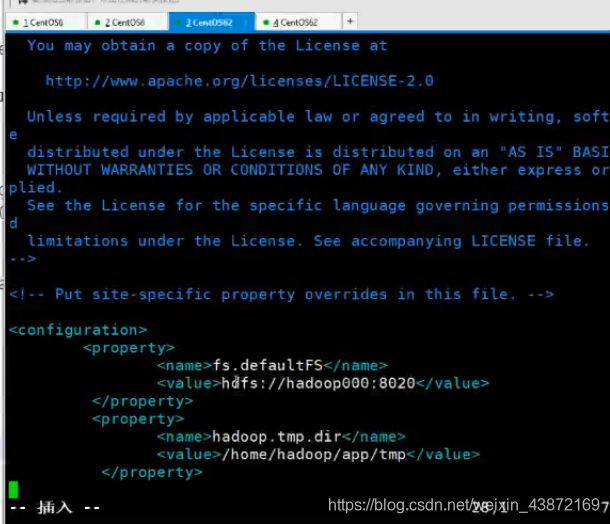

第二个:core-site

查找主机名

8020前面是主机名

配置个临时文件夹存放hdfs的,在第二个上面(官网上有)

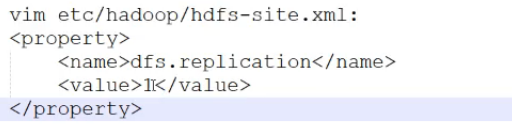

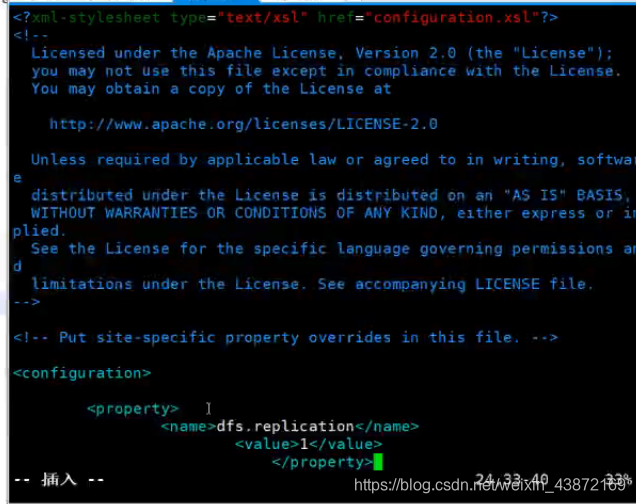

第三个:系统中的一些配置

只有1个副本,一个节点

第四个 localhost变成本机名

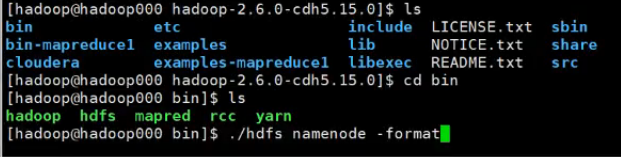

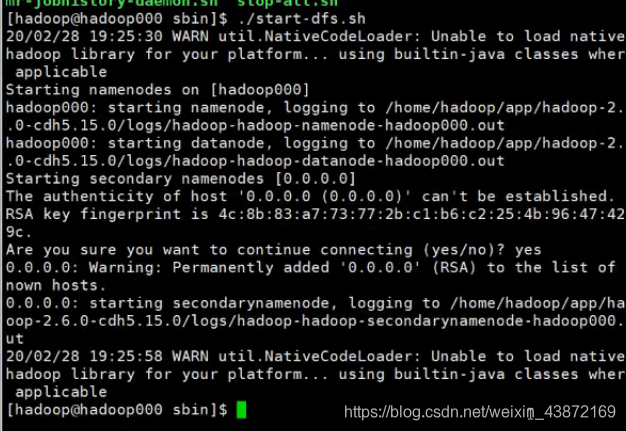

4.启动hdfs

格式换系统(仅第一次执行)

之前tmp没有文件。格式化后就有了tmp下有dfs

bin目录下 ./hdfs namenode -format

启动hdfs命令

在sbin下启动 ./start-dfs.sh

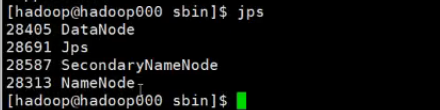

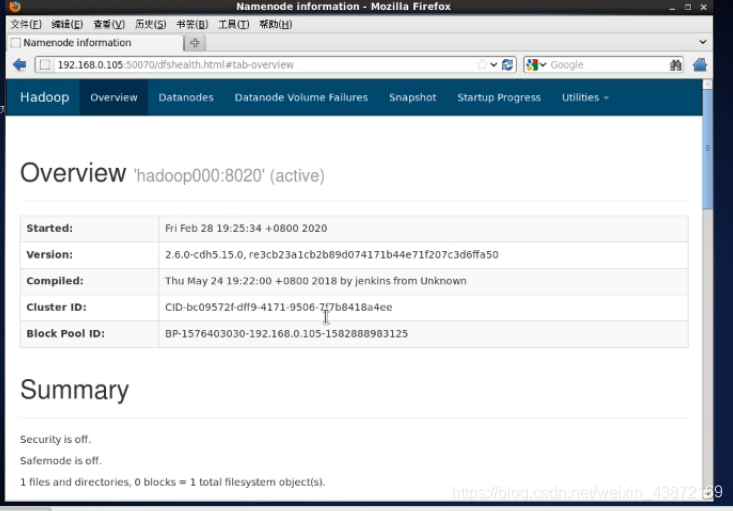

验证命令

1.jps

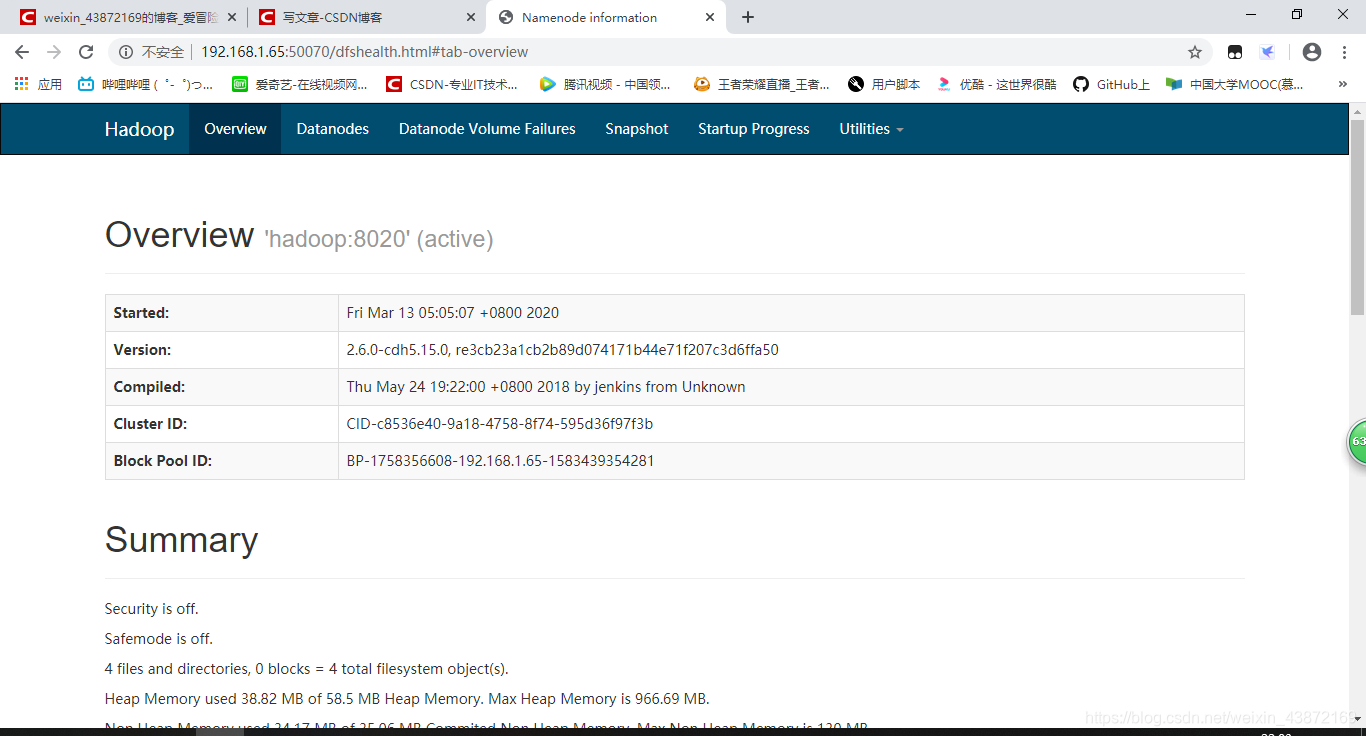

2.网站验证

在虚拟机里的网页看

ip:50070

在本机电脑看,

1要关闭防火墙chkconfig iptables off

2要关闭防火墙服务service iptables stop