来源:微信公众号 - DD程序鹅

原文:https://mp.weixin.qq.com/s/SPzNk6wi_y4gcs91ClPMxw

版权声明:本文为博主原创文章,转载请附上原文链接!

更多系列可以搜索上面公众号,提前查阅。

说到ETL相信大家都不陌生,也就是数据的提取、转换和加载功能,相信小伙伴在工作中都有做过或者使用过ETL工具。

该篇介绍的ETL工具可能有的小伙伴在数据同步、数据迁移、数据清洗等时已经使用过,它就是Kettle。

ETL也是初入大数据领域必备技能。

ETL工具

Kettle使用突破性的元数据驱动方法提供强大的提取、转换和加载(ETL)功能。

可运行在Window、Linux、Unix上。

Kettle是个ETL工具集,管理不同数据库的数据,提供一个可视化的开发工具。

Kettle有两种脚本文件,Transformation和Job。

Transformation:用于完成针对数据的基础转换。

Job:用于完成整个工作流的控制。

Kettle更名为PDI(Pentaho Data Integration)Pentaho数据集成。

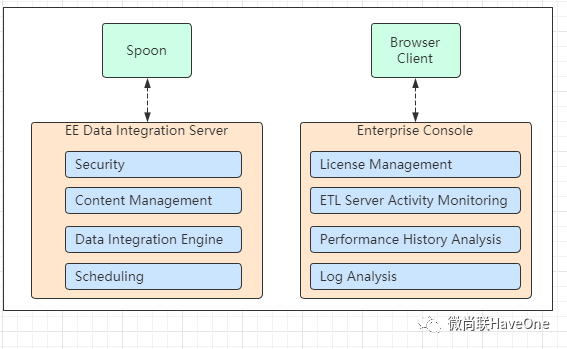

Kettle结构

Spoon是构建ETL Jobs和Transformations的工具。Spoon以拖拽的方式图形化设计,能够通过spoon调用专用的数据集成引擎或者集群。

Data Integration Server是一个专用的ETL Server,主要功能有:

1、执行:通过PDI引擎执行ETL的作业或转换。

2、安全性:管理用户、角色或集成的安全性。

3、内容管理:提供一个集中的资源库,用来管理ETL的作业和转换,资源库包含所有内容和特征的历史版本。

4、时序安排:在spoon设计者环境中提供管理Data Integration Server上的活动的时序和监控的服务。

Enterprise Console(企业控制台)提供了一个小型的客户端,用于管理Pentaho Data Integration企业版的部署。

包含企业版本的证书管理、监控和控制远程Pentaho Data Integration服务器上的活动、分析已登记的作业和转换的动态绩效。

Kettle核心组件

Spoon:通过图形接口,用于编辑作业和转换的桌面应用。

Pan:一个独立的命令程序,用于执行由Spoon编辑的转换和作业。

Kitchen:一个独立的命令程序,用于执行由Spoon编辑的作业。

Carte:Carte是一个轻量级的Web容器,用于建立专用、远程的ETL Server(分布式集群)。

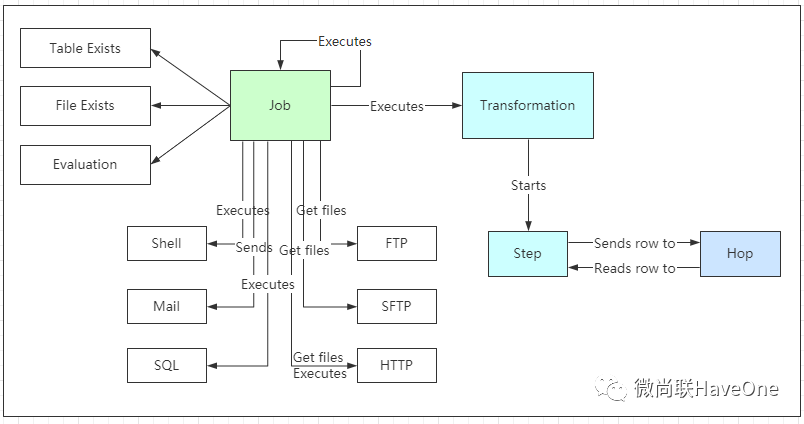

Kettle概念模型

Kettle的执行分为两个层次:Job(作业)和Transformation(转换)。

往期精彩回顾