一、逻辑回归

(1)定义与使用场景

逻辑回归(Logistic Regression)是机器学习中的一种分类模型,逻辑回归是一种分类算法,虽然名字中带有回归。由于算法的简单和高效,在实际中应用非常广泛。

应用场景举例:

- 是否为垃圾邮件

- 是否患病

- 金融诈骗

- 虚假账号

看到上面的例子,我们可以发现其中的特点,那就是都属于两个类别之间的判断。逻辑回归就是解决二分类问题的一种方法。

(2)逻辑回归的输入与输出

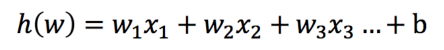

逻辑回归的输入其实就先线性回归的输出,可以简单的理解 h(w)就是逻辑回归的输入。

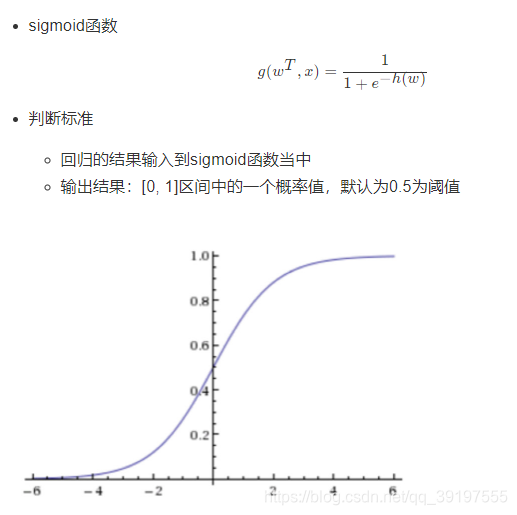

有了输入如何进行判断输出的类型呢?此时就需要使用激活函数。将h(w)送入sigmoid函数里面会得到一个取值在[0,1]范围内的概率值。通常去0.5为阈值,大于0.5的预测结果为正例,小于0.5的为反例。

(3)损失计算

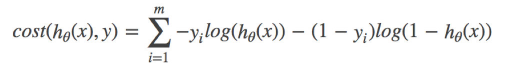

逻辑回归的损失,称之为对数似然损失,公式如下:

![]()

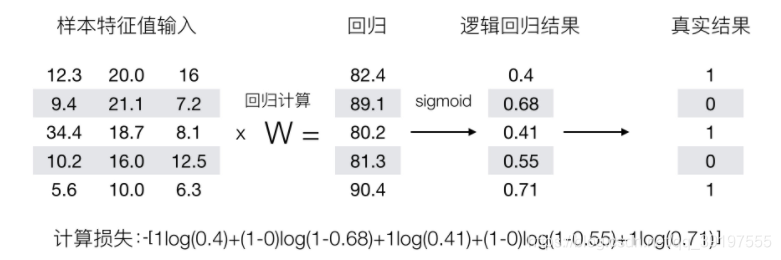

从 -log 函数的图像可以看出

- 当真实值为1,预测值(也就是经过sigmoid激活函数后得到的概率值)越接近1的时候损失越小

- 当真实值为0,预测值越接近0的时候损失越小

损失计算示例:

(4)sklearn逻辑回归API

sklearn.linear_model.LogisticRegression(solver='liblinear', penalty=‘l2’, C = 1.0)

-

solver可选参数:{'liblinear', 'sag', 'saga','newton-cg', 'lbfgs'},

- 默认: 'liblinear';用于优化问题的算法。

-

对于小数据集来说,“liblinear”是个不错的选择,而“sag”和'saga'对于大型数据集会更快。

-

对于多类问题,只有'newton-cg', 'sag', 'saga'和'lbfgs'可以处理多项损失;“liblinear”仅限于“one-versus-rest”分类。

-

penalty:正则化的种类

-

C:正则化力度

官方API:

注意:LogisticRegression方法相当于 SGDClassifier(loss="log", penalty=" "),SGDClassifier实现了一个普通的随机梯度下降学习。

二、肿瘤预测案例

import pandas as pd

import numpy as np

from sklearn.model_selection import train_test_split

from sklearn.preprocessing import StandardScaler

from sklearn.linear_model import LogisticRegression, SGDClassifier

# 不进行ssl验证

import ssl

ssl._create_default_https_context = ssl._create_unverified_context

"""

1.获取数据

2.基本数据处理

2.1 缺失值处理

2.2 确定特征值,目标值

2.3 分割数据

3.特征工程(标准化)

4.机器学习(逻辑回归)

5.模型评估

"""

# 1.获取数据

names = ['Sample code number', 'Clump Thickness', 'Uniformity of Cell Size', 'Uniformity of Cell Shape',

'Marginal Adhesion', 'Single Epithelial Cell Size', 'Bare Nuclei', 'Bland Chromatin',

'Normal Nucleoli', 'Mitoses', 'Class']

data = pd.read_csv("https://archive.ics.uci.edu/ml/machine-learning-databases/breast-cancer-wisconsin/breast-cancer-wisconsin.data",

names=names)

# 2.基本数据处理

# 2.1 缺失值处理

data = data.replace("?",np.nan)

data = data.dropna()

# 2.2 确定特征值,目标值

x = data.iloc[:, 1:10]

# y = data.iloc[:, 10:10]

# print(type(y))

# 或者

y = data["Class"]

print(type(y))

# 2.3 分割数据

x_train, x_test, y_train, y_test = train_test_split(x, y, random_state=22, test_size=0.2)

# 3.特征工程(标准化)

transfor = StandardScaler()

x_train = transfor.fit_transform(x_train)

x_test = transfor.transform(x_test)

# 4.机器学习(逻辑回归)

estimator = LogisticRegression(max_iter=10000, n_jobs=-1,)

estimator.fit(x_train, y_train)

# 5.模型评估

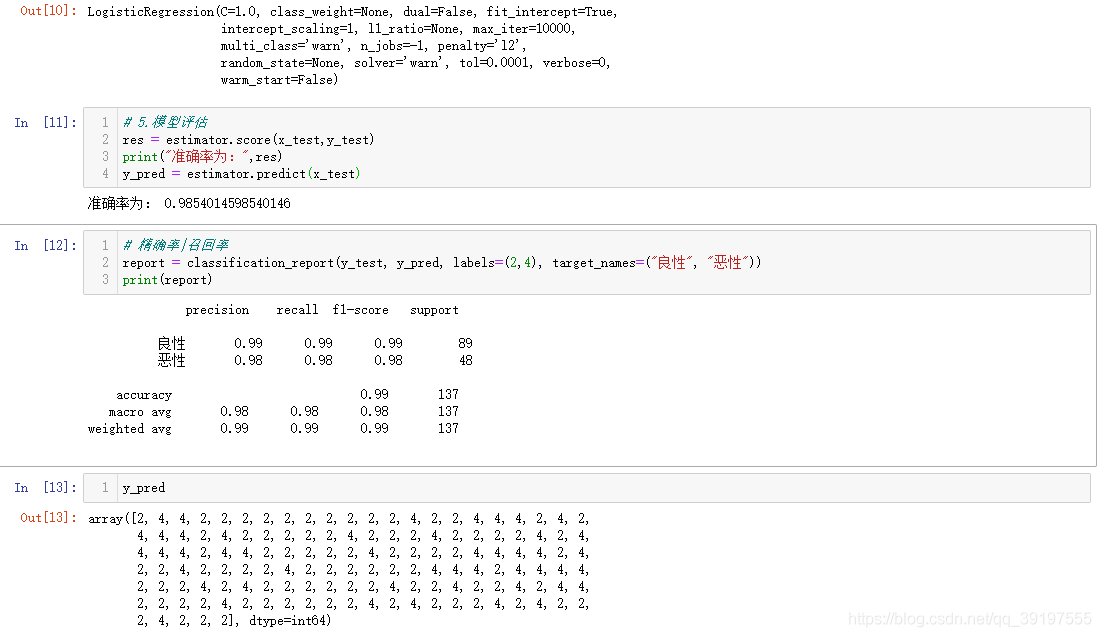

res = estimator.score(x_test,y_test)

print("准确率为:",res)

y_pred = estimator.predict(x_test)

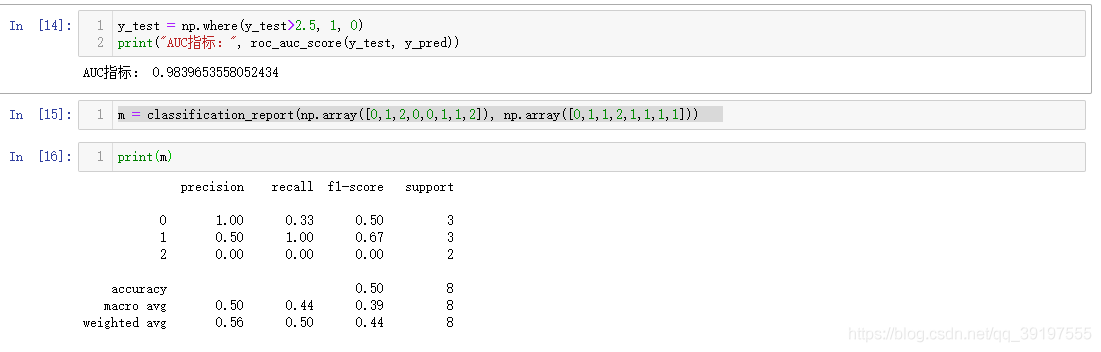

# 精确率|召回率

report = classification_report(y_test, y_pred)

print(report)

y_test = np.where(y_test>2.5, 1, 0)

print("AUC指标:", roc_auc_score(y_test, y_pred))