概述

负载均衡(Load Balance,简称LB)是一种服务器或网络设备的集群技术。负载均衡将特定的业务(网络服务、网络流量等)分担给多个服务器或网络设备,从而提高了业务处理能力,保证了业务的高可用性。负载均衡基本概念有:实服务、实服务组、虚服务、调度算法、持续性等,其常用应用场景主要是服务器负载均衡,链路负载均衡。

一、什么是负载均衡?

我们从一个实际的工作需求开始讲述负载均衡器吧。有一天,领导给你分配一个需求,你兴高采烈地去写代码,当写到一半时发现要依赖另一个模块,而另一个模块是部署在两台机器上,这时如何把你的请求合理地分配到这两台机器上呢?这时可以引入负载均衡器技术来调度请求流量。

负载均衡(Load Balance)的意思是将大量作业合理地分摊到多个操作单元上进行执行。主要用于解决互联网架构中的高并发和高可用的问题。

二、有哪些负载均衡技术?

负载均衡器主要分为硬件负载均衡和软件负载均衡两大类。

2.1 硬件负载均衡技术

直接在服务器和外部网络间安装负载均衡设备,这种设备我们通常称之为负载均衡器。由于专门的设备完成专门的任务,独立于操作系统,整体性能得到大量提高,加上多样化的负载均衡策略,智能化的流量管理,可达到最佳的负载均衡需求。 一般而言,硬件负载均衡在功能、性能上优于软件方式,不过成本昂贵,比如最常见的就是F5负载均衡器。

优点: 能够直接通过智能交换机实现,处理能力更强,而且与系统无关,负载性能强

缺点:成本高,除设备价格高昂,而且配置冗余.很难想象后面服务器做一个集群,但最关键的负载均衡设备却是单点配置;无法有效掌握服务器及应用状态。只是从网络层面来判断负载情况,有时网络负载正常的情况下,应用层可能已经堵塞了。

2.2 软件负载均衡技术

在互联网架构设计中,应用率比较高的是软件负载均衡技术。软件负载均衡技术是基于系统与应用的负载均衡技术,能够更好地根据系统与应用的状况来分配负载情况。主流的软件负载均衡器有LVS、Nginx和HAproxy。

优点:复杂应用下,软件负载均衡能够根据系统与应用情况来分配业务负载,效率很高。性价比很高,对于一些只需要几台服务器就能支撑的业务,使用软件负载均衡技术更加合适。

缺点:负载能力受服务器本身性能的影响,性能越好,负载能力越大。

LVS:内核态转发型的高可用工具,是一种基于传输层的负载均衡器,主要原理就是对网络数据报文做些更改,然后进行转发,支持的状态检测方法也比较完善,有端口检测,url检测和自定义脚本检测。 抗负载能力强,性能高,稳定性高,可靠性高,自身有完美的热备方案(Keepalived+lvs)。

Nginx:工作在网络层和应用层,主流的反向代理软件,可以通过代理的功能实现负载均衡的功能,本身功能比较完善,既可以做静态站点,缓存又可以做负载均衡器,配置上可以优化的地方很多,有端口检测和url的检测,但是检测的方式是被动式的,会对用户的访问造成一定的影响。

HAproxy:工作在TCP层和HTTP层,支持虚拟机,支持Session的保持,Cookie的引导,同时支持通过获取指定的url来检测后端服务器的状态。单纯从效率上来看,优于Nginx。

三、常用负载均衡算法?

具体的负载均衡算法通常有以下几种:

轮询(Round Robin,RR)

所有请求被一次分发到每台应用服务器上,即每台服务器需要处理的请求数目都相同,适合于素有服务器硬件都相同的场景。

加权轮询(Weighted Round Robin,WRR)

根据应用服务器硬件性能的 情况,在 轮询的基础上,按照配置的权重将请求分发到每个服务器,高性能的服务器能分配更多请求。

随机(Random)

请求被随机分配到各个应用服务器,在 许多场合下,这种方案都很简单实用,因为好的随机数本身就很均衡。即使应用服务器硬件配置不同,也可以使用加权随机算法。

最少连接(Least Connections)

记录每个应用服务器正在处理额连接数(请求数),将新到的请求分发到最少连接的服务器上,应该说,这是最符合负载均衡定义的算法。同样,最少连接算法也可以实现加权最少连接。

源地址散列(Source hashing)

根据请求来源的IP地址进行Hash计算,得到应用服务器,这样来自同一个IP地址的请求总在同一个服务器上处理,该请求的上下文信息可以存储在这台服务器上,在一个会话周期内重复使用,从而实现会话黏滞。

四、负载均衡器在互联网架构中应用

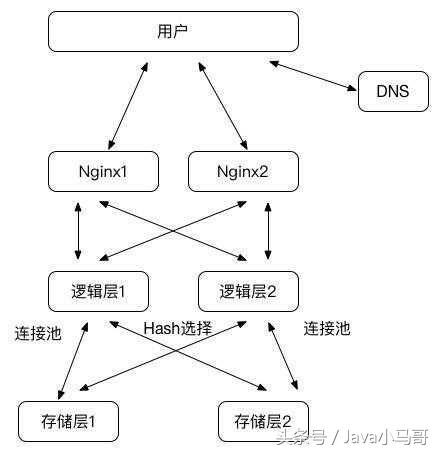

互联网架构对负载均衡器应用主要采用的是软件负载均衡技术。下面以经典三层架构模型来说明负载均衡技术的应用和选型。

1)用户请求选择接入层(Nginx)是通过DNS轮询来实现的,DNS会通过轮询算法返回一个Nginx进行负载均衡。

2)用户请求到达接入层(Nginx)后,Nginx通过权重算法或者随机算法选择逻辑层的一个节点转发请求。

3)用户请求到过逻辑层后,逻辑层通过与存储层的所有节点建立连接池,或者保存所有存储层节点的地址信息,因为数据的存储是固定在一个节点上的,所以要求同一个用户的请求能够路由到同一个存储节点上去。最简单的负载均衡实现可以依据用户账号进行HASH选择。

总结

到这里,负载均衡原理与实现方案就结束了,不足之处还望大家多多包涵!!觉得收获的话可以点个关注收藏转发一波喔,谢谢大佬们支持。(吹一波,233~~)

下面和大家交流几点编程的经验:

1、多写多敲代码,好的代码与扎实的基础知识一定是实践出来的

2丶 测试、测试再测试,如果你不彻底测试自己的代码,那恐怕你开发的就不只是代码,可能还会声名狼藉。

3丶 简化编程,加快速度,代码风骚,在你完成编码后,应回头并且优化它。从长远来看,这里或那里一些的改进,会让后来的支持人员更加轻松。