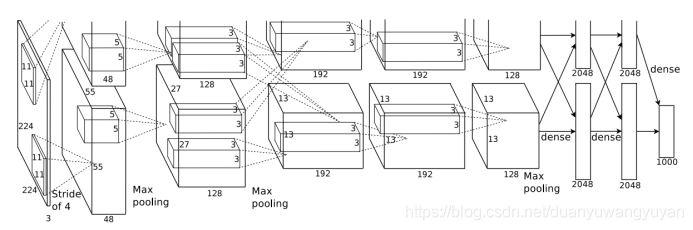

AlexNet与LeNet相比,具有更深的网络结构,包含5层卷积和3层全连接,同时使用了如下三种方法改进模型的训练过程:

-

数据增广:深度学习中常用的一种处理方式,通过对训练随机加一些变化,比如平移、缩放、裁剪、旋转、翻转或者增减亮度等,产生一系列跟原始图片相似但又不完全相同的样本,从而扩大训练数据集。通过这种方式,可以随机改变训练样本,避免模型过度依赖于某些属性,能从一定程度上抑制过拟合。

-

使用Dropout抑制过拟合。

-

使用ReLU激活函数减少梯度消失现象。

1)中心思想

consists of five convolutional layers, some of which are followed by max-pooling layers,and three fully-connected layers with a final 1000-way softmax。Dropout method reduce overfitting in the fully-connected layers。LRN层放在第一个和第二个卷积层后,最大池化层放在了两个LRN层后以及最后一个卷积层后。Relu激活函数则用在了这8层的每一层后面。

2)模型结构

3)Local Response Normalization

提出了LRN(Local Response Normalization局部响应归一化)层,对局部神经元的活动创建竞争机制,使得其中响应比较大的值变得相对更大,并抑制其他反馈较小的神经元,增强了模型的泛化能力。

where the sum runs over n “adjacent” kernel maps at the same spatial position, and N is the total

number of kernels in the layer.

备注:后来很多学者,证实这个LRN其实没起多大作用。

Tensorflow 接口实现: