点击下方卡片,关注“CVer”公众号

AI/CV重磅干货,第一时间送达

点击进入—> CV 微信技术交流群

本文分享ECCV 2022论文 『 Learning with Recoverable Forgetting 』,实现知识在深度模型上的便捷存取。新加坡国立大学 LV lab 提出全新可恢复型模型遗忘框架!代码已开源!

详细信息如下:

论文:https://arxiv.org/abs/2207.08224

代码:https://github.com/JngwenYe/LIRF

在2022年高分美剧《Severance》中,反派公司研究出一项新技术,通过将芯片植入员工的大脑,进行大脑的记忆控制。一旦员工进入公司,芯片将大脑中关于公司外的记忆暂存,而到了下班时间,芯片恢复该部分的记忆,转而暂存员工在工作时的记忆。该剧被戏称为职场惊悚剧,虽然走的是科幻路线,看似是很超前的剧情设定,但其中的核心技术在本文中已被实现!

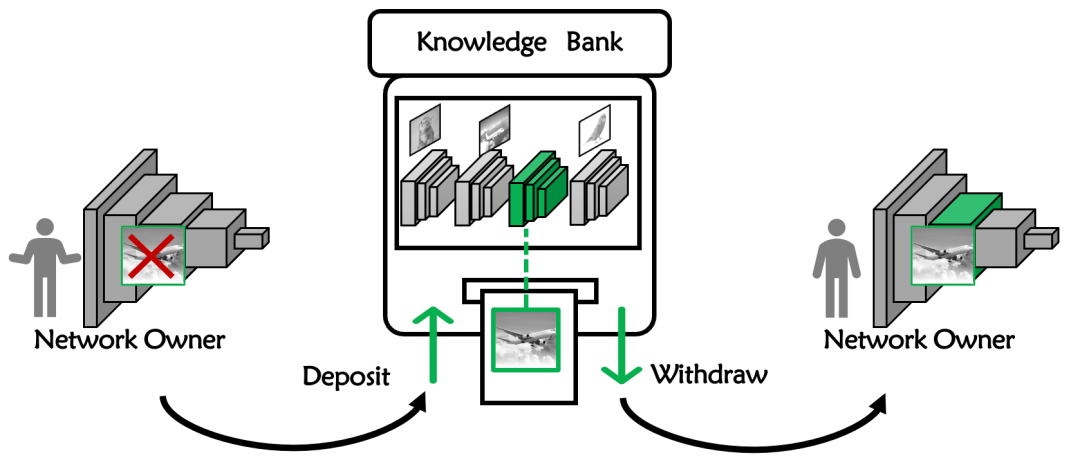

本文研究的为在神经网络上的知识灵活存取。网络中的部分知识可以代由“知识银行”进行暂存,待到需要时,该部分知识又可被便捷地取出,重新在网络上运作。这种知识可存可取性极大地扩宽了终身学习领域,在确保用户自由度的同时也起到了知识保护的目的。

- 01 - 摘要

终身学习旨在学习一系列新的任务的同时保留先前获得的知识。然而,由于数据隐私或版权问题,训练数据并不是终身合法的,这时需要诱导模型选择性失忆。

例如在实际场景中,根据模型具体部署的需求,模型所有者可能希望启用或禁用特定任务或特定敏感数据的知识。因此这时需要对模型所学到的知识进行灵活控制,包括删除暂时不需要的部分知识,以及恢复重获使用权的知识。

在本文中,作者探索了一种新颖的学习模式,称为可恢复型遗忘学习(Learning wIth Recoverable Forgetting,LIRF),用于显式处理特定任务或敏感样本知识删除和恢复。

具体地,LIRF定义了两个知识层面的任务,即知识存储和恢复:

在知识存储阶段,LIRF从目标网络中提取指定的知识并保留在存款模块中;

在知识恢复阶段,LIRF直接调取存储模块中的知识进行恢复。

训练整个LIRF框架只需要用敏感数据在原始网络上微调少量 epoch。大量实验表明 LIRF 在同时具备数据和计算高效性的同时,也能完全满足文章中定义的知识存取需求。无需任何网络微调操作即可直接恢复已存储的知识,且恢复后的网络性能相较于原始网络提升1%~5% 的准确率。

- 02 - 定义

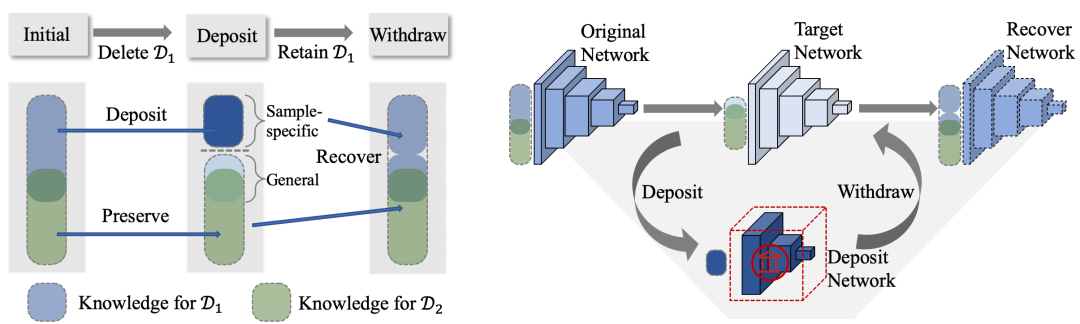

知识的存取任务的定义如下图所示, 表示包含敏感数据的完整数据集,直接在 上训练的原始网络表示为 。将原始数据集 划分为存储集和保留集,其中,存储集 的知识在目标网络 中被删除,并保留在存储模块 中;保留集 为 的补集。

因此 LIRF 所涉及的知识存储和恢复任务可以被定义为:

402 Payment Required

定义一 【存储任务 Deposit】:输出两个模型,一为目标网络 ,对于保留集中的数据 , 目标网络将输入 映射到其正确的类别标签 ,对于存储集中的数据 ,目标网络将输入 映射到错误的类别标签;二为存储模块 ,用于存储集合 的知识。

限制条件:只有原始网络 和存储集 可供使用。

定义二 【恢复任务 Withdraw】:输出复原网络 。对于所有数据 ,复原网络将输入 映射到其正确的类标签 。

限制条件:只有目标网络 和存款模块 可供使用。

- 03 - 方法

3.1. 目标网络知识滤除

在知识存储阶段,需要去除目标网络中存储集 的知识,同时保持保留集 上的性能。

首先,作者将原始网络 在第 个模块处分为浅层模块 和 深层模块 ,在目标网络上也进行相同的划分:。依据该划分策略,作者将原始网络的深层模块完全迁移至目标网络的深层模块中,即 。因此,接下来只需要进行从 到 的部分迁移操作。

Sample-specific 知识去除:该部分需要在两个层面对 Sample-specific 知识进行去除。一是目标网络无法对存储集 做出正确的类别标签预测;二是存储集 的知识无法从目标网络 中蒸馏得。

对于每个存储集的输入 ,作者对其分配一个随机标签 ,以该随机标签微调目标网络 ,使得目标网络在存储集上做出错误预测结构。于此同时,作者最大化了目标网络和原始网络浅层模块中间特征的注意力图,用以消除该部分知识的可蒸馏性。该部分损失表示为:

General 知识保留:目标网络需要保留两部分知识。一是保留集 的所有知识,用于维持目标网络在保留集上的性能;二是来自 的一般性知识,通过保留部分不会泄漏存储集隐私的一般知识,提升目标网络在保留集上的性能。

由于目标网络 由原始网络初始化得,并且目标网络 的深层模块在微调时保持参数固定,因此部分知识已完成从 到 的迁移。除此之外,作者提出了基于过滤器 的知识迁移,以阻止在保留集 上的灾难性遗忘,即:

402 Payment Required

公式中,过滤器 起到选择保留集对应的类别标签的 logits 的效果。

3.2. 存储模块知识存储

一个合格的存储模块应具备两个重要性质:首先为易恢复性,恢复存储模块中的知识不需要额外的计算开销;其次为易存储性,需设计小规模的存储模块以节省存储空间。

为了减小存储模块的参数规模,作者使用剪枝后的原始网络用以初始化存储模块 。此外,作者使用基于过滤器 的损失函数 进行部分知识转移:

402 Payment Required

公式中,过滤器 起到选择存储集对应的类别标签的 logits 的效果。

通过最小化损失 ,可以将特定样本的知识转移到存储模块。同时为了确保存储的知识易于后续的恢复操作,作者进一步微调存储模块 ,使其 easy-to-withdraw。微调的目的为确保在复原网络上 ,知识是可恢复的。因此,在进行知识存储的同时,作者提前考虑其在复原网络 上的可恢复性。具体来说,这里额外引入了与复原网络相关的损失项:

值得注意的是,得到的存储模块只用于知识的存储,并不能用作独立的预测模型。因此,敏感知识存储在 中比保留原始图像更为安全。

3.3. 复原网络知识恢复

经由之前的两个操作可实现知识的便捷存取。因此恢复知识至复原网络时,知识可以直接使用,无需任何网络参数微调以及任何训练数据。

具体来说,复原网络的组织形式可被表示为:

过滤函数 和 的定义在之前已被给出。因此训练 LIRF 的损失函数可以表示为各损失项的加权相加:

训练 LIRF 全程只需要在存储集 上进行网络微调,保留集 并不参与网络更新。

值得注意的是,虽然 LIRF 中的目标网络进行了部分数据遗忘,但其优化目标与 machine unlearning 不同。machine unlearning 旨在获得一个与使用数据 重新训练结果一致的目标网络。而在 LIRF 中,目标网络的知识容量大于仅使用 训练的网络,因为它包含存储集 的一般性知识(只有与隐私相关的敏感知识保留在存储模块中)。在知识恢复阶段,复原网络 不会被强制逼近原网络:。实际上,由于 LIRF 中包含多种知识迁移形式,复原网络的性能相较于原始网络有进一步的性能提升。

- 04 - 实验

4.1. 评价指标

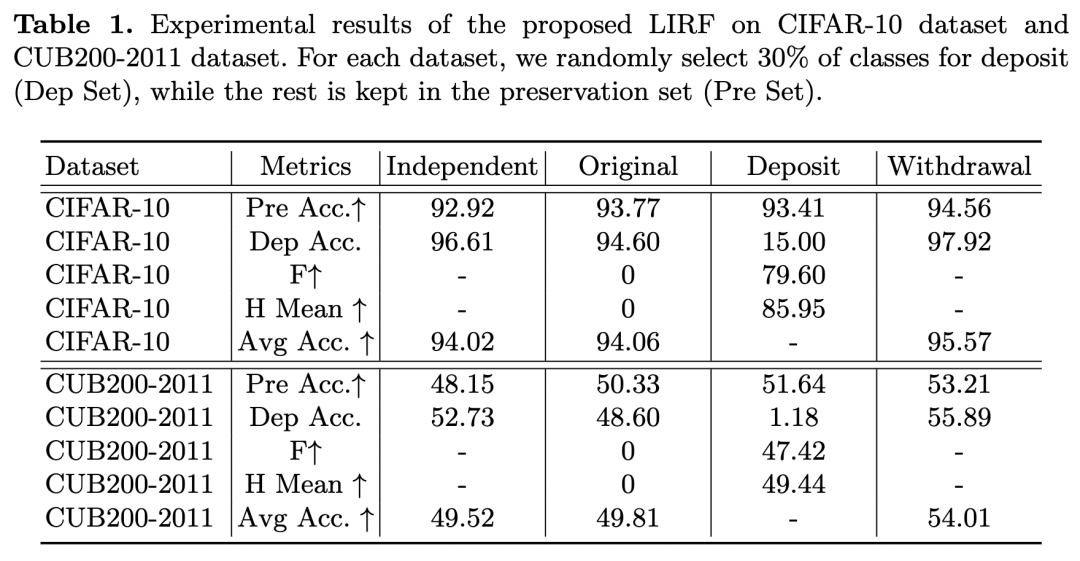

对知识存储性的性能评估,作者主要评估了目标网络和复原网络的性能。对于复原网络,作者计算了保留集的平均准确率(Pre Acc.)、存储集的平均准确率(Dep Acc.)和完整数据集的平均准确率(Avg Acc.)。对于目标网络,作者计算了保留集的平均准确率(Pre Acc.)、存储集的平均准确率(Dep Acc.)和同时考虑两者的调和平均数(H Mean)。

4.2. 实验结果

1. 总体性能

CIFAR-10 和 CUB200-2011上的效果如上表所示。由表观察可得,目标网络上的 “Pre Acc.” 相较于原始网络大幅度下降,验证了目标网络的关于存储集在 logit 层次的遗忘。同时与原始网络相比,复原网络在存储集和保留集上都获得了更高的准确性,进一步验证了 LIRF 中存在正向知识迁移。

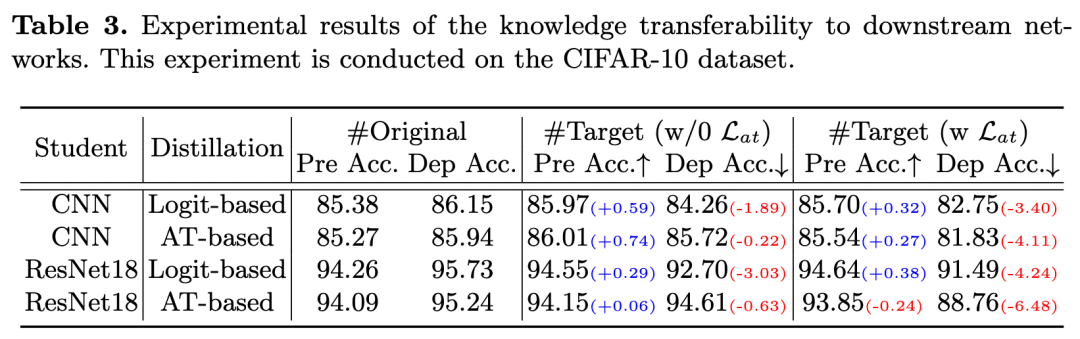

2. 知识迁移性

上表进行了目标网络中存储集的蒸馏性实验验证。从该表中观察可得,目标网络上的保留集的知识可迁移性不受影响,而存储集的知识难以通过 ligit-base 和 attention-base 的蒸馏方式进行迁移。

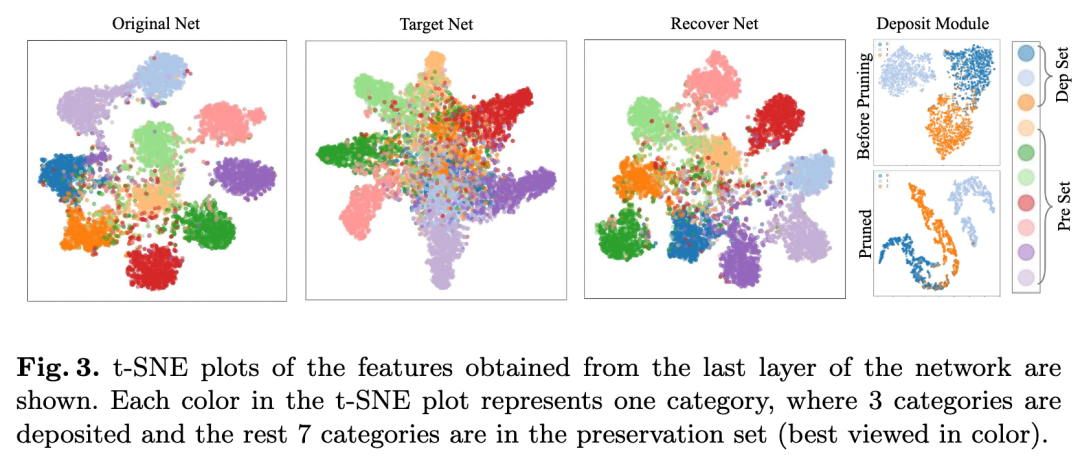

3. 可视化结果

LIRF 中的网络最后一层特征的可视化结果如上图所示。如图所示,原始网络和复原网络都可以在所有类别上产生具备判别力的特征。对于目标网络,该可视化结果证明了其具备保留集上的高度判别力特征的同时去除了对存储集的预测能力。

- 05 - 总结

在本文中,作者探索了一种全新的终身学习任务,进行可恢复型知识遗忘。与以往的终身学习任务不同,该任务设定对知识进行灵活的删除和恢复操作,在增强了用户可操作性的同时确保了网络IP安全。具体地,作者提出了包括知识存储和知识恢复的 LIRF 框架。在进行知识存储时,可能导致隐私泄露的知识从原始网络中提取,并保存在存储模块中。在进行知识恢复时,存储的知识可直接插入至复原模型中。作者在文中进行了大量实验,用以证明 LIRF 的有效性。

参考资料

[1] https://arxiv.org/abs/2207.08224

[2] https://github.com/JngwenYe/LIRF

[3] http://www.lv-nus.org/

点击进入—> CV 微信技术交流群

CVPR 2022论文和代码下载

后台回复:CVPR2022,即可下载CVPR 2022论文和代码开源的论文合集

后台回复:Transformer综述,即可下载最新的3篇Transformer综述PDF

目标检测和Transformer交流群成立

扫描下方二维码,或者添加微信:CVer6666,即可添加CVer小助手微信,便可申请加入CVer-目标检测或者Transformer 微信交流群。另外其他垂直方向已涵盖:目标检测、图像分割、目标跟踪、人脸检测&识别、OCR、姿态估计、超分辨率、SLAM、医疗影像、Re-ID、GAN、NAS、深度估计、自动驾驶、强化学习、车道线检测、模型剪枝&压缩、去噪、去雾、去雨、风格迁移、遥感图像、行为识别、视频理解、图像融合、图像检索、论文投稿&交流、PyTorch、TensorFlow和Transformer等。

一定要备注:研究方向+地点+学校/公司+昵称(如目标检测或者Transformer+上海+上交+卡卡),根据格式备注,可更快被通过且邀请进群

▲扫码或加微信: CVer6666,进交流群

CVer学术交流群(知识星球)来了!想要了解最新最快最好的CV/DL/ML论文速递、优质开源项目、学习教程和实战训练等资料,欢迎扫描下方二维码,加入CVer学术交流群,已汇集数千人!

▲扫码进群

▲点击上方卡片,关注CVer公众号

整理不易,请点赞和在看