最近在做中文文本分类,你做数据,首先你就得有数据集嘛,没有数据集你就得自己爬,很麻烦,我自己已经走了很多弯路了,只想提供给大家一些实用的东西,目的就酱。

搜狗实验室数据资源

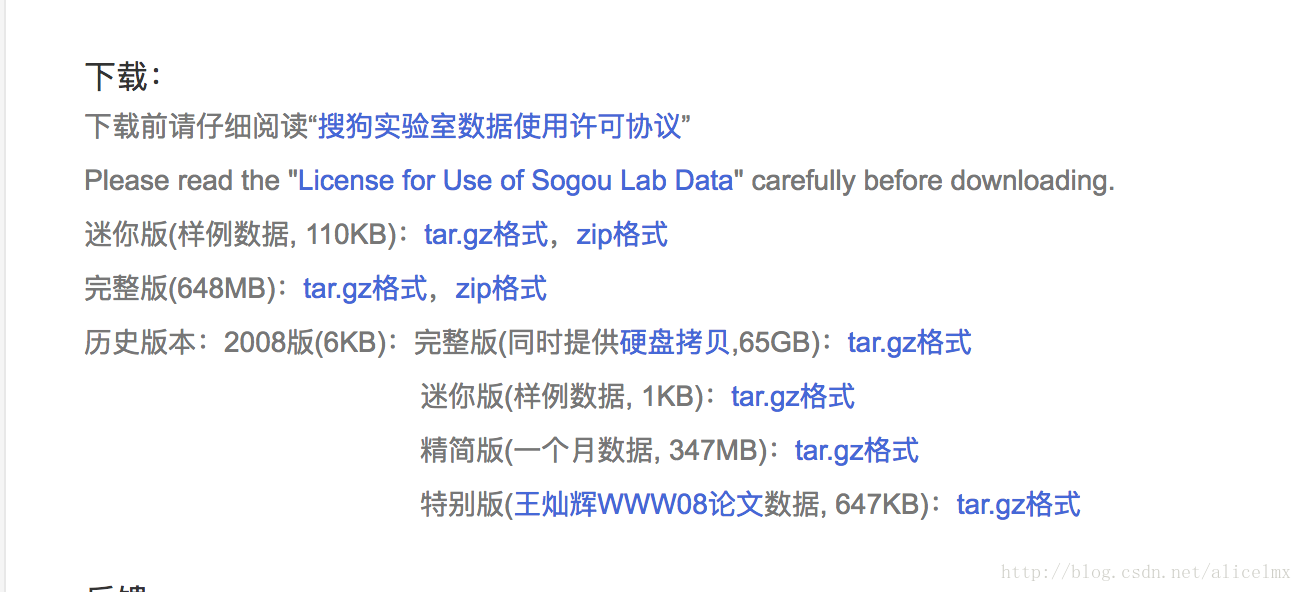

首先挂一个链接,因为其他博文的链接都是八百辈子之前的都挂掉了,想要下载的点击这个搜狗实验室,强烈建议不要使用Chrome,不知道为啥就是无法跳转到下载界面,我使用的Safari,然后登记下个人信息酒就可以使用了,毕竟你还是要尊重下人家的版权的嘛。

假设我们要使用搜狐新闻数据:

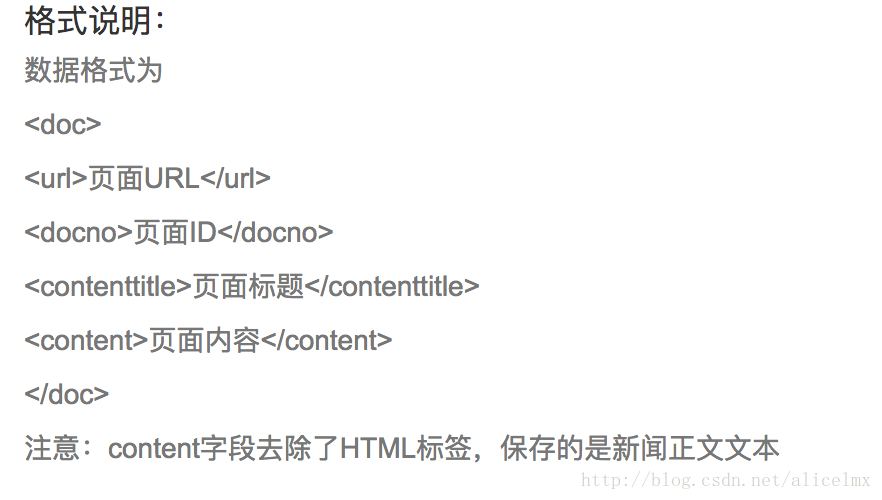

完整版非常大,是一个.dat格式的文件,还要自己进行切分,事实上搜狗实验室提供的资源不仅是ASCII码格式的,你需要自己转换,甚至文档都是xml结构的,你还需要自己提取,mmp,折腾我好久,当然我是个有毅力的人,最后当然是选择放弃了,哈哈哈哈哈~

虽然我失败了,但是给你们提供一个案例,祝你们能实现:

文本分类中语料库的获取——对搜狗语料库进行想要格式的获取

将搜狗实验室新闻语料库导入navicat

中文文本分类数据集THUCNews

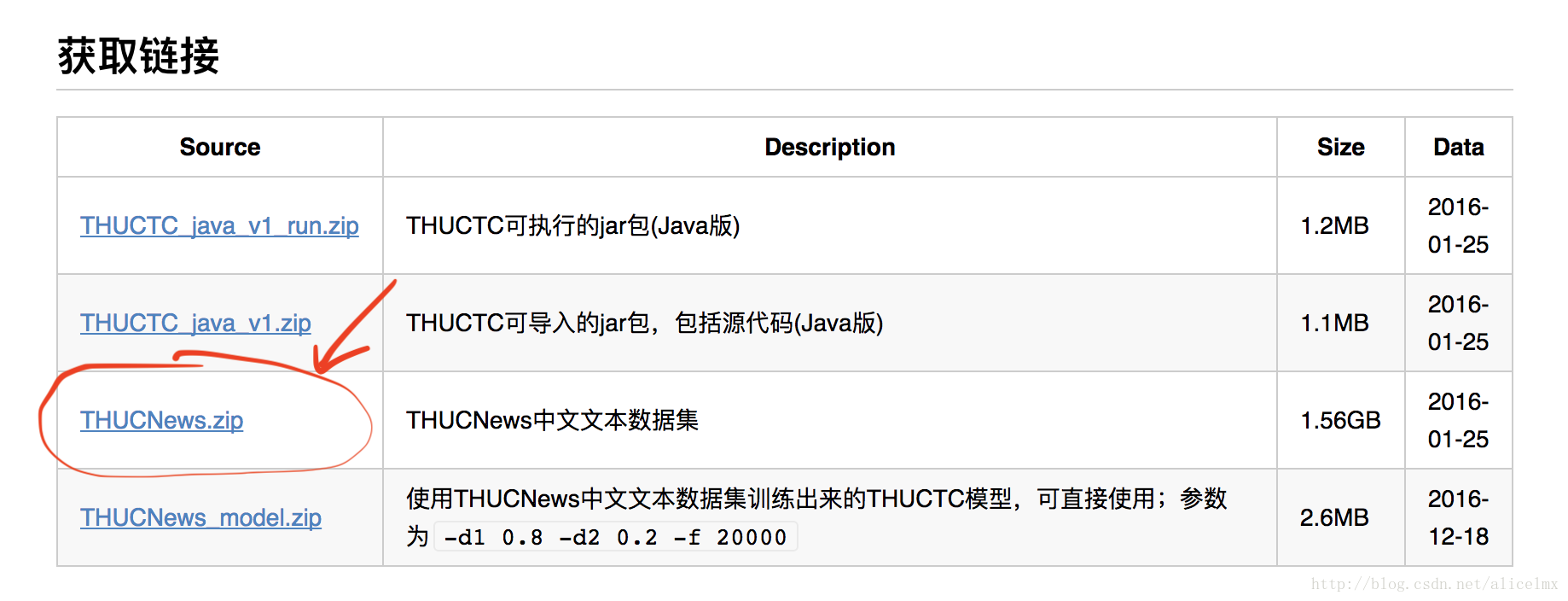

点击这里去往官网

THUCNews是根据新浪新闻RSS订阅频道2005~2011年间的历史数据筛选过滤生成,包含74万篇新闻文档(2.19 GB),均为UTF-8纯文本格式。我们在原始新浪新闻分类体系的基础上,重新整合划分出14个候选分类类别:财经、彩票、房产、股票、家居、教育、科技、社会、时尚、时政、体育、星座、游戏、娱乐。使用THUCTC工具包在此数据集上进行评测,准确率可以达到88.6%。

同样,你登录好自己的信息就可以下载了,但是你值得注意的是:这个数据集非常大,压缩包1.5G,实际文件大概在2.2G左右,解压缩就浪费了两个小时,毫不夸张的说,我都不敢在我的mac上尝试,还是借的同学的win,一般的话一个类别大概用个2000条就已经非常多了,自己可以动手在整理一下。

总结

清华的是按照类别存放的,就是太大了,切割一下拿来就可以用,搜狗这个很不良心啊,不推荐不推荐。

致谢

感谢清华大学的孙茂松,李景阳,郭志芃,赵宇,郑亚斌,司宪策,刘知远

感谢搜狗实验室团队