目录

最近在看知识图谱嵌入和知识推理方面的知识,考虑到TransC模型中关系传递性造成的语义缺失的错误传递,近期看的一篇论文《Reasoning Through Memorization: Nearest Neighbor Knowledge Graph Embeddings》(2022,记忆推理:最近邻知识图谱嵌入,已上传arxiv,暂未录用),可以利用增强记忆网络和KNN来学习新的实体embedding并存入knowledgestore。

一、TransC模型的不足

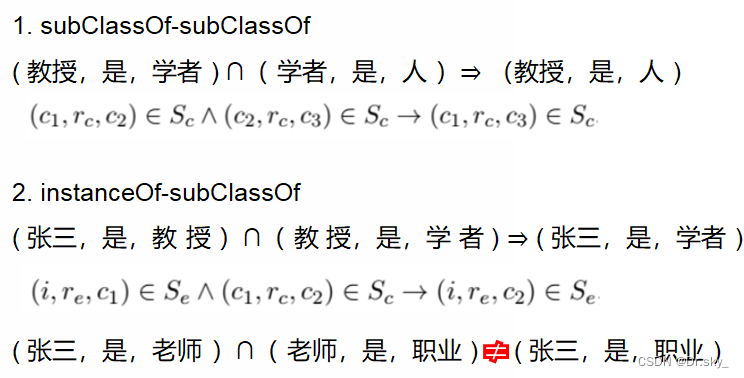

如下图所示:TransC可以吸收实体和概念的双层语义关系,但是在关系推理方面,存在一定劣势。如:张三是老师,老师是职业,若通过instanceOf和subClassOf推理出的instanceOf可能会出现错误。

二、传统KG embedding的不足

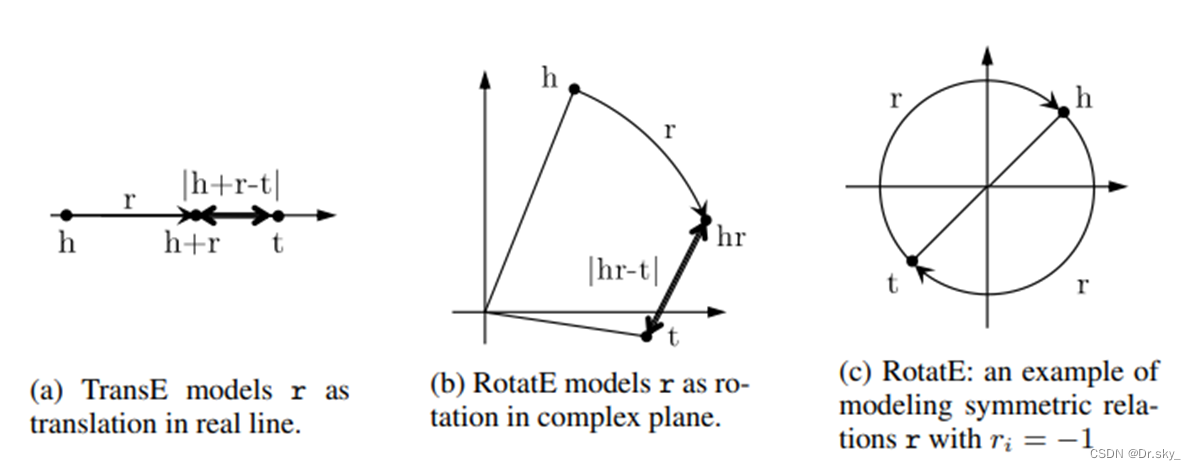

知识嵌入技术,将实体和关系嵌入到一个向量空间中,然后通过对这些向量利用预先定义的评分函数来获得预测的三要素。这些方法通过端到端训练将所有的关系知识隐含在参数化神经网络的权重中。然而,这些方法的一个主要限制是,它们很难推理出在几个三元组中演变的罕见实体或在训练中未见的新出现的实体。

三、KNN-KG

1. KNN-KG模型图

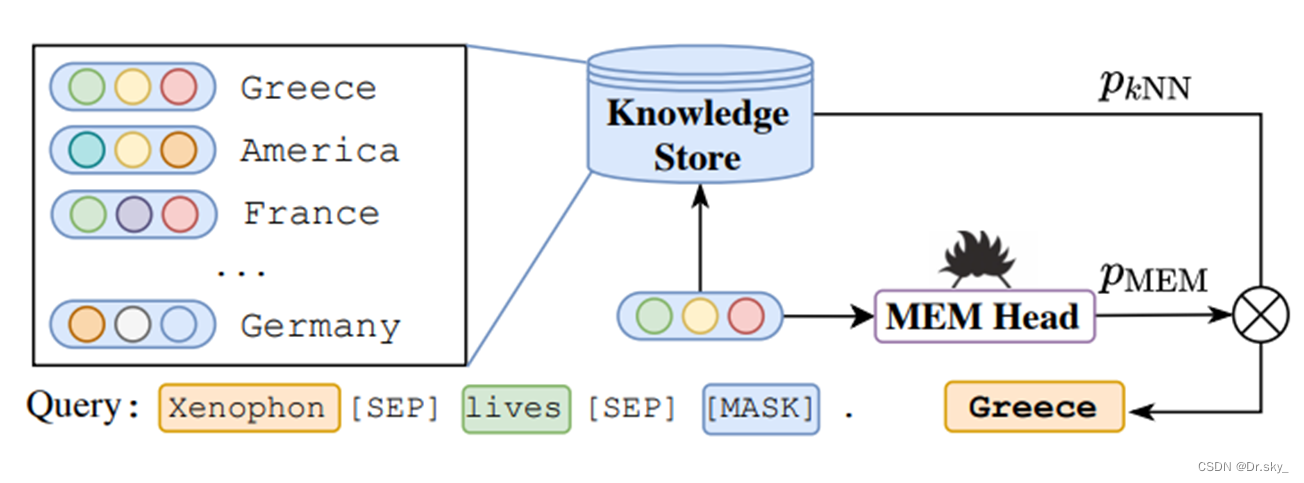

知识推理最近在记忆增强的神经网络方面的进展,催生了将计算处理和记忆存储分开的模块化架构的设计。已经成功地应用于语言建模和问题回答等任务,这些任务具有很强的表达能力和适应性。kNN-KGE不仅利用softmax(MEM头)的实体预测,而且还从实体描述和训练三元组构建的知识库中检索实体。

实体词汇扩展(图a),屏蔽实体建模(图b),以及从描述和三元组中构建知识库(图c)。彩色的实体将被编码为上下文的实体表示,并添加到的知识库中。

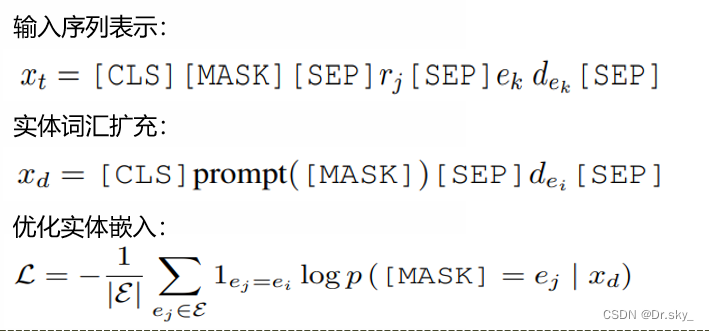

2. 通过Masked实体模型进行实体词汇的扩充

由于利用子词进行实体推理是不容易的,本文直接利用每个唯一实体的嵌入,就像常见的知识嵌入方法一样。具体来说,将实体表示为语言模型词汇表中的特殊符号;因此,知识图谱推理可以重构为屏蔽实体预测任务,获取实体的嵌入表示。

3. 知识存储推理

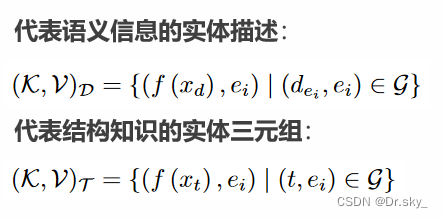

通过上下文KG表示可以推断出缺失的三元组,和罕见的或新兴的实体。受记忆增强神经网络最近进展的启发,本文构建知识存储来显式记忆实体。主要从两个部分构建知识存储:代表语义信息的实体描述和代表结构知识的实体三元组。使用上下文KG表示训练的模型从两个方面构建知识存储,罕见的或新兴的实体可以显式地表现在外部存储器中,具有灵活性和适应性。

4. 记忆推理

对于知识图谱补全任务,给定一个头尾实体缺失的三元组,我们使用[MASK]输出的表示作为预测锚实体嵌入,在知识存储中找到最近的邻居。

四、模型效果

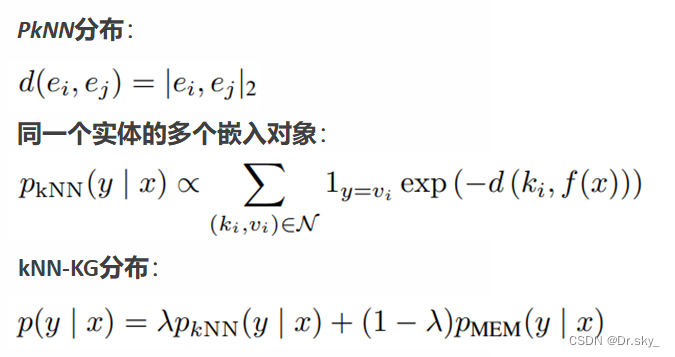

20个近邻实体的二维t-SNE可视化,以及它们在知识库中的所有嵌入,通过预测三联体(?, nationality, America)中缺失的实体来检索的结果。

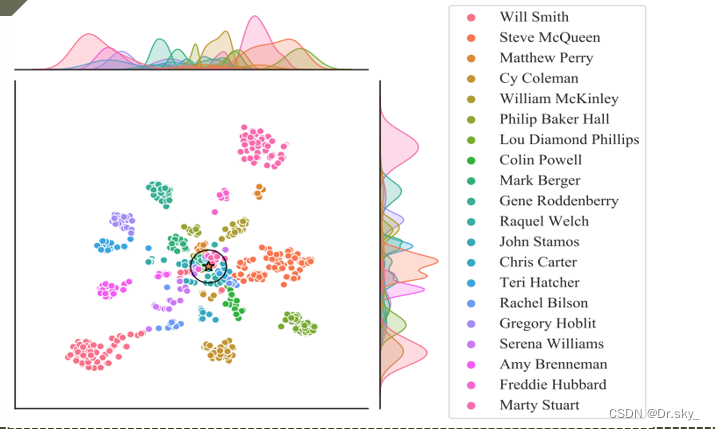

在两个例子的查询中,前五个实体及其由kNNKGE(不含知识库)预测的概率,以及由kNN-KGE对其进行的重新排序。

五、实验结果

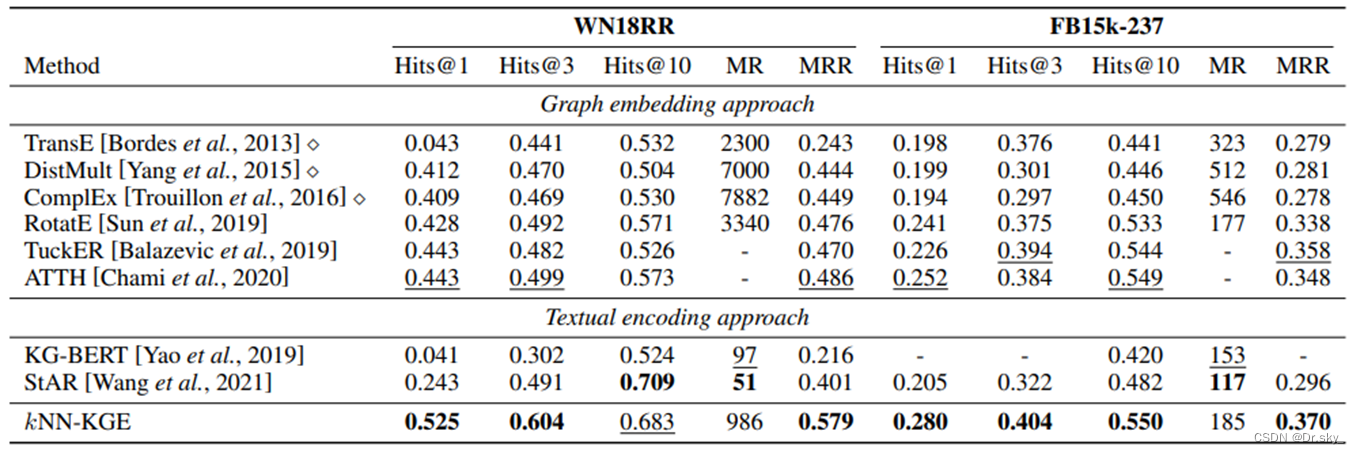

通过实验结果可发现,KNN-KG已经超过了SOTA

通过实验结果可发现,KNN-KG已经超过了SOTA

通过Masked实体模型词汇扩充

通过Masked实