一 常用损失函数

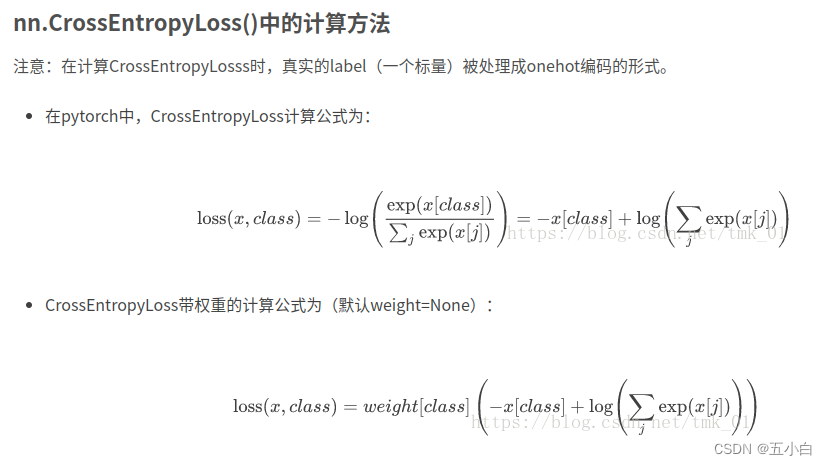

CrossEntropyLoss

分类问题中,交叉熵函数是比较常用也是比较基础的损失函数。

-

表达公式

-

参考链接:https://blog.csdn.net/ft_sunshine/article/details/92074842

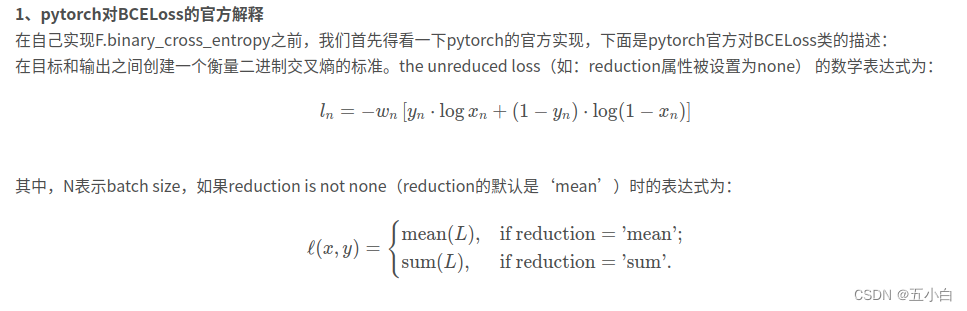

binary_cross_entropy 和 binary_cross_entropy_with_logits

二值交叉熵损失,输入可以通过sigmoid/softmax 可以完成二分类和多分类。

-

表达公式

-

两者的区别

有一个(类)损失函数名字中带了with_logits. 而这里的logits指的是,该损失函数已经内部自带了计算logit的操作,无需在传入给这个loss函数之前手动使用sigmoid/softmax将之前网络的输入映射到[0,1]之间

- 参考链接:https://blog.csdn.net/u010630669/article/details/105599067