接力:山东大学机器学习期末2021

本来是不想写的,因为不想回忆起考试时啥也不会的伤痛,没想到最后给分老师海底捞,心情好了一些,还是一块写完备考建议:多看ppt,多看ppt,多看ppt

山东大学机器学习期末考试2022

考试范围

SMO不考,PCA那一章因子分析不考,最后一章learning theory只考Bias-Variance Complexity和Decomposition 。

跟去年不太一样,比如去年不考GDA,今年我们的第二题就跟GDA的一个推论很像,考试范围最后一节课老师会说。

一、线性回归+牛顿法

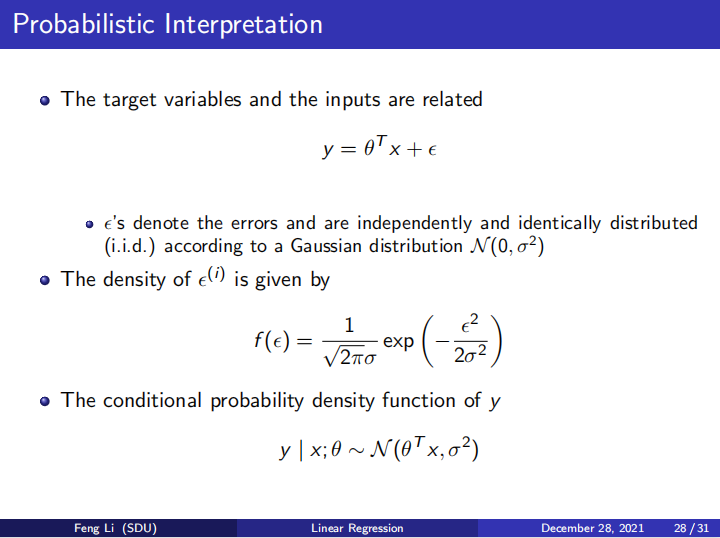

考了线性回归的概率解释。

(1)问 p ( y ∣ x ; θ ) p(y|x;\theta) p(y∣x;θ)(这里 θ T x \theta^T x θTx均是确定的哦)

(2)写出最大似然函数

(3)证明通过最大似然求解等价于求解最小二乘

然后,答案全在ppt上。

(4)求正则化线性回归的正规方程(作业题)

二、高斯朴素贝叶斯

(也许是叫这个名儿,可以上网搜搜)

(1)在原来贝叶斯的基础上,增加假设 Y Y Y符合伯努利分布,参数为 p p p, X ∣ Y X|Y X∣Y符合正态分布,均值为 μ i j \mu_{ij} μij,方差为 σ i j \sigma_{ij} σij,写出最大似然函数(其实就是贝叶斯的最大似然代入以上具体的概率分布)

(2)证明 P ( Y ∣ X ) = 1 1 + ? P(Y|X)=\frac{1}{1+?} P(Y∣X)=1+?1,其中 ? = f ( p , μ , σ ) ?=f(p,\mu,\sigma) ?=f(p,μ,σ)(证明形式是这样,,具体忘了,,求解最大似然估计参数 p , μ , σ p,\mu,\sigma p,μ,σ,然后用参数表示?)

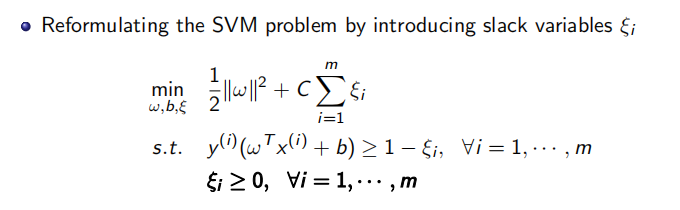

三、软间隔SVM变形

松弛一项变为 C ∑ i = 1 m ξ i 2 C\sum_{i=1}^{m}ξ_i^2 C∑i=1mξi2

(1)写出KTT条件

(2)求对偶问题

四、简答题

(跟之前的大差不差)

- pca算法的步骤

- 核方法在K-means算法上的应用

- Bias,Variance和模型复杂度关系

- K-means算法的步骤