下面将分享Datawhale总结的一个天池竞赛的经典题目——街景字符识别,流畅地过一遍基于pytorch的深度学习项目实战全过程,即使不动手,躺在床上刷一遍也会有所收获。

赛题理解

赛题数据

赛题以计算机视觉中字符识别为背景,要求选手预测街道字符编码,这是一个典型的字符识别问题。为了简化赛题难度,赛题数据采用公开数据集SVHN,并进行了匿名采样处理。原则上参赛选手只能使用比赛给定的数据集完成训练,不能使用SVHN原始数据集进行训练,但我们现在练手,直接用SVHN原始数据就ok。

比赛时,训练集数据包括3W张照片,验证集数据包括1W张照片,每张照片包括颜色图像和对应的编码类别和具体位置;为了保证比赛的公平性,测试集A包括4W张照片,测试集B包括4W张照片。

本赛题需要选手识别图片中所有的字符,训练集、验证集中所有字符的位置框已给出。

数据标签

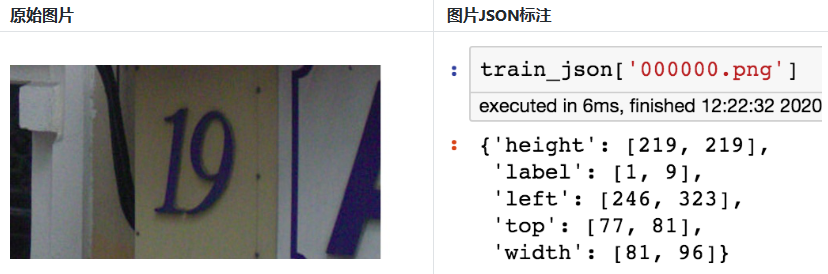

训练数据每张图片将给出对于的编码标签,和具体的字符框的位置(训练集、验证集都给出字符位置),可用于模型训练:

同一张图片中可能包括一个或者多个字符,因此在比赛数据的JSON标注中,会有两个字符的边框信息:

最终评分指标:

Score=编码识别正确的数量/测试集图片数量

读取数据

JSON中标签的读取方式:

import json

train_json = json.load(open('../input/train.json'))

# 数据标注处理

def parse_json(d):

arr = np.array([

d['top'], d['height'], d['left'], d['width'], d['label']

])

arr = arr.astype(int)

return arr

img = cv2.imread('../input/train/000000.png')

arr = parse_json(train_json['000000.png'])

plt.figure(figsize=(10, 10))

plt.subplot(1, arr.shape[1]+1, 1)

plt.imshow(img)

plt.xticks([]); plt.yticks([])

for idx in range(arr.shape[1]):

plt.subplot(1, arr.shape[1]+1, idx+2)

plt.imshow(img[arr[0, idx]:arr[0, idx]+arr[1, idx],arr[2, idx]:arr[2, idx]+arr[3, idx]])

plt.title(arr[4, idx])

plt.xticks([]); plt.yticks([])

解题思路

赛题本质是分类问题,需要对图片的字符进行识别。但赛题给定的数据图片中不同图片中包含的字符数量不等,有的图片的字符个数为2,有的图片字符个数为3,有的图片字符个数为4。因此本次赛题的难点是需要对不定长的字符进行识别,与传统的图像分类任务有所不同。

1、简单入门思路:定长字符识别:

可以将赛题抽象为一个定长字符识别问题,在赛题数据集中大部分图像中字符个数为2-4个,最多的字符个数为6个。

因此可以对于所有的图像都抽象为6个字符的识别问题,字符23填充为23XXXX,字符231填充为231XXX。

经过填充之后,原始的赛题可以简化了6个字符的分类问题。在每个字符的分类中会进行11个类别的分类(0-9和X),假如分类为填充字符,则表明该字符为空。

2、专业字符识别思路:不定长字符识别

在字符识别研究中,有特定的方法来解决此种不定长的字符识别问题,比较典型的有CRNN字符识别模型。在本次赛题中给定的图像数据都比较规整,可以视为一个单词或者一个句子。

3、专业分类思路:检测再识别

在赛题数据中已经给出了训练集、验证集中所有图片中字符的位置,因此可以首先将字符的位置进行识别,利用物体检测的思路完成。此种思路需要参赛选手构建字符检测模型,对测试集中的字符进行识别。选手可以参考物体检测模型SSD或者YOLO来完成。

小节

本次赛题虽然是一个简单的字符识别问题,但有多种解法可以使用到计算机视觉领域中的各个模型,非常适合大家入门学习。三种解决思路的难度从低到高,建议入门学习的同学可以先学习定长字符识别的思路。之后的内容中也会以定长字符识别为例,让大家熟悉CV项目实战流程。

数据读取 & 数据扩增

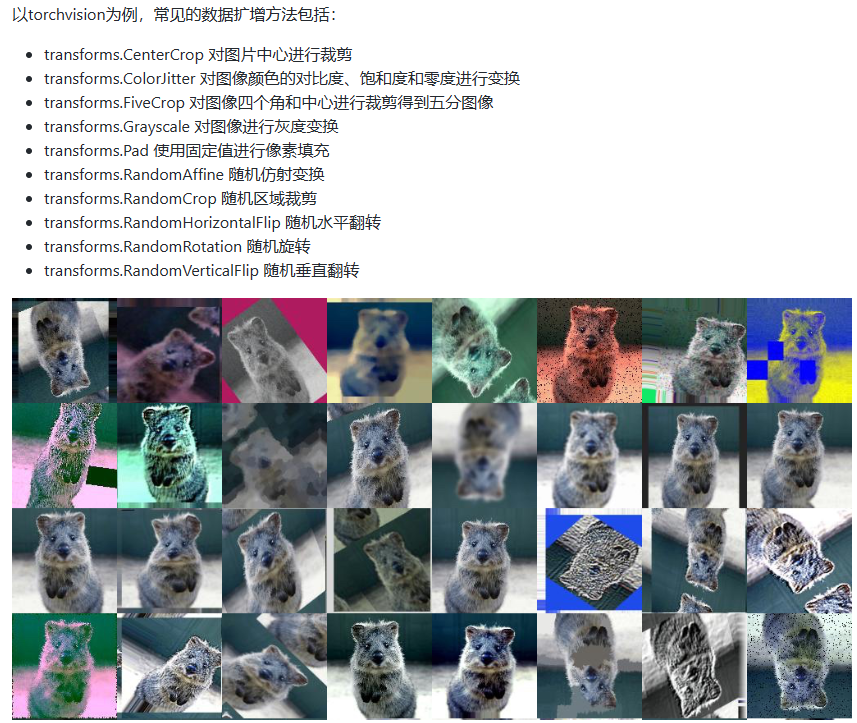

数据扩增

在深度学习模型的训练过程中,数据扩增是必不可少的环节。现有深度学习的参数非常多,一般的模型可训练的参数量基本上都是万到百万级别,而训练集样本的数量很难有这么多。在常见的数据扩增方法中,一般会从图像颜色、尺寸、形态、空间和像素等角度进行变换。当然不同的数据扩增方法可以自由进行组合,得到更加丰富的数据扩增方法。

在本次赛题中,赛题任务是需要对图像中的字符进行识别,因此对于字符图片并不能进行翻转操作。比如字符6经过水平翻转就变成了字符9,会改变字符原本的含义。

pytorch读取数据

解决赛题的第一步是使用Pytorch读取赛题数据。

在Pytorch中数据是通过Dataset进行封装,并通过DataLoder进行并行读取。所以我们只需要重载一下数据读取的逻辑就可以完成数据的读取。

import os, sys, glob, shutil, json

import cv2

from PIL import Image

import numpy as np

import torch

from torch.utils.data.dataset import Dataset

import torchvision.transforms as transforms

class SVHNDataset(Dataset):

def __init__(self, img_path, img_label, transform=None):

self.img_path = img_path

self.img_label = img_label

if transform is not None:

self.transform = transform

else:

self.transform = None

def __getitem__(self, index):

img = Image.open(self.img_path[index]).convert('RGB')

if self.transform is not None:

img = self.transform(img)

# 原始SVHN中类别10为数字0

lbl = np.array(self.img_label[index], dtype=np.int)

lbl = list(lbl) + (5 - len(lbl)) * [10]

return img, torch.from_numpy(np.array(lbl[:5]))

def __len__(self):

return len(self.img_path)

train_path = glob.glob('../input/train/*.png')

train_path.sort()

train_json = json.load(open('../input/train.json'))

train_label = [train_json[x]['label'] for x in train_json]

data = SVHNDataset(train_path, train_label,

transforms.Compose([

# 缩放到固定尺寸

transforms.Resize((64, 128)),

# 随机颜色变换

transforms.ColorJitter(0.2, 0.2, 0.2),

# 加入随机旋转

transforms.RandomRotation(5),

# 将图片转换为pytorch 的tesntor

# transforms.ToTensor(),

# 对图像像素进行归一化

# transforms.Normalize([0.485,0.456,0.406],[0.229,0.224,0.225])

]))

train_loader = torch.utils.data.DataLoader(

SVHNDataset(train_path, train_label,

transforms.Compose([

transforms.Resize((64, 128)),

transforms.ColorJitter(0.3, 0.3, 0.2),

transforms.RandomRotation(5),

transforms.ToTensor(),

transforms.Normalize([0.485, 0.456, 0.406], [0.229, 0.224, 0.225])

])),

batch_size=10, # 每批样本个数

shuffle=False, # 是否打乱顺序

num_workers=10, # 读取的线程个数

)

for data in train_loader:

break

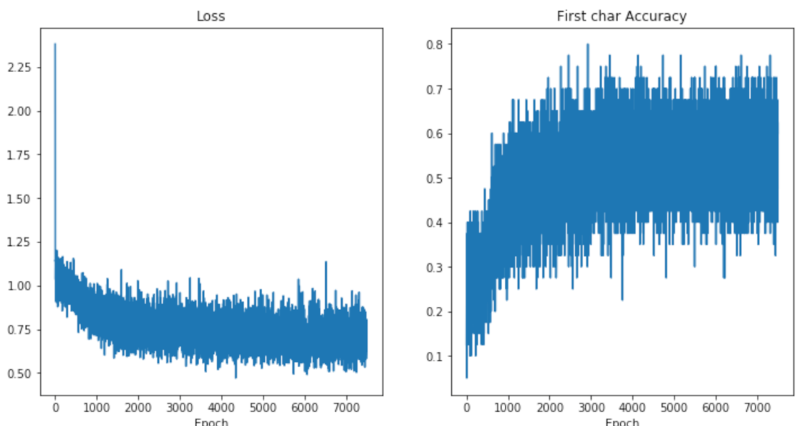

字符识别CNN模型

上面我们讲了如何使用Pytorch来读取赛题数据集,本节我们构件一个简单的CNN模型,然后进行训练,完成字符识别功能。在Pytorch中构建CNN模型非常简单,只需要定义好模型的参数和正向传播即可,Pytorch会根据正向传播自动计算反向传播。

这个CNN模型包括两个卷积层,最后并联6个全连接层进行分类。

import torch

torch.manual_seed(0)

torch.backends.cudnn.deterministic = False

torch.backends.cudnn.benchmark = True

import torchvision.models as models

import torchvision.transforms as transforms

import torchvision.datasets as datasets

import torch.nn as nn

import torch.nn.functional as F

import torch.optim as optim

from torch.autograd import Variable

from torch.utils.data.dataset import Dataset

# 定义模型

class SVHN_Model1(nn.Module):

def __init__(self):

super(SVHN_Model1, self).__init__()

# CNN提取特征模块

self.cnn = nn.Sequential(

nn.Conv2d(3, 16, kernel_size=(3, 3), stride=(2, 2)),

nn.ReLU(),

nn.MaxPool2d(2),

nn.Conv2d(16, 32, kernel_size=(3, 3), stride=(2, 2)),

nn.ReLU(),

nn.MaxPool2d(2),

)

#

self.fc1 = nn.Linear(32*3*7, 11)

self.fc2 = nn.Linear(32*3*7, 11)

self.fc3 = nn.Linear(32*3*7, 11)

self.fc4 = nn.Linear(32*3*7, 11)

self.fc5 = nn.Linear(32*3*7, 11)

self.fc6 = nn.Linear(32*3*7, 11)

def forward(self, img):

feat = self.cnn(img)

feat = feat.view(feat.shape[0], -1)

c1 = self.fc1(feat)

c2 = self.fc2(feat)

c3 = self.fc3(feat)

c4 = self.fc4(feat)

c5 = self.fc5(feat)

c6 = self.fc6(feat)

return c1, c2, c3, c4, c5, c6

model = SVHN_Model1()

# 损失函数

criterion = nn.CrossEntropyLoss()

# 优化器

optimizer = torch.optim.Adam(model.parameters(), 0.005)

loss_plot, c0_plot = [], []

# 迭代10个Epoch

for epoch in range(10):

for data in train_loader:

c0, c1, c2, c3, c4, c5 = model(data[0])

loss = criterion(c0, data[1][:, 0]) + \

criterion(c1, data[1][:, 1]) + \

criterion(c2, data[1][:, 2]) + \

criterion(c3, data[1][:, 3]) + \

criterion(c4, data[1][:, 4]) + \

criterion(c5, data[1][:, 5])

loss /= 6

optimizer.zero_grad()

loss.backward()

optimizer.step()

loss_plot.append(loss.item())

c0_plot.append((c0.argmax(1) == data[1][:, 0]).sum().item()*1.0 / c0.shape[0])

print(epoch)

加入训练集和测试集的划分,进行模型训练与验证:

import torch.nn as nn

from torch.utils.data.dataset import Dataset

class SVHN_Model1(nn.Module):

def __init__(self):

super(SVHN_Model1, self).__init__()

# CNN提取特征模块

self.cnn = nn.Sequential(

nn.Conv2d(3, 16, kernel_size=(3, 3), stride=(2, 2)),

nn.ReLU(),

nn.MaxPool2d(2),

nn.Conv2d(16, 32, kernel_size=(3, 3), stride=(2, 2)),

nn.ReLU(),

nn.MaxPool2d(2),

)

#

self.fc1 = nn.Linear(32*3*7, 11)

self.fc2 = nn.Linear(32*3*7, 11)

self.fc3 = nn.Linear(32*3*7, 11)

self.fc4 = nn.Linear(32*3*7, 11)

self.fc5 = nn.Linear(32*3*7, 11)

self.fc6 = nn.Linear(32*3*7, 11)

def forward(self, img):

feat = self.cnn(img)

feat = feat.view(feat.shape[0], -1)

c1 = self.fc1(feat)

c2 = self.fc2(feat)

c3 = self.fc3(feat)

c4 = self.fc4(feat)

c5 = self.fc5(feat)

c6 = self.fc6(feat)

return c1, c2, c3, c4, c5, c6

#每个Epoch的训练代码

def train(train_loader, model, criterion, optimizer, epoch):

# 切换模型为训练模式

model.train()

for i, (input, target) in enumerate(train_loader):

c0, c1, c2, c3, c4, c5 = model(data[0])

loss = criterion(c0, data[1][:, 0]) + \

criterion(c1, data[1][:, 1]) + \

criterion(c2, data[1][:, 2]) + \

criterion(c3, data[1][:, 3]) + \

criterion(c4, data[1][:, 4]) + \

criterion(c5, data[1][:, 5])

loss /= 6

optimizer.zero_grad()

loss.backward()

optimizer.step()

#每个Epoch的验证代码:

def validate(val_loader, model, criterion):

# 切换模型为预测模型

model.eval()

val_loss = []

# 不记录模型梯度信息

with torch.no_grad():

for i, (input, target) in enumerate(val_loader):

c0, c1, c2, c3, c4, c5 = model(data[0])

loss = criterion(c0, data[1][:, 0]) + \

criterion(c1, data[1][:, 1]) + \

criterion(c2, data[1][:, 2]) + \

criterion(c3, data[1][:, 3]) + \

criterion(c4, data[1][:, 4]) + \

criterion(c5, data[1][:, 5])

loss /= 6

val_loss.append(loss.item())

return np.mean(val_loss)

train_loader = torch.utils.data.DataLoader(

# train_dataset,

batch_size=10,

shuffle=True,

num_workers=10,

)

val_loader = torch.utils.data.DataLoader(

# val_dataset,

batch_size=10,

shuffle=False,

num_workers=10,

)

model = SVHN_Model1()

criterion = nn.CrossEntropyLoss (size_average=False)

optimizer = torch.optim.Adam(model.parameters(), 0.001)

best_loss = 1000.0

for epoch in range(20):

print('Epoch: ', epoch)

train(train_loader, model, criterion, optimizer, epoch)

val_loss = validate(val_loader, model, criterion)

# 记录下验证集精度

if val_loss < best_loss:

best_loss = val_loss

torch.save(model.state_dict(), './model.pt')

#模型保存与加载

torch.save(model_object.state_dict(), 'model.pt')

model.load_state_dict(torch.load(' model.pt'))

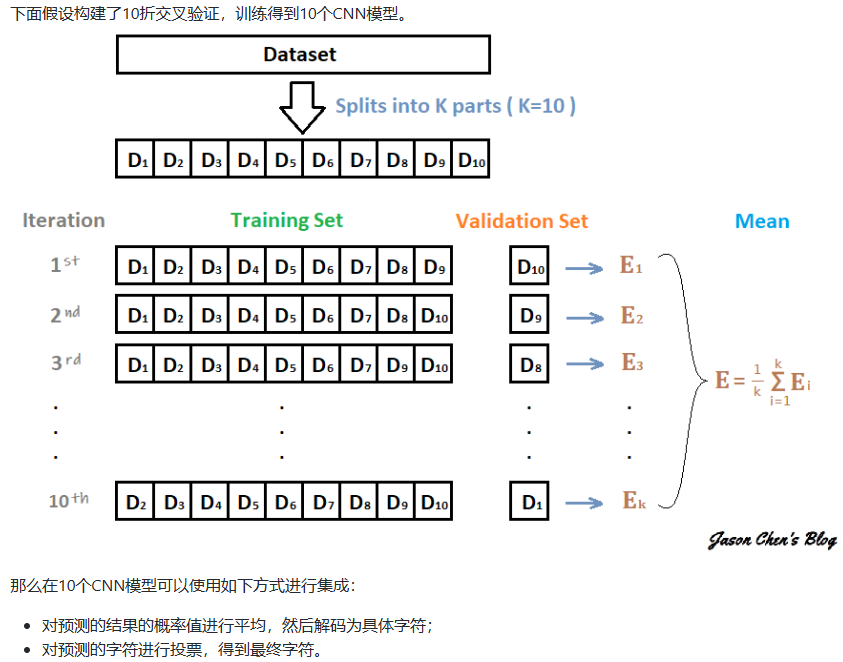

模型集成

在机器学习中的集成学习可以在一定程度上提高预测精度,常见的集成学习方法有Stacking、Bagging和Boosting,同时这些集成学习方法与具体验证集划分联系紧密。

由于深度学习模型一般需要较长的训练周期,如果硬件设备不允许建议选取留出法,如果需要追求精度可以使用交叉验证的方法。

Dropout

Dropout可以作为训练深度神经网络的一种技巧,也算集成学习的一种方法。在每个训练批次中,通过随机让一部分的节点停止工作。同时在预测的过程中让所有的节点都其作用。Dropout可以有效的缓解模型过拟合的情况,也可以在预测时增加模型的精度。

加入dropout之后的网络结构:

# 定义模型

class SVHN_Model1(nn.Module):

def __init__(self):

super(SVHN_Model1, self).__init__()

# CNN提取特征模块

self.cnn = nn.Sequential(

nn.Conv2d(3, 16, kernel_size=(3, 3), stride=(2, 2)),

nn.ReLU(),

nn.Dropout(0.25),

nn.MaxPool2d(2),

nn.Conv2d(16, 32, kernel_size=(3, 3), stride=(2, 2)),

nn.ReLU(),

nn.Dropout(0.25),

nn.MaxPool2d(2),

)

#

self.fc1 = nn.Linear(32*3*7, 11)

self.fc2 = nn.Linear(32*3*7, 11)

self.fc3 = nn.Linear(32*3*7, 11)

self.fc4 = nn.Linear(32*3*7, 11)

self.fc5 = nn.Linear(32*3*7, 11)

self.fc6 = nn.Linear(32*3*7, 11)

def forward(self, img):

feat = self.cnn(img)

feat = feat.view(feat.shape[0], -1)

c1 = self.fc1(feat)

c2 = self.fc2(feat)

c3 = self.fc3(feat)

c4 = self.fc4(feat)

c5 = self.fc5(feat)

c6 = self.fc6(feat)

return c1, c2, c3, c4, c5, c6

TTA

测试集数据扩增(Test Time Augmentation,简称TTA)也是常用的集成学习技巧,数据扩增不仅可以在训练时候用,而且可以同样在预测时候进行数据扩增,对同一个样本预测三次,然后对三次结果进行平均。

def predict(test_loader, model, tta=10):

model.eval()

test_pred_tta = None

# TTA 次数

for _ in range(tta):

test_pred = []

with torch.no_grad():

for i, (input, target) in enumerate(test_loader):

c0, c1, c2, c3, c4, c5 = model(data[0])

output = np.concatenate([c0.data.numpy(), c1.data.numpy(),

c2.data.numpy(), c3.data.numpy(),

c4.data.numpy(), c5.data.numpy()], axis=1)

test_pred.append(output)

test_pred = np.vstack(test_pred)

if test_pred_tta is None:

test_pred_tta = test_pred

else:

test_pred_tta += test_pred

return test_pred_tta

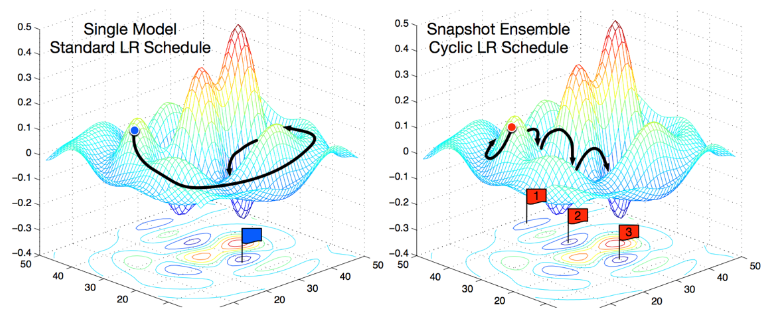

Snapshot

假设我们训练了10个CNN则可以将多个模型的预测结果进行平均。但是加入只训练了一个CNN模型,如何做模型集成呢?

在论文Snapshot Ensembles中,作者提出使用cyclical learning rate进行训练模型,并保存精度比较好的一些checkopint,最后将多个checkpoint进行模型集成。

由于在cyclical learning rate中学习率的变化有周期性变大和减少的行为,因此CNN模型很有可能在跳出局部最优进入另一个局部最优。在Snapshot论文中作者通过使用表明,此种方法可以在一定程度上提高模型精度,但需要更长的训练时间。