系统安装

系统安装过程分为3步:

- 下载必要的软件及镜像

Jetson Nano Developer Kit SD卡映像

https://developer.nvidia.com/jetson-nano-sd-card-image

Windows版SD存储卡格式化程序

https://www.sdcard.org/downloads/formatter_4/eula_windows/

镜像烧录工具balenaEtcher

https://www.balena.io/etcher

- 格式化SD卡并写入镜像

安装Paddle

Paddle Inference 是飞桨的原生推理库, 作用于服务器端和云端,提供高性能的推理能力,在使用之前,我们需要在Jetson Nano里安装好PaddlePaddle。

sudo apt-get install python3-pip

pip3 install --upgrade pip

pip3 install --upgrade numpy==1.16.1

cat /etc/nv_tegra_release

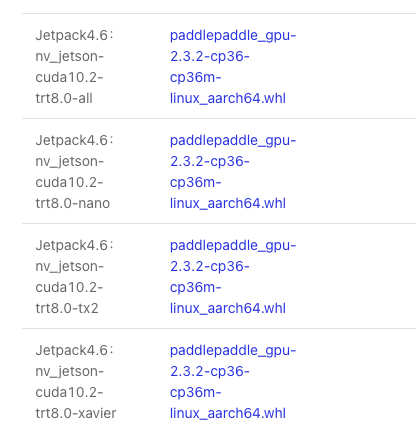

下载并安装与Jetpack版本对应的PaddlePaddle

下载链接: https://paddleinference.paddlepaddle.org.cn

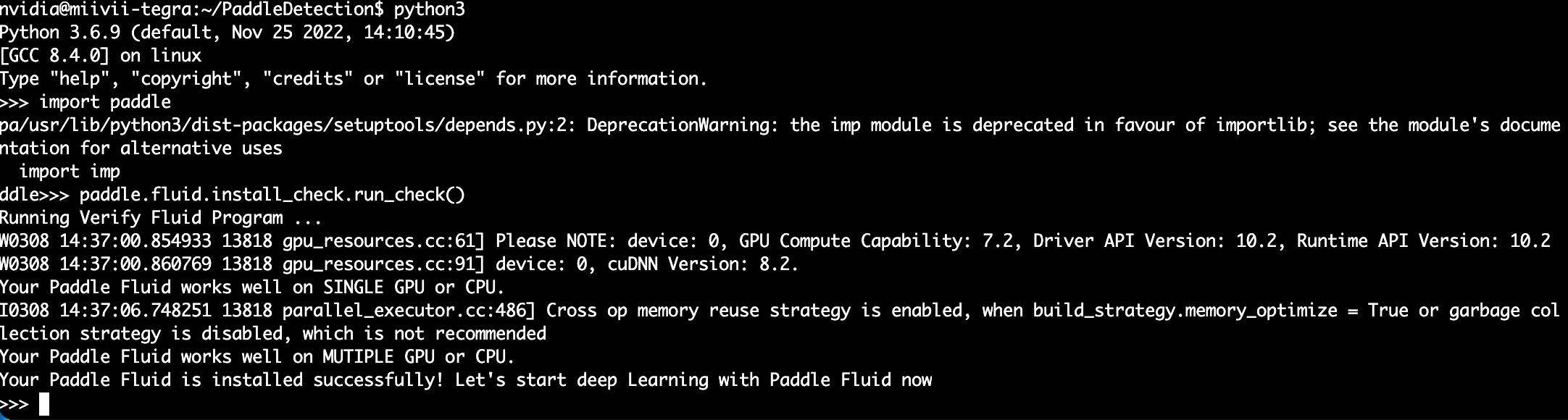

测试PaddlePaddle

python3

import paddle

paddle.fluid.install_check.run_check()

模型准备

在部署之前,我们需要得到 Paddle 预测格式的模型: - 存储模型结构的inference.pdmodel - 存储模型参数的inference.pdiparams

获取方式有很多种,可以自己训练一个模型,并使用paddle.static.save_inference_model接口保存推理模型和参数

当然你也可以使用套件训练一个模型,然后将模型导出成推理模型,下面我们以PaddleDetection为例。

# 拉取PaddleDetection源码

git clone https://gitee.com/PaddlePaddle/PaddleDetection

# 安装依赖库

pip install pycocotools

pip install motmetrics

pip install lap

我们可以在/PaddleDetection/configs下找到很多模型,这里以ppyolo为例,选择你想导出的预训练模型。

模型权重可以在PaddleDetection的官方文档里找到。如果你想导出别的模型,直接替换下面config和weight的参数即可。

cd PaddleDetection/

python tools/export_model.py -c configs/ppyolo/ppyolo_tiny_650e_coco.yml --output_dir=./inference_model \

-o weights=https://paddledet.bj.bcebos.com/models/ppyolo_tiny_650e_coco.pdparams

推理模型准备好之后,下载到Jetson NX 即可使用。

参考资料: