ChatGPT由OpenAI开发,2022年11月一经面世便引发热烈讨论,用户数持续暴涨。2023年初,微软成功将ChatGPT接入其搜索引擎Bing中,市场影响力迅速提升,几乎同一时间,谷歌宣布其研发的一款类似人工智能应用Bard上线。此后,生成式人工智能在国内外科技圈与资本市场领域掀起了阵阵热潮。

目录

ChatGPT是什么?有何潜在的法律风险?法律在人工智能领域的监管趋势如何?企业和用户该如何在人工智能热席卷全球的背景下防范法律风险?我们会被AI替代吗?

1.ChatGPT是什么?

1. 概念及原理

ChatGPT是一个基于语言模型GPT-3.5的聊天机器人,他以对话的方式进行交互,既能做到回答问题,也能够承认错误、质疑不正确的前提以及拒绝不恰当的请求。ChatGPT是生成式人工智能技术(Artificial Intelligence Generative Content, 简称“AIGC”或“生成式AI”)浪潮的一部分。

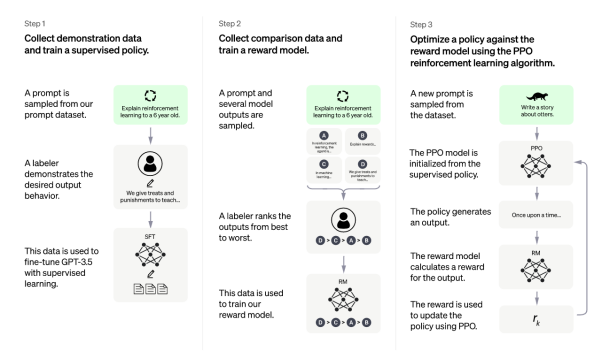

GPT(Generative Pre-trained Transformer)模型是一种自然语言处理(NLP)模型,使用多层变换器(Transformer)来预测下一个单体的频率分布,通过训练在大型文本语料库上学习到的语言模式来生成自然语言文本。根据OpenAI官网介绍,ChatGPT模型的训练使用了人类反馈强化学习(Reinforcement Learning from Human Feedback,简称RLHF),由人类训练师扮演用户和人工智能助手的角色,在训练中优化ChatGPT的回答质量,使AI的语言更具有人类风格。(见图1为OpenAI官网所列训练流程)

2. 生成式AI的发展过程及主要应用领域

生成式AI起源于分析式AI,不同于分析式AI学习的知识局限于数据本身,生成式AI可以在总结归纳数据知识的基础上生成数据中不存在的样本。自2010年起,生成式AI迎来了快速发展阶段,2017年微软人工智能“小冰”独立创作世界首部AI诗集;2018年英伟达发布StyleGAN自动生成肉眼难以辨别的图片;2022年OpenAI宣布GPT-3.5的突破……每一里程碑式的突破都标志着生成式AI迎来技术和商业的拐点。

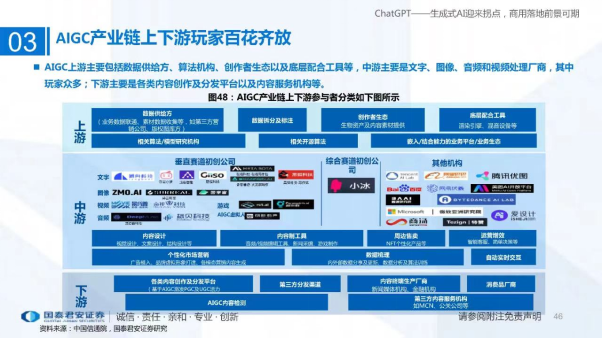

生成式AI的爆火主要是由不同领域产业链上下游的应用带来的,从以ChatGPT为代表的文本交互式AI到以Stable Diffusion为代表的图像生成AI,从策略生成到虚拟人生成,从视频生成到游戏角色生成,如图2所示,AI在搜索、金融、教育、医疗、商品营销、娱乐等众多领域对人类社会传统行业产生深远影响,人类可以使用AI帮助自己写企业策划书、学英语、研究生物蛋白构成、画画……以AI武装头脑达到智慧升级进化。

2.ChatGPT潜藏的法律风险分析

在人们为新技术带来的新奇体验欢呼、风投资本涌入充满创造性的新世界的同时,我们需要思考新型技术可能引发的混乱与潜在的危害人类社会的风险。结合我们服务生成式AI客户的经验和我们对这一新领域的观察,我们认为,需要在数据与网络安全、知识产权、未成年人保护和刑事领域重点关注生成式AI的法律问题。

1. 数据合规与网络安全问题

(1)数据来源的合规风险

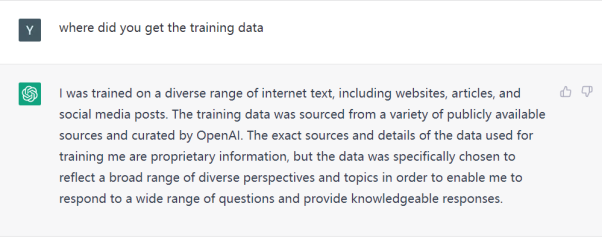

根据ChatGPT的回答(图3),它的训练数据来自于广泛的互联网文本和社交平台信息。虽然大数据时代,数据爬虫是企业采集公开数据的常用手段,但对于抓取数据是否会筛选个人信息甚至敏感个人信息;类似生成式AI抓取训练数据是所使用的爬虫技术是否具有侵入性;以及前期抓取的数据是否仅用作训练等问题,均应引起我们的警惕。

(2)数据处理的合规风险

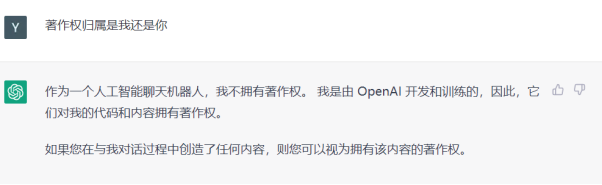

在使用生成式AI的过程中是否会侵犯商业秘密、企业数据权益与个人信息权益的问题也值得关注。生成式AI代替人工作的同时增加了数据泄露的风险,生成式AI公司该如何确保与用户交互过程中不侵害商业秘密、企业数据权益以及用户个人信息与其他人身权益也成为了值得思考的问题。关于这个问题,不同的生成式AI公司做法不尽相同,OpenAI作为生成式AI的领头羊自然也在隐私保护措施探索方面走在前列:ChatGPT回答承诺对所有数据采取严格保密措施,保护隐私安全(见图4);而OpenAI的另一款图像生成应用DALL-E 则在用户协议中声明:禁止上传可识别的人类面部图像,禁止在提示词(prompt)中输入现实存在的人名,并加入技术和人工审核来防止滥用。

(3)网络安全风险

生成式AI在帮助人类获取知识和解决问题的同时也可能会被用来写恶意软件代码,进而危害网络安全;另外,存有大量交互信息的生成式AI本身可能会成为网络攻击对象,从而进一步加大数据泄露的风险。此外,ChatGPT深度影响人类获取知识和做出判断的同时势必会带来操控人类思想的危险,由于算法偏见以及不真实信息源带来的政治操控对信息安全乃至国家安全的风险不容忽视。

2. 知识产权保护问题

(1)著作权归属问题

随着越来越多的人利用ChatGPT代写论文或做论文研究,ChatGPT已经被一些论文冠以共同作者的头衔,而生成式AI产生的作品的著作权归属问题也一直是讨论热点——使用生成式AI创作的作品属于AI、开发AI的公司、还是输入提示词的人?

(2)著作权侵权问题

对于生成式AI的公司来讲,无论使用商业软件亦或开源软件,都可能涉及软件著作权的侵权风险。不仅如此,由于机器学习的局限性,使用生成类AI创作的作品可能会因为不够具有创造性而被相似风格作品的原作者诉讼侵权,全球知名视觉艺术网站ArtStation的上千名画师发起联合抵制,禁止用户将其画作投放AI绘画系统,认为任由系统学习模仿画作是在侵犯版权。而AI绘画鼻祖Stable Diffusion不仅深陷知识产权侵权诉讼,同时受到众多画家的讨伐。

3. 未成年人保护

经我们调查发现,由于AI生成内容质量的良莠不齐确实会对缺乏判断力的未成年人构成威胁,目前市场上绝大部分生成式AI应用都仅限于成年人使用,但目前如何在用户协议确认用户年龄限制,以及如何在注册阶段严格禁止未成年人的使用成为企业与社会共同面对的难题。以ChatGPT为例,根据其隐私政策,未满13岁的儿童不得使用ChatGPT,而关于如何保护13-18岁未成年人的利益,ChatGPT在现阶段并未采取任何声明和措施;此外,由于目前ChatGPT仅使用手机号即可注册,在手机号码未实名验证的情境下如何保护未成年人,ChatGPT目前也没有采取任何限制措施。

4. 刑事风险

随着越来越多功能的生成式AI技术产生,从图片、音频到视频的合成已不存在技术难题,犯罪分子、恐怖分子利用AI技术盗刷人脸,利用ChatGPT类似新兴概念进行网络诈骗等问题日益凸显,犯罪手法日渐多样化。