首先,GPU服务器有什么作用?

GPU 加速计算可以提供非凡的应用程序性能,能将应用程序计算密集部分的工作负载转移到 GPU,同时仍由 CPU 运行其余程序代码,从用户的角度来看,应用程序的运行速度明显加快。

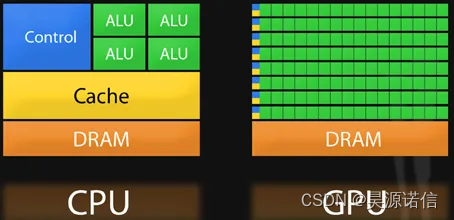

理解 GPU 和 CPU 之间区别的一种简单方式是比较它们如何处理任务。

CPU 由专为顺序串行处理而优化的几个核心组成,而 GPU 则拥有一个由数以千计得更小、更高效的核心(专为同时处理多重任务而设计)组成的大规模并行计算架构。

其次,GPU服务器的主要应用场景是什么?

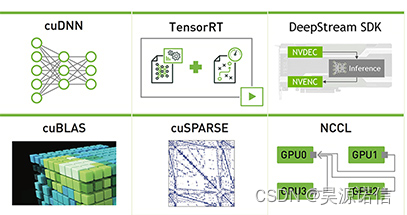

深度学习模型:

GPU服务器可作为深度学习训练的平台:

1.GPU 服务器可直接加速计算服务,亦可直接与外界连接通信。

2.GPU 服务器和计算服务器搭配使用,计算服务器为主 GPU 云服务器提供计算平台。

3.对象存储 COS 可以为 GPU 服务器提供大数据量的云存储服务。

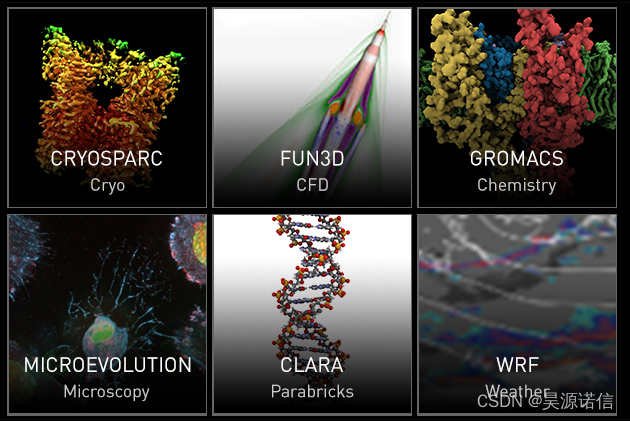

海量计算处理:

GPU 服务器超强的计算功能可应用于海量数据处理方面的运算,如搜索、大数据推荐、智能输入法、人脸识别等:

1.原本需要数天完成的数据量,采用 GPU 服务器在数小时内即可完成运算。

2.原本需要数十台 CPU 服务器共同运算集群,采用单台 GPU 服务器可完成。

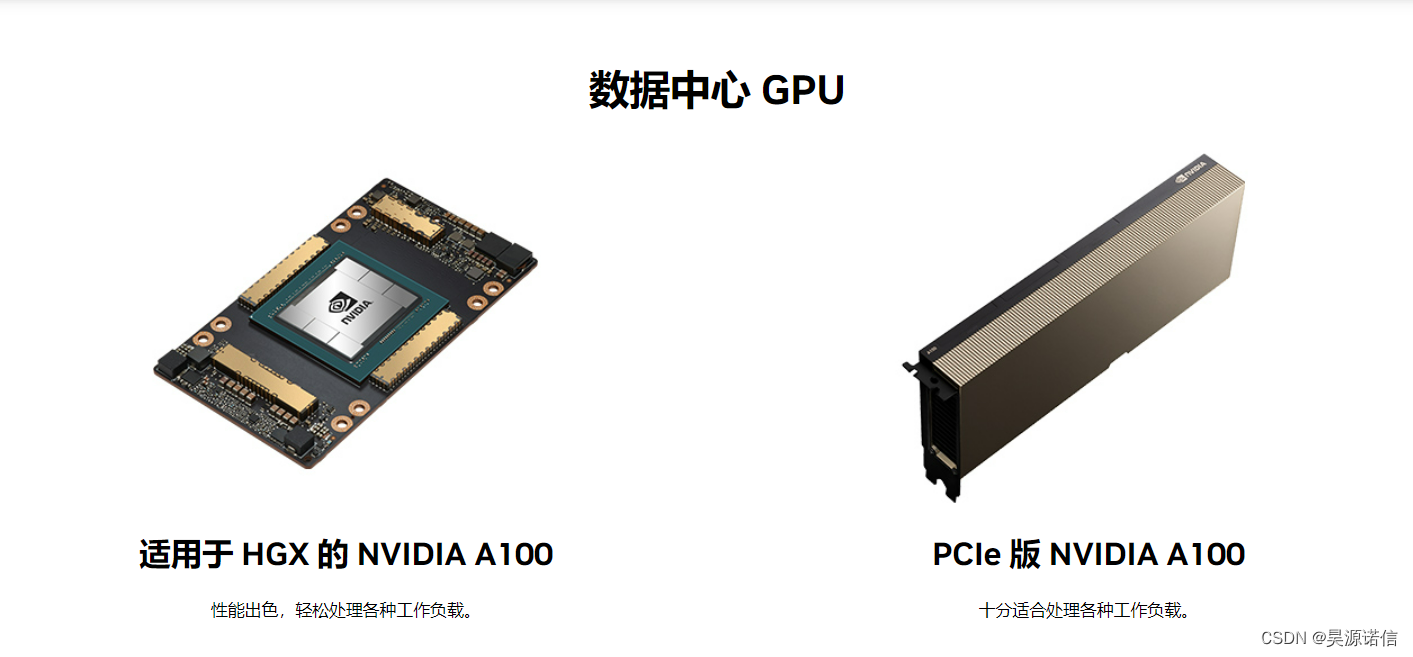

最后,如何正确选择GPU服务器?

选择GPU服务器时首先要考虑业务需求来选择适合的GPU型号。在HPC高性能计算中还需要根据精度来选择,比如有的高性能计算需要双精度,这时如果使用P40或者P4就不合适,只能使用A100或者V100;同时也会对显存容量有要求,比如石油或石化勘探类的计算应用对显存要求比较高;还有些对总线标准有要求,因此选择GPU型号要先看业务需求。

当GPU型号选定后,再考虑用什么样GPU的服务器。这时我们需要考虑以下几种情况:

第一、在边缘服务器租用上需要根据量来选择T40或者P40等相应的服务器,同时也要考虑服务器的使用场景,比如火车站卡口、机场卡口或者公安卡口等;在中心端做Inference时可能需要A100的服务器,需要考虑吞吐量以及使用场景、数量等。

第二、需要考虑客户本身使用人群和IT运维能力,对于BAT这类大公司来说,他们自己的运营能力比较强,这时会选择通用的PCI-e服务器;而对于一些IT运维能力不那么强的客户,他们更关注数字以及数据标注等,我们称这类人为数据科学家,选择GPU服务器的标准也会有所不同。

第三、需要考虑配套软件和服务的价值。

第四、要考虑整体GPU集群系统的成熟程度以及工程效率,比如像DGX这种GPU一体化的超级计算机,它有非常成熟的从底端的操作系统驱动Docker到其他部分都是固定且优化过的,这时效率就比较高。

GPU加速运算的优势就在于它可以一边由CPU运行应用程序代码,一边由图形处理单元(GPU)处理大规模并行架构的计算密集型任务。

那问题来了,什么样的GPU服务器可以满足需求。

想了解更多深度学习服务器信息,可查看【昊源诺信】