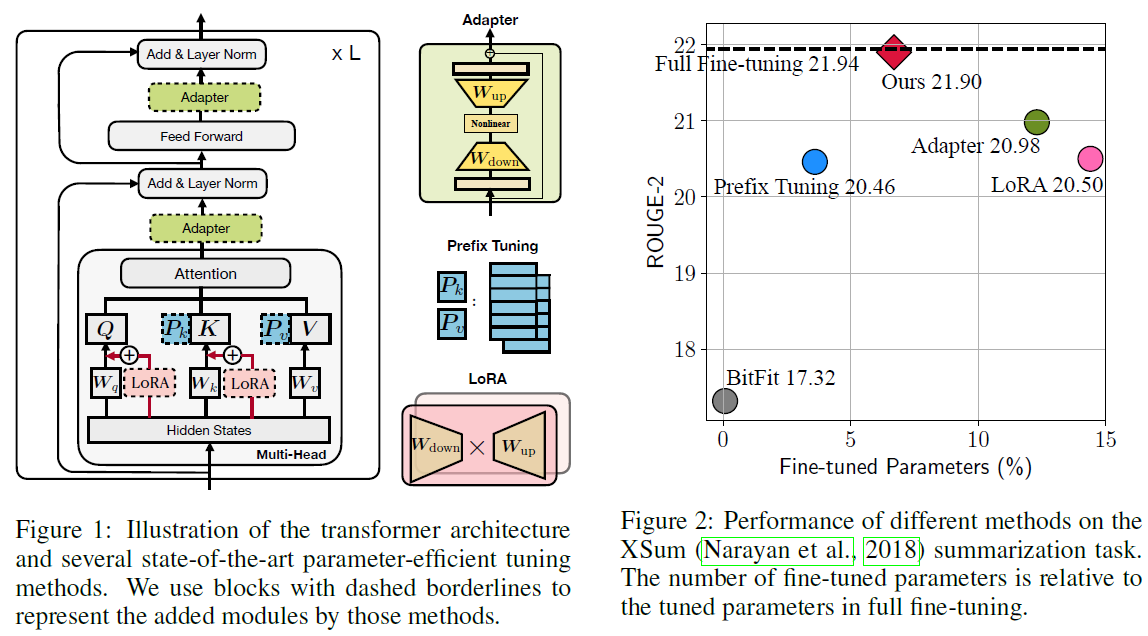

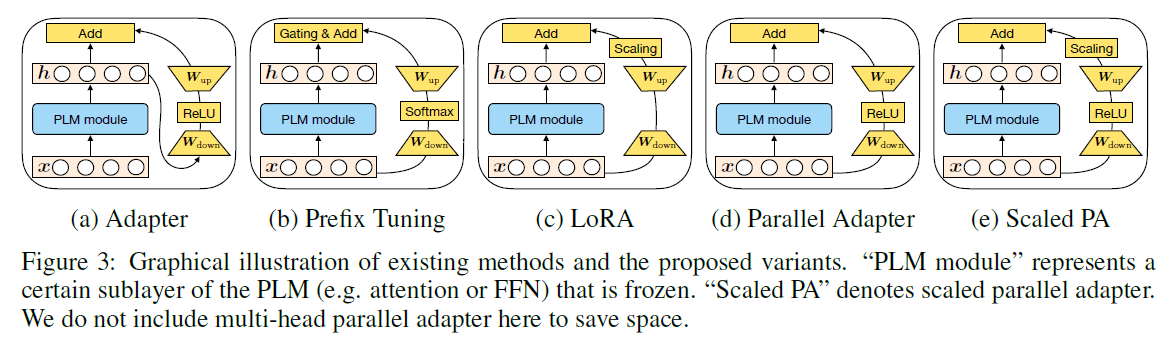

大模型-微调技术:统一框架(统一Adapter-Tuning、Prefix-Tuning、LoRA)【冻结大模型参数,微调新插入的参数层】

猜你喜欢

转载自blog.csdn.net/u013250861/article/details/131257909

今日推荐

周排行