安装Stable Diffusion webui

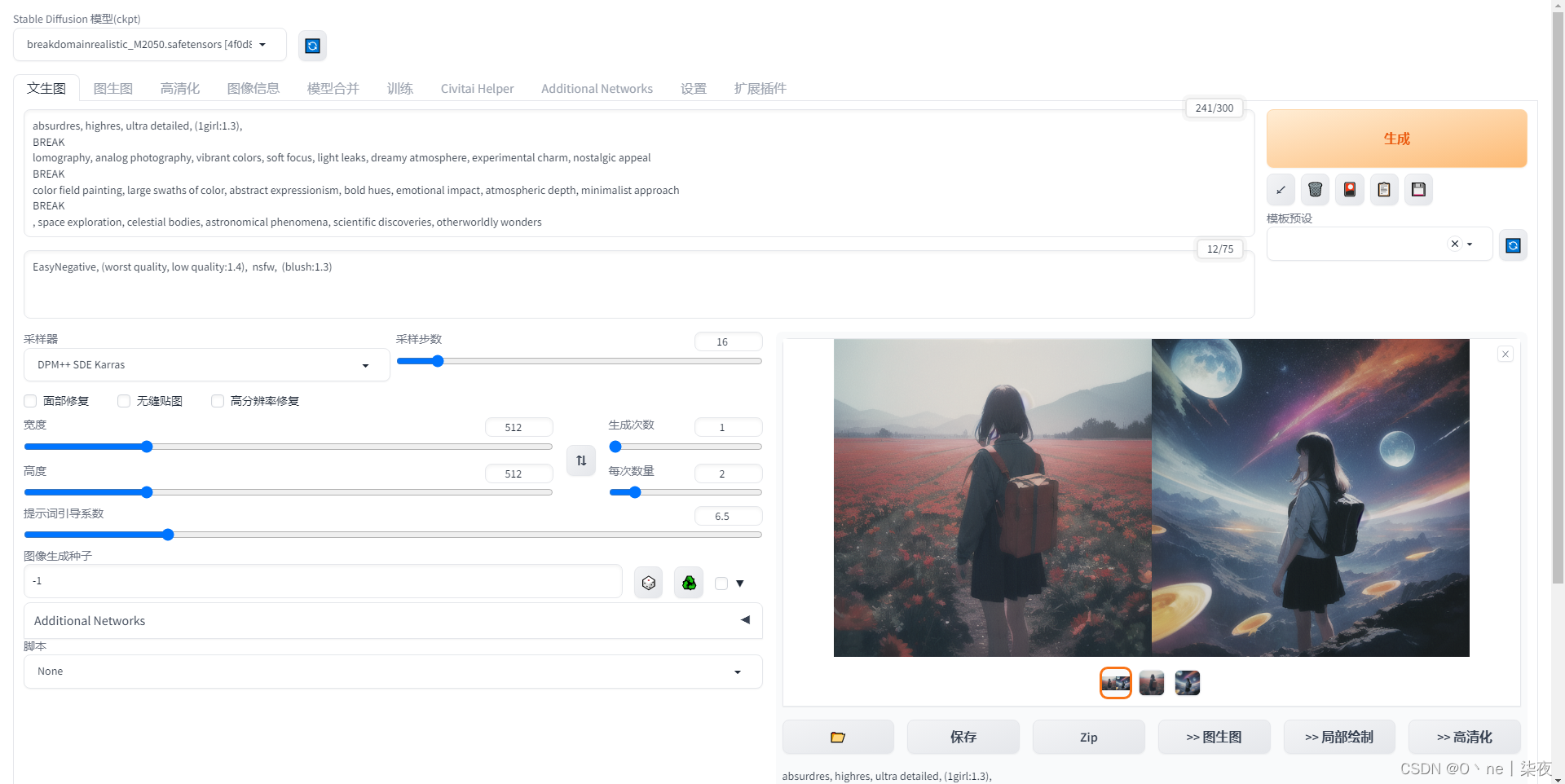

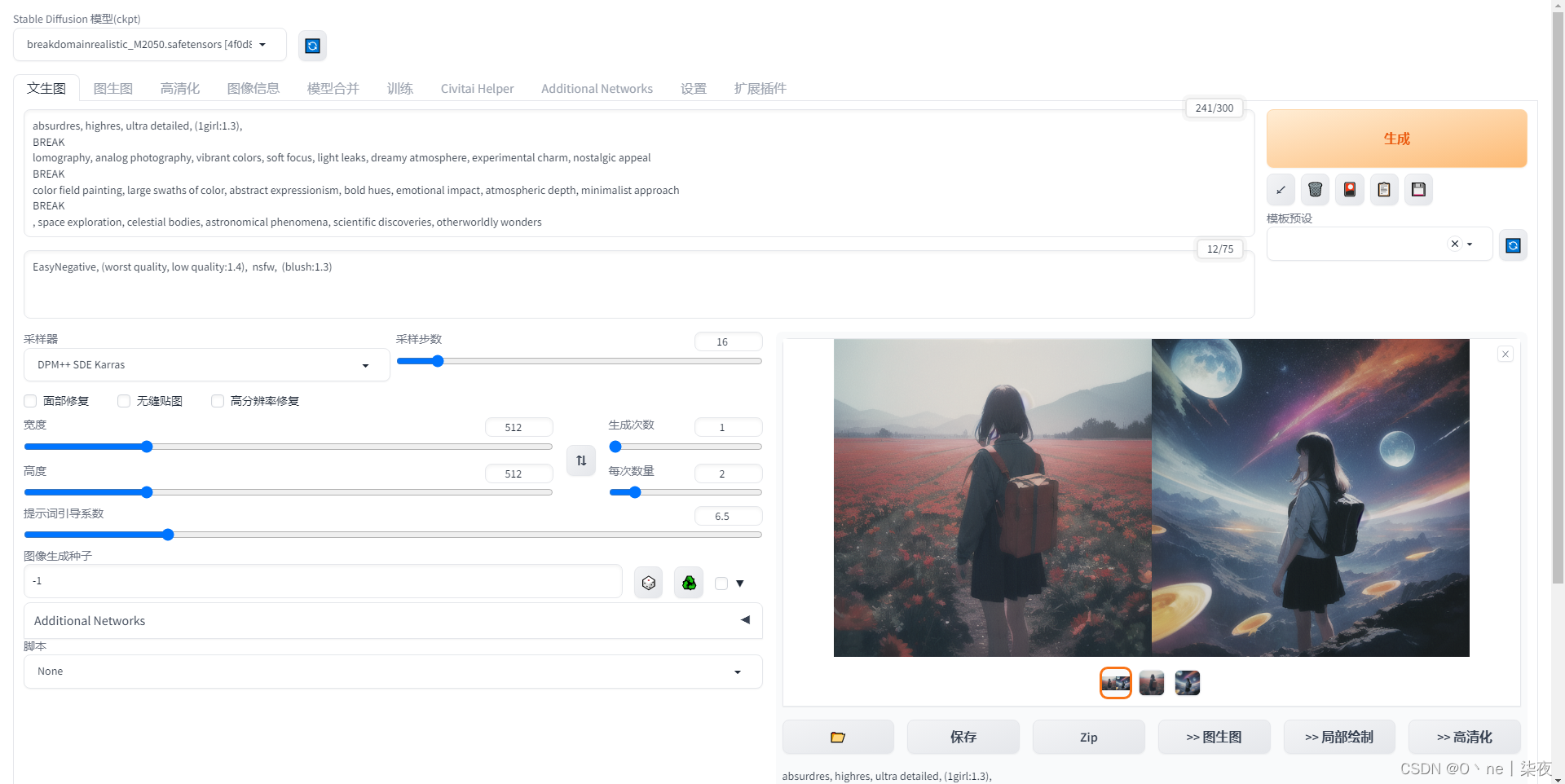

效果图:

1.准备工作

在下载 AI 绘画工具前,电脑上需要提前下载一些运行的环境

1.下载python、git

首先本地机器最好是英伟达的 N 卡,并且至少需要 4GB 显存才能在本地运行,当然,A 卡也是可以玩起来的,因为绘画对显卡是有着很高的要求的。不然的话,即使安装成功,得到的图片结果可能也是全黑图或者是根本无法进行绘制

安装的时候,需要打开魔法上网,不然无法下载绘画所需要的一些依赖

另外本地需要有 python 环境,官方要求下载 Python 3.10.6 版本

其中 python 的下载地址:https://www.python.org/downloads/

另外还需要安装 Git,下载地址:https://git-scm.com/downloads/

python 安装完成后,我们运行以下命令,将 pip 升级到最新

python -m pip install --upgrade pip2.下载Stable Diffusion webui

第一种使用 Git 命令:

git clone https://github.com/AUTOMATIC1111/stable-diffusion-webui.git第二种直接下载压缩包文件,如下图所示:

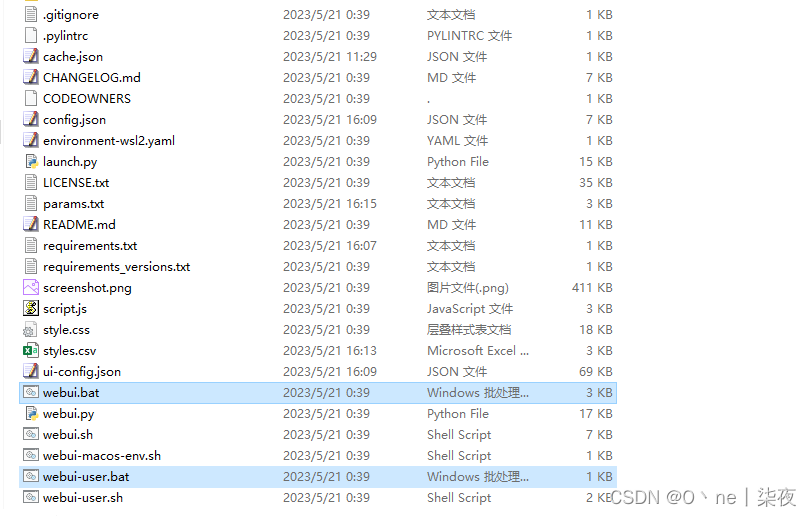

3.运行启动

下载到本地后,如果你是 windows 系统,直接双击文件夹中的 webui-user.bat

如果你是 MACOS 或者 Linux 系统,请运行命令 ./webui.sh

第一次启动会下载各种依赖,时间比较久,而且最新版加入了一个近 4GB 的默认模型 v1-5-pruned-emaonly.safetensors 也是要下载的,所以耐心等就可以了。

如果想要加快下载速度的话,可以提前下载好这个模型,然后放到 models/Stable-diffusion 文件夹中即可,然后再启动 webui-user.bat,这样就不会再重新下载这个模型了

模型默认官方下载地址:https://huggingface.co/runwayml/stable-diffusion-v1-5/tree/main

如果觉得官方默认下载缓慢,评论区我也贴上了百度云默认模型的下载地址,请自行选择

如果安装过程顺利,直接在浏览器打开 http://127.0.0.1:7860

访问成功即是安装成功,打开的页面大概如下

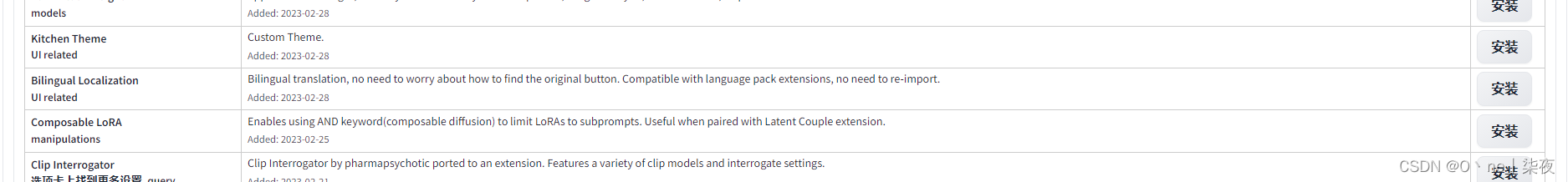

2.下载插件,汉化

汉化安装

方式1:从可用安装

点击软件界面的 Extensions 按钮,再点击 Available 可用扩展按钮,最后点击 Load from 按钮,它就能从后面的索引链接中,检索出所有可用的扩展,供自己下载了

当扩展列表列表加载出来后,我们搜索 Bilingual Localization 语言本地化插件,点击后面的 install 下载即可

方式2:从网站安装

先点击 Extensions,然后点击下面的第三个按钮 Install from URL

需要自己手动填写汉化的链接地址进行安装,这里我们可以选择 github 的链接也可以去国内 gitee 上面的链接

汉化插件的开源仓库是 sd-webui-bilingual-localization 或者 stable-diffusion-webui-chinese,搜索一下,然后把链接贴进去,点击 Install 即可

https://github.com/VinsonLaro/stable-diffusion-webui-chinese.git方式3:从网站安装

-

我们直接找到

stable-diffusion-webui/extensions扩展目录,然后打开命令行窗口在该目录下运行以下命令即可

git clone 仓库地址启用汉化

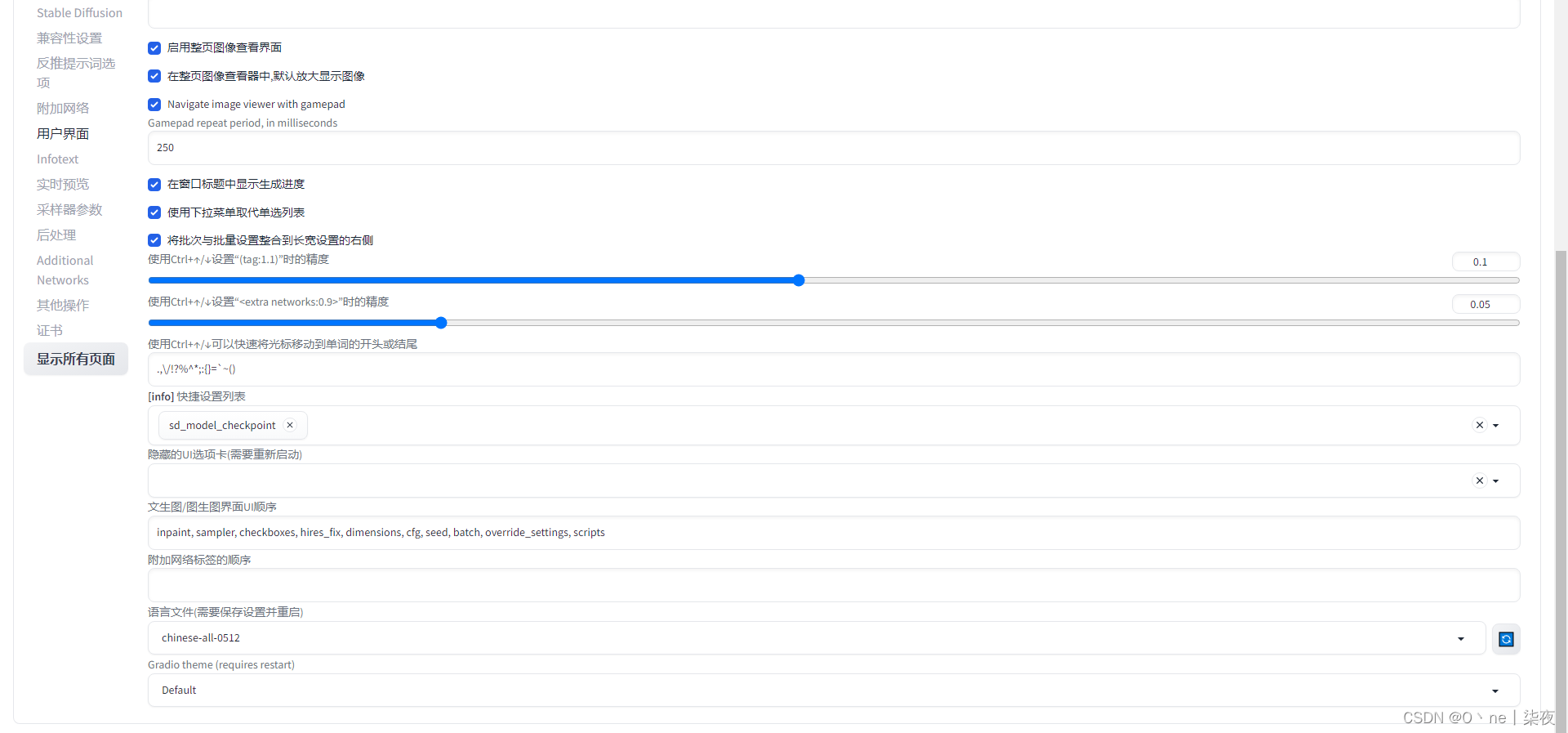

方法一:点击 Setting 按钮,再点击左侧的 Bilingual Localization 栏,在 Localization file 下拉框中选择语言即可

方法二:点击 Setting 按钮,再点击左侧的 User interface 栏,拉到最下面就可以看到插件 Localizationg 的开启窗口了

在选择好后,我们需要点击 Apply setting 保存一下配置,再点击 Reload UI 重新加载界面即可愉快的玩耍了

双语汉化

-

双语汉化仓库链接:https://github.com/journey-ad/sd-webui-bilingual-localization.git

-

上面的简单汉化,只是界面全转成中文,如果你想既显示中文又显示英文的话,需要使用双语插件

-

也是通过上面的三种方式任意一种下载好汉化插件后,需要启用它才可以看到效果

-

此时我们需要将

Setting中左侧的User interface栏下面的Localizationg的设置成None,然后再在Bilingual Localization栏Localization file下拉框中选择语言,重启UI即可

使用篇

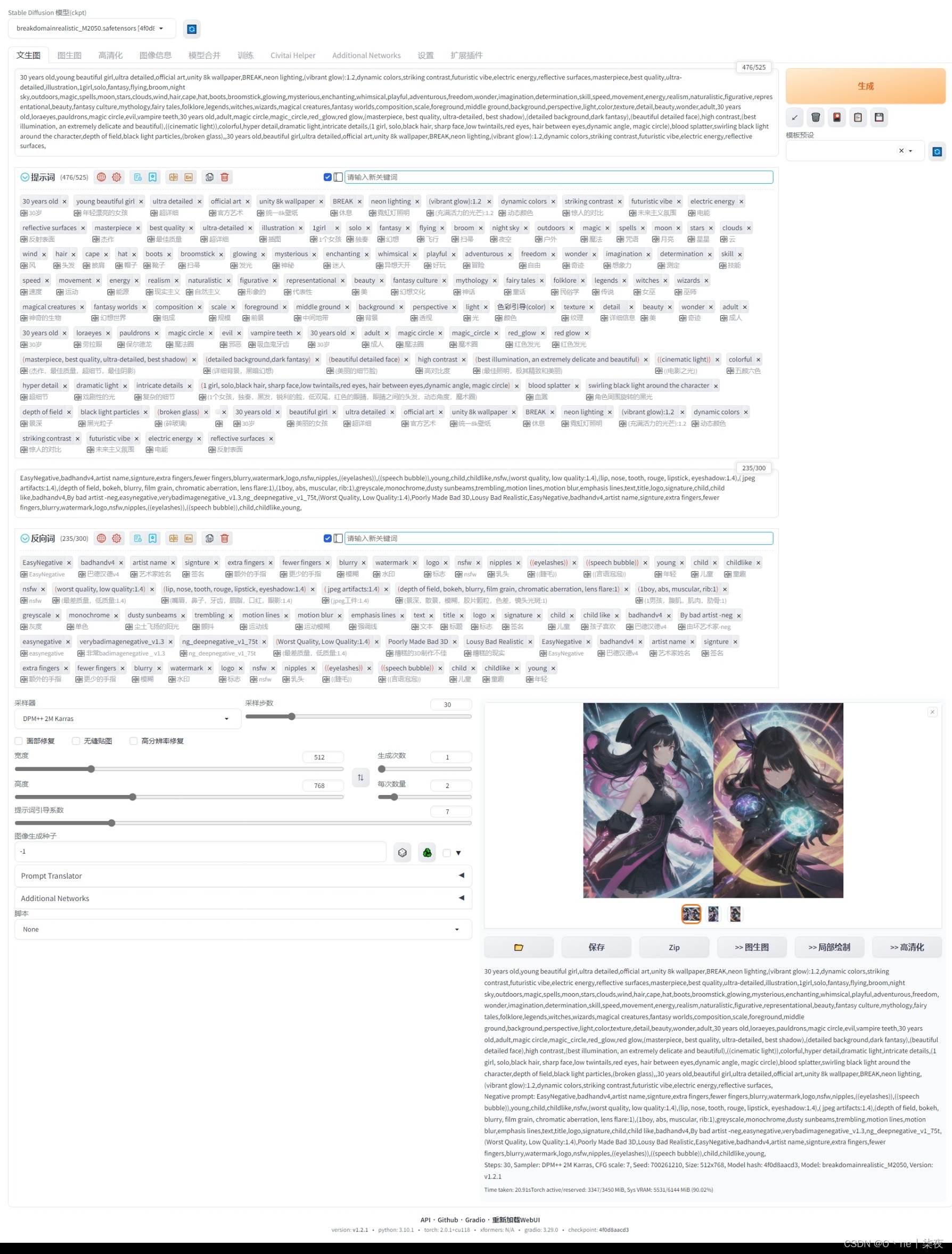

效果图:

界面参数

在使用 Stable Diffusion 开源 AI 绘画之前,需要了解一下绘画的界面和一些参数的意义

目前 AI 绘画对中文提示词的效果不好,尽量使用英文提示词

最主要一些参数如下:

Prompt:正向提示词,也就是 tag,提示词越多,AI 绘图结果会更加精准

Negative prompt:反向提示词,也就是反向 tag

Width / Height:要生成的图片尺寸。尺寸越大,越耗性能,耗时越久。

CFG scale:AI 对描述参数 Prompt 的倾向程度。值越小生成的图片越偏离你的描述,但越符合逻辑;值越大则生成的图片越符合你的描述,但可能不符合逻辑。

Sampling method:采样方法。有很多种,但只是采样算法上有差别,没有好坏之分,选用适合的即可。

Sampling steps:采样步长。太小的话采样的随机性会很高,太大的话采样的效率会很低,拒绝概率高

Seed:随机数种子。生成每张图片时的随机种子,这个种子是用来作为确定扩散初始状态的基础。不懂的话,用随机的即可

Restore faces:面部修复,优化面部的,原理是调用一个神经网络模型对面部进行修复,影响面部。修复画面中人物的面部,但是非写实风格的人物开启面部修复可能导致面部崩坏

Tiling:无缝贴图,是一种老牌优化技术,即 CUDA 的矩阵乘法优化,影响出图速度和降低显存消耗,不过实际选上之后可能连正常的图都不出来了。打死不开

Highres.fix:高分辨率修复,默认情况下,文生图在高分辨率下会生成非常混沌的图像。如果使用高清修复,会型首先按照指定的尺寸生成一张图片,然后通过放大算法将图片分辨率扩大,以实现高清大图效果

采样器

Euler a:是个插画,tag 利用率仅次于 DPM2 和 DPM2 a,环境光效菜,构图有时奇葩

Euler:柔和,也适合插画,环境细节与渲染好,背景模糊较深

Heun:单次出土平均质量比 Euler 和 Euler a 高,但速度最慢,高 step 表现好

DDIM:适合宽画,速度偏低,高 step 表现较好,负面 tag 不够时发挥随意,环境光线与水汽效果好,写实不佳

DPM2:该采样方式对 tag 的利用率最高,几乎占用 80% 以上

DPM2 a:几乎与 DPM2 相同,只是在人物的时候可能有特写

PLMS:单次出图质量仅次于 Heun

LMS:质感 OA,饱和度与对比度偏低,更倾向于动画风格

LMS Karras:会大改成优化的风格,写实不佳

DPM fast:此为上界开发者所遗留的测试工具,不适合魔术师使用

文生图(txt2img)

文生图(text2img):根据提示词 Prompt 的描述生成相应的图片

选择 绘画模型(Stable Diffusion checkpoint) ► 文生图(txt2img) ► 填写正向提示词(Prompt) ► 填写反向提示词(Negative prompt) ► 选择采样器(一般选择DPM++ 2M Karras) ► 设置采样步骤(一般设置30) ► 设置长宽(Width / Height,推荐 1024 * 1536) ► 点击生成(Generate)

根据上面的步骤,即可通过文字生成图片了,一般我们只要编写 Prompt 即可, Negative prompt 一般都是固定的,限制一下水印,低质量以及其他可能出现的逻辑错误即可

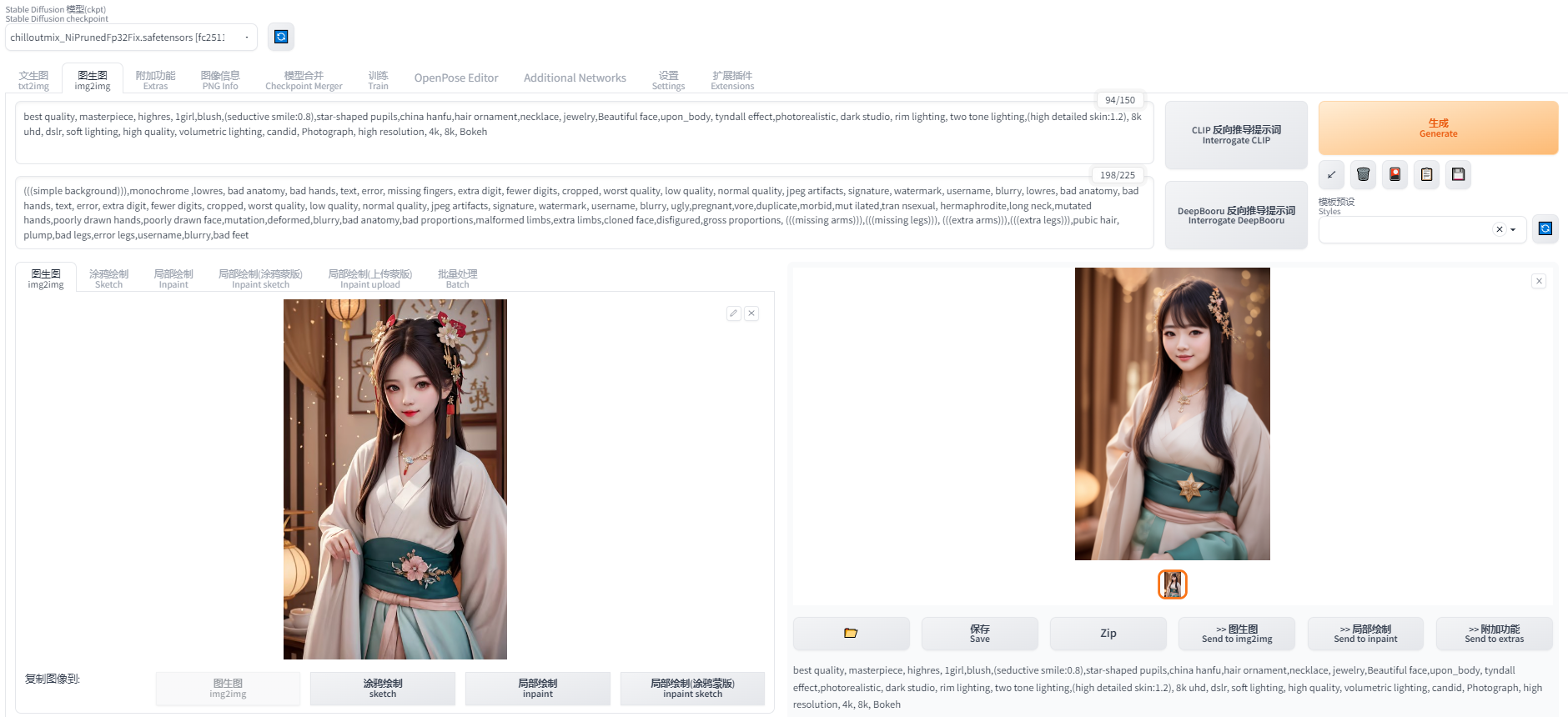

图生图(img2img)

图生图(img2img):将一张图片根据提示词 Prompt 描述的特点生成另一张新的图片

选择 绘画模型(Stable Diffusion checkpoint) ► 图生图(img2img) ► 填写正向提示词(Prompt) ► 填写反向提示词(Negative prompt) ► 选择采样器(一般选择DPM++ 2M Karras) ► 设置采样步骤(一般设置30) ► 设置长宽(Width / Height,推荐 1024 * 1536) ► 点击生成(Generate)

将上传一张图片到图生图中,进行测试一下,这里使用的是刚刚文生图的照片,根据上面的步骤,点击生成,看看效果

可以看出:AI 图生图,其实就是根据你上传的图片和你的 Prompt 生成一张跟上传差不多的照片

标签权重

在输入 Prompt 标签的时候,有时候想到啥就会写啥,默认写在前面的权重会最高

在 stable Diffusion 中也可以通过特定符号提升关键词的权重

其中 () 是加强权重,[] 是降低权重,{} 是 NAI 对 () 的“实现”,<> 用于嵌入

例如:(eye) > [eye],(eye:1.4)会比正常情况多增加约 40%,(eye:0.6)会减少约40 %

模型下载

模型网站推荐:https://civitai.com/

左上角的下拉框可以用来选择模型,其中 v1-5-pruned-emaonly.safetensors 是默认模型

默认的模型画出来的图片比较丑,所以我们需要下载更好更适合的模型来绘画

每个模型侧重绘画的风格不一样,有些适合画人,有些适合画动漫,有些适合画风景,根据自己的需求选择适合自己的绘画风格模型进行下载

下载好模型,将模型文件放入到 models/Stable-diffusion 文件夹下,重载 UI,即可看到

模型的大致区别

| 名称 | 需求 | 效果 | 备注 |

|---|---|---|---|

| stable-diffusion (4GB emaonly模型) | 2GB 显存起步 | 出图速度 10s,单次最大出 920×920 | 适合出图用 |

| stable-diffusion (7GB full ema模型) | 4GB 显存起步 | 带最后一次训练的权重,所以费显存 | 适合训练用 |

| waifu (Float 16 EMA 模型) | 2GB显存起步 | 与stable性能接近 ,显存占用略高 | 适合出图用 |

| waifu (Float 32 EMA 模型) | 2GB显存起步 | 与stable性能接近,显存占用略高 | 适合出图用,出图质量其实和16差别不大 |

| waifu (Float 32 Full 模型) | 4GB显存起步 | 与stable性能接近,显存占用略高 | 适合出图或训练用 |

| waifu (Float 32 Full + Optimizer 模型) | 8GB显存起步 | 与stable性能接近,显存占用略高 | 适合训练用 |

| Naifu (4GB pruned 模型) | 最低8GB显存&8GB显存 | 和官方比较接近 | 适合出图用 |

| Naifu (7GB latest模型) | 最低8GB显存(向上浮动10GB) | 和官方比较接近 | 适合出图或训练用 |

- 注意这里显存指的是512X512尺寸,默认配置下,出图时软件所需要占用的显存。2GB显存起步,意味浙你电脑显卡实际显存最少也要3GB(因为系统桌面,浏览器的显示也需要占用一部分显存)

- 通过增加各种“优化”参数,可以通过性能的部分下降换取显存占用减少。

- Nafu模型名称说明1:animefull-final-pruned = full-latest = NAI 全量模型(包含NSFW)

- Nafu模型名称说明2:animesfw-latest = NAI 基线模型

参考资料:

Stable Diffusion 开源地址:GitHub - AUTOMATIC1111/stable-diffusion-webui: Stable Diffusion web UI

最新版本 Stable Diffusion 开源 AI 绘画工具之使用篇_人工智能_极客飞兔_InfoQ写作社区

AI 标签生成器 极客飞兔AI标签生成器