OVS 目前有两种比较突出的架构,一种是原生的 OVS 架构(使用 kernel 作为 datapath),一种是基于 DPDK 的架构(使用用户空间作为 datapath)。

原生 OVS

原生 OVS 架构如下所示,主要包含两个组件:

-

openvswitch.ko :在内核态负责快速路径的数据转发。转发靠流表来完成,每一个流表都包含很多的匹配项(match fields)和相应的动作(actions)

-

match fields : 定义了能够标识一个数据包的头部字段

-

actions : 定义了能够对这个数据包操作的动作,比如添加或去除 VLAN 标签、修改数据包的某个头部字段,以及控制数据包从端口的进出等等。

-

-

ovs-vswitchd :在用户态负责慢速路径的数据转发。

-

ofproto: 实现 OpenFlow 交换机

-

netdev: 和网络设备(包括物理的和虚拟的)交互的抽象接口层

-

dpif: 用户空间数据转发路径的实现

-

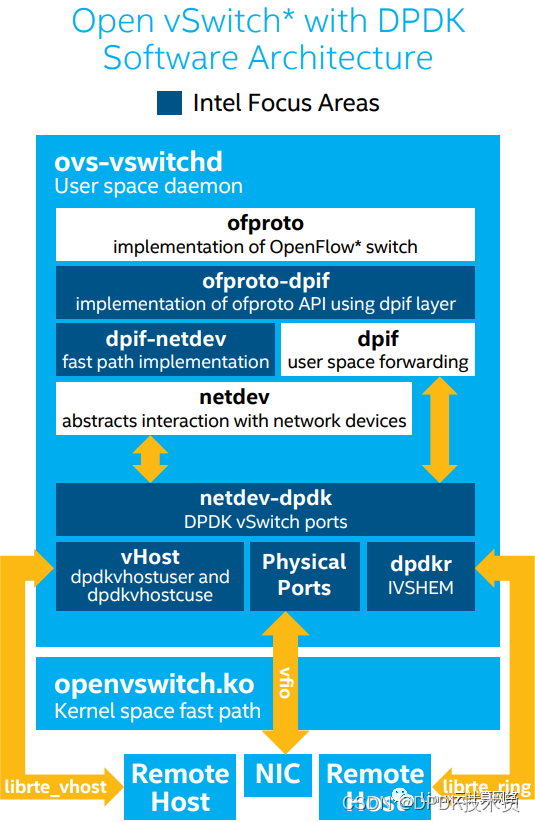

OVS-DPDK

基于 DPDK 的 OVS 架构如下所示,其中深色部分的模块就是引入 DPDK 相关的模块。

-

dpif-netdev : 用户空间中快速路径的实现,它实现了

dpif模块 API,可以直接操作netdev设备,能够实现数据包在用户空间的快速处理,减少和内核空间的切换开销。 -

ofproto-dpif : 实现了

ofproto模块 API,直接操作dpif层。 -

netdev-dpdk : 使用 DPDK 库实现了

netdev模块 API,提供了多种类型的接口,如下:-

Physical ports(PMDs) : 使用

vfio或者igb_uio实现的端口 -

dpdkvhostuser and dpdkvhostcuse: 使用

librte_vhost库实现的端口,用户可以基于这两种端口类型创建vhost-user和vhost-cuse端口来完成用户空间的数据转发,并且能够实现和 VM 的快速通信,只要提供 virtio 后端驱动 vhost 即可,virtio/vhost 被证实是用于 VM 通信的一套快速、安全、标准的接口。 -

dpdkr: 使用

librte_ring实现,用户可以基于这种端口类型创建dpdk-ring端口来完成用户空间的数据转发,它能够实现和 VM 之间快速的零拷贝通信(使用 IVSHMEM 或者其他进程间通信方式)

-

两种架构性能对比

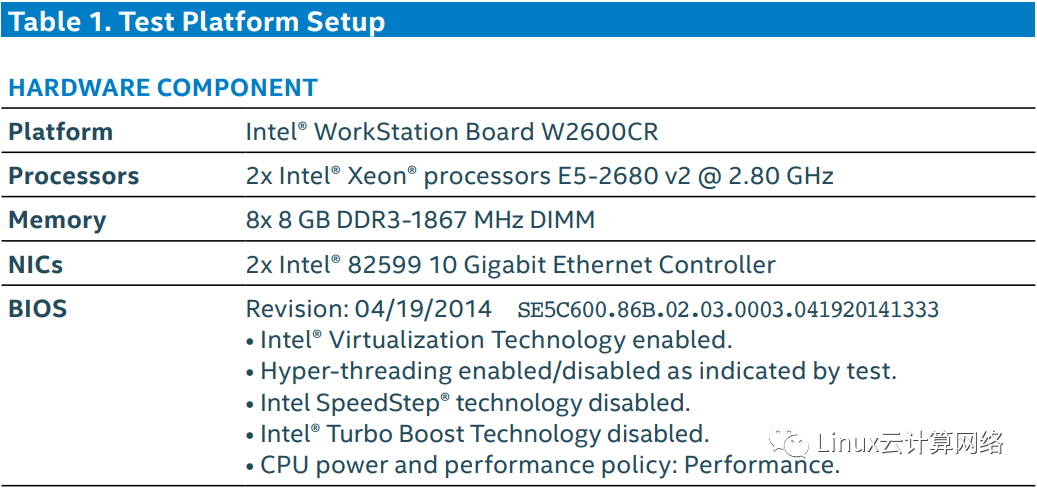

那么这两种架构哪种性能更佳呢,不用说,当然是 OVS-DPDK,我们用数据说话,看下下面这份 Intel 做的性能报告(时间是 2015 年,但也具备参考性)。

首先是实验环境参数:

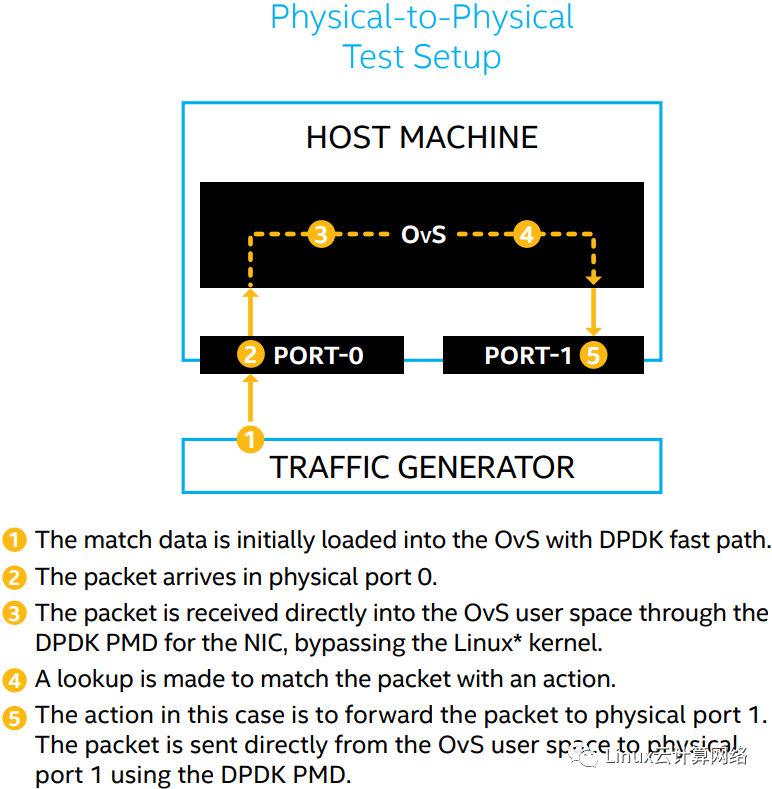

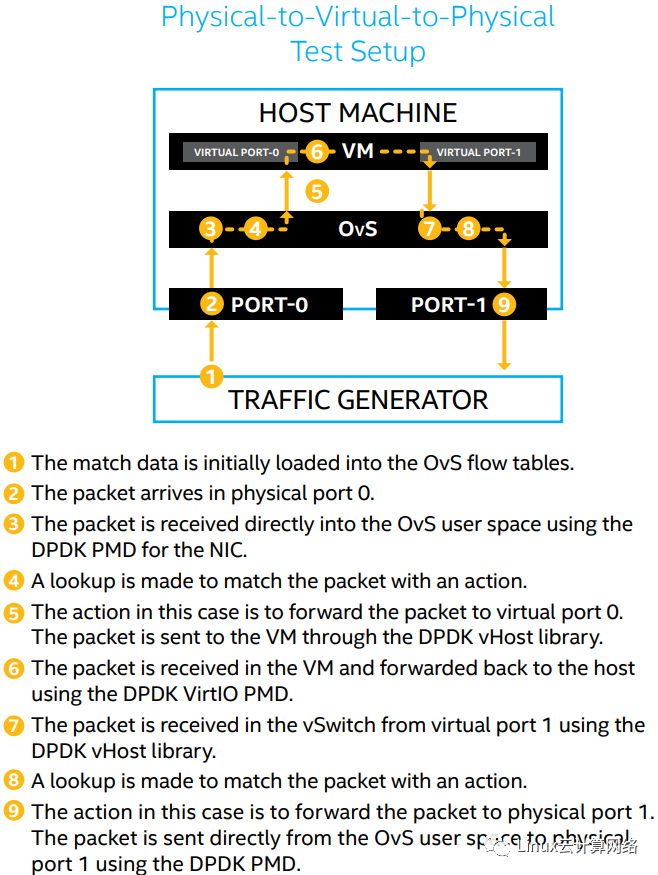

然后看实验拓扑图,包括 physical-to-physical 和 physical-to-virtual-to-physical 两种拓扑:

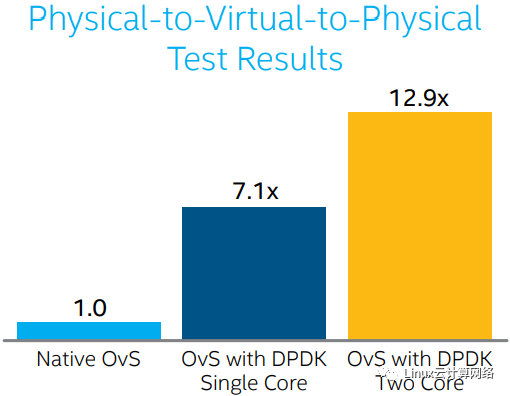

最后再来看性能对比:

同样包括 physical-to-physical 和 physical-to-virtual-to-physical 两种场景:

可以看到,P2P 的场景,OVS-DPDK 比原生 OVS 性能提高差不多 12 倍。

对于 PVP 的场景,我们增加单核和多核的实验观察,单核的情况,OVS-DPDK 比原生 OVS 提高 7 倍,双核的情况提高接近 13 倍。

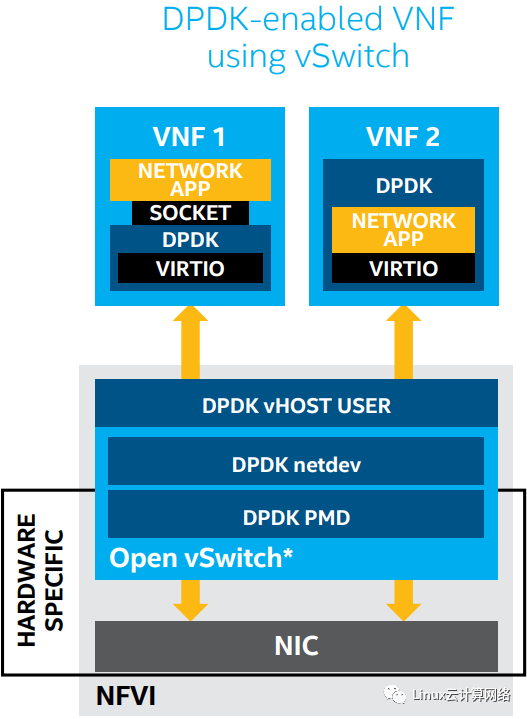

基于 DPDK 的 VNF 使用 OVS 作为数据面

基于 OVS-DPDK 的 VNF 架构如下图所示:

DPDK 在其中既加速 OVS 数据平面,又加速 VNF 应用,这种方案由于采用纯软件的形式实现,可编程灵活,DPDK 的参与也使得性能大大提高,基本可以媲美纯硬件的形式。

原文链接:https://mp.weixin.qq.com/s/We-1j7WZgyu9vHp9UBQVYg

【文章福利】:小编整理了一些个人觉得比较好的学习书籍、视频资料共享在君羊文件里面,有需要的可以自行添加哦!~点击909332607加入(需要自取)

(资料包括:Dpdk/网络协议栈/vpp/OvS/DDos/NFV/虚拟化,tcp/ip,plugin,feature,柔性数组,golang,mysql,linux,Redis,CDN等),免费分享~

Dpdk/网络协议栈/ vpp /OvS/DDos/NFV/虚拟化/高性能专家 学习地址:https://ke.qq.com/course/506620