method: 请求方法 get post

url: 请求的链接地址

反扒的三剑客

headers: ( 可选的) 构建请求头字段的关键字参数, 构建字典

cookies: ( 可选的) 通过这个关键字传递cookies字段信息, 构建字典

proxies: ( 可选的) ip代理的关键字参数, 构建字典

请求参数的三剑客

params: ( 可选的) 构建查询参数的关键字

data: ( 可选的) 构建请求参数的关键字

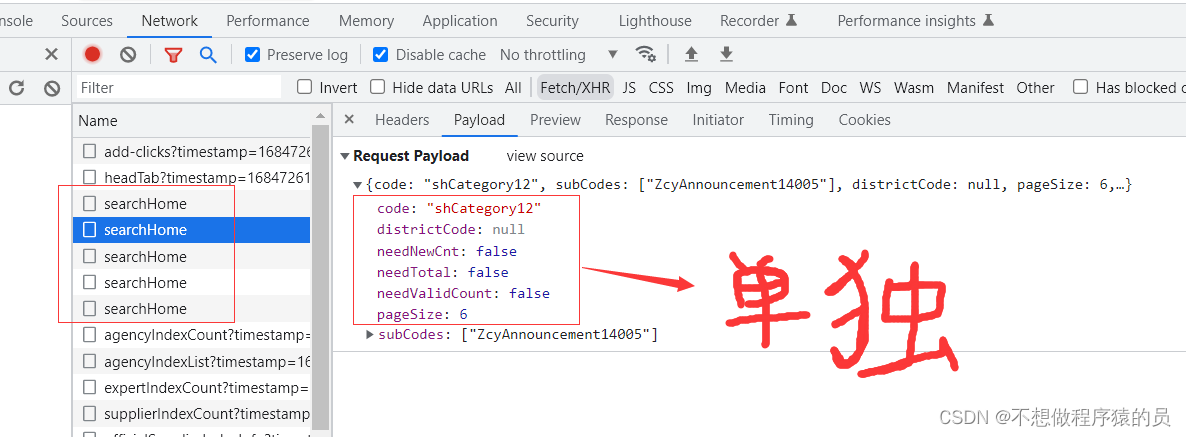

json: ( 可选的) 以 json 数据提交的请求参数关键字, 构建字典

timeout: ( 可选的) 设置响应时间, 单位/ 秒, 如果超过这个时间程序会报错 最大180 秒

allow_redirects: ( 可选的) 是否允许重定向, 默认如果发生了重定向, 会自动重定向, 设置布尔值

verify: ( 可选的) 是否验证网站证书 ca证书 ssl证书, 默认为Ture, 默认会校验证书 返回警告

files: ( 可选的) 文件操作

stream: ( 可选的) 数据流数据, 是都是数据流数据, 实时更新的数据( 直播, 弹幕, 股票)

import requests

url = 'http://www.zfcg.sh.gov.cn/front/search/category'

json_data = {

"utm" : "sites_group_front.2ef5001f.0.0.07ec2550d86011edb93db70f086e4f9a" ,

"categoryCode" : "ZcyAnnouncement3012" ,

"pageSize" : '15' ,

"pageNo" : '1'

}

response = requests. post( url= url, json= json_data)

print ( response. json( ) )

①.在请求头headers中一起构建

cookies = {

'BAIDUID' : '963EC08DDD8CA5647A50D2ED99D0CCF2:SL=0:NR=10:FG=1' ,

'BAIDUID_BFESS' : '963EC08DDD8CA5647A50D2ED99D0CCF2:SL=0:NR=10:FG=1' ,

'ZFY' : 'fVb9op8tO3yhpq3TJlvkhdkE8iS3bLYoA53APCw5awg:C' ,

'1.0.1_MDJhNTY0OGI3NzhkNjMxNGE5ZWY3MzNiNGI3OGJiMjRmYjJlNGQ2NThkYjYyNzc5OTllMWEwZWFiMDM5MjBlODYwOWI4Y2M0Zjc5NWNkMGFjNmI5OGM2NDkwOTBmNjAxYzVjZTdiMTc3ZjkxMWQ4ZTM0OWNkYTA0MjA1ZDI4MjE5ZmIyMGJlYjM2MjY2NTBjM2EzNGI5NmIxMDEzYjJmOTFjM2FhNDliYWQ5Y2M5YjdlYWU0MWJhZTU2YzRiYmM3' ,

. . . . . .

}

import requests

requests. packages. urllib3. disable_warnings( )

url = 'https://data.stats.gov.cn/'

response = requests. post( url= url, verify= False )

print ( response. text)

"""

requests.exceptions.SSLError: 网站没有证书引发的报错, 因为requests模块会默认校验证书

"""

import requests

url = 'https://github.com/'

response = requests. post( url= url, timeout= 0.1 )

print ( response. text)

import requests

url = 'http://github.com/'

response = requests. post( url= url, allow_redirects= False )

print ( response. status_code)

print ( response. url)