目录

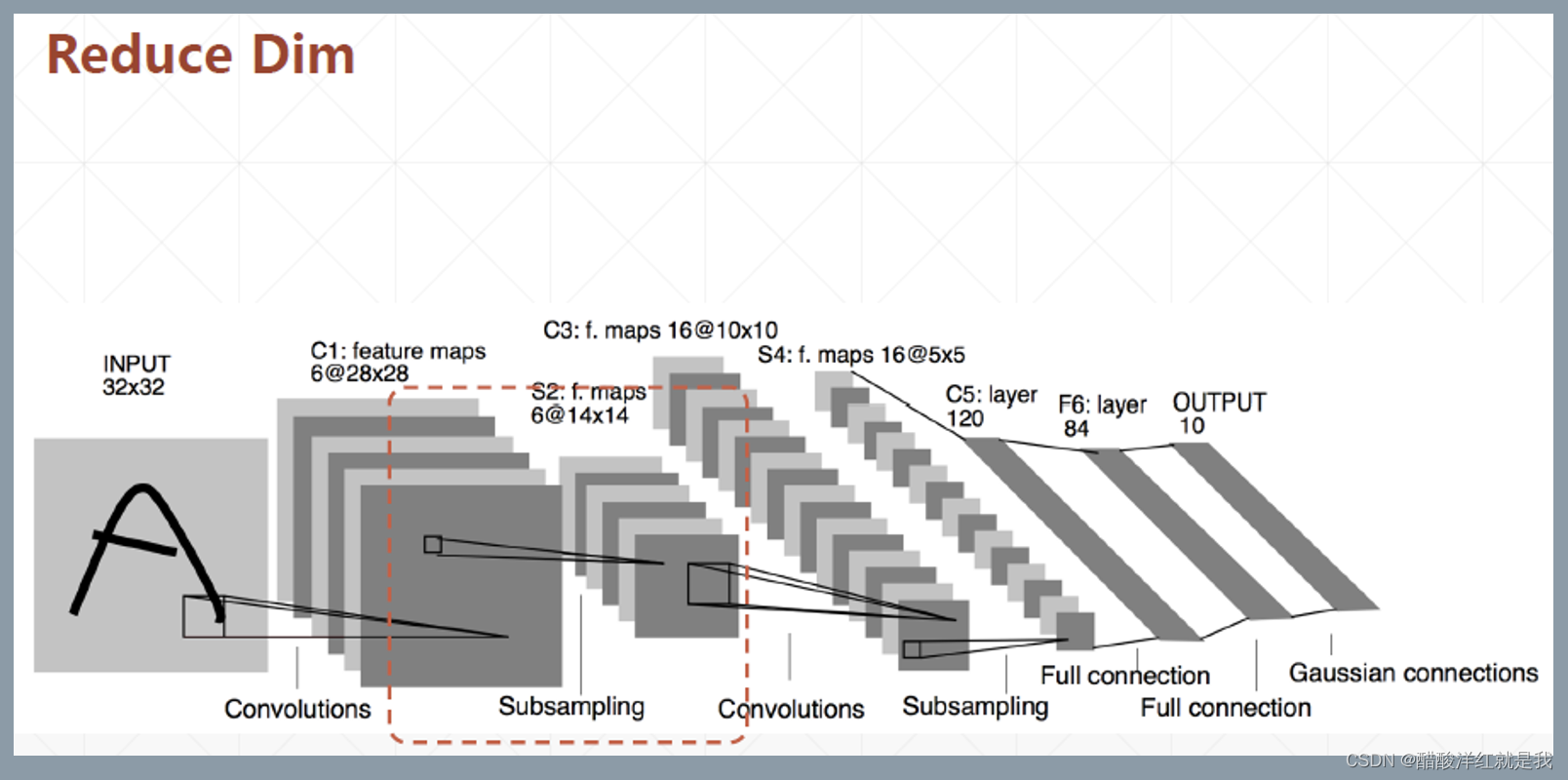

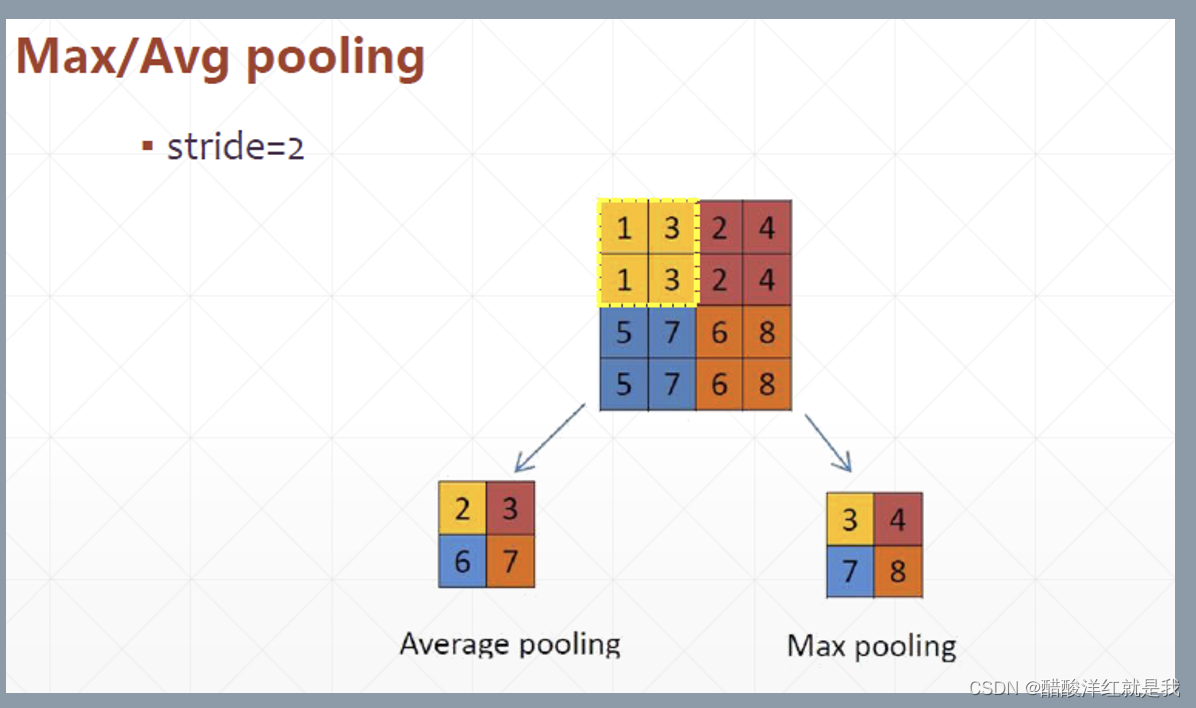

Pooling(池化)

在降采样(Subsampling)中起作用,在不改变feature map的基础上,在卷积出来的基础上进一步降低宽高

此处stride是滑动几个格子进行下一次计算

#x的维度为[1,14,14,4]

pool=layers.MaxPool2D(2,strides=2)

out=pool(x)

TensorShape([1,7,7,4]) 注:此处7是由⌊14/2⌋-(2-2)得到,公式为⌊宽高/strides⌋-(计算区域的大小-strides)

#x的维度为[1,14,14,4]

pool=layers.MaxPool2D(3,strides=2)

out=pool(x)

TensorShape([1,6,6,4])

#x的维度为[1,14,14,4]

#另外一种写法

out=tf.nn.max_pool2d(x,2,strides=2,padding='VALID')

TensorShape([1,7,7,4])

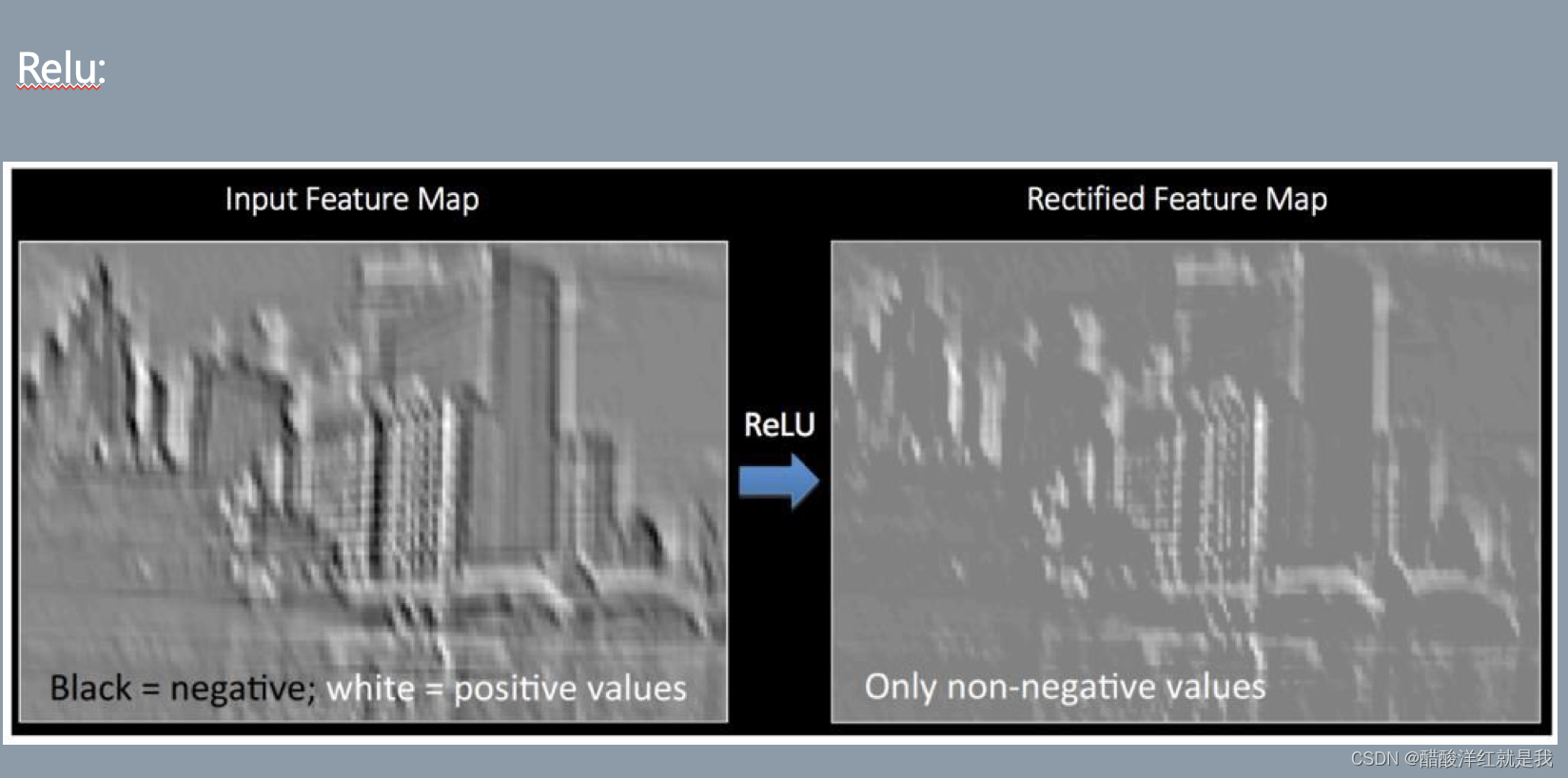

Relu

在线性层作为激活函数,把x轴上的负数全部变为0,正数保持不变

ResNet

很多利用卷积神经网络的东西都要引用ResNet这篇论文

通过一个残差卷积神经网络模块,可以自动的让模型去选择使用几层卷积神经网络解决问题

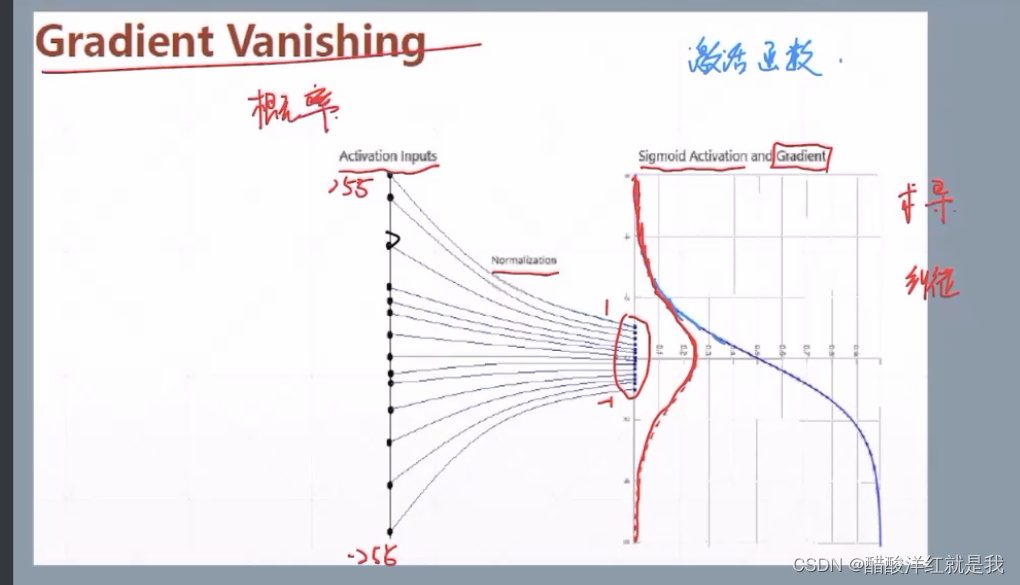

Gradient Vanishing

梯度消失

当神经网络到达一定长度时,就会出现梯度消失,也就是梯度值变得特别小,那么在更新参数的时候(w=w- d y d w \frac{dy}{dw} dwdy*lr),w就相当于几乎不变

Feature scaling

特征缩放

Image Normalization

一般初始化时使用,当图片给定时一般不使用

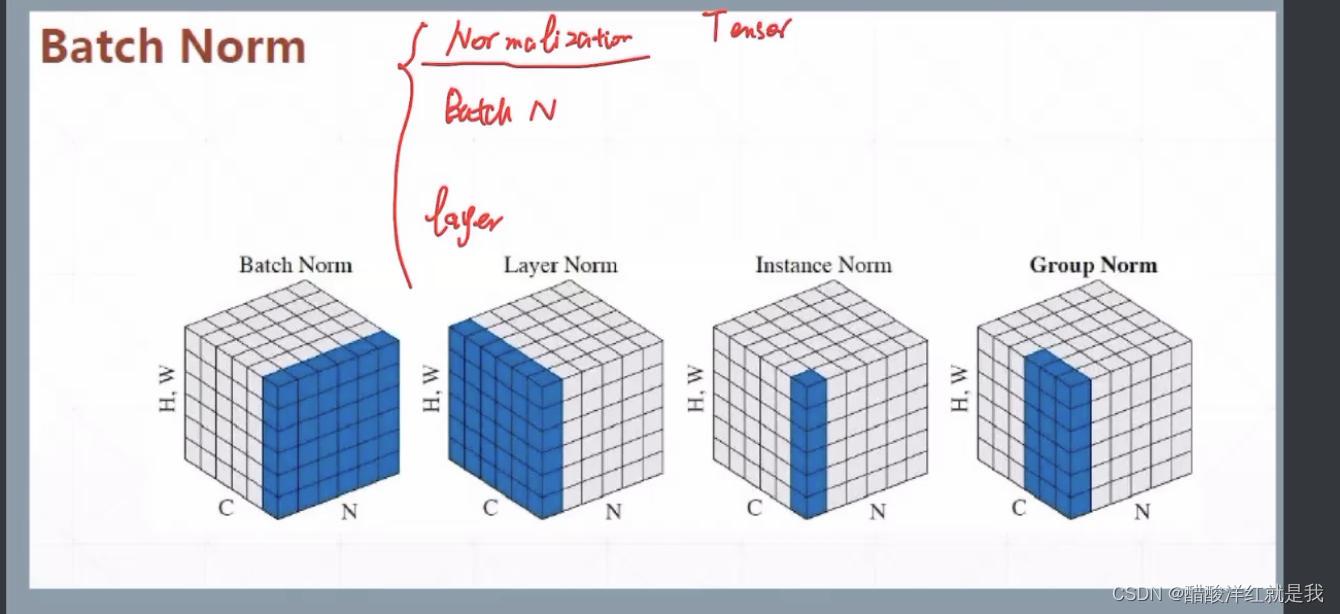

Batch Normalization

批量标准化

net=layers.BatchNormalization()

net(x,training=None)