Request库的入门

下载Request库后,在IDLE中输入以下代码:

>>> import requests

>>> r=requests.get("http://www.baidu.com")

>>> r.status_code

200

>>> r.encoding='utf-8'

>>> r.text

将会输出:

'<!DOCTYPE html>\r\n<!--STATUS OK--><html> <head><meta http-equiv=content-type content=text/html;charset=utf-8><meta http-equiv=X-UA-Compatible content=IE=Edge><meta content=always name=referrer><link rel=stylesheet type=text/css href=http://s1.bdstatic.com/r/www/cache/bdorz/baidu.min.css><title>百度一下,你就知道</title></head> <body link=#0000cc> <div id=wrapper> <div id=head> <div class=head_wrapper> <div class=s_form> <div class=s_form_wrapper> <div id=lg> <img hidefocus=true src=//www.baidu.com/img/bd_logo1.png width=270 height=129> </div> <form id=form name=f action=//www.baidu.com/s class=fm> <input type=hidden name=bdorz_come value=1> <input type=hidden name=ie value=utf-8> <input type=hidden name=f value=8> <input type=hidden name=rsv_bp value=1> <input type=hidden name=rsv_idx value=1> <input type=hidden name=tn value=baidu><span class="bg s_ipt_wr"><input id=kw name=wd class=s_ipt value maxlength=255 autocomplete=off autofocus></span><span class="bg s_btn_wr"><input type=submit id=su value=百度一下 class="bg s_btn"></span> </form> </div> </div> <div id=u1> <a href=http://news.baidu.com name=tj_trnews class=mnav>新闻</a> <a href=http://www.hao123.com name=tj_trhao123 class=mnav>hao123</a> <a href=http://map.baidu.com name=tj_trmap class=mnav>地图</a> <a href=http://v.baidu.com name=tj_trvideo class=mnav>视频</a> <a href=http://tieba.baidu.com name=tj_trtieba class=mnav>贴吧</a> <noscript> <a href=http://www.baidu.com/bdorz/login.gif?login&tpl=mn&u=http%3A%2F%2Fwww.baidu.com%2f%3fbdorz_come%3d1 name=tj_login class=lb>登录</a> </noscript> <script>document.write(\'<a href="http://www.baidu.com/bdorz/login.gif?login&tpl=mn&u=\'+ encodeURIComponent(window.location.href+ (window.location.search === "" ? "?" : "&")+ "bdorz_come=1")+ \'" name="tj_login" class="lb">登录</a>\');</script> <a href=//www.baidu.com/more/ name=tj_briicon class=bri style="display: block;">更多产品</a> </div> </div> </div> <div id=ftCon> <div id=ftConw> <p id=lh> <a href=http://home.baidu.com>关于百度</a> <a href=http://ir.baidu.com>About Baidu</a> </p> <p id=cp>©2017 Baidu <a href=http://www.baidu.com/duty/>使用百度前必读</a> <a href=http://jianyi.baidu.com/ class=cp-feedback>意见反馈</a> 京ICP证030173号 <img src=//www.baidu.com/img/gs.gif> </p> </div> </div> </div> </body> </html>\r\n'

r.encoding:如果header中不存在charset,则认为编码为ISO-8859-1

r.apparent_enconding:根据网页内容分析出的编码方式

扫描二维码关注公众号,回复:

1574572 查看本文章

爬取网页的通用代码框架

import requests

def getHTMLText(url):

try:

r=requests.get(url,timeout=30)

r.raise_for_status()#如果状态不是200,引发HTTPError异常

r.encoding=r.apparent_encoding

return r.text

except:

return"产生异常"

if __name__ == "__main__":

url="http://www.baidu.com"

print(getHTMLText(url))

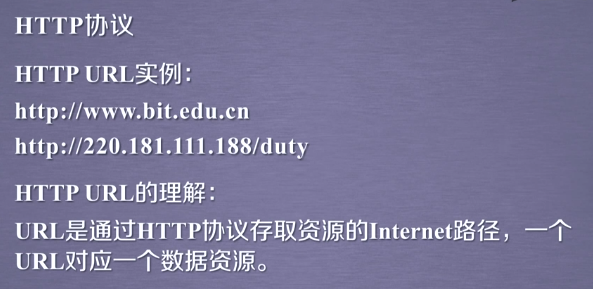

HTTP协议

Hypertext Transfer Protocol,超文本传输协议,是一个基于“请求与响应”模式的、无状态的应用层协议。采用URL作为定位网络资源的标识。

网络爬虫引发的问题

Robots协议

Robots Exclusion Standard 网络爬虫排除标准

作用:网络告知网络爬虫哪些页面可以抓取,哪些不行。

形式:在网络根目录下的robots.txt文件。

https://www.jd.com/robots.txt

User-agent: * Disallow: /?* #不允许访问?开头的路径 Disallow: /pop/*.html Disallow: /pinpai/*.html?* User-agent: EtaoSpider #以下4个爬虫不允许爬取任何数据 Disallow: / User-agent: HuihuiSpider Disallow: / User-agent: GwdangSpider Disallow: / User-agent: WochachaSpider Disallow: /

Robots协议的遵守方式

网络爬虫:自动或人工识别robots.txt,再进行内容爬取

约束性:Pobots协议是建议但非约束性,网络爬虫可以不遵守,但存在法律风险。

Request库的实战

例1京东商品页面爬取

import requests

url="https://item.jd.com/2967929.html"

try:

r=requests.get(url)

r.raise_for_status()#如果状态不是200,引发HTTPError异常

r.encoding=r.apparent_encoding

print(r.text[:1000])

except:

print("爬取失败")

例2亚马逊商品

import requests

url="https://www.amazon.cn/gp/product/B01M8L5Z3Y"

try:

kv={'user-agent':'Mozilla/5.0'}

r=requests.get(url,headers=kv)

r.raise_for_status()#如果状态不是200,引发HTTPError异常

r.encoding=r.apparent_encoding

print(r.text)

except:

print("爬取失败")

例 百度360关键词提交

import requests

keyword="Python"

try:

kv={'wd':keyword}

r=requests.get("http://www.baidu.com/s",params=kv)

print(r.request.url)

r.raise_for_status()

print(len(r.text))

except:

print("爬取失败")

import requests

keyword="Python"

try:

kv={'q':keyword}

r=requests.get("http://www.so.com/s",params=kv)

print(r.request.url)

r.raise_for_status()

print(len(r.text))

except:

print("爬取失败")

例 网络图片的爬取与存储

import requests

import os

url="https://www.nationalgeographic.com/content/dam/animals/pictures/mammals/c/cheetah/cheetah.adapt.885.1.JPG"

root="D://"

path=root+url.split('/')[-1]

try:

if not os.path.exists(root):

os.mkdir(root)

if not os.path.exists(path):

r=requests.get(url)

with open(path,'wb') as f:

f.write(r.content)

f.close()

print("文件保存成功")

else:

print("文件已存在")

except:

print("爬取失败")

例 IP地址归属地的自动查询

import requests

url="http://m.ip138.com/ip.asp?ip="

try:

r=requests.get(url+'202.204.80.112')

r.raise_for_status()

r.encoding=r.apparent_encoding

print(r.text[-500:])

except:

print("爬取失败")

通过这个实例我们可以知道,人与网站的交互是通过点击按钮从而产生链接来进行的。