“ 过去在的 Stable Diffusion 下,若要固定某个人的脸,就要事先训练 LoRa 。这样的过程往往复杂而耗时,限制了创作者的创作效率。然而最近有一个新工具在最近引起了广泛的讨论和关注,只要一张照片,就可以让 AI 做出这个人的不同动作,让创作者不必要再为了训练模型而分心,大大提高创作速度。”

01

—

reference only

这种方法类似于基于修复的参考方法,但不会使您的图像变得混乱。

许多专业的stable diffusion用户知道一种使用修复的参考图像来扩散图像的技巧。例如,如果您有一张512x512的狗的图像,并且想要生成另一张512x512的具有相同狗的图像,一些用户会将512x512的狗图像和512x512的空白图像连接成一个1024x512的图像,发送给修复算法,并遮罩掉空白的512x512部分以扩散具有相似外观的狗。然而,这种方法通常不是很令人满意,因为图像是连接在一起的,会出现许多失真。

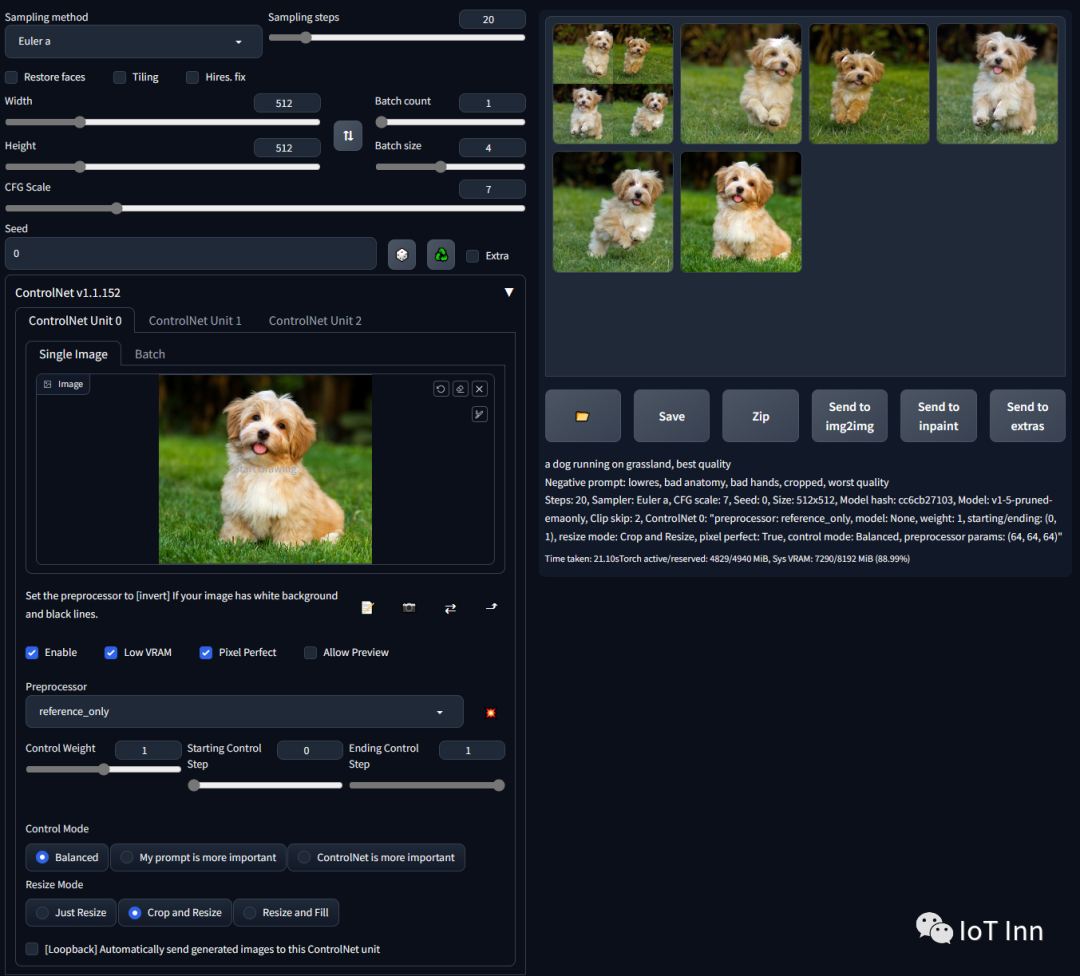

这个使用preference only的ControlNet可以直接连接您的SD的注意力层与任意独立图像,这样您的SD就可以读取任意图像作为参考。您使用时,只需选择仅参考作为预处理器并输入一张图像。您的SD将只使用该图像作为参考。请注意,这种方法尽可能“无偏见”。它只包含非常基本的连接代码,没有任何个人偏好,用于将注意力层与参考图像连接起来

02

—

安装preference only

首先需要在SD中安装ControlNet,具体方法在我之前的文章中有介绍ControlNet让SD变得可控 (qq.com),然后在web页面打开扩展标签,检查更新,完成后保存并重启UI。如果出现无法更新或者更新后报错,可以尝试从网址安装https://github.com/Mikubill/sd-webui-controlnet.git

安装完成后,重启SD,然后点开文生图,就可以看到ControlNet的版本变成了1.1.231,然后我们在预处理下拉框选项就可以看到preference only选项

03

—

preference only体验

首先我们选择模型,老样子我们还是选择NED,然后我们输入简单的prompt,生成一张图片

然后将这张图片拖到controlnet标签页,启用controlnet,预处理器选择preference only,选择pixel perfect,其他保持默认,cfg=9,sample steps=30然后生成如下图片:

看上去简直一模一样,除了手势和衣服。然后我们多调整几个参数再试试,cfg=7,sample steps=30

这效果简直不要太炸裂,这还需要啥LoRA,只需要第一张参考图片即可保持原样风格。想尝试的朋友点个关注,按照文中的方式试试吧。