生成式AI(Generative AI)已经成为全球范围内的一个重要趋势,得到越来越多企业和研究机构的关注和应用。纽约时间7月26日,亚马逊云科技数据库、数据分析和机器学习全球副总裁Swami Sivasubramanian在亚马逊云科技举办的纽约峰会上更是表示,“生成式AI技术已经达到临界点。”

目前我们观察到,随着机器学习、深度学习等技术的不断迭代,生成式AI的应用趋势正朝着端到端的方向发展。而本次峰会上亚马逊云科技宣布的“生成式AI创新”也是将“端到端”显示的淋漓尽致,进一步降低了生成式AI的使用门槛,无论是业务用户还是开发者都可以从中受益,来自千行百业的企业都能更专注于核心业务,提高生产效率,充分释放数据价值和生成式AI的潜力。

生成式AI的第一要务是“帮用户解决生产问题”

随着人工智能技术的快速发展,生成式AI已经得到了越来越多的生产者和企业的关注和应用,进入高速发展期。生成式AI技术可以通过学习大量的数据和知识,然后生成新的数据和内容,例如图像、文本、声音等;其可以应用于许多领域,例如自然语言处理、图像处理、语音识别等。在生产环境中,生成式AI技术可以用来自动化许多繁琐的工作,例如编写代码、设计产品、翻译文本等。帮助企业提高生产效率、降低生产成本、提高产品质量,为企业的创新和发展提供强有力的支持。

在生成式AI技术的发展中,推动技术研发厂商不断前进的动力就是用户“既要又要还要”的业务需求和技术需求。在满足用户需求方面,亚马逊云科技是业内做的相当不错的厂商,前段时间推出的Amazon Bedrock便是一大利器,通过Amazon Bedrock,文本生成、聊天机器人、搜索、文本摘要、图像生成、个性化情景式产品推荐等功能实例可以完美集成于应用中。

从训练和部署、架构扩展层面,一个好的模型需要易于训练和部署、提高效率,并能够随着业务需求变化进行扩展和升级。Amazon Bedrock提供可扩展的API和无服务器体验,客户可以使用自有数据基于基础模型进行定制,并使用熟悉的工具和能力进行集成和部署,无需管理基础设施,降低成本。用户还可以使用SageMaker、Experiments和Pipelines等功能实现模型的集成和自动化管理、部署。

在数据安全层面,好的模型需要具备安全的数据存储能力,能够保护用户的数据不被泄露和滥用。而Bedrock非常注重数据的安全性和隐私保护,对所有数据都进行了加密,并且不会离开客户的虚拟私有网络(VPC)。此外,Amazon Bedrock还提供了可配置的数据共享选项,客户可以控制数据共享和使用,确保数据的完整性和机密性。

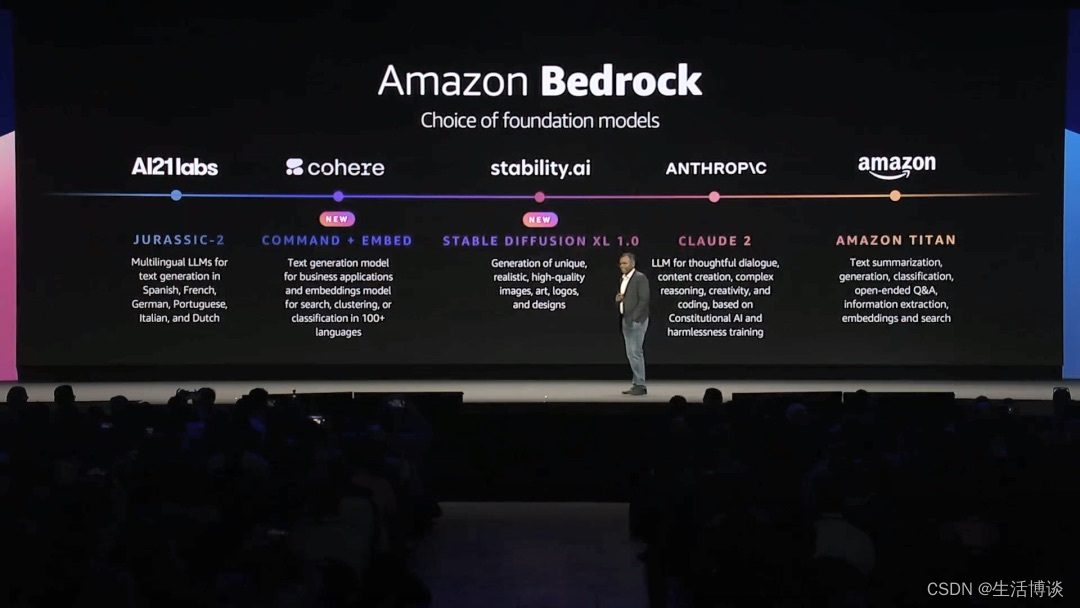

在模型选择层面,一个好的模型需要具备丰富的模型选择,能够满足不同领域和场景的需求。用户需要能够选择适合自己业务的模型,并能够灵活地组合和集成多个模型,以实现更好的业务效果。Bedrock提供了丰富的的基础模型选择,满足不同领域和场景的需求,使得用户可以更加灵活地选择和组合模型,满足自身的业务需求:

● AI21 Labs开发的的多语种大语言模型系列Jurassic-2,可根据自然语言指令生成文本内容;

● Anthropic开发的大语言模型Claude,能够执行多种对话和文本处理任务;

● Stability AI开发的文生图基础模型Stable Diffusion,能够生成独特、写实、高清的图像、艺术作品、商标和其它设计图;

● Anthropic接入到Amazon Bedrock的最新语言模型Claude 2,可以在每个对话任务提示中使用10万个标记,能处理数百页文本甚至整本书。相比之前版本,还可以撰写长篇文件,长度可达几千个标记;

● Stability AI将发布最新版文生图模型套件Stable Diffusion XL 1.0,能够生成更逼真的影视、电视、音乐和教学视频,具有更精细的图像和构图细节。

● 亚马逊云科技新增的基础模型供应商Cohere将提供更直观地生成、检索和汇总信息的基础模型服务。

本次峰会上,亚马逊云科技宣布全面扩展其全托管基础模型服务Amazon Bedrock,发布变革性的新功能Amazon Bedrock Agents,该功能将助力开发者轻松创建全托管的AI Agents,帮助开发者研发提效,解决开发过程中的复杂度问题。目前很多专业开发者开始使用ChatGPT进行软件开发,事实表明ChatGPT可以为开发工作提供帮助,但在具体的业务场景中,开发者需要的不仅是可以编代码的工具,而是从源头降低软件开发复杂度的工具。想要从源头入手降低软件的复杂度,就意味着开发者需要设计良好的架构、简化功能和模块开发、采用合适开发工具等方法,从而来减少软件中的不必要的复杂度,提高软件的可维护性、可读性和可扩展性。而亚马逊云科技此次新推出的Amazon Bedrock Agents便有效解决了这些难题,是Amazon Bedrock的一大看点,也是生成式AI领域在降低开发复杂度的新节点。

向量数据库是生成式AI的基石

随着大模型和生成式AI技术的高速发展,数据安全和数据自定义成为了技术发展的基础,以往只存储结构化数据的企业数据库已不能满足需求,于是向量数据库成为了全球数据库发展的重要趋势。

向量数据库当前被视为生成式AI的基石,因为其存储和处理的数据都是向量形式,而生成式AI模型则需要使用向量数据进行训练和推理,它提供了高效的数据存储和查询方式,并且可以与深度学习框架无缝集成,这种集成使得生成式AI模型能够更快地学习和生成更准确的数据。

目前在研究大模型、生成式AI的厂商几乎都在同时研究向量数据库技术,基于生成式AI、大模型的训练场景,各家的技术成果目前几乎没有太大差距。然而在本次纽约峰会上,亚马逊云科技新发布的适用于Amazon OpenSearch Serverless的向量引擎,正式可用后,该向量引擎支持简单的API调用,可用于存储和查询数十亿个Embeddings。

Embeddings是一种将文本、图像、声音等数据转换为向量表示的方法以便于使用机器学习算法进行处理,目前在研发向量数据库的厂商都在相关方面展开了探索。亚马逊云科技本次在该方面的新发布,完全是从用户需求出发。

要知道,正常情况下的Embeddings应存储在靠近源数据的位置,一系列因素都将影响企业如何选择最适合自己的选项,比如当前数据存储位置、对数据库技术的熟悉程度、向量维度的扩展、Embeddings的数量和性能需求等,因此亚马逊云科技提供了三个选项满足更高级的向量数据存储需求:

● Amazon Aurora PostgreSQL兼容版关系型数据库,支持pgvector开源向量相似性搜索插件,对需要存储和搜索大量向量数据的应用场景帮助意义很大;

● 分布式搜索和分析服务Amazon OpenSearch,带有k-NN(k最近邻)插件和适用于Amazon OpenSearch Serverless的向量引擎,可以处理大规模的向量数据、提供高效的搜索服务;

● 兼容PostgreSQL的Amazon RDS关系型数据库,支持pgvector插件,可以满足企业日常对于PostgreSQL数据库的兼容性和向量数据存储需求。

由于向量数据通常具有很高的维度和稀疏性,采用传统的存储方式会占用大量的存储空间,在向量数据存储和查询过程中,需要执行许多复杂的计算,所以如何对向量数据进行压缩和优化、优化算法以提高计算效率是向量数据存储技术领域持续探索的问题,而此次亚马逊云科技新发布的向量引擎也为解决这两个技术壁垒提供了有力支持,同时从用户的需求层来看,这也是向量数据存储技术的新突破。

生成式AI同样需要“加速”

生成式AI作为一种强大的技术,目前已在多个领域展现出了巨大潜力。然而在实际应用中,尽管其强大的创造力和表达能力令人惊叹,但生成式AI在“速度”方面仍有很大的进步空间。GPU作为专门用于并行计算的处理器,可以同时处理多个数据单元来提高计算速度。在生成式AI的训练中,需要进行的大量矩阵运算和反向传播等计算、处理大量的数据和模型参数,而这些计算任务均可以通过GPU进行并行计算,以达到加快计算速度,降低训练时间的目的。本次峰会上新发布的Amazon EC2 P5实例作为亚马逊云科技平台上的一种强大的计算实例类型,便很好地满足了目前用户在生成式AI训练过程中的GPU需求。

Amazon EC2 P5实例以其出众的硬件配置提供了卓越的计算、存储、横向拓展性能,它搭载了8个NVIDIA H100 Tensor Core GPU,拥有640GB高带宽GPU内存,同时提供第三代AMD EPYC处理器、2TB系统内存和30TB本地NVMe存储。同时,Amazon EC2 P5实例还提供3200Gbps的聚合网络带宽并支持GPUDirect RDMA,从而能够绕过CPU进行节点间通信,实现更低的延迟和高效的横向扩展性能。

NVIDIA H100 GPU具有新的转换器引擎,可智能地管理和动态选择FP8和16位计算,与上一代A100 GPU相比,可在LLM上提供更快的DL训练加速。对于HPC工作负载,与A100 GPU相比,NVIDIA H100 GPU具有新的DPX指令,可进一步加速动态编程算法。这种计算能力对于生成式AI模型中大量的矩阵计算和向量运算至关重要,与上一代基于GPU的实例相比,训练时间最多可缩短6倍。通过利用P5实例的高性能计算资源,可以显著降低训练成本,加快生成式AI的处理速度。

为了能够满足生成式AI模型的大量训练数据、模型参数及中间结果的大量数据存储和加载需求,Amazon EC2 P5实例还提供了大容量的本地存储空间,使得可以更高效地管理和处理大规模的数据集,在本地存储的支持下,避免频繁的数据传输和加载,从而进一步提升生成式AI任务的效率。

端到端的生成式AI“未来已至”

无论是完全托管式的Amazon Bedrock,还是适用于Amazon OpenSearch Serverless的向量引擎、Amazon EC2 P5实例,亚马逊云科技结合用户需求在生成式AI“端到端”方面的探索越来越深入。作为GenAI领域的技术领导者,亚马逊云科技凭借先进的技术、庞大的生态体系、丰富的实践经验和可靠的安全性,为自己的用户们提供了越来越全面的支持和几近完美的解决方案来推动端到端生成式AI的发展。

除了已经提到的几个亮点技术,在本次峰会上,亚马逊云科技还推出了其他四项生成式AI技术与应用——AI编程助手Amazon Codewhisperer通过提供丰富的模型和算法库来快速构建和训练生成式AI模型,使得开发者能够更轻松地进入生成式AI领域,并在图像、语音和文本生成方面得到更好的支持和指导;亚马逊云科技将Amazon Bedrock的大语言模型能力与Amazon QuickSight Q的自然语言问答功能相结合,提供生成式BI功能,提高了数据分析的效率和易用性,同时结合数据可视化,Quicksight将数据分析结果以更直观丰富的方式展现,让用户更好地理解和利用数据。此外,亚马逊云科技还通过Amazon Entity Resolution,赋能企业提升数据质量、获取客户洞察;推出Amazon HealthScribe,利用生成式AI助力构建医疗应用程序。

一直以来亚马逊云科技致力于降低生成式AI门槛,使更多的人能够轻松尝试和应用这项技术。他们希望成为生成式AI的普惠领导者,让更多的人从中受益。