引言

浅浅阅读下论文,毕竟是研究生期间一直研究的课题,下面开始阅读论文。

Perception-Oriented Single Image Super-Resolution using Optimal Objective Estimation

面向感知的单图像超分辨率重建--利用最优目标估计

Abstract

使用感知和对抗性损失进行训练的单图像超分辨率(SISR)网络相较于使用失真导向损失(如 L1 或 L2)进行训练的网络,其输出提供了更高对比度。然而,已经证明仅仅使用单一感知损失不足以准确地恢复图像中局部变化的多样形状,往往导致生成不良的伪影或不自然的细节。因此,人们尝试了各种损失的组合,例如感知损失、对抗性损失和失真损失,但是找到最佳组合仍然具有挑战性。因此,在本文中,我们提出了一种新的 SISR 框架,通过应用最优目标来生成高分辨率输出中各个区域的合理结果。具体而言,该框架包含两个模型:一个预测模型,用于为给定的低分辨率(LR)输入推断最优目标图,以及一个生成模型,该生成模型应用目标目标图来产生相应的超分辨率输出。生成模型通过我们提出的目标轨迹进行训练,该轨迹表示一组基本目标,使得单一网络能够学习对应于轨迹上组合损失的各种超分辨率结果。预测模型使用从目标轨迹中搜索得到的 LR 图像与相应的最优目标图进行配对训练。在五个基准测试上的实验结果表明,所提出的方法在 LPIPS、DISTS、PSNR 和 SSIM 指标上优于最先进的感知驱动超分辨率方法。视觉结果也充分展示了我们的方法在感知导向重建方面的优越性。

图1. 视觉和定量比较。我们的提出的SROOE方法相较于其他最先进的方法,在PSNR、LR-PSNR 方面表现更好,同时在LPIPS 方面表现更低,意味着更低的失真和更高的感知质量。

1.Introduction

单图像超分辨率(SISR)的目的是根据给定的低分辨率(LR)输入估计对应的高分辨率(HR)图像。SISR在许多领域有广泛应用,主要作为计算机视觉或图像分析任务的预处理步骤,如医学影像、监控以及卫星图像分析等。然而,SISR是一个病态问题,意味着一个低分辨率图像对应着无数个高分辨率图像。近年来,采用深度神经网络极大地提高了SISR的性能。早期的研究中普遍采用像素级的失真导向损失(L1和L2),这有助于获得较高的信噪比(PSNR)。然而,这些损失使得模型生成可能的高分辨率解的平均值,通常导致图像模糊,从视觉上并不令人满意。

随后,为了克服这个问题并产生带有精细细节的逼真图像,研究人员引入了感知导向损失,例如感知损失和生成对抗性损失。这些感知导向损失被广泛用于各种超分辨率方法,但同时也带来了一些不良的副作用,如产生不自然的细节和结构失真。为了减轻这些副作用并提高感知质量,研究人员提出了各种方法,包括使用专门设计的损失函数,以及利用先验信息和额外网络分支的条件方法。同时,与传统的单一目标优化的超分辨率方法不同,一些研究尝试应用多个目标来生成更准确的高分辨率输出。然而,其中一些方法应用了针对特定图像的目标,但未考虑区域特性,而另一些方法则利用了使用有限预定义类别的语义图像分割得到的区域特定目标。

在本文中,我们提出了一种新的超分辨率(SR)框架,它在连续样本空间中找到一组目标的局部最优组合,从而实现区域优化的高分辨率重建。图1的上半部分展示了我们的结果与最先进的感知导向方法的视觉对比。可以看出,我们的基于最优目标估计(OOE)的SR方法,称为SROOE,生成了更准确的结构。图1的下半部分显示SROOE位于右下方,对应于同时具有理想PSNR和LPIPS 值的位置。

为了实现这一目标,我们的超分辨率框架由两个模型组成:一个预测模型,用于推断给定输入的最适合的目标;和一个生成模型,该生成模型应用局部变化的目标来生成相应的超分辨率结果。主要的挑战在于训练一个单一的生成器,使其能够在不同的位置上学习连续变化的目标。为此,我们将目标定义为几个损失的加权和,并使用不同的权重组合来训练生成器。同时,预测模型的作用是为给定的图像输入估计合适的权重。这样,我们能够实现对不同区域的局部优化,从而生成更精确的超分辨率结果。

为了高效训练,我们并不在权重向量所跨越的整个目标空间上进行学习,而是寻找一组在每个视觉级别上对优化产生较大影响且在目标空间中彼此接近的目标。这样的策略有助于提高学习效率,并增加不同目标结果之间的相似性,从而减少不良的副作用。此外,我们采用了一种定义的轨迹来训练生成模型,该轨迹是通过连接选定目标得到的,以使得轨迹从适合于低视觉级别的目标开始,逐渐过渡到适合于更高级别的目标。这种方式允许我们用简单的一维轨迹跟踪来替代高维权重向量的操作,从而简化训练过程。预测模型则是使用包含低分辨率图像和相应最优目标图的数据集进行训练。我们通过对生成模型的目标轨迹进行网格搜索,以获得这些最优训练图的权重分布。

关于网络结构,我们在生成器中采用了空间特征变换(SFT)层,以便根据目标灵活地调整网络的行为。通过这种方式训练的灵活模型具有三个优势。首先,由于网络学习了各种情况,它能够更好地泛化到不同结构的图像上。第二,超分辨率结果在轨迹和给定输入上是一致的,保持了稳定性。第三,高维权重向量用于损失项的表示可以被替换为一个具有一维输入的向量函数,从而可以轻松地找到和控制最优的损失组合。这为优化过程带来了更多的灵活性和便利性。

我们的贡献总结如下:(1) 我们提出了一个SISR框架,能够为每个输入区域估计和应用最优的目标组合,从而产生感知准确的超分辨率结果。(2) 尽管这种方法需要使用多种加权损失组合进行训练,并且需要在高维权重向量空间上进行搜索,但我们引入了一种高效的方法,通过定义受一维变量控制的目标轨迹来探索和选择目标。(3) 我们提出了一种获取沿着目标轨迹的最优目标图的方法,进而用这些图来训练目标估计器。(4) 实验证明我们的方法在PSNR和LPIPS上都表现出色,而这两者通常被认为是一种权衡关系。我们的方法能够在这两个指标上取得较好的结果。通过这些贡献,我们的研究为感知导向的单图像超分辨率问题提供了一种创新的解决方案,有效地提高了重建结果的感知质量。

2.Related Work

Distortion-oriented SR:Dong等人最早提出了一种基于卷积神经网络(CNN)的失真导向单图像超分辨率(SISR)方法,利用了一个三层CNN来学习从低分辨率(LR)到高分辨率(HR)图像的映射关系。自那时以来,许多更深层次的基于CNN的SISR框架被提出。Ledig等人提出了SR-ResNet,其中包含了残差块和跳跃连接,进一步增强了SR结果。随着Huang等人提出DenseNet的成功,密集连接在SR网络中变得普遍应用。Zhang等人引入了RCAN,利用通道注意力机制提高模型的表示能力和SR性能。最近,SwinIR和Uformer通过采用Swin Transformer架构和局部增强窗口(LeWin)Transformer块,分别取得了出色的SISR性能。虽然上述提到了许多用于SISR的不同架构,但在本文中,我们选择了简单的CNN架构作为我们的预测模型和生成模型。本文的主要重点在于提出一种新的SR框架,而具体的网络结构并不是主要关注点。在未来的研究中,可以尝试使用其他CNN和Transformer架构来替代我们选择的模型,以进一步探索不同可能性,并提升所提出方法的性能。

Perception-oriented SR:由于像素损失(如L1和L2)仅考虑像素之间的差异而不关注感知质量,使用这些损失的结果通常缺乏高频细节。为了改善输出的视觉质量,Johnson等人提出了感知损失。Ledig等人引入了SRGAN,利用对抗性损失,可以生成逼真的高分辨率图像。Wang等人进一步增强了这一框架,引入了Residual-in-Residual Dense Block(RRDB),并将其命名为ESRGAN。这些感知导向和对抗性的损失函数的引入在超分辨率中取得了显著的改进,提高了生成图像的质量和视觉效果。

然而,这些感知导向的超分辨率模型可能会引发一些不受欢迎的伪影,例如在平坦表面上产生意外的纹理。为了减轻这些伪影和/或进一步提高感知质量,研究者们提出了各种方法。Soh等人引入了NatSR,其中设计了一种损失函数来抑制混叠现象。Wang等人提出了利用语义先验通过SFT层生成语义特定的细节。Zhang等人提出了一种Ranker,用于学习感知指标的行为。Ma等人提出了结构保持超分辨率(SPSR)方法,以减轻几何失真。Liang等人则通过局部判别学习的方式区分GAN生成的伪影和真实细节。然而,Blau认为,要同时实现感知质量的提升和失真的降低是困难的,因为它们之间存在权衡关系。针对这一问题,还有一个SR挑战专注于解决生成准确性和感知质量之间的权衡。本文的一个主要观点是,我们可以同时减少失真并提高感知质量,如图1所示。通过新的SISR框架,我们能够取得这一平衡,提供更加真实和准确的高分辨率重建结果。

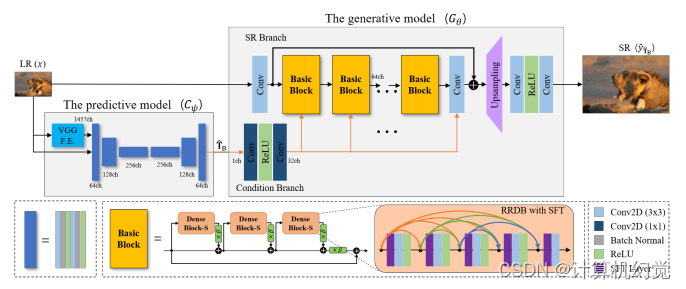

图2展示了我们提出的方法的架构。预测模型生成最优目标图TˆB,并将其传递给生成模型。输入的低分辨率(LR)图像通过我们的基本块和生成器的其他组件进行超分辨率处理,这些组件由Condition Branch提供的映射进行控制。

3.Methods

3.1 Proposed SISR Framework

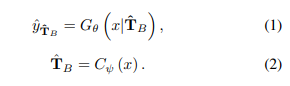

我们的SISR框架概览如图2所示。该框架由一个预测模型Cψ和一个生成模型Gθ组成,分别由参数ψ和θ进行参数化。预测模型Cψ针对给定的LR输入x推断出一个LR大小的最优目标图TˆB,然后生成模型Gθ将其应用于生成相应的SR输出,使其尽可能地与对应的HR图像y相似,具体如下:

3.2 Proposed Generative Model

使用单一固定的目标无法为每个图像区域生成最优的高分辨率结果,因此根据输入特征应用区域性不同的损失是非常有益的。然而,训练多个SR模型,每个模型都使用不同的目标进行训练,是不切实际的,因为这会消耗大量内存并且需要较长的训练和推断时间。因此,在本文中,我们提出了一种方法,可以训练一个单一的SR模型,能够考虑到局部不同的目标。通过这种方式,我们能够在一个模型中融合不同的目标,从而实现更加高效和灵活的图像超分辨率重建。

Effective Objective Set.我们首先研究了为实现准确的超分辨率而需要学习的目标。对于感知导向的超分辨率,通常使用以下目标函数进行加权求和:像素重建损失Lrec、对抗性损失Ladv和感知损失Lper。具体如下所示:

在这个公式中,λrec、λadv和λper是对应损失的权重参数,而φper(·)表示在VGG网络的第19层perl提取的输入的特征图。这里的公式5中的五层是参考自的VGG网络。值得注意的是,随着深入到VGG网络中,感受野逐渐变大,因此浅层(如V12和V22)和深层(如V34、V44和V54)的特征分别对应于相对低级别和高级别的视觉信息。

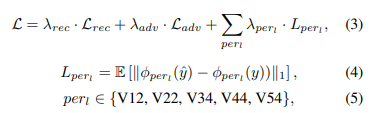

为了找到一个有效的目标集合,我们定义了一个超分辨率(SR)目标空间。SR的目标是七个损失项的加权和,如公式3所示。因此,目标空间由这些基本损失项构成,并且任何目标都可以用七维的权重参数向量λ ∈ R^7来表示:

![]()

其中,λper ∈ R^5 是感知损失的权重向量。

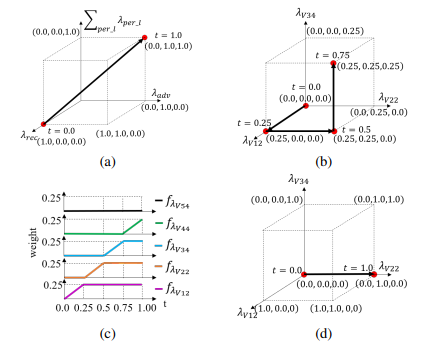

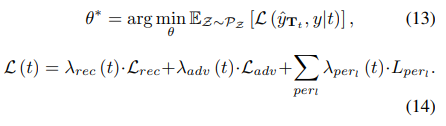

图3显示了目标空间中的A组(左侧)和B组(右侧)。

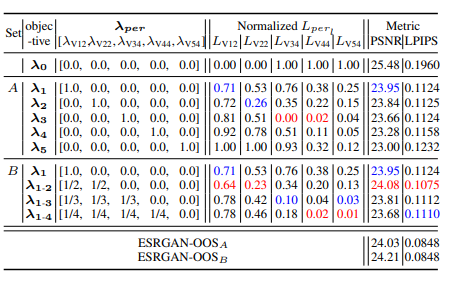

表1比较了两组目标,分别为A组和B组,如图3所示。在表中,ESRGAN 是基准模型,因此除了λ0外,所有目标的λrec和λadv分别设置为1×10^−2和5×10^−3,与ESRGAN相同,只是λper发生了变化,其中kλperk1 = 1。特别地,对于λper,A组中的每个目标只在五个VGG特征空间中的一个权重,而B组中的每个目标在低于目标视觉级别的每个特征空间中都有相等的权重。因此,高级别的目标也包含了低级别特征空间的损失。同时,由于λ0对应于以失真为导向的RRDB模型,它的λrec和λadv分别设置为1×10^−2和0。值得注意的是,λ0同时包含在A组和B组中。

表1. 使用不同感知损失权重向量的ESRGAN模型的超分辨率结果性能比较。在A组和B组的目标中,除了λ0之外,每一列中排名第一和第二的最佳性能分别以红色和蓝色突出显示。

在表1中,报告了五个数据集(BSD100 、General100 、Urban100 、Manga109 和DIV2K)的Lperl的归一化版本(最小-最大特征缩放)。对于所有特征空间,包括目标V12和V22特征空间,B组中的λ1-2的L1误差比A组中的λ1和λ2更小。此外,B组中的λ1-4的误差也比A组中的λ4和λ5小。尽管B组中的λ1-3在V34特征空间中的误差略高于λ3,但在V12和V22特征空间中的误差较小,因此相比于过拟合到V34特征空间的λ3,λ1-3表现出较少的失真。这得到了这样的支持,即B组中的大部分目标,包括λ1-3,在Urban100 上具有比A组中的更好的PSNR和LPIPS。

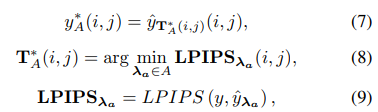

为了检查使用A组目标的本地适当超分辨率结果,我们通过选择每个像素位置具有最低LPIPS的SR结果,混合ESRGAN-λa的六个SR结果,其中λa ∈ A,如下所示:

其中,yˆλa表示ESRGAN-λa的超分辨率结果。LPIPS 函数计算每个像素位置的两个图像块之间的感知距离,生成输入图像大小的 LPIPS 图,即 LPIPS。表1中的 LPIPS 指标是该图的平均值。由于 T∗A 是最优目标选择(OOS),T∗A 及其用于混合的 SR 模型分别表示为 OOSA 和 ESRGAN-OOSA。图4的上部展示了基于 A 组和 B 组的 OOSA 和 OOSB 的一个示例。表1中报告ESRGAN-OOSA 和 ESRGAN-OOSB 的 PSNR 和 LPIPS 指标,其中 ESRGAN-OOSB 优于任何单一目标模型,显示了局部适当目标应用的性能改进潜力。图4的下部显示了使用比 A 组中的目标更接近的 B 组中的目标混合的副作用,如图3所示。由于图4中的 ESRGAN-OOSB 具有比 ESRGAN-OOSA 更少的伪影和更好的 PSNR,因此建议使用 B 组更适合应用局部适当的目标。

图4. 使用A组和B组的ESRGAN-OOS和OOS示意图。

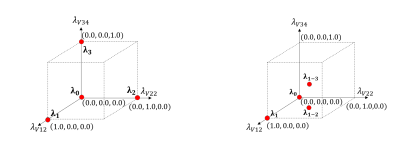

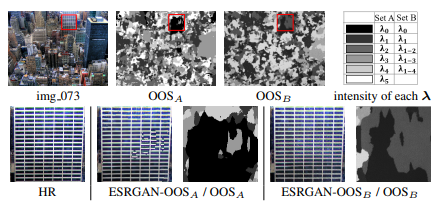

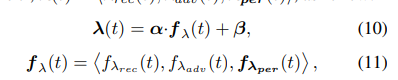

Learning Objective Trajectory.我们将生成模型训练在目标轨迹上的一组目标而不是单个目标λ(见公式6)。目标轨迹是通过连接选择的目标来形成的,即B组的五个目标,从适用于低视觉级别的目标开始,逐步过渡到适用于更高级别的目标,即从λ0到λ1-4。它由一个单一变量t参数化,表示为λ(t) = hλrec(t), λadv(t), λper(t)i,如下所示:

其中,fλper(t) ∈ R^5,fλrec(t)和fλadv(t)是权重函数,α和β是缩放和偏移向量。由于fλ:R → R^7,这个向量函数使得可以用一维追踪来替代高维度的权重向量操作,从而简化了训练过程。

图5. 损失权重的向量函数。(α=1和β=0)

具体来说,轨迹设计基于表1中的观察,即使用λ0的以失真为导向的RRDB模型在低级特征空间(例如V12和V22)具有比所有ESRGAN模型更小的L1误差,而ESRGAN模型在高级特征空间(例如V34、V44和V54)具有更小的L1误差。因此,我们设计了权重函数fλrec、fλadv和fλper,使得当t接近0时,fλrec增加,而{fλadv,∑perl fλperl}减小,以接近λ0;当t增加到1时,相反地接近λ1-4,如图5(a)所示,其中α=1,β=0。

与Pperl fλperl(t)的变化相关联,我们设计了每个fλper(t)的五个组成部分函数,如图5(c)所示,以获得从集合B的λ0到λ1-4的目标轨迹,如图5(b)所示,仅展示了其中三个组成部分,因为三维可视化的限制。因此,随着我们通过增加t从0到1来沿着轨迹前进,目标的权重参数从以失真为导向的目标λ0开始,然后逐渐添加高视觉级别特征空间的损失和对抗性损失,使目标朝着λ1-4进行轻微的过渡。图5(d)显示了用于FxSR 的目标轨迹,它仅使用V22特征空间,限制了感知准确恢复的性能。

提议的目标轨迹可以有效提高超分辨率结果的准确性和一致性。首先,我们可以在从低级到高级视觉的连续轨迹上使用任何目标,从而能够为每个区域应用更准确的目标。其次,对于一致性而言,我们所提出的目标轨迹上的高级目标包括低级和高级损失,因此也考虑到了低级目标。这种加权方法使得在轨迹上的所有超分辨率结果之间共享主要由低级视觉级别目标重建的结构组件成为可能。最后,我们只需训练单个超分辨率模型一次,从而减少了产生多样高分辨率输出所需的模型数量。

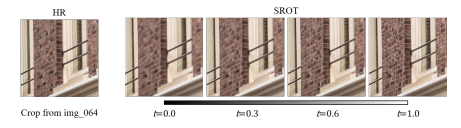

图6. SROT的超分辨率结果随t值变化的变化。

图7. PSNR和LPIPS随着t值的变化。

图6展示了基于图5(b)中的目标轨迹(OT)进行训练的生成模型的超分辨率结果随着t从0变化到1的变化,我们称之为SROT。图7展示了随着t的变化在感知-失真平面上的权衡曲线,其中t从0.0增加到1.0,共有21个采样点,每个曲线上的超分辨率结果通过将T的值保持为相同的t输入到生成模型的条件分支中,如下所示:

![]()

在图7中,水平和垂直虚线分别表示模型的最低LPIPS值和相应的PSNR值。在垂直线旁边写下了该时刻的t值。然而,将特定的t值应用于整个图像仍然限制了超分辨率性能,并且在推断时不知道图像的最佳t值。我们进一步提出了如何估计和应用局部最优目标。

图8. 输入图像,通过参数搜索得到的最优目标选择T∗S,以及由Cψ估计得到的TˆB。

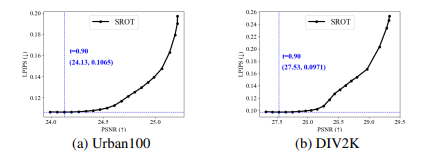

Network Architecture and Training.生成器网络的概要来自于,即Gθ由两个分支组成,一个SR分支包含23个基本块,一个条件分支,如图2所示。条件分支接收一个LR大小的目标目标图T,并产生共享的中间条件,可以传递到SR分支中的所有SFT层。由于SFT层通过应用仿射变换调制特征图,它们学习一个基于T的调制参数的映射函数。具体来说,Tt,其中t在预定义的范围内随机变化,在训练期间被馈送到条件分支,这个调制层允许SR分支通过t优化变化的目标。因此,Gθ学习了目标轨迹上的所有目标,并在推断时根据地图生成具有不同空间目标的SR结果。Gθ在训练样本Z =(x,y)上通过PZ分布进行优化,如下所示:

3.3 Optimal Objective Estimation (OOE)

为了为每个区域估计最优的目标组合,我们训练一个预测模型Cψ。该模型生成了一个给定LR图像估计的最优目标图Tˆ B,然后将其传递给Eqn. 1中的生成模型。由于很难找到Cψ训练的真实目标图,我们通过简单的穷举搜索获得其近似值T∗S,以缩小最佳可能值的范围。具体来说,我们通过将t从0变化到1,步长为0.05,生成一组21个SR结果,并通过选择其中LPIPS最低的t来为每个像素生成最优目标图,如下所示:

其中,Tt = 1×t, t ∈ S = {0.0, 0.05, 0.10, ..., 1.0}.图8显示了最优目标选择(OOS)T∗S的一个示例,使用T∗S的SR结果,SROOS,可以作为Gθ性能的一个上界近似,即:

![]()

尽管T∗ S对于训练Cψ是有用的,但是由于没有考虑Gθ的卷积所引起的干扰,这种像素级的目标选择不是准确的真实值。因此,Cψ的优化采用了三个损失项:像素级的目标映射损失、像素级的重建损失和感知损失,用于衡量重建图像和高分辨率图像之间的差异,如下所示:

其中,LT and Lrec是n T∗ S and Tˆ B之间的L1损失,以及y and yˆTˆ B之间的L1损失,分别表示重建的目标映射和原始图像与重建图像之间的差异。同时,ZT = (x, y, T∗ S )表示训练数据集,λT, λ OOE rec和λR是每个损失项的权重。在Cψ模型训练过程中,Cψ与已经训练好的生成模型结合,生成器的参数被固定。因此,Cψ训练中的损失,包括LPIPS,仅用于估计局部适当的目标映射,而不会影响或改变生成器的参数。

Cψ的架构包括两个独立的子网络:一个是特征提取器(F.E.),利用VGG-19 进行特征提取,另一个是预测器,采用UNet架构 ,如图2所示。为了获得更好的性能,特征提取器旨在获取从低到高级别的特征,并将它们传递给UNet进行预测。由于UNet的结构具有更大的感受野,因此在上下文中预测目标更有优势。

4. Experiments

4.1 Experiment Setup

Materials and Evaluation Metrics.我们使用DIV2K(800张图片)或DF2K(3450张图片)数据集来训练我们的模型。我们的测试数据集包括BSD100 、General100 、Urban100 、Manga109 和DIV2K验证集 。为了评估感知质量,我们报告LPIPS 和DISTS,这是全参考度量。DISTS是一种侧重于细节相似性的感知度量。我们还报告PSNR和SSIM 作为保真度导向的度量。LR-PSNR度量是输入LR图像与降采样SR图像之间的PSNR。LR-PSNR越高,SR结果与LR图像的一致性越好,其中45 dB或更高被认为是良好的LR一致性,这也是NTIRE挑战中的要求。因为与LR输入图像的一致性很重要,我们还报告了LR-PSNR。

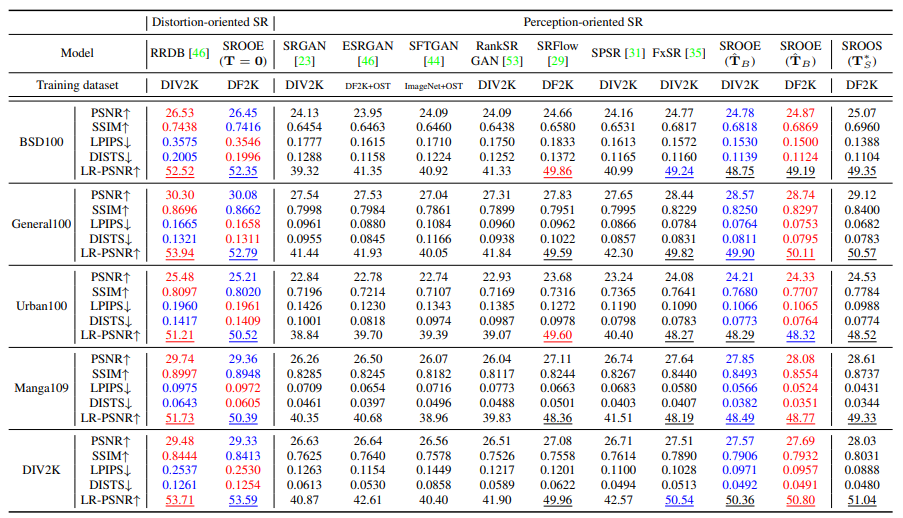

表2.与基准上的最先进的SR方法的比较。每组中的第1和第2个最佳表现分别用红色和蓝色标记。LR-PSNR值大于45dB的用下划线标记。

图9. 与最先进的SR方法的视觉比较。在七种感知导向的SR方法中,最佳表现用红色标记。

图9. 与最先进的SR方法的视觉比较。在七种感知导向的SR方法中,最佳表现用红色标记。

Training Details. 训练时,高分辨率(HR)和低分辨率(LR)的批处理大小分别为256×256和64×64。所有的训练参数都与ESRGAN [46]相同,除了损失权重。对于生成器训练,t是一个在[0, 1]范围内均匀分布的随机变量。α=[1×10−2,1,1]和β=[1×10−2,0,0]。

4.2 Evaluation

Quantitative Comparison.表2显示了4倍超分辨率的定量性能比较。我们将其与以失真为导向的方法RRDB [46]以及以感知为导向的方法进行了比较,例如SRGAN 、ESRGAN 、SFTGAN 、RankSRGAN 、SRFlow 、SPSR 和FxSR 。从表中可以看出,我们的方法在所有数据集上都表现出色,不仅在LPIPS 和DISTS 等感知度量上表现最好,而且在PSNR和SSIM等失真导向的度量上也表现最佳。它的LR-PSNR值也超过了45 dB,说明LR的一致性得到了很好的维持,正如NTIRE 所提到的。此外,在Urban100和DIV2K基准测试中,使用局部目标映射的SROOE在LPIPS和PSNR方面都优于使用全局最优t值的SROT。SROOS使用T∗S具有最佳的PSNR、SSIM、LPIPS和DISTS得分,这显示了所提出的SROOE的近似上限。另一方面,当目标映射T设置为0时,SROOE作为失真导向的SR模型运行。尽管在PSNR方面略逊于RRDB ,但其性能并不相距,而且在LPIPS方面表现更好。这意味着SROOE在需要失真导向修复的区域表现接近RRDB ,从而在实现高感知质量的同时降低了整体失真水平。

Qualitative Comparison.图9显示了一个视觉比较,我们可以观察到SROOE生成了更准确的结构和细节。特别地,可以看出在SROOE使用T = 0和Tˆ B的结果之间,结构组件几乎没有变化,而锐利的边缘和生成的细节被添加到结构组件中。其他视觉比较结果可以在附录中找到。

5. Ablation Study

表3报告了表2中五个基准数据集上每个指标的平均值,这些值根据每个元素的变化而变化。图5(b)和(d)显示的两种不同的目标轨迹分别被称为P1234和P2。表格显示,从P2,固定t和DIV2K到P1234,OOE和DF2K,SR性能逐步改善。具体而言,我们提出的模型SROOE-P1234在DF2K上的PSNR提高了0.25 dB,SSIM提高了0.0069,LPIPS提高了0.0051,LR-PSNR提高了0.23 dB,相对于SROT-P2(对应于FxSR,t=0.8)。将SROOE和SROOS的性能进行比较表明,仍然有改进的空间。

Complexity Analysis. 表4显示了运行时间和参数大小的比较。使用NVIDIA RTX3090 GPU测量了一个128×128 LR图像的4× SR的复杂度。

Limitations. 尽管应用局部适当的目标可以显著提高从低分辨率到高分辨率的映射准确性,即使生成器使用最优目标图T∗S,它仍然受到实现完全重构的限制。这意味着所提出的生成器仍然无法使用用于训练的目标集生成所有的高分辨率图像,因此仍需要比VGG特征空间更复杂的感知损失项来克服这一问题。同时,解决由高频损失引起的不适定问题仍然存在限制。

6. Conclusion

我们提出了一种新颖的SISR框架,用于实现感知准确的高分辨率图像恢复。在该框架中,目标估计器为给定的图像块提供最优的目标组合,生成器生成反映目标目标的SR结果。为了实现这一目的,我们采用了目标轨迹学习方法,有效地训练一个单一的生成模型,可以应用不同的目标集。实验证明,与现有的感知导向方法相比,所提出的方法减少了结构畸变和不自然细节等视觉伪影,并在感知和失真指标方面实现了更好的结果。该方法可以应用于现有的SISR网络架构和其他相关领域。

总结:没想到现在的已经有能实现LIPIPS和PSNR同向增长的方法了,是非常不错的研究新坑。